Vigilancia predictiva Se suponía que transformaría la forma en que se llevaba a cabo la actuación policial, llevándonos a un mundo de leyes inteligentes. aplicación de la ley en la que se eliminara el sesgo y la policía pudiera responder a los datos, no a corazonadas. Pero una década después de que la mayoría de nosotros escuchamos por primera vez el término “vigilancia policial predictiva”, parece claro que no ha funcionado. Impulsada por una reacción pública, la tecnología está experimentando una disminución significativa en su uso, en comparación con hace apenas unos años.

Contenido

- La promesa de una vigilancia policial predictiva

- Algoritmos discriminatorios

- Los peligros de los datos sucios

- El futuro incierto de la policía predictiva

- ¿Las herramientas equivocadas para el trabajo?

En abril de este año, Los Ángeles (que, según el LA Times, “fue pionera en predecir el crimen con datos”) recortó fondos para su programa policial predictivo, culpando al costo. "Es una decisión difícil", dijo el jefe de policía Michel Moore.

dijo al LA Times. “Es una estrategia que utilizamos, pero las proyecciones de costos de cientos de miles de dólares para gastar en ese derecho Ahora, en lugar de encontrar ese dinero y dirigirlo a otras actividades más centrales, es lo que tengo que hacer”.Vídeos recomendados

¿Qué salió mal? ¿Cómo podría algo que se anuncia como tecnología “inteligente” terminar afianzando aún más los prejuicios y la discriminación? ¿Y es el sueño de una vigilancia policial predictiva uno que podría modificarse con el algoritmo correcto, o un callejón sin salida en una sociedad más justa que actualmente está lidiando con cómo debe operar la policía?

La promesa de una vigilancia policial predictiva

La vigilancia policial predictiva en su forma actual se remonta aproximadamente a una década a un artículo de 2009 de la psicóloga Colleen McCue y el jefe de policía de Los Ángeles, Charlie Beck, titulado “Vigilancia policial predictiva: ¿Qué podemos aprender de Walmart y Amazon sobre la lucha contra el crimen en una recesión?En el documento, aprovecharon la forma en que los principales minoristas estaban utilizando big data para ayudar a descubrir patrones en el comportamiento pasado de los clientes que podrían usarse para predecir el comportamiento futuro. Gracias a los avances tanto en informática como en recopilación de datos, McCue y Beck sugirieron que era posible recopilar y analizar datos sobre delitos en tiempo real. Estos datos podrían luego utilizarse para anticipar, prevenir y responder más eficazmente a delitos que aún no habían ocurrido.

En los años transcurridos desde entonces, la vigilancia policial predictiva ha pasado de ser una idea descartable a una realidad en muchas partes de Estados Unidos, junto con el resto del mundo. En el proceso, se ha propuesto cambiar la actuación policial de una fuerza reactiva a una proactiva; aprovechando algunos de los avances en tecnología basada en datos que permiten detectar patrones en tiempo real y actuar en consecuencia.

"Hay dos formas principales de vigilancia policial predictiva" Andres Ferguson, profesor de derecho en la Universidad del Distrito de Columbia David A. Clarke School of Law y autor de El auge de la vigilancia policial con big data: vigilancia, raza y el futuro de la aplicación de la ley, dijo a Digital Trends. "[Éstas son] vigilancia policial predictiva basada en el lugar y vigilancia policial predictiva basada en personas".

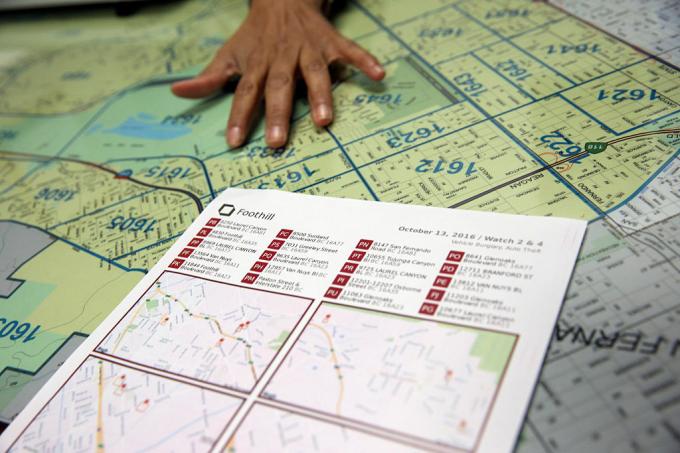

En ambos casos, los sistemas policiales predictivos asignan una puntuación de riesgo a la persona o lugar en cuestión, lo que anima a la policía a realizar un seguimiento en un intervalo determinado. El primero de estos enfoques, la vigilancia policial predictiva basada en el lugar, se centra predominantemente en patrullas policiales. Implica el uso de mapas de delitos y análisis sobre los lugares probables de futuros delitos, basándose en estadísticas previas.

En lugar de ayudar a eliminar problemas como el racismo y otros sesgos sistémicos, la actuación policial predictiva puede en realidad ayudar a consolidarlos.

El segundo enfoque se centra en predecir la probabilidad de que un individuo represente un riesgo potencial futuro. Por ejemplo, en 2013, un comandante de la policía de Chicago fue enviado a la casa de Robert McDaniel, de 22 años, que había sido señalado como un riesgo potencial o autor de violencia armada en el centro de la ciudad de Chicago por un algoritmo. La “lista de calor” que el algoritmo ayudó a reunir buscaba patrones que pudieran predecir futuros delincuentes. o víctimas, incluso si ellos mismos no hubieran hecho nada para justificar este escrutinio más allá de cumplir con un perfil.

como el Chicago Tribune señaló: “La estrategia exige advertir individualmente a aquellos en la lista de calor que una mayor actividad criminal, incluso para los delitos más pequeños, resultará en que toda la fuerza de la ley caiga sobre a ellos."

El sueño de la vigilancia policial predictiva era que, al actuar sobre datos cuantificables, la haría no sólo más eficiente, sino también menos propensa a conjeturas y, como resultado, a sesgos. Según sus defensores, cambiaría la actuación policial para mejor y marcaría el comienzo de una nueva era de actuación policial inteligente. Sin embargo, casi desde el principio, la vigilancia policial predictiva ha tenido críticos acérrimos. Sostienen que, en lugar de ayudar a eliminar problemas como el racismo y otros sesgos sistémicos, la actuación policial predictiva puede en realidad ayudar a consolidarlos. Y es difícil argumentar que no tienen razón.

Algoritmos discriminatorios

La idea de que los sistemas policiales predictivos basados en el aprendizaje automático puedan aprender a discriminar en función de factores como la raza no es nada nuevo. Las herramientas de aprendizaje automático se entrenan con enormes cantidades de datos. Y, mientras esos datos se recopilen mediante un sistema en el que la raza sigue siendo un factor abrumador, eso puede conducir a la discriminación.

Como dice Renata M. O'Donnell escribe en un artículo de 2019, titulado "Desafiando los algoritmos policiales predictivos racistas bajo la cláusula de igual protección”, los algoritmos de aprendizaje automático aprenden de datos derivados de un sistema de justicia en el que “los estadounidenses negros son encarcelados en prisiones estatales a un ritmo eso es 5,1 veces el encarcelamiento de los blancos, y uno de cada tres hombres negros nacidos hoy puede esperar ir a prisión durante su vida si las tendencias actuales continuar."

"Los datos no son objetivos", dijo Ferguson a Digital Trends. “Solo somos nosotros reducidos a un código binario. Los sistemas basados en datos que operan en el mundo real no son más objetivos, justos o imparciales que el mundo real. Si su mundo real es estructuralmente desigual o racialmente discriminatorio, un sistema basado en datos reflejará esas desigualdades sociales. Los insumos que ingresan están contaminados por sesgos. El análisis está teñido de sesgos. Y los mecanismos de la autoridad policial no cambian sólo porque haya tecnología que guíe los sistemas”.

Ferguson da el ejemplo de los arrestos como un factor aparentemente objetivo para predecir el riesgo. Sin embargo, los arrestos estarán sesgados por la asignación de recursos policiales (como el lugar donde patrullan) y los tipos de delitos que normalmente justifican arrestos. Este es sólo un ejemplo de datos potencialmente problemáticos.

Los peligros de los datos sucios

En la minería de datos, a veces se hace referencia a los datos faltantes o incorrectos como “datos sucios”. A Artículo de 2019 de investigadores del A.I. Instituto Now de la Universidad de Nueva York amplía este término para referirse también a datos que están influenciados por datos corruptos, sesgados e ilegales. prácticas, ya sea manipuladas intencionalmente o distorsionadas por individuos y prejuicios sociales. Podría, por ejemplo, incluir datos generados a partir del arresto de una persona inocente a la que se le han colocado pruebas o a quien se le ha acusado falsamente de otro modo.

Hay cierta ironía en el hecho de que, en las últimas décadas, las demandas de la sociedad de datos, en la que todo tiene que ver con la cuantificación y los objetivos numéricos de hierro fundido, acaba de llevar a un montón de... bueno, realmente malos datos. La serie de HBO El alambre mostró el fenómeno del mundo real de "jugar las estadísticas", y los años transcurridos desde que el programa salió del aire han ofrecido muchas ejemplos de manipulación sistémica real de datos, informes policiales falsos y prácticas inconstitucionales que han enviado a personas inocentes a la cárcel. celda.

Los datos incorrectos que permiten a las personas en el poder alcanzar objetivos artificialmente son una cosa. Pero si combinamos eso con algoritmos y modelos predictivos que utilizan esto como base para modelar el mundo, potencialmente obtendremos algo mucho peor.

Los investigadores han demostrado cómo los datos sobre delitos cuestionables conectados a algoritmos policiales predictivos pueden crear lo que se conoce como "bucles de retroalimentación desbocados”, en el que la policía es enviada repetidamente a los mismos vecindarios independientemente de la verdadera tasa de criminalidad. Uno de los coautores de ese artículo, el informático Suresh Venkatasubramanian, dice que los modelos de aprendizaje automático pueden incorporar suposiciones erróneas a través de su modelado. Como dice el viejo dicho de que, para la persona con un martillo, cada problema parece un clavo, estos sistemas modelan sólo ciertos elementos de un problema e imaginan sólo un resultado posible.

“[Algo que] no se aborda en estos modelos es hasta qué punto se está modelando el hecho de que enviar más policías a un área en realidad puede ¿Bajar la calidad de vida de las personas que viven allí? Venkatasubramanian, profesor de la Escuela de Computación de la Universidad de Utah, dijo a Digital Tendencias. “Asumimos que más policías es mejor. Pero como estamos viendo ahora, tener más policías no es necesariamente algo bueno. De hecho, puede empeorar las cosas. En ningún modelo que haya visto nadie se ha preguntado cuál es el costo de poner más policía en un área”.

El futuro incierto de la policía predictiva

Quienes trabajan en vigilancia policial predictiva a veces utilizan, de manera poco irónica, el término “Informe de minorías” para referirse al tipo de predicción que están haciendo. El término se invoca frecuentemente como referencia a la Película de 2002 del mismo nombre., que a su vez se basó libremente en un cuento de 1956 de Philip K. Polla. En Informe de minorías, un departamento de policía especial de PreCrime detiene a los delincuentes basándose en el conocimiento previo de los delitos que se cometerán en el futuro. Estos pronósticos son proporcionados por tres psíquicos llamados "precogs".

Pero el giro en Informe de minorías es que las predicciones no siempre son precisas. Las visiones disidentes de uno de los precogs proporcionan una visión alternativa del futuro, que se suprime por temor a que el sistema parezca poco confiable.

Las auditorías internas que muestran que las tácticas no funcionaron. Las listas predictivas no sólo eran defectuosas, sino que también eran ineficaces.

En este momento, la vigilancia policial predictiva se enfrenta a su propio futuro incierto. Además de las nuevas tecnologías, como el reconocimiento facial, la tecnología disponible para las fuerzas del orden para su posible uso nunca ha sido más poderosa. Al mismo tiempo, la conciencia sobre el uso de políticas predictivas ha provocado una reacción pública que en realidad puede haber ayudado a anularla. Ferguson dijo a Digital Trends que el uso de herramientas policiales predictivas ha estado en “caída” durante los últimos años.

“En su apogeo, [la vigilancia policial predictiva basada en el lugar] estaba en más de 60 ciudades importantes y seguía creciendo, pero como resultado de organización comunitaria exitosa, en gran medida se ha reducido o reemplazado por otras formas de análisis”, dijo. “En resumen, el término vigilancia policial predictiva se volvió tóxico y los departamentos de policía aprendieron a cambiar el nombre de lo que hacían con los datos. La vigilancia policial predictiva basada en personas tuvo una caída más pronunciada. Las dos principales ciudades que invirtieron en su creación (Chicago y Los Ángeles) abandonaron su estrategia basada en personas. estrategias después de duras críticas de la comunidad y auditorías internas devastadoras que muestran que las tácticas no funcionaron trabajar. Las listas predictivas no sólo eran defectuosas, sino que también eran ineficaces”.

¿Las herramientas equivocadas para el trabajo?

Sin embargo, Rashida Richardson, Director de Investigación de Políticas en A.I. Ahora el Instituto dijo que hay demasiada opacidad sobre el uso de esta tecnología. “Todavía no lo sabemos debido a la falta de transparencia con respecto a la adquisición de tecnología por parte del gobierno y muchos lagunas en los procedimientos de adquisición existentes que pueden proteger ciertas compras de tecnología del escrutinio público”, ella dijo. Ella da el ejemplo de la tecnología que podría entregarse a un departamento de policía de forma gratuita o ser comprada por un tercero. “Sabemos por investigaciones como la mía y por informes de los medios de comunicación que muchos de los departamentos de policía más grandes de Estados Unidos han utilizado la tecnología en algún momento, pero también hay muchos pequeños departamentos de policía que la están usando, o la han usado por períodos limitados de tiempo."

Dado el cuestionamiento actual sobre el papel de la policía, ¿existirá la tentación de volver a abrazar La vigilancia policial predictiva como herramienta para la toma de decisiones basada en datos, tal vez en una ciencia ficción menos distópica. ¿marca? Existe la posibilidad de que surja tal resurgimiento. Pero Venkatasubramanian se muestra muy escéptico en cuanto a que el aprendizaje automático, tal como se practica actualmente, sea la herramienta adecuada para el trabajo.

“Todo el aprendizaje automático y su éxito en la sociedad moderna se basa en la premisa de que, sin importar cuál sea la situación real problema, en última instancia se reduce a recopilar datos, construir un modelo, predecir el resultado, y no tienes que preocuparte por el dominio ". él dijo. “Puedes escribir el mismo código y aplicarlo en 100 lugares diferentes. Ésa es la promesa de la abstracción y la portabilidad. El problema es que cuando utilizamos lo que la gente llama sistemas sociotécnicos, en los que hay humanos y tecnología entrelazados en ondas complicadas, no se puede hacer esto. No se puede simplemente conectar una pieza y esperar que funcione. Porque [hay] efectos dominó al colocar esa pieza y el hecho de que hay diferentes actores con diferentes agendas en tal sistema, y subvierten el sistema según sus propias necesidades en diferentes caminos. Todas estas cosas deben tenerse en cuenta cuando se habla de eficacia. Sí, se puede decir en abstracto que todo funcionará bien, pero hay es sin resumen. Sólo existe el contexto en el que estás trabajando”.