Den konstante summen rundt omkring OpenAIs ChatGPT nægter at aftage. Med Microsoft nu, der bruger den samme teknologi til at drive sin helt nye Bing Chat, er det sikkert at sige, at ChatGPT kan fortsætte denne opadgående tendens i et stykke tid. Det er gode nyheder for OpenAI og Microsoft, men de er ikke de eneste to virksomheder, der har fordel.

Ifølge en ny rapport er salget af Nvidias datacenter grafikkort kan være ved at skyde i vejret. Med kommercialiseringen af ChatGPT kan OpenAI have brug for så mange som 10.000 nye GPU'er for at understøtte den voksende model - og Nvidia ser ud til at være den mest sandsynlige leverandør.

Forskningsfirma TrendForce delte nogle interessante skøn i dag, og det mest interessante vedrører fremtiden for ChatGPT. Ifølge TrendForce vil GPT-modellen, der driver ChatGPT, snart have brug for en betydelig stigning i hardware for at opskalere udviklingen.

Anbefalede videoer

"Antallet af træningsparametre brugt i udviklingen af denne autoregressive sprogmodel steg fra omkring 120 millioner i 2018 til næsten 180 milliarder i 2020," sagde TrendForce i sin rapport. Selvom det ikke delte nogen 2023-estimater, er det sikkert at antage, at disse tal kun vil fortsætte med at stige så meget, som teknologi og budget tillader.

Firmaet hævder, at GPT-modellen havde brug for hele 20.000 grafikkort for at behandle træningsdata i 2020. Som det fortsætter med at udvide, forventes det tal at stige til over 30.000. Dette kunne være gode nyheder for Nvidia.

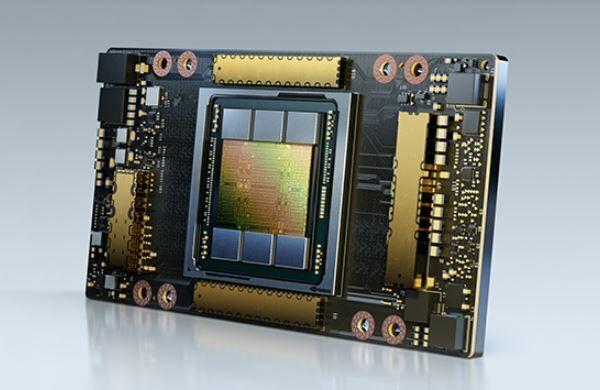

Disse beregninger er baseret på den antagelse, at OpenAI ville bruge Nvidias A100 GPU'er for at drive sprogmodellen. Disse ultrakraftige grafikkort er virkelig dyre - i boldparken på $10.000 til $15.000 hver. De er heller ikke Nvidias bedste datacenterkort lige nu, så det er muligt, at OpenAI ville gå efter de nyere H100-kort i stedet, som formodes at levere op til tre gange ydelsen af A100. Disse GPU'er kommer med en voldsom prisstigning, hvor et kort koster omkring $30.000 eller mere.

Datacenter GPU-markedet består ikke kun af Nvidia - Intel og AMD sælger også AI-acceleratorer. Imidlertid, Nvidia ses ofte som go-to-løsningen til AI-relaterede opgaver, så det er muligt, at det måske er i stand til at score en lukrativ aftale, hvis og når OpenAI beslutter sig for at skalere op.

Skulle spillere være bekymrede, hvis Nvidia faktisk ender med at levere hele 10.000 GPU'er til at tænde for ChatGPT? Det kommer an på. De grafikkort, der kræves af OpenAI, har intet at gøre med Nvidias bedste GPU'er for gamere, så vi er sikre der. Men hvis Nvidia ender med at flytte noget produktion til datacenter GPU'er, kan vi se et begrænset udbud af forbrugere

Redaktørens anbefalinger

- Topforfattere kræver betaling fra AI-virksomheder for at bruge deres arbejde

- GPT-4: hvordan man bruger AI chatbot, der gør ChatGPT til skamme

- Wix bruger ChatGPT til at hjælpe dig med hurtigt at bygge et helt websted

- ChatGPT-producenten OpenAI står over for FTC-undersøgelse over forbrugerbeskyttelseslove

- ChatGPT-webstedets trafik er faldet for første gang

Opgrader din livsstilDigital Trends hjælper læserne med at holde styr på den hurtige teknologiske verden med alle de seneste nyheder, sjove produktanmeldelser, indsigtsfulde redaktionelle artikler og enestående smugkig.