Förutsägande polisarbete var tänkt att förändra sättet att polisarbete utfördes och leda oss in i en värld av smart lag verkställighet där partiskhet togs bort och polisen skulle kunna svara på uppgifterna, inte till förnimmelser. Men ett decennium efter att de flesta av oss först hörde termen "predictive policing" verkar det tydligt att det inte har fungerat. Driven av en offentlig motreaktion upplever tekniken en betydande nedgång i dess användning, jämfört med för bara några år sedan.

Innehåll

- Löftet om förutseende polisarbete

- Diskriminerande algoritmer

- Farorna med smutsiga data

- Den osäkra framtiden för predictive policing

- Fel verktyg för jobbet?

I april i år skar Los Angeles - som, enligt LA Times, "banan för att förutsäga brott med data" - ned finansieringen för sitt förutseende polisprogram och skyllde på kostnaden. "Det är ett svårt beslut," polischef Michel Moore berättade för LA Times. "Det är en strategi vi använde, men kostnadsprognoserna på hundratusentals dollar att spendera på den rätten nu kontra att hitta de pengarna och styra de pengarna till andra mer centrala aktiviteter är vad jag måste göra.”

Rekommenderade videor

Vad gick fel? Hur skulle något som annonseras som "smart" teknik kunna leda till ytterligare befästning av fördomar och diskriminering? Och är drömmen om förutsägande polisarbete en som kan justeras med rätt algoritm - eller en återvändsgränd i ett rättvisare samhälle som just nu brottas med hur polisen ska fungera?

Löftet om förutseende polisarbete

Förutsägande polisarbete i sin nuvarande form går tillbaka runt ett decennium till en artikel från 2009 av psykologen Colleen McCue och Los Angeles polischef Charlie Beck, med titeln "Predictive Policing: Vad kan vi lära oss av Walmart och Amazon om att bekämpa brott i en lågkonjunktur?” I tidningen tog de tag i hur stordata användes av stora återförsäljare för att hjälpa till att upptäcka mönster i tidigare kundbeteende som kunde användas för att förutsäga framtida beteende. Tack vare framsteg inom både datoranvändning och datainsamling föreslog McCue och Beck att det var möjligt att samla in och analysera brottsdata i realtid. Dessa uppgifter kan sedan användas för att förutse, förebygga och reagera mer effektivt på brott som ännu inte hade ägt rum.

Under åren sedan har förutseende polisarbete övergått från en engångsidé till en verklighet i många delar av USA, tillsammans med resten av världen. I processen har man bestämt sig för att förändra polisarbetet från en reaktiv kraft till en proaktiv; med hjälp av några av genombrotten inom datadriven teknik som gör det möjligt att upptäcka mönster i realtid – och agera utifrån dem.

"Det finns två huvudsakliga former av förutsägande polisarbete," Andrew Ferguson, professor i juridik vid University of District of Columbia David A. Clarke School of Law och författare till The Rise of Big Data Policing: Surveillance, Race, and the Future of Law Enforcement, berättade för Digital Trends. "[Detta är] platsbaserad prediktiv polisverksamhet och personbaserad prediktiv polisverksamhet."

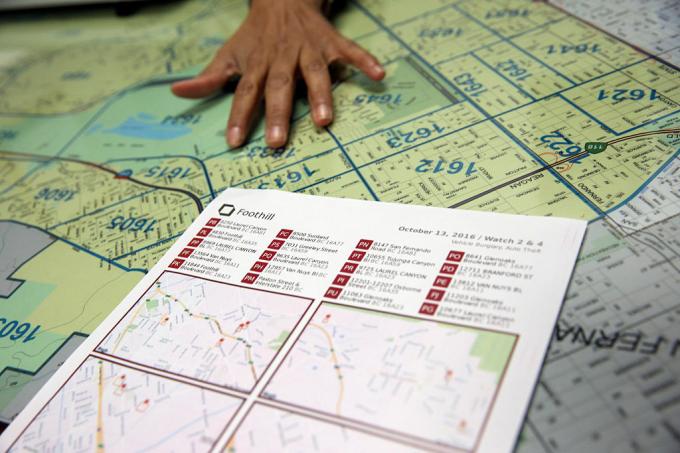

I båda fallen tilldelar de prediktiva polissystemen en riskpoäng till personen eller platsen i fråga, vilket uppmuntrar polisen att följa upp med ett givet intervall. Det första av dessa tillvägagångssätt, platsbaserad prediktiv polisverksamhet, fokuserar främst på polispatrullering. Det innebär användning av brottskartläggning och analyser om de troliga platserna för framtida brott, baserat på tidigare statistik.

Istället för att hjälpa till att bli av med problem som rasism och andra systemiska fördomar, kan förutsägande polisarbete faktiskt hjälpa till att befästa dem.

Det andra tillvägagångssättet fokuserar på att förutsäga sannolikheten för att en individ utgör en potentiell framtida risk. Till exempel, 2013 skickades en befälhavare från Chicago-polisen hem till en 22-årig Robert McDaniel, som hade flaggats som en potentiell risk eller förövare av vapenvåld i Chicagos innerstad av en algoritm. "Heatlistan" som algoritmen hjälpte till att sammanställa letade efter mönster som skulle kunna förutsäga framtida lagöverträdare eller offer, även om de själva inte hade gjort något för att motivera denna granskning utöver att överensstämma med en profil.

Som den Chicago Tribune noterade: "Strategien kräver att varna dem på värmelistan individuellt för att ytterligare kriminell aktivitet, även för de mest ringa förseelser, kommer att leda till att lagens fulla kraft fälls dem."

Drömmen om förutsägande polisarbete var att, genom att agera på kvantifierbara data, skulle det göra polisarbetet inte bara mer effektivt, utan också mindre benäget att gissa och, som ett resultat, partiskhet. Det skulle, hävdade förespråkarna, förändra polisväsendet till det bättre och inleda en ny era av smart polisarbete. Men från nästan första början har förutsägande polisarbete haft starka kritiker. De hävdar att, snarare än att hjälpa till att bli av med problem som rasism och andra systemiska fördomar, kan förutsägande polisarbete faktiskt hjälpa till att befästa dem. Och det är svårt att hävda att de inte har en poäng.

Diskriminerande algoritmer

Tanken att maskininlärningsbaserade prediktiva polissystem kan lära sig att diskriminera baserat på faktorer som ras är ingen nyhet. Maskininlärningsverktyg tränas med enorma mängder data. Och så länge som dessa uppgifter samlas in av ett system där ras fortsätter att vara en överväldigande faktor, kan det leda till diskriminering.

Som Renata M. O'Donnell skriver i en tidning från 2019, med titeln "Utmana rasistiska förutsägande polisiära algoritmer enligt klausulen om lika skydd," maskininlärningsalgoritmer lär sig från data som härrör från ett rättssystem där "svarta amerikaner fängslas i statliga fängelser i en takt det är 5,1 gånger vitas fängelse, och en av tre svarta män som är födda i dag kan förvänta sig att hamna i fängelse under sin livstid om trenderna är aktuella Fortsätta."

"Data är inte objektiv," sa Ferguson till Digital Trends. "Det är bara vi som reducerats till binär kod. Datadrivna system som fungerar i den verkliga världen är inte mer objektiva, rättvisa eller opartiska än den verkliga världen. Om din verkliga värld är strukturellt ojämlik eller rasdiskriminerande, kommer ett datadrivet system att spegla dessa samhälleliga orättvisor. Ingångarna som går in är behäftade med bias. Analysen är behäftad med partiskhet. Och mekanismerna för polismyndighet förändras inte bara för att det finns teknik som styr systemen."

Ferguson ger exemplet med arresteringar som en till synes objektiv faktor för att förutsäga risk. Men arresteringarna kommer att ske på grund av tilldelningen av polisresurser (till exempel var de patrullerar) och de typer av brott som vanligtvis motiverar arresteringar. Detta är bara en illustration av potentiellt problematiska data.

Farorna med smutsiga data

Saknade och felaktiga data kallas ibland i datautvinning som "smutsiga data". A 2019 uppsats av forskare från A.I. Nu Institute vid New York University utökar denna term till att även hänvisa till data som påverkas av korrupta, partiska och olagliga praxis - oavsett om det är från avsiktligt manipulerat som är förvrängt av individuella och samhälleliga fördomar. Det kan till exempel omfatta data som genereras från gripandet av en oskyldig person som har fått bevis planterad på sig eller som på annat sätt är falskt anklagad.

Det finns en viss ironi i det faktum att under de senaste decennierna kraven från datasamhället, där allt handlar om kvantifiering och gjutjärns numeriska mål, har precis lett till en hel del … ja, verkligen dålig data. HBO-serien Tråden visade upp det verkliga fenomenet att "juka statistiken", och åren sedan programmet gick ur luften har bjudit på massor av exempel på faktisk systemisk datamanipulation, falska polisrapporter och grundlagsstridiga metoder som har skickat oskyldiga människor till fängelse.

Dålig data som tillåter makthavare att på konstgjord väg träffa mål är en sak. Men kombinera det med algoritmer och prediktiva modeller som använder detta som sin grund för att modellera världen så får du potentiellt något mycket värre.

Forskare har visat hur tvivelaktiga brottsdata kopplade till prediktiva polisalgoritmer kan skapa vad som kallas "runaway feedback loopar”, där poliser upprepade gånger skickas till samma stadsdelar oavsett den sanna brottsligheten. En av medförfattarna till den tidningen, datavetare Suresh Venkatasubramanian, säger att maskininlärningsmodeller kan bygga in felaktiga antaganden genom sin modellering. Liksom det gamla talesättet om hur varje problem ser ut som en spik för den som har en hammare, modellerar dessa system bara vissa delar till ett problem - och föreställer sig bara ett möjligt resultat.

"[Något som] inte tas upp i dessa modeller är i vilken utsträckning modellerar du det faktum att kasta fler poliser i ett område faktiskt kan sänka livskvaliteten för människor som bor där?” Venkatasubramanian, professor vid School of Computing vid University of Utah, berättade för Digital Trender. "Vi antar att fler poliser är en bättre sak. Men som vi ser just nu är det inte nödvändigtvis bra att ha fler poliser. Det kan faktiskt göra saker värre. I inte en modell som jag någonsin har sett har någon någonsin frågat vad kostnaden är för att sätta in fler poliser i ett område."

Den osäkra framtiden för predictive policing

De som arbetar med förutsägande polisarbete använder ibland unironiskt termen "minoritetsrapport" för att hänvisa till vilken typ av förutsägelse de gör. Termen åberopas ofta som en referens till 2002 film med samma namn, som i sin tur var löst baserad på en novell från 1956 av Philip K. Kuk. I Minoritetsrapport, en särskild PreCrime-polisavdelning griper brottslingar baserat på förkunskaper om brott som kommer att begås i framtiden. Dessa prognoser tillhandahålls av tre synska personer som kallas "precogs".

Men vridningen in Minoritetsrapport är att förutsägelserna inte alltid är korrekta. Avvikande visioner av en av precogs ger en alternativ syn på framtiden, som undertrycks av rädsla för att få systemet att framstå som opålitligt.

Internrevisioner som visar att taktiken inte fungerade. Inte bara var de prediktiva listorna felaktiga, de var också ineffektiva.

Just nu står predictive policing inför sin egen osäkra framtid. Vid sidan av ny teknik som ansiktsigenkänning har den teknik som är tillgänglig för brottsbekämpande myndigheter för eventuell användning aldrig varit mer kraftfull. Samtidigt har medvetenheten om användningen av förutsägande polisarbete orsakat en offentlig motreaktion som faktiskt kan ha hjälpt till att stoppa den. Ferguson berättade för Digital Trends att användningen av prediktiva polisverktyg har varit på en "nedgång" under de senaste åren.

"På sin zenit fanns [platsbaserad prediktiv polisverksamhet] i över 60 större städer och växer, men som ett resultat av framgångsrik samhällsorganisering har den till stor del reducerats och/eller ersatts med andra former av datadriven analys, sa han. "Kort sagt, termen predictive policing blev giftig, och polisavdelningar lärde sig att byta namn på vad de gjorde med data. Personbaserad prediktiv polisverksamhet hade ett brantare fall. De två största städerna som investerat i dess skapelse - Chicago och Los Angeles - backade upp sin personbaserade strategier efter skarp samhällskritik och förödande interna revisioner som visar att taktiken inte gjorde det arbete. Inte bara var de prediktiva listorna felaktiga, de var också ineffektiva."

Fel verktyg för jobbet?

Dock, Rashida Richardson, chef för policyforskning vid A.I. Nu sa Institutet att det finns för mycket opacitet om användningen av denna teknik. "Vi vet fortfarande inte på grund av bristen på transparens när det gäller statligt förvärv av teknik och många kryphål i befintliga upphandlingsförfaranden som kan skydda vissa teknikköp från offentlig granskning.” Hon sa. Hon ger ett exempel på teknik som kan ges till en polisavdelning gratis eller köpas av en tredje part. "Vi vet från forskning som min och mediarapportering att många av de största polisavdelningarna i USA har använt teknik någon gång, men det finns också många små polisavdelningar som använder den, eller har använt den under begränsade perioder av tid."

Med tanke på det aktuella förhöret om polisens roll, kommer det att finnas en frestelse att omfamna predictive policing som ett verktyg för datadrivet beslutsfattande - kanske under mindre dystopisk sci-fi varumärke? Det finns möjlighet att en sådan återuppgång kan uppstå. Men Venkatasubramanian är mycket skeptisk till att maskininlärning, som den för närvarande praktiseras, är rätt verktyg för jobbet.

"Helheten i maskininlärning och dess framgång i det moderna samhället bygger på premissen att, oavsett vad det är i verkligheten problem, det handlar i slutändan om att samla in data, bygga en modell, förutsäga resultatet – och du behöver inte oroa dig för domänen.” han sa. "Du kan skriva samma kod och använda den på 100 olika ställen. Det är löftet om abstraktion och portabilitet. Problemet är att när vi använder det som folk kallar socio-tekniska system, där man har människor och teknik inblandade i komplicerade vågor, så kan man inte göra detta. Du kan inte bara koppla in en bit och förvänta dig att den ska fungera. För [det finns] ringeffekter med att sätta in den biten och det faktum att det finns olika spelare med olika agendor i ett sådant system, och de undergräver systemet till sina egna behov olika sätt. Alla dessa saker måste beaktas när du pratar om effektivitet. Ja, man kan säga abstrakt att allt kommer att fungera bra, men där är inget abstrakt. Det finns bara sammanhanget du arbetar i."