Policiamento preditivo deveria transformar a forma como o policiamento era realizado, conduzindo-nos a um mundo de leis inteligentes aplicação em que o preconceito fosse removido e a polícia pudesse responder aos dados, e não palpites. Mas uma década depois de a maioria de nós ter ouvido pela primeira vez o termo “policiamento preditivo”, parece claro que não funcionou. Impulsionada por uma reação pública, a tecnologia está a sofrer um declínio significativo na sua utilização, em comparação com apenas alguns anos atrás.

Conteúdo

- A promessa do policiamento preditivo

- Algoritmos discriminatórios

- Os perigos dos dados sujos

- O futuro incerto do policiamento preditivo

- As ferramentas erradas para o trabalho?

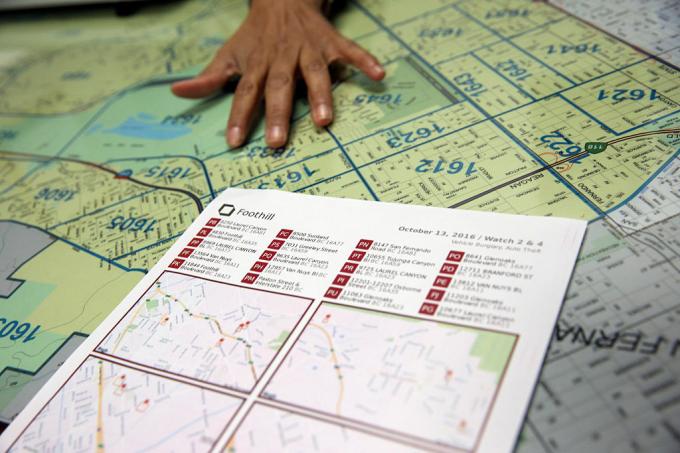

Em Abril deste ano, Los Angeles – que, segundo o LA Times, “foi pioneira na previsão da criminalidade com dados” – cortou o financiamento do seu programa de policiamento preditivo, culpando o custo. “Essa é uma decisão difícil”, disse o chefe de polícia Michel Moore

disse ao LA Times. “É uma estratégia que usamos, mas as projeções de custos de centenas de milhares de dólares para gastar nesse direito agora, em vez de encontrar esse dinheiro e direcioná-lo para outras atividades mais centrais, é o que tenho que fazer.”Vídeos recomendados

O que deu errado? Como é que algo anunciado como tecnologia “inteligente” poderia acabar por consolidar ainda mais os preconceitos e a discriminação? E será que o sonho do policiamento preditivo pode ser ajustado com o algoritmo certo – ou um beco sem saída numa sociedade mais justa que está atualmente a debater-se com a forma como a polícia deve operar?

A promessa do policiamento preditivo

O policiamento preditivo em sua forma atual remonta a cerca de uma década, a um artigo de 2009 da psicóloga Colleen McCue e do chefe de polícia de Los Angeles, Charlie Beck, intitulado “Policiamento Preditivo: O que podemos aprender com o Walmart e a Amazon sobre o combate ao crime em uma recessão?” No artigo, eles aproveitaram a forma como o big data estava sendo usado pelos grandes varejistas para ajudar a descobrir padrões no comportamento passado do cliente que poderiam ser usados para prever o comportamento futuro. Graças aos avanços na computação e na recolha de dados, McCue e Beck sugeriram que era possível recolher e analisar dados criminais em tempo real. Estes dados poderiam então ser utilizados para antecipar, prevenir e responder de forma mais eficaz a crimes que ainda não tinham ocorrido.

Nos anos que se seguiram, o policiamento preditivo passou de uma ideia descartável para uma realidade em muitas partes dos Estados Unidos, juntamente com o resto do mundo. No processo, propôs-se transformar o policiamento de uma força reactiva numa força proactiva; aproveitando alguns dos avanços na tecnologia baseada em dados que tornam possível detectar padrões em tempo real – e agir de acordo com eles.

“Existem duas formas principais de policiamento preditivo”, Andrew Ferguson, professor de direito da Universidade do Distrito de Columbia David A. Clarke School of Law e autor de A ascensão do policiamento de big data: vigilância, raça e o futuro da aplicação da lei, disse Tendências Digitais. “[Estes são] policiamento preditivo baseado no local e policiamento preditivo baseado na pessoa.”

Em ambos os casos, os sistemas de policiamento preditivo atribuem uma pontuação de risco à pessoa ou local em questão, o que incentiva a polícia a fazer o acompanhamento num determinado intervalo. A primeira destas abordagens, o policiamento preditivo baseado no local, centra-se predominantemente em patrulhas policiais. Envolve o uso de mapeamento criminal e análises sobre os locais prováveis de crimes futuros, com base em estatísticas anteriores.

Em vez de ajudar a eliminar problemas como o racismo e outros preconceitos sistémicos, o policiamento preditivo pode, na verdade, ajudar a consolidá-los.

A segunda abordagem concentra-se em prever a probabilidade de um indivíduo representar um risco potencial futuro. Por exemplo, em 2013, um comandante da Polícia de Chicago foi enviado à casa de Robert McDaniel, de 22 anos, que foi sinalizado como um risco potencial ou perpetrador de violência armada no centro da cidade de Chicago por um algoritmo. A “lista de calor” que o algoritmo ajudou a montar procurava padrões que pudessem prever futuros infratores ou vítimas, mesmo que elas próprias não tenham feito nada que justifique esse escrutínio além de se conformarem a um perfil.

Enquanto o Chicago Tribune observou: “A estratégia exige alertar individualmente aqueles que estão na lista de calor de que novas atividades criminosas, mesmo para os delitos mais pequenos, resultará na aplicação de toda a força da lei sobre eles."

O sonho do policiamento preditivo era que, ao agir com base em dados quantificáveis, tornaria o policiamento não só mais eficiente, mas também menos sujeito a suposições e, como resultado, a preconceitos. Segundo os proponentes, isso mudaria o policiamento para melhor e inauguraria uma nova era de policiamento inteligente. No entanto, quase desde o início, o policiamento preditivo teve críticos ferrenhos. Argumentam que, em vez de ajudar a eliminar problemas como o racismo e outros preconceitos sistémicos, o policiamento preditivo pode, na verdade, ajudar a consolidá-los. E é difícil argumentar que eles não têm razão.

Algoritmos discriminatórios

A ideia de que os sistemas de policiamento preditivo baseados em aprendizagem automática podem aprender a discriminar com base em factores como a raça não é novidade. As ferramentas de aprendizado de máquina são treinadas com grandes quantidades de dados. E, desde que esses dados sejam recolhidos por um sistema em que a raça continue a ser um factor esmagador, isso pode levar à discriminação.

Como Renata M. O'Donnell escreve em um artigo de 2019, intitulado “Desafiando algoritmos de policiamento preditivo racista sob a cláusula de proteção igualitária”, algoritmos de aprendizado de máquina estão aprendendo com dados derivados de um sistema de justiça no qual “os negros americanos são encarcerados em prisões estaduais a uma taxa isso é 5,1 vezes o encarceramento de brancos, e um em cada três homens negros nascidos hoje pode esperar ir para a prisão durante sua vida se as tendências atuais continuar."

“Os dados não são objetivos”, disse Ferguson à Digital Trends. “Somos apenas nós reduzidos ao código binário. Os sistemas baseados em dados que operam no mundo real não são mais objetivos, justos ou imparciais do que o mundo real. Se o seu mundo real for estruturalmente desigual ou racialmente discriminatório, um sistema baseado em dados refletirá essas desigualdades sociais. As informações recebidas são contaminadas por preconceitos. A análise está contaminada por preconceitos. E os mecanismos da autoridade policial não mudam só porque existe tecnologia guiando os sistemas.”

Ferguson dá o exemplo das prisões como um fator aparentemente objetivo na previsão de risco. No entanto, as detenções serão distorcidas pela atribuição de recursos policiais (tais como o local onde patrulham) e pelos tipos de crimes que normalmente justificam detenções. Esta é apenas uma ilustração de dados potencialmente problemáticos.

Os perigos dos dados sujos

Dados ausentes e incorretos são às vezes chamados de “dados sujos” na mineração de dados. A Artigo de 2019 de pesquisadores do A.I. Agora Instituto na Universidade de Nova York expande este termo para se referir também a dados que são influenciados por pessoas corruptas, tendenciosas e ilegais. práticas - sejam elas manipuladas intencionalmente e distorcidas por indivíduos e preconceitos sociais. Poderia, por exemplo, incluir dados gerados a partir da detenção de uma pessoa inocente a quem foram plantadas provas ou que seja falsamente acusada.

Há uma certa ironia no facto de, ao longo das últimas décadas, as exigências da sociedade de dados, em que tudo gira em torno de quantificação e metas numéricas sólidas, acabou de levar a um monte de... bem, realmente dados ruins. A série da HBO O fio apresentou o fenômeno do mundo real de “juking the stats”, e os anos desde que o programa saiu do ar ofereceram muitas exemplos reais de manipulação sistémica de dados, relatórios policiais falsos e práticas inconstitucionais que enviaram pessoas inocentes para cadeia.

Dados ruins que permitem que pessoas no poder atinjam alvos artificialmente são uma coisa. Mas combine isso com algoritmos e modelos preditivos que usam isso como base para modelar o mundo e você terá potencialmente algo muito pior.

Os pesquisadores demonstraram como dados criminais questionáveis conectados a algoritmos de policiamento preditivo podem criar o que é chamado de “ciclos de feedback descontrolados”, em que a polícia é enviada repetidamente para os mesmos bairros, independentemente da verdadeira taxa de criminalidade. Um dos co-autores desse artigo, cientista da computação Suresh Venkatasubramanian, diz que os modelos de aprendizado de máquina podem criar suposições erradas por meio de sua modelagem. Como diz o velho ditado sobre como, para quem tem um martelo, todo problema parece um prego, esses sistemas modelam apenas alguns elementos de um problema – e imaginam apenas um resultado possível.

“[Algo que] não é abordado nesses modelos é até que ponto você está modelando o fato de que enviar mais policiais para uma área pode realmente diminuir a qualidade de vida das pessoas que lá vivem?” Venkatasubramanian, professor da Escola de Computação da Universidade de Utah, disse ao Digital Tendências. “Presumimos que mais policiais é uma coisa melhor. Mas, como vemos agora, ter mais polícia não é necessariamente uma coisa boa. Na verdade, pode piorar as coisas. Em nenhum modelo que já vi alguém perguntou qual é o custo de colocar mais policiais em uma área.”

O futuro incerto do policiamento preditivo

Aqueles que trabalham no policiamento preditivo usam por vezes, sem ironia, o termo “Relatório Minoritário” para se referir ao tipo de previsão que estão a fazer. O termo é frequentemente invocado como uma referência ao Filme de 2002 com o mesmo nome, que por sua vez foi vagamente baseado em um conto de 1956 de Philip K. Pau. Em Relatório Minoritário, um departamento especial de polícia PreCrime apreende criminosos com base no conhecimento prévio de crimes que serão cometidos no futuro. Essas previsões são fornecidas por três médiuns chamados “precogs”.

Mas a reviravolta Relatório Minoritário é que as previsões nem sempre são precisas. As visões divergentes de um dos precognitivos proporcionam uma visão alternativa do futuro, que é suprimida por medo de fazer com que o sistema pareça indigno de confiança.

Auditorias internas que mostram que as táticas não funcionaram. As listas preditivas não apenas eram falhas, mas também ineficazes.

Neste momento, o policiamento preditivo enfrenta o seu próprio futuro incerto. Juntamente com as novas tecnologias, como o reconhecimento facial, a tecnologia disponível para a aplicação da lei para possível utilização nunca foi tão poderosa. Ao mesmo tempo, a consciência do uso do policiamento preditivo causou uma reação pública que pode, na verdade, ter ajudado a suprimi-lo. Ferguson disse à Digital Trends que o uso de ferramentas de policiamento preditivo tem estado em “desaceleração” nos últimos anos.

“No seu apogeu, [o policiamento preditivo baseado no local] estava em mais de 60 grandes cidades e estava crescendo, mas como resultado de organização comunitária bem-sucedida, ela foi amplamente reduzida e/ou substituída por outras formas de análise”, disse ele. “Em suma, o termo policiamento preditivo tornou-se tóxico e os departamentos de polícia aprenderam a renomear o que faziam com os dados. O policiamento preditivo baseado na pessoa teve uma queda mais acentuada. As duas principais cidades que investiram na sua criação – Chicago e Los Angeles – recuaram na sua abordagem baseada na pessoa. estratégias após duras críticas da comunidade e auditorias internas devastadoras que mostram que as táticas não funcionaram trabalhar. As listas preditivas não eram apenas falhas, mas também ineficazes.”

As ferramentas erradas para o trabalho?

No entanto, Rashida Richardson, Diretor de Pesquisa Política da A.I. Agora o Instituto disse que há muita opacidade no uso dessa tecnologia. “Ainda não sabemos devido à falta de transparência em relação à aquisição governamental de tecnologia e muitos lacunas nos procedimentos de aquisição existentes que podem proteger certas compras de tecnologia do escrutínio público”, ela disse. Ela dá o exemplo de tecnologia que pode ser dada gratuitamente a um departamento de polícia ou adquirida por terceiros. “Sabemos, por pesquisas como a minha e por reportagens da mídia, que muitos dos maiores departamentos de polícia dos EUA usaram o tecnologia em algum momento, mas também há muitos pequenos departamentos de polícia que a utilizam ou a utilizaram por períodos limitados de tempo."

Dado o actual questionamento sobre o papel da polícia, haverá a tentação de abraçar novamente a policiamento preditivo como uma ferramenta para a tomada de decisões baseada em dados – talvez sob uma ficção científica menos distópica marca? Existe a possibilidade de que tal ressurgimento possa surgir. Mas Venkatasubramanian é altamente cético de que o aprendizado de máquina, como é praticado atualmente, seja a ferramenta certa para o trabalho.

“Todo o aprendizado de máquina e seu sucesso na sociedade moderna baseiam-se na premissa de que, não importa qual seja o real problema, em última análise, tudo se resume a coletar dados, construir um modelo, prever o resultado - e você não precisa se preocupar com o domínio”, ele disse. “Você pode escrever o mesmo código e aplicá-lo em 100 lugares diferentes. Essa é a promessa de abstração e portabilidade. O problema é que quando usamos o que as pessoas chamam de sistemas sociotécnicos, onde temos humanos e tecnologia entrelaçados em ondas complicadas, não podemos fazer isso. Você não pode simplesmente conectar uma peça e esperar que funcione. Porque [há] efeitos em cascata ao colocar essa peça e o fato de que existem diferentes intervenientes com agendas diferentes num tal sistema, e subvertem o sistema às suas próprias necessidades em jeitos diferentes. Todas essas coisas devem ser levadas em consideração quando se fala em eficácia. Sim, você pode dizer abstratamente que tudo funcionará bem, mas há é nada de abstrato. Existe apenas o contexto em que você está trabalhando.”