Aby nieco zmodyfikować tytuł znanego programu telewizyjnego: Dzieci robią najdziwniejsze rzeczy. Niedawno naukowcy z Niemiec i Wielkiej Brytanii przeprowadzili badanie, w którym stwierdzono, że opublikowane w czasopiśmie Nauka Robotyka, które pokazało, w jakim stopniu dzieci są podatne na presję rówieśników robotów. Wersja TLDR: odpowiedź na to stare pytanie rodziców: „Gdyby wszyscy twoi przyjaciele kazali ci skoczyć z klifu, zrobiłbyś to?” może równie dobrze brzmieć: „Jasne. Gdyby wszyscy moi przyjaciele byli robotami.”

Zawartość

- Czy dorośli naprawdę są o wiele mądrzejsi?

- Na każdy statek przypada wrak

Test odtwarzał słynny eksperyment z 1951 roku, którego pionierem był polski psycholog Solomon Asch. Eksperyment pokazał, jak na ludzi może wpływać nacisk myślenia grupowego, nawet jeśli jest to sprzeczne z informacjami, o których wiedzą, że są prawidłowe. W eksperymentach Ascha zebrano grupę studentów i pokazano im dwie karty. Karta po lewej stronie przedstawiała obraz pojedynczej pionowej linii. Karta po prawej stronie przedstawiała trzy linie o różnej długości. Następnie eksperymentator zapytał uczestników, która linia na prawej karcie odpowiada długości linii pokazanej na lewej karcie.

Polecane filmy

„Wyjątkową cechą dzieci w tym przedziale wiekowym jest to, że wciąż są w wieku, w którym zawieszą niewiarę”.

Póki co, prosto. Jednak sytuacja stała się bardziej przebiegła w składzie grupy. Tylko jedna osoba z grupy była prawdziwym uczestnikiem, a pozostali byli aktorami, którym wcześniej powiedziano, co mają powiedzieć. Eksperyment miał na celu sprawdzenie, czy prawdziwy uczestnik zgodzi się z resztą grupy, gdy jednomyślnie poda błędną odpowiedź. Jak się okazało, większość tak. Presja rówieśnicza oznacza, że większość ludzi zaprzeczy informacjom, które są w sposób oczywisty poprawne, jeśli oznacza to zgodność z opinią większości.

Powiązany

- Ewoluujące, samoreplikujące się roboty już tu są – ale nie martw się powstaniem

- Roboty nie przyjdą, żeby ukraść Twoją pracę. Przychodzą, żeby to poprawić

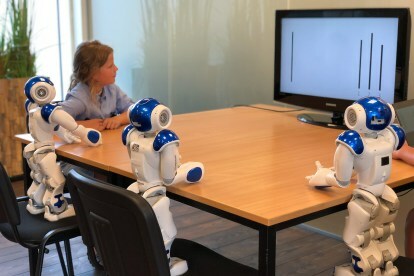

W remiksie eksperymentu z 2018 roku zastosowano tę samą zasadę – tyle że zamiast grupy rówieśników w wieku studenckim „prawdziwym uczestnikiem” było dziecko w wieku od siedmiu do dziewięciu lat. W rolę „aktorów” wcielały się trzy roboty zaprogramowane tak, aby udzielały błędnych odpowiedzi. W próbie 43 ochotników 74 procent dzieci udzieliło tej samej błędnej odpowiedzi, co roboty. Wyniki sugerują, że większość dzieci w tym wieku będzie traktować presję ze strony robotów tak samo, jak presję rówieśników ze strony rówieśników z krwi i kości.

„Wyjątkową cechą dzieci w tym przedziale wiekowym jest to, że wciąż są w wieku, w którym zawieszą niewiarę” – Tony’ego Belpaeme’a, profesor inteligentnych i autonomicznych systemów sterowania, który pomógł w przeprowadzeniu badania, powiedział Digital Trends. „Będą się bawić zabawkami i nadal będą wierzyć, że ich figurki lub lalki są prawdziwe; nadal będą patrzeć na przedstawienie kukiełkowe i naprawdę wierzyć w to, co się dzieje; mogą nadal wierzyć w [Świętego Mikołaja]. To samo dzieje się, gdy patrzą na robota: nie widzą elektroniki i plastiku, ale raczej charakter społeczny”.

Co ciekawe, w eksperymencie porównano to z odpowiedzią dorosłych. W przeciwieństwie do dzieci, dorośli nie dali się zwieść błędom robotów. „Kiedy dorosły zobaczył, że robot udziela błędnej odpowiedzi, spojrzał na niego ze zdziwieniem, a następnie udzielił prawidłowej odpowiedzi” – kontynuował Belpaeme.

Więc nie ma się czym martwić? Dopóki nie pozwolimy dzieciom dotykać robotów zaprogramowanych do dawania złych reakcji, wszystko powinno być w porządku, prawda? Nie bądź taki szybki.

Czy dorośli naprawdę są o wiele mądrzejsi?

Jak przyznał Belpaeme, zadanie to zostało zaprojektowane tak, aby było tak proste, że nie było niepewności co do odpowiedzi. Prawdziwy świat jest inny. Kiedy myślimy o rodzajach prac, które można łatwo powierzyć maszynom, często są to zadania, których jako ludzie nie zawsze jesteśmy w stanie wykonać doskonale.

Zadanie to zostało zaprojektowane tak, aby było tak proste, że nie było niepewności co do odpowiedzi.

Może się zdarzyć, że zadanie jest niewiarygodnie proste, ale maszyna może je wykonać znacznie szybciej niż my. Może to być jednak zadanie bardziej złożone, w którym komputer ma dostęp do znacznie większej ilości danych niż my. W zależności od potencjalnego wpływu wykonywanej pracy nie jest zaskoczeniem, że wielu z nas byłoby niezadowolonych z poprawiania maszyny.

Czy pielęgniarka w szpitalu byłaby zadowolona z unieważnienia tej decyzji Algorytm zatwierdzony przez FDA które mogą pomóc w ustaleniu priorytetów dotyczących zdrowia pacjenta poprzez monitorowanie parametrów życiowych, a następnie wysyłanie ostrzeżeń do personelu medycznego? A może kierowca czułby się komfortowo przejmując kierownicę samochodu autonomicznego, mając do czynienia ze szczególnie złożonym scenariuszem drogowym? A może nawet pilot pomijający autopilota, ponieważ uważa, że podejmowana jest zła decyzja? We wszystkich tych przypadkach chcielibyśmy myśleć, że odpowiedź brzmi „tak”. Jednak z różnych powodów może to nie być rzeczywistość.

Pisze o tym Nicholas Carr w swojej książce z 2014 roku Szklana klatka: dokąd zabiera nas automatyzacja. Sposób, w jaki to opisuje, podkreśla rodzaj niejednoznaczności, z jaką wiążą się rzeczywiste przypadki automatyzacji, tam, gdzie występują problemy znacznie bardziej skomplikowane niż długość linii na karcie, maszyny są znacznie mądrzejsze, a wynik jest potencjalnie lepszy kluczowy.

„Jak zmierzyć koszt erozji wysiłku i zaangażowania, zaniku sprawczości i autonomii lub subtelnego pogorszenia umiejętności? Nie można” – pisze. „Są to rodzaje niewyraźnych, nieuchwytnych rzeczy, które rzadko doceniamy, dopóki nie znikną, a nawet wtedy możemy mieć problemy z konkretnym wyrażeniem strat”.

„Są to rodzaje cienistych, nieuchwytnych rzeczy, które rzadko doceniamy, dopóki nie znikną”.

Roboty społeczne tego rodzaju, o których teoretyzuje Belpaeme w artykule badawczym, nie są jeszcze głównym nurtem, ale istnieją już ilustracje niektórych z tych zagadek w praktyce. Na przykład Carr rozpoczyna swoją książkę wzmianką o notatce Federalnej Administracji Lotniczej, w której zauważono, że piloci powinni spędzać mniej czasu na lataniu na autopilocie ze względu na związane z tym ryzyko. Opierało się to na analizie danych dotyczących wypadków, która wykazała, że piloci często w zbyt dużym stopniu polegają na systemach skomputeryzowanych.

Podobna sprawa dotyczyła pozwu z 2009 roku, w którym uczestniczyła kobieta o nazwisku Lauren Rosenberg złożył pozew przeciwko Google’owi po tym, jak polecono mu iść trasą prowadzącą do niebezpiecznego ruchu. Choć sprawa została wyrzucona z sądu, pokazuje, że ludzie przekroczą własny zdrowy rozsądek w przekonaniu, że inteligencja maszynowa ma większą inteligencję od nas.

Na każdy statek przypada wrak

Ostatecznie, jak przyznaje Belpaeme, problem polega na tym, że czasami chcemy przekazać podejmowanie decyzji maszynom. Roboty obiecaj wykonywać pracę nudną, brudną i niebezpieczną — i jeśli będziemy musieli ponownie rozważyć każdą decyzję, tak naprawdę nie są to obiecane urządzenia oszczędzające pracę. Jeśli w końcu mamy zaprosić roboty do naszego domu, chcemy, aby mogły działać autonomicznie, a to będzie wymagało pewnego poziomu zaufania.

„Roboty wywierające na ciebie presję społeczną mogą być dobrą rzeczą; to nie musi być złowrogie” – kontynuował Belpaeme. „Jeśli masz roboty używane w opiece zdrowotnej lub edukacji, chcesz, aby mogły na ciebie wpływać. Na przykład, jeśli chcesz schudnąć, możesz otrzymać robota odchudzającego na dwa miesiące monitory spożycie kalorii i zachęca do większej aktywności fizycznej. Chcesz, żeby taki robot był przekonujący i wywierał na Ciebie wpływ. Ale każda technologia, którą można wykorzystać w dobrym celu, może być również wykorzystana w złym celu.

Jaka jest na to odpowiedź? Kwestie tego typu będą omawiane indywidualnie dla każdego przypadku. Jeśli zło ostatecznie przeważy nad dobrem, technologia taka jak roboty społeczne nigdy się nie sprawdzi. Ważne jest jednak, abyśmy wyciągnęli właściwe wnioski z badań takich jak to dotyczące presji rówieśniczej wywoływanej przez roboty. I nie chodzi o to, że jesteśmy o wiele mądrzejsi od dzieci.

Zalecenia redaktorów

- Przyszłość automatyzacji: Roboty nadchodzą, ale nie zabiorą Ci pracy

- Te roboty tasują chwasty na śmierć, więc rolnicy nie potrzebują chemicznych herbicydów