Som et par joggesko noen har på seg? Eller kanskje en kjole? Det er ganske mange apper og tjenester - som Amazons Firefly eller Samsungs Bixby Vision — som lar deg rett og slett peke smarttelefonkameraet mot objektet og søke etter det, eller lignende stiler. Google følger etter med en lignende funksjon i Google Lens, men den har potensial til å nå langt flere mennesker.

Anbefalte videoer

Google Lens er for tiden innebygd i Google Assistant på Android telefoner, samt Google Foto. Den lar deg peke på smarttelefon kamera på objekter for å identifisere dem, lære deg mer om landemerker, gjenkjenne QR-koder, hente kontaktinformasjon fra visittkort og mer. På sin årlige Google I/O-utviklerkonferanse kunngjorde søkegiganten fire nye forbedringer av Lens, og vi fikk prøve det ut.

Innebygd i kameraapper

Google Lens er nå innebygd i kameraappen på telefoner fra 10 produsenter: LG, Motorola, Xiaomi, Sony, Nokia, Transsion, TCL, OnePlus, BQ, Asus. Det inkluderer ikke Googles egne

Google Pixel 2. Du har fortsatt tilgang til den gjennom Google Assistant på alleI slekt

- Apple-kortet ditt vil snart få sin egen sparekonto – slik ser det ut

- Den nye Google Wallet-appen har landet, og slik ser den ut

- Google legger til en privat låst bildemappe til iPhones for "personlige" bilder

Vi fikk en sjanse til å prøve den ut på den nylig annonserte LG G7 ThinQ, og det nye alternativet sitter rett ved siden av telefonens portrettmodus.

Stilmatch

Det største tillegget til Lens i denne I/O-kunngjøringen er Style Match. Som Bixby Vision eller Amazon Firefly, kan du peke på

Det er relativt raskt og en enkel måte å finne ting du ikke kan skrive inn i Googles søkefelt.

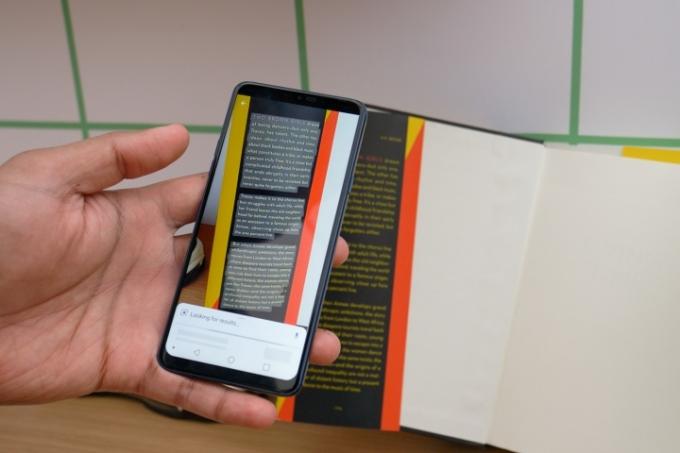

Smart tekstvalg

Kanskje enda mer nyttig er Smart Text Selection. Pek Google Lens på tekst, si som fra en bok eller en meny, og det kan skille ut teksten fra alt annet. Du kan deretter trykke på teksten og kopiere den eller oversette den. Da vi prøvde det, klarte Lens å ta hele tre avsnitt med tekst, selv om vi måtte gjøre flere tester for å se hvor godt den kan fange opp håndskrevet tekst.

Sanntid

Google Lens fungerer nå i sanntid, så du trenger ikke pause og ta et bilde for å forstå motivet. Det betyr at du kan peke den på flere ting, og du vil se at den lager fargede prikker på objektene den henter informasjon om. Google sa at de identifiserer milliarder av ord, setninger og ting på et brøkdel av et sekund, alt takket være "state-of-the-art maskinlæring, intelligens på enheten og sky-TPUer."

Google sa at det vil rulle ut alle disse funksjonene mot slutten av mai.

Redaktørenes anbefalinger

- Her er hvordan Android-telefoner kan ha sett ut uten iPhone

- Denne nye Google Lens-funksjonen ser ut som den er rett ut av en sci-fi-film

- Slik ser Googles Pixel Watch ut på et håndledd

- Prisene på Google Pixel 6 ser ut til å matche Apples iPhone 13

- Apple lar deg nå enkelt flytte iCloud Photos-innhold til Google Photos

Oppgrader livsstilen dinDigitale trender hjelper leserne å følge med på den fartsfylte teknologiverdenen med alle de siste nyhetene, morsomme produktanmeldelser, innsiktsfulle redaksjoner og unike sniktitter.