Police prédictive était censé transformer la façon dont la police était exercée, nous faisant entrer dans un monde de droit intelligent une application de la loi dans laquelle les préjugés seraient éliminés et la police serait en mesure de répondre aux données, et non de des intuitions. Mais dix ans après que la plupart d’entre nous ont entendu pour la première fois le terme « police prédictive », il semble clair que cela n’a pas fonctionné. Poussée par la réaction du public, cette technologie connaît un déclin significatif de son utilisation par rapport à il y a seulement quelques années.

Contenu

- La promesse d’une police prédictive

- Algorithmes discriminatoires

- Les dangers des données sales

- L’avenir incertain de la police prédictive

- Les mauvais outils pour le travail ?

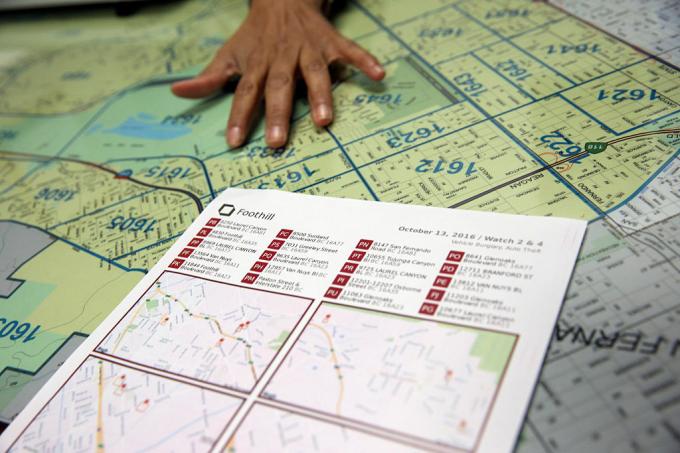

En avril de cette année, Los Angeles – qui, selon le LA Times, « a été le premier à prédire la criminalité à l’aide de données » – a réduit le financement de son programme de police prédictive, en accusant le coût. "C'est une décision difficile", a déclaré le chef de la police Michel Moore.

a déclaré au LA Times. "C'est une stratégie que nous avons utilisée, mais les coûts projetés de centaines de milliers de dollars à consacrer à cette stratégie maintenant, plutôt que de trouver cet argent et de le diriger vers d’autres activités plus centrales, c’est ce que je dois faire.Vidéos recommandées

Qu'est ce qui ne s'est pas bien passé? Comment une technologie présentée comme « intelligente » pourrait-elle finir par renforcer davantage les préjugés et la discrimination? Et le rêve d’une police prédictive est-il un rêve qui pourrait être peaufiné avec le bon algorithme – ou une impasse dans une société plus juste qui est actuellement aux prises avec la manière dont la police devrait fonctionner ?

La promesse d’une police prédictive

La police prédictive dans sa forme actuelle remonte à environ une décennie dans un article de 2009 de la psychologue Colleen McCue et du chef de la police de Los Angeles, Charlie Beck, intitulé «Police prédictive: que pouvons-nous apprendre de Walmart et d'Amazon sur la lutte contre la criminalité en période de récession ?« Dans cet article, ils ont exploité la manière dont les grands détaillants utilisaient le Big Data pour aider à découvrir des modèles de comportement passé des clients qui pourraient être utilisés pour prédire le comportement futur. Grâce aux progrès de l’informatique et de la collecte de données, McCue et Beck ont suggéré qu’il était possible de collecter et d’analyser des données sur la criminalité en temps réel. Ces données pourraient ensuite être utilisées pour anticiper, prévenir et répondre plus efficacement à des crimes qui n’avaient pas encore eu lieu.

Au cours des années qui ont suivi, la police prédictive est passée d’une idée jetable à une réalité dans de nombreuses régions des États-Unis, ainsi que dans le reste du monde. Ce faisant, il a entrepris de faire passer la police d'une force réactive à une force proactive; s'appuyant sur certaines des avancées technologiques basées sur les données qui permettent de détecter des modèles en temps réel et d'agir en conséquence.

« Il existe deux formes principales de police prédictive » Andrew Ferguson, professeur de droit à l'Université du District de Columbia David A. Clarke School of Law et auteur de L’essor de la police du Big Data: surveillance, race et avenir des forces de l’ordre, a déclaré à Digital Trends. « [Il s’agit] d’une police prédictive basée sur le lieu et d’une police prédictive basée sur la personne. »

Dans les deux cas, les systèmes de police prédictive attribuent un score de risque à la personne ou au lieu en question, ce qui incite la police à effectuer un suivi à intervalle donné. La première de ces approches, la police prédictive basée sur le lieu, se concentre principalement sur les patrouilles de police. Cela implique l’utilisation d’une cartographie de la criminalité et d’analyses sur les lieux probables de futurs crimes, sur la base de statistiques antérieures.

Plutôt que d’aider à éliminer des problèmes tels que le racisme et d’autres préjugés systémiques, la police prédictive peut en réalité contribuer à les consolider.

La deuxième approche se concentre sur la prévision de la probabilité qu’un individu présente un risque futur potentiel. Par exemple, en 2013, un commandant de la police de Chicago a été envoyé au domicile de Robert McDaniel, 22 ans, qui avait été signalé comme un risque potentiel ou un auteur de violence armée dans le centre-ville de Chicago par un algorithme. La « liste de prédilection » que l'algorithme a aidé à établir recherchait des modèles susceptibles de prédire les futurs délinquants. ou des victimes, même si elles n'avaient elles-mêmes rien fait pour justifier cet examen, au-delà de se conformer à un profil.

Comme le Le Chicago Tribune a noté: « La stratégie appelle à avertir individuellement les personnes figurant sur la liste de sélection de toute activité criminelle supplémentaire, même pour les délits les plus mineurs, la loi sera appliquée dans toute sa force. eux."

Le rêve d’une police prédictive était qu’en agissant sur des données quantifiables, elle rendrait le maintien de l’ordre non seulement plus efficace, mais aussi moins sujet aux conjectures et, par conséquent, aux préjugés. Selon ses partisans, cela modifierait la police pour le mieux et inaugurerait une nouvelle ère de police intelligente. Cependant, depuis presque le tout début, la police prédictive a fait l’objet de ferventes critiques. Ils soutiennent que, plutôt que d’aider à éliminer des problèmes tels que le racisme et d’autres préjugés systémiques, la police prédictive pourrait en réalité contribuer à les consolider. Et il est difficile de prétendre qu’ils n’ont pas raison.

Algorithmes discriminatoires

L’idée selon laquelle les systèmes de police prédictive basés sur l’apprentissage automatique peuvent apprendre à discriminer en fonction de facteurs tels que la race n’est pas nouvelle. Les outils d’apprentissage automatique sont entraînés avec d’énormes quantités de données. Et tant que ces données sont collectées par un système dans lequel la race reste un facteur prédominant, cela peut conduire à la discrimination.

Comme le dit Renata M. O’Donnell écrit dans un article de 2019, intitulé «Remettre en question les algorithmes racistes de police prédictive dans le cadre de la clause d’égalité de protection", les algorithmes d'apprentissage automatique apprennent à partir de données dérivées d'un système judiciaire dans lequel "les Noirs américains sont incarcérés dans les prisons d'État à un rythme élevé". cela représente 5,1 fois l'emprisonnement des Blancs, et un homme noir sur trois né aujourd'hui peut s'attendre à aller en prison au cours de sa vie si les tendances actuelles continuer."

"Les données ne sont pas objectives", a déclaré Ferguson à Digital Trends. « C’est juste nous réduits au code binaire. Les systèmes basés sur les données qui fonctionnent dans le monde réel ne sont pas plus objectifs, justes ou impartiaux que le monde réel. Si votre monde réel est structurellement inégal ou racialement discriminatoire, un système basé sur les données reflétera ces inégalités sociétales. Les apports entrants sont entachés de biais. L’analyse est entachée de parti pris. Et les mécanismes d’autorité de la police ne changent pas simplement parce qu’il existe une technologie qui guide les systèmes.

Ferguson donne l’exemple des arrestations comme un facteur apparemment objectif de prévision du risque. Cependant, les arrestations seront faussées par l'allocation des ressources policières (comme les lieux de patrouille) et les types de crimes qui justifient généralement une arrestation. Ceci n’est qu’une illustration de données potentiellement problématiques.

Les dangers des données sales

Les données manquantes et incorrectes sont parfois appelées « données sales » dans le data mining. UN Article 2019 rédigé par des chercheurs de l'A.I. Now Institute à l’Université de New York étend ce terme pour désigner également les données influencées par des données corrompues, biaisées et illégales. pratiques – qu’elles soient intentionnellement manipulées ou déformées par l’individu et préjugés sociétaux. Cela pourrait, par exemple, inclure des données générées par l’arrestation d’une personne innocente sur laquelle des preuves ont été déposées ou qui est autrement accusée à tort.

Il y a une certaine ironie dans le fait qu'au cours des dernières décennies, les exigences de la société des données, dans laquelle tout est question de quantification et d'objectifs numériques concrets, cela vient de conduire à tout un tas de… eh bien, vraiment mauvaises données. La série HBO Le fil a présenté le phénomène du monde réel consistant à « falsifier les statistiques », et les années qui se sont écoulées depuis la fin de la diffusion de l'émission ont offert de nombreuses possibilités. des exemples de manipulations systémiques réelles de données, de faux rapports de police et de pratiques inconstitutionnelles qui ont envoyé des innocents vers prison.

De mauvaises données qui permettent aux personnes au pouvoir d’atteindre artificiellement des cibles sont une chose. Mais combinez cela avec des algorithmes et des modèles prédictifs qui utilisent cela comme base pour modéliser le monde et vous obtenez potentiellement quelque chose de bien pire.

Les chercheurs ont démontré comment des données criminelles douteuses connectées à des algorithmes de police prédictive peuvent créer ce que l’on appelle «boucles de rétroaction incontrôlables», dans lequel la police est envoyée à plusieurs reprises dans les mêmes quartiers, quel que soit le taux de criminalité réel. L'un des co-auteurs de cet article, l'informaticien Suresh Venkatasubramanian, affirme que les modèles d'apprentissage automatique peuvent intégrer des hypothèses erronées grâce à leur modélisation. Comme le dit le vieil adage selon lequel, pour la personne qui tient un marteau, chaque problème ressemble à un clou, ces systèmes ne modélisent que certains éléments d'un problème et n'imaginent qu'un seul résultat possible.

« [Something that] n’est pas abordé dans ces modèles, c’est dans quelle mesure modélisez-vous le fait qu’envoyer plus de policiers dans une zone peut en fait diminuer la qualité de vie des personnes qui y vivent? Venkatasubramanian, professeur à la School of Computing de l'Université de l'Utah, a déclaré à Digital Les tendances. « Nous pensons qu’avoir plus de policiers est une meilleure chose. Mais comme nous le constatons actuellement, avoir plus de policiers n’est pas nécessairement une bonne chose. Cela peut en fait aggraver les choses. Dans aucun des modèles que j’ai jamais vu, personne n’a jamais demandé quel serait le coût de l’envoi de davantage de policiers dans une zone donnée.

L’avenir incertain de la police prédictive

Ceux qui travaillent dans le domaine de la police prédictive utilisent parfois, sans ironie, le terme « rapport minoritaire » pour désigner le type de prédiction qu'ils font. Le terme est fréquemment invoqué pour faire référence à Film de 2002 du même nom, qui était à son tour vaguement basé sur une nouvelle de 1956 de Philip K. Queue. Dans Rapport minoritaire, un service de police spécial PreCrime appréhende les criminels sur la base de la connaissance préalable des crimes qui vont être commis à l'avenir. Ces prévisions sont fournies par trois médiums appelés « précogs ».

Mais la torsion Rapport minoritaire c'est que les prédictions ne sont pas toujours exactes. Les visions dissidentes de l'un des précogs fournissent une vision alternative de l'avenir, qui est supprimée de peur de donner l'impression que le système n'est pas fiable.

Des audits internes qui montrent que les tactiques n’ont pas fonctionné. Non seulement les listes prédictives étaient erronées, mais elles étaient également inefficaces.

À l’heure actuelle, la police prédictive est confrontée à un avenir incertain. Parallèlement aux nouvelles technologies telles que la reconnaissance faciale, la technologie dont disposent les forces de l’ordre pour une utilisation éventuelle n’a jamais été aussi puissante. Dans le même temps, la prise de conscience de l’utilisation de la police prédictive a provoqué une réaction publique qui a peut-être contribué à l’annuler. Ferguson a déclaré à Digital Trends que l’utilisation d’outils de police prédictive est en « déclin » depuis quelques années.

« À son apogée, [la police prédictive basée sur le lieu] était présente dans plus de 60 grandes villes et en croissance, mais en raison de organisation communautaire réussie, elle a été largement réduite et/ou remplacée par d'autres formes d'organisation basée sur les données. analyses », a-t-il déclaré. « En bref, le terme de police prédictive est devenu toxique et les services de police ont appris à renommer ce qu’ils faisaient avec les données. La police prédictive basée sur la personne a connu une baisse plus forte. Les deux principales villes qui ont investi dans sa création – Chicago et Los Angeles – ont renoncé à stratégies après de vives critiques de la communauté et des audits internes dévastateurs qui montrent que les tactiques n’ont pas fonctionné travail. Non seulement les listes prédictives étaient erronées, mais elles étaient également inefficaces.

Les mauvais outils pour le travail ?

Cependant, Rashida Richardson, directeur de la recherche politique à l'A.I. Now Institute a déclaré qu’il y avait trop d’opacité quant à l’utilisation de cette technologie. « Nous ne le savons toujours pas en raison du manque de transparence concernant l’acquisition de technologies par le gouvernement et de nombreux des failles dans les procédures de passation de marchés existantes qui peuvent protéger certains achats de technologies du contrôle public », dit-elle. Elle donne l’exemple d’une technologie qui pourrait être donnée gratuitement à un service de police ou achetée par un tiers. « Nous savons, grâce à des recherches comme les miennes et aux reportages des médias, que bon nombre des plus grands services de police des États-Unis ont utilisé le technologie à un moment donné, mais de nombreux petits services de police l'utilisent également ou l'ont utilisé pendant des périodes limitées. de temps."

Compte tenu des interrogations actuelles sur le rôle de la police, sera-t-il tenté de réintégrer la police prédictive comme outil de prise de décision basée sur les données – peut-être dans le cadre d’une science-fiction moins dystopique l'image de marque? Il est possible qu’une telle résurgence émerge. Mais Venkatasubramanian est très sceptique quant au fait que l’apprentissage automatique, tel qu’il est actuellement pratiqué, soit le bon outil pour ce travail.

« L’intégralité de l’apprentissage automatique et son succès dans la société moderne reposent sur le principe selon lequel, quelle que soit la situation réelle, problème, cela se résume en fin de compte à collecter des données, à créer un modèle, à prédire le résultat – et vous n’avez pas à vous soucier du domaine », il a dit. « Vous pouvez écrire le même code et l’appliquer à 100 endroits différents. C’est la promesse de l’abstraction et de la portabilité. Le problème est que lorsque nous utilisons ce que les gens appellent des systèmes socio-techniques, dans lesquels les humains et la technologie sont imbriqués dans des vagues complexes, cela n’est pas possible. Vous ne pouvez pas simplement brancher un élément et vous attendre à ce qu’il fonctionne. Parce que [il y a] des effets d'entraînement liés à l'insertion de cette pièce et au fait qu'il existe différents acteurs ayant des agendas différents dans un tel système, et ils subvertissent le système selon leurs propres besoins différentes façons. Tous ces éléments doivent être pris en compte lorsque l’on parle d’efficacité. Oui, on peut dire de manière abstraite que tout fonctionnera bien, mais là est pas de résumé. Il n’y a que le contexte dans lequel vous travaillez.