Stellen Sie sich ein Tablett vor. Auf dem Tablett liegen verschiedene Formen: Einige Würfel, andere Kugeln. Die Formen bestehen aus verschiedenen Materialien und repräsentieren unterschiedliche Größen. Insgesamt sind es vielleicht acht Objekte. Meine Frage: „Wenn man die Objekte betrachtet, gibt es gleich viele große Dinge und Metallkugeln?“

Inhalt

- Der Aufstieg und Fall der symbolischen KI.

- Die Welt der neuronalen Netze

- Brennende Ampeln

- Ergänzende Ideen

- K.I. Forschung: die nächste Generation

Es ist keine Fangfrage. Die Tatsache, dass es so klingt, ist ein Beweis dafür, wie einfach es tatsächlich ist. Es ist die Art von Frage, die ein Vorschulkind höchstwahrscheinlich leicht beantworten könnte. Für die heutigen hochmodernen neuronalen Netze ist dies jedoch nahezu unmöglich. Das muss sich ändern. Und das muss durch die Neuerfindung der künstlichen Intelligenz, wie wir sie kennen, geschehen.

Empfohlene Videos

Das ist nicht meine Meinung; Es ist die Meinung von David Cox, Direktor des MIT-IBM Watson A.I. Labor in Cambridge, MA. In einem früheren Leben war Cox Professor an der Harvard University, wo sein Team Erkenntnisse aus den Neurowissenschaften nutzte, um beim Aufbau besserer, vom Gehirn inspirierter Computersysteme für maschinelles Lernen zu helfen. In seiner aktuellen Rolle bei IBM betreut er eine einzigartige Partnerschaft zwischen MIT und IBM, die die KI vorantreibt. Forschung, einschließlich IBMs Watson A.I. Plattform. Für diejenigen, die es nicht wissen: Watson war die KI. das bekanntermaßen zwei der besten Gameshow-Spieler besiegte

in der Geschichte einer TV-Quizshow Gefahr. Watson ist außerdem ein vorwiegend maschinell lernendes System, das mithilfe von Datenmassen und nicht anhand von Menschen abgeleiteter Regeln trainiert wird.

Wenn Cox also sagt, dass die Welt die KI überdenken muss: Da es in ein neues Jahrzehnt geht, klingt es irgendwie seltsam. Schließlich waren die 2010er Jahre wohl das erfolgreichste Jahrzehnt in der KI-Branche. Geschichte: Eine Zeit, in der es scheinbar wöchentlich zu Durchbrüchen kommt, und es gibt keine frostigen Anzeichen dafür K.I. Winter Einblick. Genau aus diesem Grund glaubt er, dass K.I. muss sich allerdings ändern. Und sein Vorschlag für diese Änderung, ein derzeit unbekannter Begriff namens „neurosymbolische KI“, könnte bis zum Ende der 2020er Jahre durchaus zu einem dieser Ausdrücke werden, mit denen wir bestens vertraut sind.

Der Aufstieg und Fall der symbolischen KI.

Neurosymbolische K.I. ist streng genommen keine völlig neue Art der KI. Es ist eine Kombination aus zwei bestehenden Ansätzen zum Aufbau von Denkmaschinen; diejenigen, die einst als Todfeinde gegeneinander antraten.

Der „symbolische“ Teil des Namens bezieht sich auf den ersten Mainstream-Ansatz zur Schaffung künstlicher Intelligenz. Von den 1950er bis 1980er Jahren wurde symbolische K.I. unumstößlich regiert. Zu einer symbolischen K.I. Forscher: Intelligenz basiert auf der Fähigkeit des Menschen, die Welt um ihn herum zu verstehen, indem er interne symbolische Darstellungen bildet. Anschließend erstellen sie Regeln für den Umgang mit diesen Konzepten, und diese Regeln können so formalisiert werden, dass sie Alltagswissen erfassen.

Shakey the Robot: Der erste Roboter mit künstlicher Intelligenz

Wenn das Gehirn mit einem Computer vergleichbar ist, bedeutet dies, dass jede Situation, der wir begegnen, darauf angewiesen ist, dass wir eine Aufgabe ausführen Internes Computerprogramm, das Schritt für Schritt erklärt, wie eine Operation ausgeführt wird Logik. Vorausgesetzt, dass dies der Fall ist, kann die symbolische K.I. Forscher glauben, dass dieselben Regeln für die Die Organisation der Welt könnte entdeckt und dann in Form eines Algorithmus für einen Computer kodifiziert werden Ausführen.

Symbolische K.I. führte zu einigen ziemlich beeindruckenden Demonstrationen. Beispielsweise entwickelte der Informatiker Bertram Raphael 1964 ein System namens SIR, das für „Semantischer Informationsabruf.“ SIR war ein rechnergestütztes Argumentationssystem, das scheinbar in der Lage war, Beziehungen zwischen Objekten auf eine Weise zu lernen, die echter Intelligenz ähnelte. Wenn Sie zum Beispiel sagen würden: „John ist ein Junge; ein Junge ist eine Person; eine Person hat zwei Hände; „Eine Hand hat fünf Finger“, dann würde SIR die Frage „Wie viele Finger hat John?“ beantworten. mit der richtigen Zahl 10.

„...es gibt besorgniserregende Risse in der Wand, die langsam sichtbar werden.“

Computersysteme basierend auf symbolischer K.I. Den Höhepunkt ihrer Macht (und ihren Niedergang) erreichten sie in den 1980er Jahren. Dies war das Jahrzehnt des sogenannten „Expertensystems“, das versuchte, regelbasierte Systeme zur Lösung realer Probleme zu nutzen, wie z Unterstützung von Biochemikern bei der Identifizierung unbekannter organischer Moleküle oder Unterstützung von Ärzten bei der Empfehlung der richtigen Antibiotikadosis Infektionen.

Das Grundkonzept dieser Expertensysteme war solide. Aber sie hatten Probleme. Die Systeme waren teuer, mussten ständig aktualisiert werden und, was noch schlimmer war, konnten mit zunehmender Anzahl von Regeln sogar an Genauigkeit verlieren.

Die Welt der neuronalen Netze

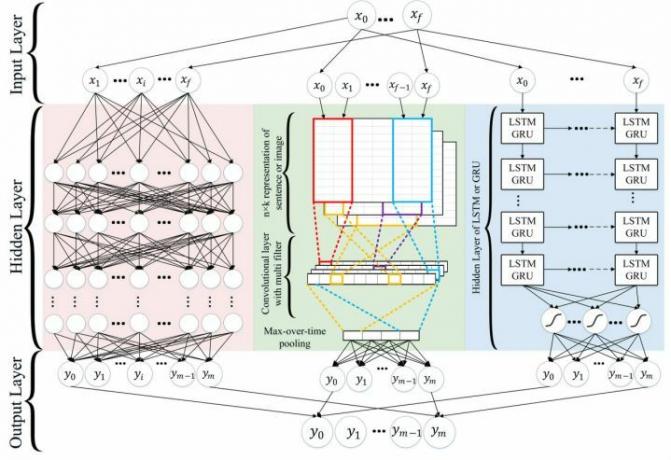

Der „Neuro“-Teil der neurosymbolischen KI. bezieht sich auf Deep-Learning-Neuronale Netze. Neuronale Netze sind die vom Gehirn inspirierte Art der Berechnung, die viele der KI-Entwicklungen vorangetrieben hat. Durchbrüche im letzten Jahrzehnt. K.I. das kann Autos fahren? Neuronale Netze. K.I. Welches kann Texte in Dutzende verschiedener Sprachen übersetzen? Neuronale Netze. K.I. Was hilft dem intelligenten Lautsprecher in Ihrem Zuhause, Ihre Stimme zu verstehen? Neuronale Netze sind die Technologie, die es zu verdanken hat.

Neuronale Netze funktionieren anders als symbolische KI. weil sie datengesteuert und nicht regelbasiert sind. Einer symbolischen KI etwas erklären System bedeutet, ihm explizit alle Informationen zur Verfügung zu stellen, die es für eine korrekte Identifizierung benötigt. Als Analogie stellen Sie sich vor, Sie schicken jemanden, der Ihre Mutter vom Busbahnhof abholt, müssen sie aber beschreiben, indem Sie eine Reihe von Regeln festlegen, die es Ihrem Freund ermöglichen, sie aus der Menge herauszuheben. Um ein neuronales Netzwerk darauf zu trainieren, zeigt man ihm einfach Tausende von Bildern des betreffenden Objekts. Sobald es intelligent genug ist, wird es nicht nur in der Lage sein, dieses Objekt zu erkennen; es kann seine eigenen ähnlichen Objekte erschaffen, die es haben hat in der realen Welt nie wirklich existiert.

„Deep Learning hat mit Sicherheit erstaunliche Fortschritte ermöglicht“, sagte David Cox gegenüber Digital Trends. „Gleichzeitig zeigen sich besorgniserregende Risse in der Wand.“

Einer dieser sogenannten Cracks basiert auf genau dem, was die heutigen neuronalen Netze so leistungsfähig gemacht hat: Daten. Genau wie ein Mensch lernt ein neuronales Netzwerk anhand von Beispielen. Aber während ein Mensch möglicherweise nur ein oder zwei Trainingsbeispiele eines Objekts sehen muss, um sich richtig daran zu erinnern, kann eine K.I. wird noch viel, viel mehr erfordern. Die Genauigkeit hängt von großen Mengen annotierter Daten ab, mit denen jede neue Aufgabe erlernt werden kann.

Brennende Ampeln

Das macht sie bei statistisch seltenen „Black Swan“-Problemen weniger gut. Ein Black-Swan-Event, populär gemacht durch Nassim Nicholas Talebist ein Eckfall, der statistisch selten vorkommt. „Viele unserer heutigen Deep-Learning-Lösungen – so erstaunlich sie auch sind – sind sozusagen 80-20-Lösungen“, fuhr Cox fort. „Sie werden 80 % der Fälle richtig machen, aber wenn diese Eckfälle wichtig sind, werden sie tendenziell scheitern.“ Wenn Sie ein Objekt sehen, das normalerweise nicht [an einen bestimmten Ort] gehört, oder ein Objekt in einer etwas seltsamen Ausrichtung, werden selbst erstaunliche Systeme zusammenbrechen.“

Vorstellung von Wahrnehmungsautomaten

Bevor er zu IBM kam, war Cox Mitbegründer eines Unternehmens, Wahrnehmungsautomaten, das Software für selbstfahrende Autos entwickelte. Das Team hatte einen Slack-Kanal, in dem es lustige Bilder postete, über die es im Zuge der Datenerfassung gestolpert war. Eines davon, aufgenommen an einer Kreuzung, zeigte eine brennende Ampel. „Es ist einer dieser Fälle, die man vielleicht nie im Leben sieht“, sagte Cox. „Ich weiß nicht, ob Waymo und Tesla in den Datensätzen, die sie verwenden, Bilder von brennenden Ampeln haben Trainieren Sie ihre neuronalen Netze, aber ich wette … wenn sie welche haben, werden sie nur sehr wenige haben wenige."

Es ist eine Sache, dass ein Eckfall unbedeutend ist, weil er selten vorkommt und nicht so wichtig ist, wenn er passiert. Eine schlechte Restaurantempfehlung zu bekommen ist vielleicht nicht ideal, wird aber wahrscheinlich nicht ausreichen, um Ihnen den Tag zu verderben. Solange die bisherigen 99 Empfehlungen des Systems gut sind, gibt es keinen wirklichen Grund zur Frustration. Ein selbstfahrendes Auto, das an einer Kreuzung aufgrund einer brennenden Ampel oder einer Pferdekutsche nicht richtig reagiert, kann viel mehr als nur Ihren Tag ruinieren. Es ist zwar unwahrscheinlich, dass das passiert, aber wenn doch, wollen wir wissen, dass das System dafür ausgelegt ist, damit klarzukommen.

„Wenn man über die Fähigkeit verfügt, über das, was wir bisher gesehen haben, nachzudenken und zu extrapolieren, können wir mit diesen Szenarien umgehen“, erklärte Cox. „Wir wissen, dass Menschen das können. Wenn ich sehe, dass eine Ampel brennt, kann ich viel Wissen einbringen. Ich weiß zum Beispiel, dass mir das Licht nicht sagen wird, ob ich anhalten oder gehen soll. Ich weiß, dass ich vorsichtig sein muss, weil [die Fahrer um mich herum verwirrt sein werden.] Ich weiß, dass entgegenkommende Fahrer sich möglicherweise anders verhalten, weil ihr Licht möglicherweise funktioniert. Ich kann einen Aktionsplan ausarbeiten, der mich dorthin bringt, wo ich hin muss. In solchen sicherheits- und geschäftskritischen Umgebungen glaube ich nicht, dass Deep Learning uns noch gute Dienste leistet. Deshalb brauchen wir zusätzliche Lösungen.“

Ergänzende Ideen

Die Idee der neurosymbolischen K.I. besteht darin, diese Ansätze zusammenzuführen, um sowohl Lernen als auch Logik zu verbinden. Neuronale Netze werden dazu beitragen, symbolische KI zu schaffen. Machen Sie Systeme intelligenter, indem Sie die Welt in Symbole aufteilen, anstatt sich darauf zu verlassen, dass menschliche Programmierer dies für sie tun. Inzwischen symbolische K.I. Algorithmen werden dabei helfen, gesunden Menschenverstand und Domänenwissen in Deep Learning zu integrieren. Die Ergebnisse könnten zu erheblichen Fortschritten in der KI führen. Systeme, die komplexe Aufgaben bewältigen, von selbstfahrenden Autos bis hin zur Verarbeitung natürlicher Sprache. Und das alles, während für das Training viel weniger Daten benötigt werden.

Neurosymbolische KI erklärt

„Neuronale Netze und symbolische Ideen ergänzen sich wirklich wunderbar“, sagte Cox. „Denn neuronale Netze geben Ihnen die Antworten, um von der Unordnung der realen Welt zu einer symbolischen Darstellung der Welt zu gelangen und alle Zusammenhänge in Bildern zu finden. Sobald Sie diese symbolische Darstellung haben, können Sie in Bezug auf das Denken einige ziemlich magische Dinge tun.“

In dem Formbeispiel, mit dem ich diesen Artikel begonnen habe, würde beispielsweise ein neurosymbolisches System die Mustererkennungsfähigkeiten eines neuronalen Netzwerks nutzen, um Objekte zu identifizieren. Dann würde es sich auf symbolische KI verlassen. Logik und semantisches Denken anzuwenden, um neue Zusammenhänge aufzudecken. Solche Systeme haben hat sich bereits als effektiv erwiesen.

Es sind nicht nur Eckfälle, in denen dies nützlich wäre. Es wird immer wichtiger, dass K.I. Systeme sind bei Bedarf erklärbar. Ein neuronales Netzwerk kann bestimmte Aufgaben außergewöhnlich gut ausführen, aber viele seiner inneren Überlegungen sind „black boxed“ und für diejenigen, die wissen wollen, wie es seine Entscheidung getroffen hat, undurchschaubar. Auch dies spielt keine große Rolle, wenn es sich um einen Bot handelt, der den falschen Titel auf Spotify empfiehlt. Aber wenn Ihnen ein Bankkredit verweigert wurde, Ihre Bewerbung abgelehnt wurde oder jemand bei einem Unfall verletzt wurde Bei einem Vorfall mit einem autonomen Auto sollten Sie besser erklären können, warum bestimmte Empfehlungen ausgesprochen wurden gemacht. Hier kommt die neurosymbolische KI zum Einsatz. könnte reinkommen.

K.I. Forschung: die nächste Generation

Vor einigen Jahrzehnten waren die Welten der symbolischen K.I. und neuronale Netze waren im Widerspruch zueinander. Die renommierten Persönlichkeiten, die sich für diese Ansätze einsetzten, glaubten nicht nur, dass ihr Ansatz richtig war; Sie glaubten, dass dies bedeutete, dass der andere Ansatz falsch war. Sie lagen damit nicht unbedingt falsch. Im Wettbewerb um die Lösung der gleichen Probleme und mit begrenzten finanziellen Mitteln haben beide Schulen der K.I. schienen grundsätzlich gegensätzlich zu sein. Heute scheint es, als ob das Gegenteil der Fall sein könnte.

„Es ist wirklich faszinierend, die jüngere Generation zu sehen“, sagte Cox. „[Viele der Leute in meinem Team sind] relativ junge Leute: frisch, aufgeregt, erst kürzlich mit der Promotion abgeschlossen. Sie haben einfach nichts von dieser Geschichte. Es ist ihnen einfach egal [dass die beiden Ansätze gegeneinander ausgespielt werden] – und sich nicht darum zu kümmern ist wirklich wirkungsvoll, weil es einen öffnet und diese Vorurteile beseitigt. Sie erkunden gerne Kreuzungen … Sie wollen einfach etwas Cooles mit KI machen.“

Wenn alles nach Plan verläuft, werden wir alle von den Ergebnissen profitieren.

Empfehlungen der Redaktion

- Analoge KI? Es klingt verrückt, aber es könnte die Zukunft sein

- Lesen Sie die unheimlich schöne „synthetische Schrift“ einer KI. das denkt, es sei Gott

- Algorithmische Architektur: Sollten wir K.I. Entwerfen Sie Gebäude für uns?

- Sprach-Supermodel: Wie GPT-3 still und leise die KI einleitet Revolution

- Frauen mit Byte: Vivienne Mings Plan, „chaotische menschliche Probleme“ mit K.I. zu lösen