Det ständiga surret runt OpenAI: s ChatGPT vägrar att avta. Med Microsoft nu använder samma teknik för att driva sin helt nya Bing Chat, det är säkert att säga att ChatGPT kan fortsätta denna uppåtgående trend under ganska lång tid. Det är goda nyheter för OpenAI och Microsoft, men de är inte de enda två företagen att dra nytta av.

Enligt en ny rapport, försäljningen av Nvidias datacenter grafikkort kan vara på väg att skjuta i höjden. Med kommersialiseringen av ChatGPT kan OpenAI behöva så många som 10 000 nya grafikprocessorer för att stödja den växande modellen – och Nvidia verkar vara den mest troliga leverantören.

Forskningsföretag TrendForce delade några intressanta uppskattningar idag, och det mest intressanta gäller framtiden för ChatGPT. Enligt TrendForce kommer GPT-modellen som driver ChatGPT snart att behöva en betydande ökning av hårdvaran för att skala upp utvecklingen.

Rekommenderade videor

"Antalet träningsparametrar som används i utvecklingen av denna autoregressiva språkmodell ökade från cirka 120 miljoner 2018 till nästan 180 miljarder 2020", säger TrendForce i sin rapport. Även om det inte delade några uppskattningar för 2023, är det säkert att anta att dessa siffror bara kommer att fortsätta att öka så mycket som teknik och budget tillåter.

Företaget hävdar att GPT-modellen behövde hela 20 000 grafikkort för att bearbeta träningsdata 2020. När den fortsätter att expandera förväntas den siffran stiga till över 30 000. Detta kan vara goda nyheter för Nvidia.

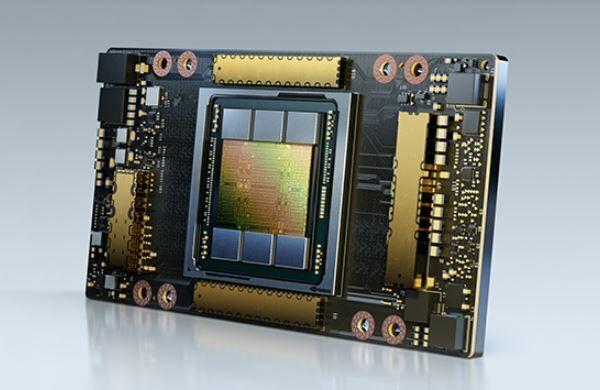

Dessa beräkningar är baserade på antagandet att OpenAI skulle använda Nvidias A100 GPU: er för att driva språkmodellen. Dessa extremt kraftfulla grafikkort är riktigt dyra - i kulparken på $10 000 till $15 000 vardera. De är inte heller Nvidias bästa datacenterkort just nu, så det är möjligt att OpenAI skulle gå för de nyare H100-korten istället, som är tänkta att ge upp till tre gånger prestanda än A100. Dessa GPU: er kommer med en kraftig prishöjning, med ett kort som kostar runt $30 000 eller mer.

Datacenter GPU-marknaden består inte bara av Nvidia – Intel och AMD säljer också AI-acceleratorer. Dock, Nvidia ses ofta som den bästa lösningen för AI-relaterade uppgifter, så det är möjligt att det kanske kan få en lukrativ affär om och när OpenAI bestämmer sig för att skala upp.

Borde spelare vara oroliga om Nvidia verkligen levererar hela 10 000 GPU: er för att starta ChatGPT? Det beror på. Grafikkorten som krävs av OpenAI har ingenting att göra med Nvidias bästa GPU: er för spelare, så vi är säkra där. Men om Nvidia slutar flytta en del produktion till datacenter GPU: er kan vi se ett begränsat utbud av konsumenter

Redaktörens rekommendationer

- Toppförfattare kräver betalning från AI-företag för att de använder deras arbete

- GPT-4: hur man använder AI-chatboten som gör ChatGPT på skam

- Wix använder ChatGPT för att hjälpa dig att snabbt bygga en hel webbplats

- ChatGPT-tillverkaren OpenAI står inför FTC-utredning över konsumentskyddslagar

- ChatGPTs webbplatstrafik har minskat för första gången

Uppgradera din livsstilDigitala trender hjälper läsare att hålla koll på den snabba teknikvärlden med alla de senaste nyheterna, roliga produktrecensioner, insiktsfulla redaktioner och unika smygtittar.