Od serii Grand Theft Auto po mnóstwo dostępnych Tytuły Spider-Mana, wiele gier wideo pozwala odkrywać trójwymiarową reprezentację prawdziwego (lub słabo fabularyzowanego) miasta. Tworzenie takich pejzaży miejskich nie jest jednak łatwe. Zadanie wymaga tysięcy godzin modelowania komputerowego i dokładnych badań referencyjnych, zanim gracze będą mieli szansę chodzić, jeździć lub latać po ukończonym wirtualnym świecie.

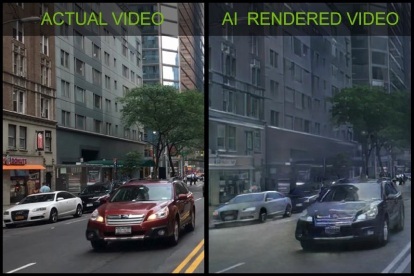

Imponujące nowe demo technologiczne od Nvidii pokazuje jednak, że istnieje inny sposób. Zaprezentowana na konferencji poświęconej sztucznej inteligencji NeurIPS w Montrealu firma technologiczna pokazała, w jaki sposób technologia uczenia maszynowego może wygenerować przekonujące wirtualne miasto, po prostu ją pokazując kamera samochodowa filmy. Te filmy zostały nagrane z samochodów autonomicznych podczas tygodniowej jazdy próbnej po miastach. Proces uczenia sieci neuronowej trwał około tygodnia przy użyciu procesorów graficznych Tesla V100 firmy Nvidia w systemie superkomputerowym DGX-1. Kiedy A.I. dowiedział się, na co patrzy i zorientował się, jak podzielić to na obiekty oznaczone kolorami, wirtualne miasta zostały wygenerowane przy użyciu silnika Unreal Engine 4.

Polecane filmy

„Jedną z głównych przeszkód, przed którymi stoją programiści, jest to, że tworzenie treści dla wirtualnych światów jest drogie” Bryana Catanzaro, wiceprezes ds. badań stosowanych głębokiego uczenia się w firmie Nvidia, powiedział Digital Trends. „Stworzenie interaktywnego świata dla gier lub aplikacji VR może zająć dziesiątki miesięcy artystom. Stworzyliśmy nowy sposób renderowania treści przy użyciu głębokiego uczenia się — przy użyciu sztucznej inteligencji. która uczy się od prawdziwego świata, co mogłoby pomóc artystom i programistom w tworzeniu środowisk wirtualnych przy znacznie niższych kosztach”.

Badania w firmie NVIDIA: pierwszy interaktywny wirtualny świat renderowany przez sztuczną inteligencję

Catanzaro powiedział, że istnieje niezliczona ilość potencjalnych zastosowań tej technologii w świecie rzeczywistym. Mogłaby na przykład umożliwić użytkownikom dostosowywanie awatarów w grach poprzez nakręcenie krótkiego filmu telefonem komórkowym i przesłanie go. Można to również wykorzystać do tworzenia zabawnych filmów, w których cechy użytkownika są odwzorowywane na ruchy innego ciała. (Jak widać na powyższym filmie, Nvidia dobrze się bawiła, zmuszając jednego ze swoich programistów do wykonania styl Gangnam taniec.)

„Architekci mogliby [dodatkowo] używać go do renderowania wirtualnych projektów dla swoich klientów” – kontynuował Catanzaro. „Można zastosować tę technikę do szkolenia robotów lub samochodów autonomicznych w środowiskach wirtualnych. We wszystkich tych przypadkach obniżyłoby to koszty i czas potrzebny na tworzenie wirtualnych światów.

Dodał, że są to wciąż wczesne badania i zajmie to „kilka lat”, zanim zostaną opracowane i wprowadzone do zastosowań komercyjnych. „Jestem jednak podekscytowany, że może to zasadniczo zmienić sposób tworzenia grafiki komputerowej” – powiedział Catanzaro.

Zalecenia redaktorów

- Superkomputer Nvidii może rozpocząć nową erę ChatGPT

- Nowy głos Nvidii A.I. brzmi jak prawdziwa osoba

- Sztuczna inteligencja IBM Statek Mayflower przepływa przez Atlantyk i można go oglądać na żywo

- Naukowcy wykorzystują sztuczną inteligencję do stworzenia sztucznego ludzkiego kodu genetycznego

- Inteligentna nowa sztuczna inteligencja system obiecuje wyszkolić Twojego psa, gdy będziesz poza domem

Ulepsz swój styl życiaDigital Trends pomaga czytelnikom śledzić szybko rozwijający się świat technologii dzięki najnowszym wiadomościom, zabawnym recenzjom produktów, wnikliwym artykułom redakcyjnym i jedynym w swoim rodzaju zajawkom.