有名なテレビ番組のタイトルを少し変更すると、子供たちは最もひどいことをします。 最近、ドイツとイギリスの研究者が研究を実施しました。 雑誌に掲載されました サイエンスロボティクス、これは、子供たちがロボットの仲間からの圧力にどの程度影響されやすいかを示しました。 TLDR バージョン: 親の古い質問に対する答え: 「友達全員が崖から飛び降りるように言ったら、あなたはそうしますか?」 「確かに。」かもしれません。 もし友達がみんなロボットだったら。」

コンテンツ

- 大人は本当に賢いのでしょうか?

- どの船にも難破船がある

このテストは、ポーランドの心理学者ソロモン・アシュが先駆的に行った1951年の有名な実験を再現したものである。 この実験は、人々が正しいとわかっている情報に反する場合でも、集団思考の圧力にどのように影響されるかを実証しました。 アッシュの実験では、大学生のグループが集められ、2 枚のカードが示されました。 左側のカードには、1 本の縦線の画像が表示されていました。 右側のカードには、さまざまな長さの 3 本の線が表示されています。 次に実験者は、右のカードのどの線が左のカードに示されている線の長さと一致するかを参加者に尋ねました。

おすすめ動画

「この年齢層の子供たちの特別な点は、彼らがまだ不信感を抱く年齢にあるということです。」

ここまではとても簡単です。 しかし、事態がより邪悪になったのは、グループの構成でした。 グループのうち純粋な参加者は 1 人だけで、他の人は全員が事前に話す内容を指示されていた俳優でした。 この実験は、グループの残りの参加者が全員一致で間違った答えをしたときに、本当の参加者がそれに同調するかどうかをテストすることでした。 結局のところ、ほとんどの人がそうするでしょう。 同調圧力とは、多数派の意見に従うことを意味する場合、明らかに正しい情報を大多数の人が否定することを意味します。

関連している

- 進化し自己複製するロボットが登場していますが、反乱の心配はありません

- ロボットはあなたの仕事を奪いに来るわけではありません。 彼らはそれを改善しに来ています

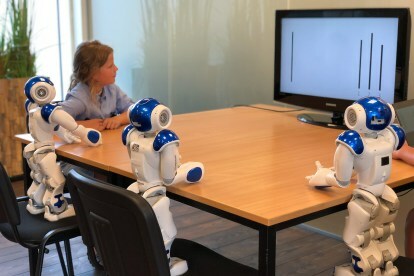

2018年の実験のリミックスでは、同じ原理が使用された。ただ、「本当の参加者」は大学生の年齢の仲間のグループではなく、7歳から9歳の子供だった。 「俳優」は、間違った答えを返すようにプログラムされた 3 台のロボットによって演じられました。 43人のボランティアのサンプルでは、74パーセントの子供たちがロボットと同じ不正解を答えた。 この結果は、この年齢の子供たちのほとんどがロボットからのプレッシャーを、生身の仲間からの仲間からのプレッシャーと同じように扱うことを示唆しています。

「この年齢層の子供たちの特別な点は、彼らがまだ不信感を抱く年齢にあるということです。」 トニー・ベルパエム, 研究の実施に協力したインテリジェントおよび自律制御システムの教授はDigital Trendsに語った。 「彼らはおもちゃで遊びますが、それでもアクションフィギュアや人形が本物であると信じています。 彼らはまだ人形劇を見て、何が起こっているのかを本当に信じます。 彼らはまだ[サンタクロース]を信じているかもしれません。 それは彼らがロボットを見るときも同じで、彼らは電子機器やプラスチックではなく、むしろ社会的な性格を見ているのです。」

興味深いことに、この実験ではこれを大人からの反応と比較しました。 子供たちとは異なり、大人はロボットのエラーに動揺しませんでした。 「ロボットが間違った答えをするのを見た大人は、怪訝な表情を浮かべた後、正しい答えを返しました」とベルパエム氏は続けた。

それで、何も心配することはありませんか? 悪い反応をするようにプログラムされたロボットに子供たちが手を出さないようにすれば、すべてうまくいくはずですよね? そんなに急いではいけません。

大人は本当に賢いのでしょうか?

Belpaeme 氏が認めたように、このタスクは非常にシンプルになるように設計されているため、答えが何であるかについて不確実性はありません。 現実の世界は違います。 機械に簡単に引き継がれる仕事の種類について考えてみると、これらは人間である私たちが常に完璧に実行できるわけではないタスクであることがよくあります。

このタスクは非常に単純になるように設計されているため、答えが何であるかについて不確実性はありません。

タスクは信じられないほど単純ですが、マシンは人間よりもはるかに速く実行できる可能性があります。 あるいは、コンピュータが私たちよりもはるかに大量のデータにアクセスできる、より複雑なタスクである可能性もあります。 現在の仕事の潜在的な影響にもよりますが、私たちの多くが機械の修正に不満を抱くのも不思議ではありません。

病院の看護師は、その規則を覆すことに満足するでしょうか? FDA承認のアルゴリズム バイタルサインを監視し、医療スタッフにアラートを送信することで、患者の健康に関する優先順位を付けるのに役立つものはどれでしょうか? それとも、特に複雑な道路状況に対処する場合、ドライバーは自動運転車から快適にハンドルを握ることができるでしょうか? それとも、パイロットが間違った決定が行われていると考えて自動操縦を無効にしたのでしょうか? これらすべての場合において、答えは「はい」であると考えたいと思います。 しかし、さまざまな理由から、それは現実ではないかもしれません。

ニコラス・カーは2014年の本の中でこのことについて書いています ガラスの檻: 自動化が私たちを導く場所. 彼の説明の仕方は、実際の自動化の事例に含まれるある種の曖昧さを強調しています。 カード上の行の長さよりもはるかに複雑ですが、マシンははるかに賢く、結果は潜在的により優れたものになります。 重要な。

「努力や関与の低下、主体性や自主性の低下、あるいはスキルの微妙な低下によるコストをどうやって測るのでしょうか? それはできません」と彼は書いている。 「こうした影の形のないものは、なくなってしまうまで感謝することはめったにありませんし、たとえその損失を具体的な言葉で表現するのが難しいかもしれません。」

「こうした影の形のないものは、なくなってからでないと感謝することがほとんどありません。」

Belpaeme 氏が研究論文で理論化している種類のソーシャル ロボットはまだ主流ではありませんが、すでにこれらの難問のいくつかが実際に動作している例が示されています。 たとえば、カーは著書の冒頭で、自動操縦がもたらすリスクを理由にパイロットが自動操縦での飛行に費やす時間をいかに減らすべきかを記した連邦航空局のメモについて言及している。 これは墜落データの分析に基づいており、パイロットがコンピューター化されたシステムに過度に依存していることが多いことを示しています。

同様の訴訟には、ローレン・ローゼンバーグという女性が訴訟を起こした2009年の訴訟も含まれていた。 Googleに対して訴訟を起こした 危険な交通に向かうルートに沿って歩くようにアドバイスされた後。 この訴訟は法廷で棄却されましたが、この事件は、人々が機械知能の方が私たちよりも優れた知性を持っていると信じて、自分たちの常識を覆すであろうことを示しています。

どの船にも難破船がある

最終的には、Belpaeme 氏も認めているように、問題は、意思決定を機械に委ねたい場合があるということです。 ロボット 退屈で汚くて危険な仕事をすると約束する そして、すべての決定を考え直さなければならないとしたら、それらは実際には約束されている省力化デバイスではありません。 最終的にロボットを家に迎えることになるのであれば、ロボットが自律的に行動できるようにする必要があり、それには一定レベルの信頼が必要になります。

「ロボットがあなたに社会的圧力をかけるのは良いことかもしれません。 それは邪悪である必要はありません」とベルパエメ氏は続けた。 「医療や教育でロボットを使用している場合、ロボットが自分に影響を与えられるようにしたいと考えます。 たとえば、体重を減らしたい場合は、減量ロボットを 2 か月間与えられます。 モニター カロリー摂取量を測定し、より多くの運動を奨励します。 そのようなロボットには説得力があり、自分に影響を与えることが必要です。 しかし、善のために使用できるテクノロジーは悪にも使用される可能性があります。」

これに対する答えは何でしょうか? このような質問については、ケースバイケースで議論されます。 最終的に悪い部分が良い部分を上回る場合、ソーシャル ロボットのようなテクノロジーは決して普及しません。 しかし、ロボットによって引き起こされる仲間からの圧力に関する研究のような研究から正しい教訓を得ることが重要です。 そして、私たちが子供よりもはるかに賢いという事実はありません。

編集者のおすすめ

- オートメーションの未来: ロボットが登場しますが、ロボットがあなたの仕事を奪うことはありません

- これらのロボットはテーザーで雑草を枯らしてくれるので、農家は化学除草剤を必要としません。