Immagina un vassoio. Sul vassoio c'è un assortimento di forme: alcuni cubi, altri sfere. Le forme sono realizzate con una varietà di materiali diversi e rappresentano un assortimento di dimensioni. In totale ci sono forse otto oggetti. La mia domanda: “Guardando gli oggetti, ci sono un numero uguale di cose grandi e sfere di metallo?”

Contenuti

- L’ascesa e la caduta dell’I.A. simbolica

- Il mondo delle reti neurali

- Semafori in fiamme

- Idee complementari

- A.I. ricerca: la prossima generazione

Non è una domanda trabocchetto. Il fatto che sembri così è una prova positiva di quanto sia semplice in realtà. È il tipo di domanda a cui molto probabilmente un bambino in età prescolare potrebbe rispondere con facilità. Ma è quasi impossibile per le reti neurali all’avanguardia di oggi. Questo deve cambiare. E ciò deve avvenire reinventando l’intelligenza artificiale come la conosciamo.

Video consigliati

Questa non è la mia opinione; è l'opinione di David Cox, direttore del MIT-IBM Watson A.I. Laboratorio a Cambridge, MA. In una vita precedente, Cox era professore all’Università di Harvard, dove il suo team ha utilizzato le conoscenze delle neuroscienze per costruire sistemi informatici di apprendimento automatico migliori ispirati al cervello. Nel suo attuale ruolo in IBM, supervisiona una partnership unica tra MIT e IBM che sta facendo avanzare l'A.I. ricerca, tra cui Watson A.I. piattaforma. Watson, per chi non lo sapesse, era l'A.I. che notoriamente ha sconfitto due dei migliori giocatori del game show

nella storia al quiz televisivo Pericolo. Inoltre, Watson è un sistema principalmente di apprendimento automatico, addestrato utilizzando masse di dati anziché regole derivate dall’uomo.

Quindi, quando Cox dice che il mondo ha bisogno di ripensare l’A.I. mentre si avvia verso un nuovo decennio, sembra un po’ strano. Dopotutto, gli anni 2010 sono stati senza dubbio il decennio di maggior successo nell’A.I. storia: un periodo in cui le scoperte avvengono apparentemente settimanalmente e senza alcun gelido accenno di an A.I. inverno intuizione. Questo è esattamente il motivo per cui pensa che A.I. deve cambiare, però. E il suo suggerimento per quel cambiamento, un termine attualmente oscuro chiamato “AI neuro-simbolica”, potrebbe benissimo diventare una di quelle frasi che conosciamo intimamente quando gli anni ’20 giungeranno al termine.

L’ascesa e la caduta dell’I.A. simbolica

L’I.A. Neurosimbolica non è, in senso stretto, un modo totalmente nuovo di fare A.I. È una combinazione di due approcci esistenti alla costruzione di macchine pensanti; quelli che una volta erano contrapposti l'uno all'altro come nemici mortali.

La parte “simbolica” del nome si riferisce al primo approccio mainstream alla creazione dell’intelligenza artificiale. Dagli anni '50 agli anni '80, la simbolica A.I. regnava supremo. Ad una simbolica A.I. ricercatore, l’intelligenza si basa sulla capacità degli esseri umani di comprendere il mondo che li circonda formando rappresentazioni simboliche interne. Quindi creano regole per gestire questi concetti e queste regole possono essere formalizzate in modo da catturare la conoscenza quotidiana.

Shakey the Robot: il primo robot a incarnare l'intelligenza artificiale

Se il cervello è analogo a un computer, ciò significa che ogni situazione che incontriamo dipende dal nostro funzionamento programma informatico interno che spiega, passo dopo passo, come effettuare un'operazione, basandosi interamente su logica. A condizione che questo sia il caso, l’A.I. i ricercatori ritengono che quelle stesse regole riguardo al l’organizzazione del mondo potrebbe essere scoperta e poi codificata, sotto forma di algoritmo, per un computer portare fuori.

IA simbolica ha dato luogo ad alcune dimostrazioni piuttosto impressionanti. Ad esempio, nel 1964 l’informatico Bertram Raphael sviluppò un sistema chiamato SIR, che sta per “Recupero semantico delle informazioni.” Il SIR era un sistema di ragionamento computazionale apparentemente in grado di apprendere le relazioni tra gli oggetti in un modo che somigliava alla vera intelligenza. Se dovessi dirgli che, per esempio, “John è un ragazzo; un ragazzo è una persona; una persona ha due mani; una mano ha cinque dita", quindi il SIR risponderebbe alla domanda "Quante dita ha John?" con il numero 10 corretto.

"... ci sono delle crepe nel muro che iniziano a mostrare."

Sistemi informatici basati sull'I.A. simbolica raggiunsero l’apice del loro potere (e il loro declino) negli anni ’80. Questo fu il decennio del cosiddetto “sistema esperto” che tentò di utilizzare sistemi basati su regole per risolvere problemi del mondo reale, come ad esempio aiutare i chimici organici a identificare molecole organiche sconosciute o assistere i medici nel consigliare la giusta dose di antibiotici infezioni.

Il concetto alla base di questi sistemi esperti era solido. Ma avevano problemi. I sistemi erano costosi, richiedevano un aggiornamento costante e, peggio di tutto, potevano diventare meno accurati man mano che venivano incorporate nuove regole.

Il mondo delle reti neurali

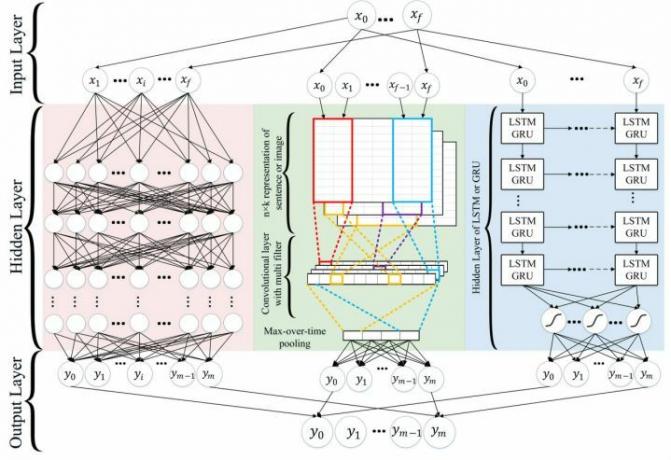

La parte “neuro” dell’A.I. neurosimbolica si riferisce a reti neurali di apprendimento profondo. Le reti neurali sono il tipo di calcolo ispirato al cervello che ha guidato molti dei progetti di intelligenza artificiale. scoperte osservate negli ultimi dieci anni. A.I. che può guidare le auto? Reti neurali. A.I. che può tradurre il testo in decine di lingue diverse? Reti neurali. A.I. che aiuta l'altoparlante intelligente di casa tua a capire la tua voce? Le reti neurali sono la tecnologia da ringraziare.

Le reti neurali funzionano in modo diverso dall'intelligenza artificiale simbolica. perché sono guidati dai dati, piuttosto che basati su regole. Per spiegare qualcosa ad una simbolica A.I. sistema significa fornirgli esplicitamente tutte le informazioni di cui ha bisogno per poter effettuare una corretta identificazione. Per analogia, immagina di mandare qualcuno a prendere tua madre alla stazione degli autobus, ma di doverla descrivere fornendo una serie di regole che permettano al tuo amico di distinguerla dalla massa. Per addestrare una rete neurale a farlo, le mostri semplicemente migliaia di immagini dell'oggetto in questione. Una volta che diventerà abbastanza intelligente, non solo sarà in grado di riconoscere quell'oggetto; può creare i propri oggetti simili che hanno non è mai realmente esistito nel mondo reale.

“Di sicuro, il deep learning ha consentito progressi sorprendenti”, ha dichiarato David Cox a Digital Trends. “Allo stesso tempo, ci sono preoccupanti crepe nel muro che iniziano a mostrare”.

Uno di questi cosiddetti crack si basa esattamente su ciò che ha reso le reti neurali di oggi così potenti: i dati. Proprio come un essere umano, una rete neurale apprende sulla base di esempi. Ma mentre a un essere umano potrebbe bastare vedere uno o due esempi di addestramento di un oggetto per ricordarlo correttamente, un’A.I. ne richiederanno molti, molti di più. La precisione dipende dalla disponibilità di grandi quantità di dati annotati con cui può apprendere ogni nuova attività.

Semafori in fiamme

Ciò li rende meno bravi a risolvere i problemi statisticamente rari del “cigno nero”. Un evento del cigno nero, reso popolare da Nassim Nicholas Taleb, è un caso limite statisticamente raro. "Molte delle nostre soluzioni di deep learning oggi, per quanto sorprendenti, sono soluzioni 80-20", ha continuato Cox. “Risolveranno l’80% dei casi, ma se i casi limite contano, tenderanno a fallire. Se vedi un oggetto che normalmente non appartiene [in un certo posto], o un oggetto con un orientamento leggermente strano, anche i sistemi sorprendenti cadranno”.

Presentazione degli automi percettivi

Prima di entrare in IBM, Cox ha co-fondato un'azienda, Automi percettivi, che ha sviluppato software per auto a guida autonoma. Il team aveva un canale Slack in cui pubblicava immagini divertenti in cui si era imbattuto durante la raccolta dei dati. Uno di essi, ripreso a un incrocio, mostrava un semaforo in fiamme. "È uno di quei casi che potresti non vedere mai nella tua vita", ha detto Cox. “Non so se Waymo e Tesla abbiano immagini di semafori in fiamme nei set di dati a cui sono abituati addestrare le loro reti neurali, ma sono disposto a scommettere... se ne hanno, ne avranno solo una molto pochi."

Una cosa è che un caso limite sia qualcosa di insignificante perché accade raramente e non ha molta importanza quando accade. Ricevere una pessima raccomandazione su un ristorante potrebbe non essere l'ideale, ma probabilmente non sarà sufficiente nemmeno a rovinarti la giornata. Finché le 99 raccomandazioni precedenti fornite dal sistema sono valide, non c’è motivo di frustrazione. Un’auto a guida autonoma che non risponde correttamente a un incrocio a causa di un semaforo acceso o di una carrozza trainata da cavalli potrebbe fare molto di più che rovinarti la giornata. Potrebbe essere improbabile che accada, ma se dovesse accadere, vogliamo sapere che il sistema è progettato per essere in grado di affrontarlo.

“Se si ha la capacità di ragionare ed estrapolare oltre ciò che abbiamo visto prima, possiamo affrontare questi scenari”, ha spiegato Cox. “Sappiamo che gli esseri umani possono farlo. Se vedo un semaforo in fiamme, posso portare con me molta conoscenza. So, ad esempio, che la luce non mi dirà se devo fermarmi o andare. So che devo stare attento perché [gli automobilisti intorno a me saranno confusi.] So che gli automobilisti che vengono nella direzione opposta potrebbero comportarsi in modo diverso perché la loro luce potrebbe funzionare. Posso ragionare su un piano d’azione che mi porterà dove devo andare. In questi tipi di contesti critici per la sicurezza e mission-critical, è da qualche parte che non penso che il deep learning ci stia ancora funzionando perfettamente. Ecco perché abbiamo bisogno di soluzioni aggiuntive”.

Idee complementari

L’idea dell’A.I. neurosimbolica è riunire questi approcci per combinare apprendimento e logica. Le reti neurali contribuiranno a rendere l’I.A. simbolica. sistemi più intelligenti suddividendo il mondo in simboli, invece di affidarsi a programmatori umani che lo facciano per loro. Nel frattempo, la simbolica A.I. gli algoritmi aiuteranno a incorporare il ragionamento basato sul buon senso e la conoscenza del dominio nel deep learning. I risultati potrebbero portare a progressi significativi nell’A.I. sistemi che affrontano compiti complessi, relativi a qualsiasi cosa, dalle auto a guida autonoma all’elaborazione del linguaggio naturale. E tutto questo richiedendo molti meno dati per la formazione.

Spiegazione dell'IA neurosimbolica

"Le reti neurali e le idee simboliche sono davvero meravigliosamente complementari tra loro", ha detto Cox. “Perché le reti neurali danno le risposte per passare dal disordine del mondo reale a una rappresentazione simbolica del mondo, trovando tutte le correlazioni all’interno delle immagini. Una volta ottenuta quella rappresentazione simbolica, puoi fare alcune cose piuttosto magiche in termini di ragionamento.

Ad esempio, nell’esempio della forma con cui ho iniziato questo articolo, un sistema neuro-simbolico utilizzerebbe le capacità di riconoscimento di schemi di una rete neurale per identificare gli oggetti. Quindi si affiderebbe all'I.A. simbolica. applicare la logica e il ragionamento semantico per scoprire nuove relazioni. Tali sistemi hanno è già stato dimostrato che funziona in modo efficace.

Non sono nemmeno solo i casi limite in cui ciò sarebbe utile. È sempre più importante che l’A.I. i sistemi sono spiegabili quando richiesto. Una rete neurale può svolgere determinati compiti eccezionalmente bene, ma gran parte del suo ragionamento interno è “scatola nera”, resa imperscrutabile a coloro che vogliono sapere come ha preso la sua decisione. Ancora una volta, questo non ha molta importanza se si tratta di un bot che consiglia la traccia sbagliata su Spotify. Ma se ti è stato negato un prestito bancario, una domanda di lavoro respinta o qualcuno è rimasto ferito in un incidente stradale incidente che coinvolge un'auto autonoma, faresti meglio a essere in grado di spiegare perché sono state adottate determinate raccomandazioni fatto. È lì che l’A.I. neurosimbolica potrebbe entrare.

A.I. ricerca: la prossima generazione

Alcuni decenni fa, i mondi simbolici dell’A.I. e le reti neurali erano in contrasto tra loro. Le figure rinomate che sostenevano questi approcci non solo credevano che il loro approccio fosse giusto; credevano che ciò significasse che l'altro approccio era sbagliato. Non erano necessariamente sbagliati nel farlo. Competendo per risolvere gli stessi problemi e con finanziamenti limitati a disposizione, entrambe le scuole di A.I. apparivano fondamentalmente opposti tra loro. Oggi sembra che potrebbe rivelarsi vero il contrario.

“È davvero affascinante vedere la generazione più giovane”, ha detto Cox. “[Molte persone nel mio team sono] persone relativamente giovani: fresche, emozionate, appena uscite dal dottorato. Semplicemente non hanno nulla di tutto ciò. A loro semplicemente non importa [del fatto che i due approcci vengano contrapposti l’uno contro l’altro] – e non preoccuparsene è davvero potente perché ti apre e ti sbarazza di quei pregiudizi. Sono felici di esplorare le intersezioni… Vogliono solo fare qualcosa di interessante con l’intelligenza artificiale”.

Se tutto andrà secondo i piani, tutti beneficeremo dei risultati.

Raccomandazioni degli editori

- IA analogica? Sembra pazzesco, ma potrebbe essere il futuro

- Leggi la "scrittura sintetica" stranamente bella di un A.I. che pensa che sia Dio

- Architettura algoritmica: dovremmo lasciare che l’A.I. progettare edifici per noi?

- Il top model del linguaggio: come GPT-3 sta silenziosamente inaugurando l'A.I. rivoluzione

- Donne con Byte: il piano di Vivienne Ming per risolvere i “problemi umani disordinati” con l’intelligenza artificiale