Pemolisian prediktif seharusnya mengubah cara pelaksanaan kepolisian, mengantarkan kita ke dunia hukum yang cerdas penegakan hukum yang bias dihilangkan dan polisi akan mampu merespons data tersebut, bukan sebaliknya firasat. Namun satu dekade setelah sebagian besar dari kita pertama kali mendengar istilah “kepolisian prediktif”, tampaknya jelas bahwa istilah tersebut tidak berhasil. Didorong oleh reaksi publik, penggunaan teknologi ini mengalami penurunan yang signifikan dibandingkan beberapa tahun yang lalu.

Isi

- Janji kebijakan prediktif

- Algoritma diskriminatif

- Bahaya data kotor

- Masa depan kepolisian prediktif yang tidak pasti

- Alat yang salah untuk pekerjaan itu?

Pada bulan April tahun ini, Los Angeles – yang menurut LA Times, “merintis prediksi kejahatan dengan data” – memotong dana untuk program kepolisian prediktif dan menyalahkan kerugian yang ditimbulkan. “Itu adalah keputusan yang sulit,” Kepala Polisi Michel Moore kata LA Times. “Itu adalah strategi yang kami gunakan, tetapi proyeksi biaya ratusan ribu dolar untuk dibelanjakan pada hal itu benar sekarang dibandingkan mencari uang itu dan mengarahkan uang itu ke kegiatan lain yang lebih penting adalah hal yang harus saya lakukan.”

Video yang Direkomendasikan

Apa yang salah? Bagaimana sesuatu yang diiklankan sebagai teknologi “pintar” bisa semakin memperparah bias dan diskriminasi? Dan apakah impian mengenai kepolisian prediktif dapat diubah dengan algoritma yang tepat – ataukah sebuah jalan buntu dalam masyarakat yang lebih adil yang saat ini sedang bergulat dengan bagaimana polisi harus beroperasi?

Janji kebijakan prediktif

Perpolisian prediktif dalam bentuknya yang sekarang sudah ada sejak sekitar satu dekade lalu, pada makalah tahun 2009 yang ditulis oleh psikolog Colleen McCue dan kepala polisi Los Angeles Charlie Beck, berjudul “Kebijakan Prediktif: Apa yang Dapat Kita Pelajari dari Walmart dan Amazon tentang Memerangi Kejahatan dalam Resesi?” Dalam makalah tersebut, mereka memanfaatkan big data yang digunakan oleh pengecer besar untuk membantu mengungkap pola perilaku pelanggan di masa lalu yang dapat digunakan untuk memprediksi perilaku di masa depan. Berkat kemajuan dalam komputasi dan pengumpulan data, McCue dan Beck menyarankan bahwa pengumpulan dan analisis data kejahatan dapat dilakukan secara real-time. Data ini kemudian dapat digunakan untuk mengantisipasi, mencegah, dan merespons kejahatan yang belum terjadi secara lebih efektif.

Bertahun-tahun setelahnya, kebijakan prediktif telah berubah dari ide yang hanya sekedar ide belaka menjadi kenyataan di banyak wilayah di Amerika Serikat, dan juga di seluruh dunia. Dalam prosesnya, mereka berupaya mengubah kepolisian dari kekuatan reaktif menjadi proaktif; memanfaatkan beberapa terobosan dalam teknologi berbasis data yang memungkinkan untuk menemukan pola secara real-time — dan menindaklanjutinya.

“Ada dua bentuk utama kebijakan prediktif,” Andrew Ferguson, profesor hukum di Universitas Distrik Columbia David A. Clarke School of Law dan penulis Bangkitnya Perpolisian Big Data: Pengawasan, Ras, dan Masa Depan Penegakan Hukum, kepada Digital Trends. “[Ini adalah] kebijakan prediktif berbasis tempat dan kebijakan prediktif berbasis orang.”

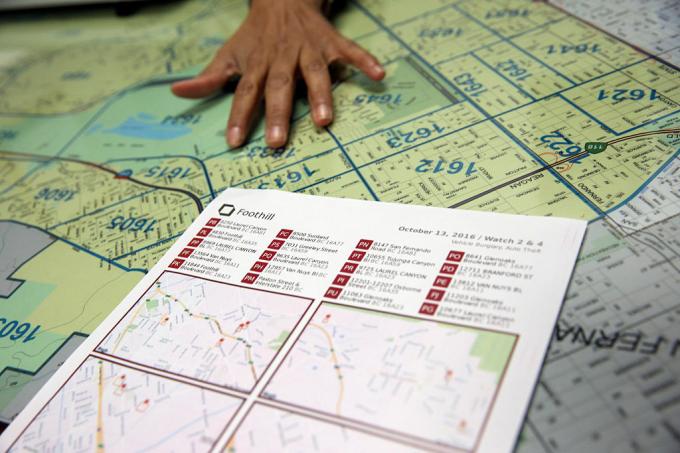

Dalam kedua kasus tersebut, sistem kepolisian prediktif memberikan skor risiko pada orang atau tempat yang bersangkutan, sehingga mendorong polisi untuk melakukan tindak lanjut pada interval tertentu. Pendekatan yang pertama, yaitu kebijakan prediktif berbasis tempat, terutama berfokus pada patroli polisi. Hal ini melibatkan penggunaan pemetaan kejahatan dan analisis tentang kemungkinan terjadinya kejahatan di masa depan, berdasarkan statistik sebelumnya.

Alih-alih membantu menghilangkan masalah-masalah seperti rasisme dan bias sistemik lainnya, kebijakan prediktif justru membantu memperdalam masalah tersebut.

Pendekatan kedua berfokus pada memprediksi kemungkinan bahwa seseorang mempunyai potensi risiko di masa depan. Misalnya, pada tahun 2013, seorang komandan Polisi Chicago dikirim ke rumah Robert McDaniel yang berusia 22 tahun, yang telah ditandai sebagai orang yang berpotensi menimbulkan risiko atau pelaku kekerasan bersenjata di pusat kota Chicago oleh seorang algoritma. “Daftar panas” yang disusun oleh algoritme mencari pola yang mungkin dapat memprediksi pelaku di masa depan atau korban, meskipun mereka sendiri tidak melakukan apa pun yang memerlukan pengawasan ini selain memenuhi a Profil.

Sebagai Chicago Tribune mencatat: “Strategi ini menyerukan peringatan kepada mereka yang masuk dalam daftar panas secara individu bahwa akan terjadi tindak kriminal lebih lanjut, bahkan untuk pelanggaran paling kecil sekalipun, akan mengakibatkan kekuatan hukum dibatalkan mereka."

Impian dari pemolisian prediktif adalah, dengan bertindak berdasarkan data yang dapat diukur, hal ini akan membuat kepolisian tidak hanya lebih efisien, namun juga mengurangi kecenderungan untuk menebak-nebak dan, sebagai akibatnya, bias. Hal ini, menurut para pendukungnya, akan mengubah kepolisian menjadi lebih baik, dan mengantarkan era baru kepolisian yang cerdas. Namun, sejak awal, kebijakan prediktif mendapat banyak kritik. Mereka berpendapat bahwa, alih-alih membantu menghilangkan masalah seperti rasisme dan bias sistemik lainnya, kebijakan prediktif justru malah membantu memperdalam masalah tersebut. Dan sulit untuk membantah bahwa mereka tidak ada benarnya.

Algoritma diskriminatif

Gagasan bahwa sistem kepolisian prediktif berbasis pembelajaran mesin dapat belajar melakukan diskriminasi berdasarkan faktor-faktor seperti ras bukanlah hal baru. Alat pembelajaran mesin dilatih dengan sejumlah besar data. Dan, selama data tersebut dikumpulkan oleh sistem yang menganggap ras masih menjadi faktor utama, hal ini dapat mengarah pada diskriminasi.

Sebagaimana Renata M. O'Donnell menulis dalam makalah tahun 2019 berjudul “Menantang Algoritma Pemolisian Prediktif Rasis Berdasarkan Klausul Perlindungan Setara,” algoritme pembelajaran mesin belajar dari data yang berasal dari sistem peradilan di mana “Orang Amerika kulit hitam dipenjara di penjara negara bagian dengan tingkat yang sama itu berarti 5,1 kali lipat hukuman penjara bagi orang kulit putih, dan satu dari setiap tiga pria kulit hitam yang lahir hari ini akan dipenjara seumur hidupnya jika tren saat ini melanjutkan."

“Data tidak objektif,” kata Ferguson kepada Digital Trends. “Hanya saja kita direduksi menjadi kode biner. Sistem berbasis data yang beroperasi di dunia nyata tidak lebih obyektif, adil, atau tidak memihak dibandingkan di dunia nyata. Jika dunia nyata Anda secara struktural tidak setara atau diskriminatif secara rasial, sistem berbasis data akan mencerminkan kesenjangan sosial tersebut. Masukan yang masuk dinodai oleh bias. Analisanya tercemar oleh bias. Dan mekanisme otoritas kepolisian tidak berubah hanya karena ada teknologi yang memandu sistem tersebut.”

Ferguson memberikan contoh penangkapan sebagai salah satu faktor yang tampaknya obyektif dalam memperkirakan risiko. Namun, penangkapan akan dipengaruhi oleh alokasi sumber daya polisi (seperti tempat mereka berpatroli) dan jenis kejahatan yang biasanya memerlukan penangkapan. Ini hanyalah salah satu ilustrasi data yang berpotensi bermasalah.

Bahaya data kotor

Data yang hilang dan salah terkadang disebut dalam penambangan data sebagai “data kotor.” A Makalah tahun 2019 oleh para peneliti dari A.I. Sekarang Institut di Universitas New York memperluas istilah ini untuk juga merujuk pada data yang dipengaruhi oleh korupsi, bias, dan melanggar hukum praktik — baik yang dimanipulasi dengan sengaja, yang diselewengkan oleh individu dan bias masyarakat. Misalnya, data tersebut dapat mencakup data yang diperoleh dari penangkapan orang yang tidak bersalah yang telah diberi bukti atau yang dituduh secara tidak benar.

Ada ironi tertentu dalam kenyataan bahwa, selama beberapa dekade terakhir, tuntutan masyarakat data semakin meningkat semuanya tentang kuantifikasi dan target numerik, telah menghasilkan banyak… yah, sungguh data yang buruk. Seri HBO Kawat memamerkan fenomena dunia nyata “mengolok-olok statistik”, dan tahun-tahun sejak pertunjukan tersebut tidak ditayangkan telah menawarkan banyak hal contoh manipulasi data sistemik yang sebenarnya, laporan polisi palsu, dan praktik inkonstitusional yang telah mengirim orang-orang yang tidak bersalah penjara.

Data buruk yang memungkinkan orang yang berkuasa mencapai target secara artifisial adalah satu hal. Namun jika digabungkan dengan algoritme dan model prediktif yang menggunakan ini sebagai dasar untuk memodelkan dunia, Anda berpotensi mendapatkan sesuatu yang jauh lebih buruk.

Para peneliti telah menunjukkan bagaimana data kejahatan yang meragukan yang dimasukkan ke dalam algoritma kepolisian prediktif dapat menciptakan apa yang disebut sebagai “putaran umpan balik yang tak terkendali,” yang mana polisi berulang kali dikirim ke lingkungan yang sama terlepas dari tingkat kejahatan sebenarnya. Salah satu rekan penulis makalah itu, ilmuwan komputer Suresh Venkatasubramanian, mengatakan bahwa model pembelajaran mesin dapat membangun asumsi yang salah melalui pemodelannya. Seperti pepatah lama yang menyatakan bahwa, bagi orang yang memegang palu, setiap masalah tampak seperti paku, sistem ini hanya memodelkan elemen tertentu dari suatu masalah — dan hanya membayangkan satu kemungkinan hasil.

“[Sesuatu yang] tidak dibahas dalam model ini adalah sejauh mana Anda memodelkan fakta bahwa memasukkan lebih banyak polisi ke suatu wilayah sebenarnya dapat menurunkan kualitas hidup orang-orang yang tinggal di sana?” Venkatasubramanian, seorang profesor di School of Computing di Universitas Utah, mengatakan kepada Digital Tren. “Kami berasumsi lebih banyak polisi adalah hal yang lebih baik. Namun seperti yang kita lihat saat ini, memiliki lebih banyak polisi belum tentu merupakan hal yang baik. Hal ini justru dapat memperburuk keadaan. Tidak ada satu pun model yang pernah saya lihat yang pernah menanyakan berapa biaya yang harus ditanggung jika menempatkan lebih banyak polisi di suatu wilayah.”

Masa depan kepolisian prediktif yang tidak pasti

Mereka yang bekerja di bidang kepolisian prediktif terkadang secara ironis menggunakan istilah “Laporan Minoritas” untuk merujuk pada jenis prediksi yang mereka lakukan. Istilah ini sering digunakan sebagai referensi ke Film tahun 2002 dengan judul yang sama, yang secara longgar didasarkan pada cerita pendek tahun 1956 karya Philip K. Kontol. Di dalam Laporan Minoritas, departemen kepolisian PreCrime khusus menangkap penjahat berdasarkan pengetahuan sebelumnya tentang kejahatan yang akan dilakukan di masa depan. Ramalan ini diberikan oleh tiga paranormal yang disebut “precogs”.

Tapi perubahannya Laporan Minoritas adalah bahwa prediksi tersebut tidak selalu akurat. Perbedaan visi yang dikemukakan oleh salah satu precog memberikan pandangan alternatif tentang masa depan, yang disembunyikan karena takut membuat sistem tampak tidak dapat dipercaya.

Audit internal menunjukkan bahwa taktik tersebut tidak berhasil. Daftar prediksi tersebut tidak hanya cacat, tetapi juga tidak efektif.

Saat ini, kebijakan prediktif menghadapi masa depan yang tidak pasti. Selain teknologi baru seperti pengenalan wajah, teknologi yang tersedia bagi penegak hukum untuk kemungkinan penggunaannya juga sangat canggih. Pada saat yang sama, kesadaran akan penggunaan kebijakan prediktif telah menimbulkan reaksi negatif dari masyarakat yang sebenarnya bisa membantu menghentikannya. Ferguson mengatakan kepada Digital Trends bahwa penggunaan alat kepolisian prediktif telah mengalami “penurunan” selama beberapa tahun terakhir.

“Pada puncaknya, [kepolisian prediktif berbasis tempat] ada di lebih dari 60 kota besar dan terus berkembang, namun sebagai akibat dari pengorganisasian masyarakat yang sukses, sebagian besar telah dikurangi dan atau diganti dengan bentuk-bentuk lain yang berbasis data analitik,” katanya. “Singkatnya, istilah kebijakan prediktif menjadi beracun, dan departemen kepolisian belajar mengganti nama apa yang mereka lakukan dengan data. Kebijakan prediktif berbasis masyarakat mengalami penurunan yang lebih tajam. Dua kota utama yang berinvestasi dalam pembangunannya – Chicago dan Los Angeles – mundur dari kota berbasis manusia strategi setelah kritik tajam dari masyarakat dan audit internal yang buruk yang menunjukkan bahwa taktik tersebut tidak berhasil bekerja. Daftar prediksi tersebut tidak hanya cacat, tetapi juga tidak efektif.”

Alat yang salah untuk pekerjaan itu?

Namun, Rashida Richardson, Direktur Riset Kebijakan di A.I. Now Institute mengatakan bahwa ada terlalu banyak ketidakjelasan mengenai penggunaan teknologi ini. “Kami masih belum tahu karena kurangnya transparansi mengenai akuisisi teknologi oleh pemerintah dan banyak lagi celah dalam prosedur pengadaan yang ada yang mungkin melindungi pembelian teknologi tertentu dari pengawasan publik,” dia berkata. Ia mencontohkan teknologi yang mungkin diberikan kepada kepolisian secara gratis atau dibeli oleh pihak ketiga. “Kami mengetahui dari penelitian seperti yang saya lakukan dan pemberitaan media bahwa banyak departemen kepolisian terbesar di AS telah menggunakan ini teknologi di beberapa titik, namun ada juga banyak departemen kepolisian kecil yang menggunakannya, atau telah menggunakannya untuk jangka waktu terbatas waktu.”

Mengingat pertanyaan yang ada saat ini mengenai peran polisi, apakah akan ada godaan untuk kembali menerima hal tersebut kepolisian prediktif sebagai alat untuk pengambilan keputusan berdasarkan data — mungkin dalam konteks fiksi ilmiah yang tidak terlalu distopia merek? Ada kemungkinan kebangkitan seperti itu bisa terjadi. Namun Venkatasubramanian sangat skeptis bahwa pembelajaran mesin, seperti yang dipraktikkan saat ini, adalah alat yang tepat untuk pekerjaan tersebut.

“Keseluruhan pembelajaran mesin dan keberhasilannya dalam masyarakat modern didasarkan pada premis bahwa, apa pun kenyataannya masalah, pada akhirnya intinya adalah mengumpulkan data, membangun model, memprediksi hasil — dan Anda tidak perlu mengkhawatirkan domainnya,” dia berkata. “Anda dapat menulis kode yang sama dan menerapkannya di 100 tempat berbeda. Itulah janji abstraksi dan portabilitas. Masalahnya adalah ketika kita menggunakan apa yang disebut sistem sosio-teknis, di mana manusia dan teknologi saling terkait dalam gelombang yang rumit, kita tidak bisa melakukan hal ini. Anda tidak bisa hanya menyambungkan satu bagian dan mengharapkannya berfungsi. Karena [ada] efek riak dengan memasukkan potongan itu dan faktanya ada yang berbeda pemain dengan agenda berbeda dalam sistem seperti itu, dan mereka menumbangkan sistem demi kebutuhan mereka sendiri cara yang berbeda. Semua hal ini harus diperhitungkan ketika Anda berbicara tentang efektivitas. Ya, Anda dapat mengatakan secara abstrak bahwa semuanya akan berfungsi dengan baik, tetapi di sana adalah tidak ada abstrak. Yang ada hanyalah konteks tempat Anda bekerja.”