Pour modifier légèrement le titre d'une émission télévisée bien connue: les enfants font les choses les plus dingues. Récemment, des chercheurs d'Allemagne et du Royaume-Uni ont mené une étude, publié dans la revue Robotique scientifique, qui a démontré à quel point les enfants sont sensibles à la pression des robots. Version TLDR: la réponse à cette vieille question parentale: « Si tous vos amis vous disaient de sauter d'une falaise, le feriez-vous? » pourrait bien être « Bien sûr. Si tous mes amis étaient des robots.

Contenu

- Les adultes sont-ils vraiment tellement plus intelligents ?

- Pour chaque navire il y a une épave

Le test reconstituait une célèbre expérience de 1951 lancée par le psychologue polonais Solomon Asch. L’expérience a démontré comment les gens peuvent être influencés par les pressions de la pensée de groupe, même lorsque cela va à l’encontre d’informations qu’ils savent exactes. Dans les expériences d’Asch, un groupe d’étudiants a été rassemblé et a montré deux cartes. La carte de gauche affichait l’image d’une seule ligne verticale. La carte de droite affichait trois lignes de longueurs variables. L'expérimentateur a ensuite demandé aux participants quelle ligne sur la carte de droite correspondait à la longueur de la ligne indiquée sur la carte de gauche.

Vidéos recommandées

"La particularité de cette tranche d'âge d'enfants est qu'ils sont encore à un âge où ils suspendent leur incrédulité."

Jusqu’ici, c’est si simple. Mais là où les choses sont devenues plus sournoises, c'est dans la composition du groupe. Une seule personne du groupe était un véritable participant, tandis que les autres étaient tous des acteurs à qui on avait dit à l'avance quoi dire. L'expérience visait à tester si le vrai participant suivrait le reste du groupe lorsqu'il donnerait à l'unanimité la mauvaise réponse. Il s’est avéré que la plupart le feraient. La pression des pairs signifie que la majorité des gens nieront une information clairement correcte si cela implique de se conformer à l’opinion majoritaire.

En rapport

- Les robots évolutifs et auto-réplicatifs sont là – mais ne vous inquiétez pas d'un soulèvement

- Les robots ne viennent pas vous voler votre travail. Ils viennent l'améliorer

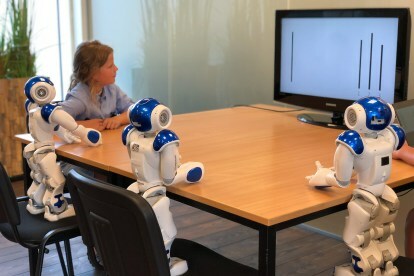

Dans le remix de l'expérience de 2018, le même principe a été utilisé: seulement au lieu d'un groupe de pairs d'âge universitaire, le « vrai participant » était un enfant âgé de sept à neuf ans. Les « acteurs » étaient joués par trois robots, programmés pour donner la mauvaise réponse. Sur un échantillon de 43 volontaires, 74 % des enfants ont donné la même réponse incorrecte que les robots. Les résultats suggèrent que la plupart des enfants de cet âge traiteront la pression des robots de la même manière que la pression de leurs pairs en chair et en os.

« La particularité de cette tranche d’âge d’enfants, c’est qu’ils sont encore à un âge où ils suspendent leur incrédulité » Tony Belpaème, professeur en systèmes de contrôle intelligents et autonomes, qui a contribué à la réalisation de l'étude, a déclaré à Digital Trends. « Ils joueront avec des jouets et continueront de croire que leurs figurines ou poupées sont réelles; ils continueront à regarder un spectacle de marionnettes et croiront vraiment à ce qui se passe; ils croient peut-être encore au [Père Noël]. C’est la même chose quand ils regardent un robot: ils n’y voient pas d’électronique et de plastique, mais plutôt un personnage social. »

Il est intéressant de noter que l’expérience a comparé cela avec la réponse des adultes. Contrairement aux enfants, les adultes ne se sont pas laissés influencer par les erreurs des robots. "Quand un adulte voyait le robot donner la mauvaise réponse, il lui lançait un regard perplexe puis donnait la bonne réponse", a poursuivi Belpaeme.

Alors il n'y a pas de quoi s'inquiéter? Tant que nous empêchons les enfants de mettre la main sur des robots programmés pour donner de mauvaises réponses, tout devrait bien se passer, non? Ne soyez pas si rapide.

Les adultes sont-ils vraiment tellement plus intelligents ?

Comme Belpaeme l'a reconnu, cette tâche était conçue pour être si simple qu'il n'y avait aucune incertitude quant à la réponse possible. Le monde réel est différent. Lorsque nous pensons aux types de tâches facilement confiées aux machines, il s’agit souvent de tâches que nous ne sommes pas toujours en mesure, en tant qu’humains, d’accomplir parfaitement.

Cette tâche a été conçue pour être si simple qu’il n’y avait aucune incertitude quant à la réponse possible.

Il se pourrait que la tâche soit incroyablement simple, mais que la machine puisse l’accomplir beaucoup plus rapidement que nous. Ou encore, il peut s’agir d’une tâche plus complexe, dans laquelle l’ordinateur a accès à des quantités de données bien plus importantes que nous. En fonction de l'impact potentiel du travail à accomplir, il n'est pas surprenant que beaucoup d'entre nous soient mécontents de corriger une machine.

Une infirmière dans un hôpital serait-elle heureuse d'annuler la Algorithme approuvé par la FDA qui peut aider à établir des priorités concernant la santé des patients en surveillant les signes vitaux, puis en envoyant des alertes au personnel médical? Ou un conducteur serait-il à l’aise de prendre le volant d’une voiture sans conducteur face à un scénario routier particulièrement complexe? Ou même un pilote annulant le pilote automatique parce qu’il pense que la mauvaise décision est prise? Dans tous ces cas, nous aimerions penser que la réponse est « oui ». Mais pour toutes sortes de raisons, cela n’est peut-être pas la réalité.

Nicholas Carr écrit à ce sujet dans son livre de 2014 La cage de verre: où l'automatisation nous mène. La façon dont il le décrit souligne le genre d'ambiguïté qu'impliquent les cas réels d'automatisation, où les problèmes sont bien plus complexe que la longueur d'une ligne sur une carte, les machines sont bien plus intelligentes et le résultat est potentiellement plus crucial.

« Comment mesurez-vous le coût d’une érosion de l’effort et de l’engagement, ou d’un déclin de l’action et de l’autonomie, ou d’une subtile détérioration des compétences? Vous ne pouvez pas », écrit-il. « C’est le genre de choses obscures et intangibles que nous apprécions rarement jusqu’à leur disparition, et même dans ce cas, nous pouvons avoir du mal à exprimer les pertes en termes concrets. »

"C'est le genre de choses sombres et intangibles que nous apprécions rarement jusqu'à leur disparition."

Les robots sociaux du type de ceux sur lesquels Belpaeme théorise dans le document de recherche ne sont pas encore courants, mais il existe déjà des illustrations de certaines de ces énigmes en action. Par exemple, Carr ouvre son livre en mentionnant une note de la Federal Aviation Administration qui souligne que les pilotes devraient passer moins de temps à voler en pilote automatique en raison des risques que cela représente. Ceci était basé sur l’analyse des données d’accidents, montrant que les pilotes s’appuient souvent trop sur les systèmes informatisés.

Une affaire similaire impliquait un procès en 2009 dans lequel une femme nommée Lauren Rosenberg a porté plainte contre Google après avoir été invité à marcher le long d'un itinéraire menant à une circulation dangereuse. Bien que l’affaire ait été rejetée par les tribunaux, elle montre que les gens vont outrepasser leur bon sens en pensant que l’intelligence artificielle est plus intelligente que la nôtre.

Pour chaque navire il y a une épave

En fin de compte, comme le reconnaît Belpaeme, le problème est que nous souhaitons parfois confier la prise de décision aux machines. Robots promettre de faire des travaux ennuyeux, sales et dangereux – et si nous devons remettre en question chaque décision, ce ne sont pas vraiment les dispositifs permettant d’économiser du travail qui ont été promis. Si nous voulons à terme inviter des robots chez nous, nous voudrons qu’ils soient capables d’agir de manière autonome, et cela impliquera un certain niveau de confiance.

« Les robots qui exercent une pression sociale sur vous peuvent être une bonne chose; il n’est pas nécessaire que ce soit sinistre », a poursuivi Belpaeme. « Si vous utilisez des robots dans le domaine de la santé ou de l’éducation, vous voulez qu’ils puissent vous influencer. Par exemple, si vous souhaitez perdre du poids, vous pourriez recevoir un robot amaigrissant pendant deux mois. moniteurs votre apport calorique et vous encourage à faire plus d'exercice. Vous voulez qu’un robot comme celui-là soit persuasif et vous influence. Mais toute technologie qui peut être utilisée pour le bien peut aussi être utilisée pour le mal.

Quelle est la réponse à cela? Des questions comme celle-ci seront débattues au cas par cas. Si le mal l’emporte finalement sur le bien, les technologies telles que les robots sociaux ne décolleront jamais. Mais il est important que nous tirions les bonnes leçons d’études comme celle sur la pression des pairs induite par les robots. Et ce n’est pas le fait que nous soyons tellement plus intelligents que les enfants.

Recommandations des rédacteurs

- L’avenir de l’automatisation: les robots arrivent, mais ils ne prendront pas votre travail

- Ces robots tuent les mauvaises herbes pour que les agriculteurs n'aient pas besoin d'herbicides chimiques