Google Glass llevó las gafas inteligentes del ámbito de los académicos con cola de caballo y los soñadores de Silicon Valley a la realidad generalizada. Tiene decenas de aplicaciones. Tiene nuevos diseños de Oakley y Ray Ban. Tiene fans que incluyen ambos. modelos de pista y jugadores de baloncesto.

Y si estás en una habitación ruidosa, es casi tan inútil como geek. Porque hablar con tus dispositivos no es tan fluido como David Hasselhoff lo hizo parecer en Jinete caballero.

Vídeos recomendados

Claro, puedes gritar "Glass, toma una foto" en la comodidad de tu sala de estar y tomarle una foto al Sr. Meowsers sin dejar el té. Pero intentar lo mismo en un bar bullicioso es una forma segura de molestar a la gente que te rodea y tal vez conseguir una paliza. Mientras tanto, el panel táctil de Glass maneja sólo unas pocas funciones básicas.

La rápida evolución de la tecnología de gafas inteligentes también podría ayudar a dar un impulso al paso bastante letárgico de ARI.

"El teléfono inteligente se está incorporando a su visión y es necesario que haya una nueva interfaz para evolucionar con el nuevo hardware", dice el cofundador Ryan Fink. "Ahí es donde entra en juego las IRA".

ARI, abreviatura de Interfaz de Realidad Aumentada, no requiere botones, paneles táctiles ni hablar. "ARI es el Siri del reconocimiento de gestos para gafas inteligentes", explica Fink.

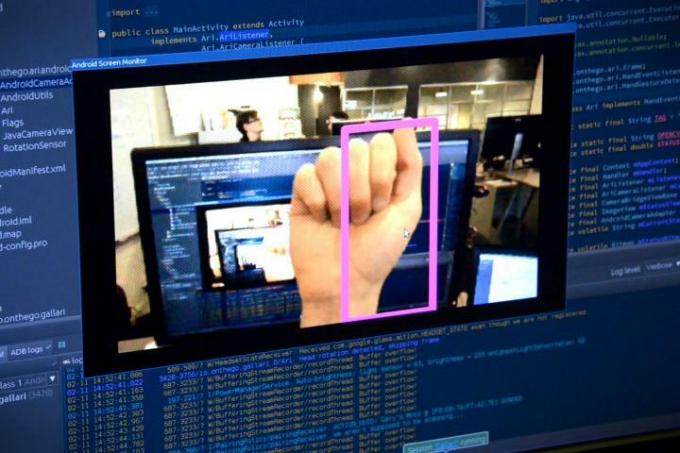

Levante el puño frente a su cara (como un boxeador antiguo que busca pelea) y aparecerá un cuadro superpuesto sobre él en Google Glass. Después de reconocerlo como un comando, ARI cuenta atrás 3 segundos para que puedas quitar la mano del camino y luego toma una foto. Después de recopilar algunas, puedes usar el movimiento de tu mano para hojear la biblioteca de fotos de Glass como si pasaras páginas invisibles en un álbum de fotos.

Ese es sólo un uso. En última instancia, el equipo espera que ARI pueda reconocer una biblioteca completa de gestos, que los desarrolladores externos pueden incorporar a sus aplicaciones como controles. La aplicación Pandora, por ejemplo, algún día podría interpretar un pulgar hacia arriba literal como tu aprobación por esa canción de Whitesnake que acaba de reproducir en tu estación de los 80.

Una nueva forma de controlar Google Glass

Además de ser simplemente menos irritante que hablar con tus gafas, Fink y el cofundador Gary Peck lo ven como una forma esencial de controlar Glass en escenarios donde de otro modo nunca funcionaría, como una fábrica piso.

"Es muy ruidoso, a veces tienen cosas en sus manos y quieren poder interactuar fácilmente con el contenido o marcar cosas a medida que avanzan", explica Fink. Con ARI, un trabajador podría simplemente agitar una mano para mover la pantalla de sus gafas a la siguiente instrucción de una lista, o levantar el puño para marcarla como finalizada.

Lo mismo ocurre con los deportistas. Un practicante de snowboard con guantes gruesos puede tener dificultades para deslizar el panel táctil y un ciclista puede no querer levantar las manos del manillar para iniciar un cronómetro.

"Creo que al principio será un poco extraño, especialmente para las personas que no están familiarizadas con la tecnología".

En teoría, ARI resuelve todos estos problemas. En la ejecución, todavía quedan muchos problemas por resolver. La primera versión alfa que probamos tardó un poco en reconocer los gestos, y se necesita una ejecución decidida para realizar un golpe o un puño tal como ARI busca verlo.

Pero la rápida evolución de la tecnología de gafas inteligentes también podría ayudar a darle un impulso al paso más bien letárgico de ARI. Dado que analiza constantemente imágenes de la cámara Glass incorporada, ARI no puede ejecutarse en su teléfono; tiene que ejecutarse en el anémico procesador integrado en Glass. A medida que esos procesadores se vuelvan más rápidos, también lo hará ARI.

La cámara de Glass también sigue siendo un desafío, porque sólo hay una. Los sistemas de control de gestos especialmente diseñados, como Kinect de Microsoft, se basan en un par de cámaras para generar imágenes estéreo, lo que permite que la computadora, que lee sus movimientos maníacos, determine la profundidad. “Con las cámaras duales, realmente tienes un modelo 3D del mundo frente a ti. Con una sola cámara es simplemente una imagen simple", explica Peck. "No tienes idea de que esta mano es un objeto diferente de la mesa, son todos píxeles diferentes”. Peck ha tenido que solucionar esa entrada primitiva para detectar objetos basándose únicamente en su apariencia.

El desafío se hace aún más difícil por la necesidad de preservar la duración limitada de la batería de Google Glass: cuanto más precisa es la detección de gestos, más agota la batería. "Esa es la compensación", dijo Peck. "¿Cómo puedes conseguir una precisión que sea lo suficientemente buena para los gestos que intentas hacer?" Su código, por ejemplo, utiliza baja resolución. video de la cámara integrada a pesar de que técnicamente puede capturar a 1080p, porque no está tratando de rastrear cada dedo.

El factor geek aquí también es imposible de ignorar: ¿Cómo logras que la gente use una tecnología que te hace parecer el peor mimo del mundo? "Creo que al principio será un poco extraño, especialmente para las personas que no están familiarizadas con la tecnología", reconoce Fink, pero insiste en que las percepciones cambiarán a medida que la tecnología mejore. “Será mucho más parecido Hombre de Acero o Informe de minorías, donde es una experiencia inmersiva. Así que creo que el estigma de que sea extraño e incómodo desaparecerá con eso”.

El futuro de las gafas inteligentes y la realidad aumentada sigue siendo confuso.

Uno de los mayores avances vendrá de las “lentes de guía de ondas”. Mientras que Glass simplemente muestra una pequeña señal de vídeo en el rincón de su visión, las lentes de guía de ondas pueden literalmente superponer información en todo su campo de visión, como un verdadero Terminator anteojos. Vuzix ha producido los primeros prototipos de esta tecnología y algunos modelos costosos destinados a entornos industriales, pero aún no han alcanzado el tamaño o el precio de Google Glass. Peck cree que podría pasar al menos otro año antes de que veamos este nivel de visualización llegar al público general.

El futuro de las gafas inteligentes y la realidad aumentada sigue siendo confuso, pero los próximos pasos desconocidos siguen siendo parte del atractivo para Peck y Fink.

“Es un nuevo paradigma de interacción. Hay mucho que resolver: ¿cómo se presenta la información de la manera más intuitiva? ¿Cómo interactúas con él? Peck explica. “Pero como desarrollador de aplicaciones, no existen convenciones. No se sabe cuál es la mejor manera de presentar la información que aparece aquí en la pantalla. Esos son desafíos interesantes”.

Recomendaciones de los editores

- Digital Trends Live: el nuevo Glass de Google, Impossible Sausage y más

Mejora tu estilo de vidaDigital Trends ayuda a los lectores a mantenerse al tanto del vertiginoso mundo de la tecnología con las últimas noticias, reseñas divertidas de productos, editoriales interesantes y adelantos únicos.