Vorausschauende Polizeiarbeit sollte die Art und Weise der Polizeiarbeit verändern und uns in eine Welt intelligenter Gesetze führen Durchsetzung, bei der die Voreingenommenheit beseitigt wurde und die Polizei in der Lage wäre, auf die Daten zu reagieren, nicht auf sie Ahnungen. Aber ein Jahrzehnt nachdem die meisten von uns zum ersten Mal den Begriff „vorausschauende Polizeiarbeit“ gehört haben, scheint es klar zu sein, dass er nicht funktioniert hat. Aufgrund der öffentlichen Gegenreaktion verzeichnet die Technologie im Vergleich zu noch vor wenigen Jahren einen deutlichen Rückgang ihrer Nutzung.

Inhalt

- Das Versprechen einer vorausschauenden Polizeiarbeit

- Diskriminierende Algorithmen

- Die Gefahren schmutziger Daten

- Die ungewisse Zukunft der vorausschauenden Polizeiarbeit

- Die falschen Werkzeuge für den Job?

Im April dieses Jahres kürzte Los Angeles – das laut LA Times „Vorreiter bei der Vorhersage von Kriminalität anhand von Daten“ war – die Mittel für sein Programm zur prädiktiven Polizeiarbeit und machte dafür die Kosten verantwortlich. „Das ist eine schwere Entscheidung“, sagte Polizeichef Michel Moore

sagte der LA Times. „Es ist eine Strategie, die wir verwendet haben, aber die Kostenschätzungen von Hunderttausenden von Dollar, die dafür ausgegeben werden müssen, stimmen.“ Jetzt muss ich das tun, anstatt dieses Geld aufzutreiben und es für andere, zentralere Aktivitäten zu verwenden.“Empfohlene Videos

Was schief gelaufen ist? Wie könnte etwas, das als „intelligente“ Technologie beworben wird, dazu führen, dass sich Vorurteile und Diskriminierung noch weiter verfestigen? Und ist der Traum von der vorausschauenden Polizeiarbeit ein Traum, der mit dem richtigen Algorithmus optimiert werden könnte – oder eine Sackgasse in einer gerechteren Gesellschaft, die sich derzeit mit der Arbeitsweise der Polizei auseinandersetzt?

Das Versprechen einer vorausschauenden Polizeiarbeit

Die prädiktive Polizeiarbeit in ihrer jetzigen Form geht auf einen Aufsatz der Psychologin Colleen McCue und des Polizeichefs von Los Angeles, Charlie Beck, aus dem Jahr 2009 mit dem Titel „Predictive Policing“ zurück.Predictive Policing: Was können wir von Walmart und Amazon über die Kriminalitätsbekämpfung in einer Rezession lernen?„In dem Artikel griffen sie die Art und Weise auf, wie Big Data von großen Einzelhändlern genutzt wird, um Muster im vergangenen Kundenverhalten aufzudecken, die zur Vorhersage künftigen Verhaltens genutzt werden könnten. McCue und Beck schlugen vor, dass es dank der Fortschritte sowohl in der Computertechnik als auch in der Datenerfassung möglich sei, Kriminalitätsdaten in Echtzeit zu sammeln und zu analysieren. Diese Daten könnten dann genutzt werden, um Straftaten, die noch nicht stattgefunden haben, zu antizipieren, zu verhindern und wirksamer darauf zu reagieren.

In den darauffolgenden Jahren hat sich Predictive Policing in vielen Teilen der Vereinigten Staaten und im Rest der Welt von einer Wegwerfidee zur Realität entwickelt. Dabei hat sie sich zum Ziel gesetzt, die Polizeiarbeit von einer reaktiven zu einer proaktiven zu machen. Dabei stützen wir uns auf einige Durchbrüche in der datengesteuerten Technologie, die es ermöglichen, Muster in Echtzeit zu erkennen – und darauf zu reagieren.

„Es gibt zwei Hauptformen der vorausschauenden Polizeiarbeit“ Andrew Ferguson, Professor für Rechtswissenschaften an der University of the District of Columbia David A. Clarke School of Law und Autor von Der Aufstieg der Big-Data-Polizeiarbeit: Überwachung, Rasse und die Zukunft der Strafverfolgung, sagte Digital Trends. „[Dies sind] ortsbasierte prädiktive Polizeiarbeit und personenbasierte prädiktive Polizeiarbeit.“

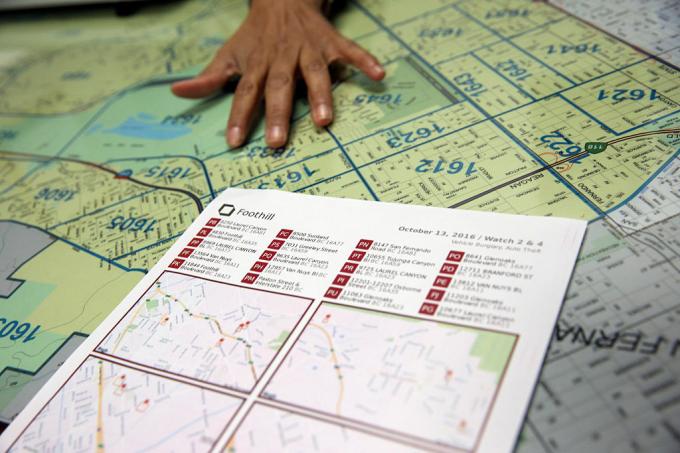

In beiden Fällen weisen die prädiktiven Polizeisysteme der betreffenden Person oder dem betreffenden Ort eine Risikobewertung zu, die die Polizei dazu anregt, in bestimmten Abständen nachzuhaken. Der erste dieser Ansätze, die ortsbasierte prädiktive Polizeiarbeit, konzentriert sich hauptsächlich auf Polizeipatrouillen. Dazu gehört der Einsatz von Kriminalitätskartierungen und Analysen über die wahrscheinlichen Orte zukünftiger Straftaten auf der Grundlage früherer Statistiken.

Anstatt dabei zu helfen, Probleme wie Rassismus und andere systemische Vorurteile zu beseitigen, kann vorausschauende Polizeiarbeit tatsächlich dazu beitragen, sie zu festigen.

Der zweite Ansatz konzentriert sich auf die Vorhersage der Wahrscheinlichkeit, dass eine Person ein potenzielles zukünftiges Risiko darstellt. Im Jahr 2013 wurde beispielsweise ein Polizeikommandant aus Chicago zum Haus des 22-jährigen Robert McDaniel geschickt. der von einem als potenzielles Risiko oder Täter von Waffengewalt in der Innenstadt von Chicago eingestuft wurde Algorithmus. Die „Hitzeliste“, die der Algorithmus zusammengestellt hat, suchte nach Mustern, die möglicherweise zukünftige Straftäter vorhersagen könnten oder Opfer, selbst wenn sie selbst nichts getan hätten, was diese Prüfung über die Einhaltung von a hinaus rechtfertigte Profil.

Als die Chicago Tribune bemerkte: „Die Strategie sieht vor, diejenigen auf der Hauptliste einzeln zu warnen, dass weitere kriminelle Aktivitäten, selbst bei geringfügigsten Verstößen wird die volle Härte des Gesetzes zur Folge haben ihnen."

Der Traum von Predictive Policing bestand darin, dass die Polizeiarbeit durch das Eingreifen auf quantifizierbare Daten nicht nur effizienter, sondern auch weniger anfällig für Vermutungen und damit Voreingenommenheit werden würde. Befürworter behaupteten, es würde die Polizeiarbeit zum Besseren verändern und eine neue Ära der intelligenten Polizeiarbeit einläuten. Allerdings gab es schon fast von Anfang an heftige Kritiker an der prädiktiven Polizeiarbeit. Sie argumentieren, dass Predictive Policing nicht dabei hilft, Probleme wie Rassismus und andere systemische Vorurteile zu beseitigen, sondern vielmehr dabei hilft, sie zu festigen. Und es ist schwer zu behaupten, dass sie keinen Sinn haben.

Diskriminierende Algorithmen

Die Idee, dass prädiktive Polizeisysteme, die auf maschinellem Lernen basieren, lernen können, anhand von Faktoren wie der Rasse zu diskriminieren, ist nichts Neues. Tools für maschinelles Lernen werden mit riesigen Datenmengen trainiert. Und solange diese Daten von einem System gesammelt werden, in dem die Rasse weiterhin ein überwältigender Faktor ist, kann das zu Diskriminierung führen.

Als Renata M. O’Donnell schreibt in einem Artikel aus dem Jahr 2019 mit dem Titel „Infragestellung rassistischer prädiktiver Polizeialgorithmen gemäß der Gleichbehandlungsklausel„Maschinelle Lernalgorithmen lernen aus Daten, die aus einem Justizsystem stammen, in dem „schwarze Amerikaner in regelmäßigen Abständen in Staatsgefängnissen eingesperrt sind Das ist das 5,1-fache der Inhaftierung von Weißen, und jeder dritte heute geborene schwarze Mann muss damit rechnen, im Laufe seines Lebens ins Gefängnis zu gehen, wenn man den aktuellen Trends folgt weitermachen."

„Daten sind nicht objektiv“, sagte Ferguson gegenüber Digital Trends. „Wir sind nur auf Binärcode reduziert. Datengesteuerte Systeme, die in der realen Welt funktionieren, sind nicht objektiver, fairer oder unvoreingenommener als die reale Welt. Wenn Ihre reale Welt strukturell ungleich oder rassistisch diskriminierend ist, wird ein datengesteuertes System diese gesellschaftlichen Ungleichheiten widerspiegeln. Die eingehenden Eingaben sind voreingenommen. Die Analyse ist von Voreingenommenheit geprägt. Und die Mechanismen der Polizeigewalt ändern sich nicht, nur weil es Technologie gibt, die die Systeme steuert.“

Ferguson nennt als Beispiel Verhaftungen einen scheinbar objektiven Faktor bei der Risikovorhersage. Festnahmen werden jedoch durch die Zuteilung der Polizeiressourcen (z. B. den Ort, an dem sie patrouillieren) und die Arten von Straftaten, die typischerweise eine Festnahme rechtfertigen, verzerrt sein. Dies ist nur ein Beispiel für potenziell problematische Daten.

Die Gefahren schmutziger Daten

Fehlende und falsche Daten werden im Data Mining manchmal als „schmutzige Daten“ bezeichnet. A 2019-Artikel von Forschern des A.I. Jetzt Institut an der New York University erweitert diesen Begriff und bezieht sich auch auf Daten, die korrupt, voreingenommen und rechtswidrig sind Praktiken – sei es aus absichtlich manipulierten oder von Einzelpersonen verzerrten Praktiken gesellschaftliche Vorurteile. Dazu könnten beispielsweise Daten gehören, die aus der Festnahme einer unschuldigen Person stammen, der Beweise beigefügt wurden oder die auf andere Weise fälschlicherweise beschuldigt wird.

Es liegt eine gewisse Ironie darin, dass in den letzten Jahrzehnten die Anforderungen der Datengesellschaft, in der Alles dreht sich um Quantifizierung und eiserne numerische Ziele, hat gerade zu einer ganzen Menge … nun ja, wirklich geführt schlechte Daten. Die HBO-Serie Das Kabel zeigte das reale Phänomen des „Junking the Stats“, und die Jahre, seit die Show ausgestrahlt wurde, haben viel zu bieten Beispiele für tatsächliche systemische Datenmanipulation, gefälschte Polizeiberichte und verfassungswidrige Praktiken, die unschuldige Menschen dorthin geschickt haben Gefängnis.

Schlechte Daten, die es Machthabern ermöglichen, Ziele künstlich anzugreifen, sind eine Sache. Aber wenn man das mit Algorithmen und Vorhersagemodellen kombiniert, die dies als Grundlage für die Modellierung der Welt nutzen, kommt man möglicherweise zu etwas noch viel Schlimmerem.

Forscher haben gezeigt, wie fragwürdige Kriminalitätsdaten, die in prädiktive Polizeialgorithmen eingebunden werden, zu etwas führen können, das als „außer Kontrolle geratene Rückkopplungsschleifen„, bei dem die Polizei unabhängig von der tatsächlichen Kriminalitätsrate immer wieder in die gleichen Viertel geschickt wird. Einer der Co-Autoren dieses Artikels, Informatiker Suresh Venkatasubramanian, sagt, dass Modelle des maschinellen Lernens durch ihre Modellierung fehlerhafte Annahmen einbauen können. Wie das alte Sprichwort besagt, dass für den Menschen mit einem Hammer jedes Problem wie ein Nagel aussieht, modellieren diese Systeme nur bestimmte Elemente eines Problems – und stellen sich nur ein mögliches Ergebnis vor.

„[Etwas, das] in diesen Modellen nicht berücksichtigt wird, ist, inwieweit Sie die Tatsache modellieren, dass es tatsächlich möglich ist, mehr Polizisten in ein Gebiet zu schicken die Lebensqualität der dort lebenden Menschen verringern?“ Venkatasubramanian, Professor an der School of Computing der University of Utah, sagte gegenüber Digital Trends. „Wir gehen davon aus, dass mehr Polizisten eine bessere Sache sind. Aber wie wir gerade sehen, ist es nicht unbedingt eine gute Sache, mehr Polizei zu haben. Es kann tatsächlich alles noch schlimmer machen. Bei keinem Modell, das ich je gesehen habe, hat jemals jemand gefragt, wie hoch die Kosten sind, wenn mehr Polizei in einem Gebiet stationiert wird.“

Die ungewisse Zukunft der vorausschauenden Polizeiarbeit

Diejenigen, die in der prädiktiven Polizeiarbeit arbeiten, verwenden manchmal ironischerweise den Begriff „Minderheitenbericht“, um sich auf die Art der Vorhersage zu beziehen, die sie durchführen. Der Begriff wird häufig als Hinweis auf die verwendet gleichnamiger Film aus dem Jahr 2002, das wiederum lose auf einer Kurzgeschichte von Philip K. aus dem Jahr 1956 basierte. Dick. In Minderheitsbericht, eine spezielle PreCrime-Polizeibehörde, nimmt Kriminelle auf der Grundlage des Vorwissens über Straftaten fest, die in der Zukunft begangen werden sollen. Diese Prognosen werden von drei Hellsehern bereitgestellt, die „Precogs“ genannt werden.

Aber die Wendung Minderheitsbericht ist, dass die Vorhersagen nicht immer korrekt sind. Abweichende Visionen eines der Precogs bieten eine alternative Sicht auf die Zukunft, die aus Angst, das System als unglaubwürdig erscheinen zu lassen, unterdrückt wird.

Interne Audits zeigen, dass die Taktik nicht funktioniert hat. Die Vorhersagelisten waren nicht nur fehlerhaft, sondern auch unwirksam.

Derzeit steht die prädiktive Polizeiarbeit vor einer ungewissen Zukunft. Neben neuen Technologien wie der Gesichtserkennung war die Technologie, die den Strafverfolgungsbehörden zur möglichen Nutzung zur Verfügung steht, noch nie so leistungsfähig. Gleichzeitig hat das Bewusstsein für den Einsatz vorausschauender Polizeiarbeit zu einer öffentlichen Gegenreaktion geführt, die möglicherweise tatsächlich dazu beigetragen hat, diese zu unterdrücken. Ferguson sagte gegenüber Digital Trends, dass der Einsatz prädiktiver Polizeiinstrumente in den letzten Jahren einen „Abschwung“ erlebt habe.

„Auf dem Höhepunkt war die ortsbezogene prädiktive Polizeiarbeit in über 60 Großstädten verbreitet, Tendenz steigend, aber infolgedessen Trotz erfolgreicher Community-Organisation wurde sie weitgehend reduziert und/oder durch andere Formen der datengesteuerten Organisation ersetzt Analytik“, sagte er. „Kurz gesagt, der Begriff „Predictive Policing“ wurde giftig und die Polizeibehörden lernten, ihre Arbeit mit Daten umzubenennen. Die personenbasierte prädiktive Polizeiarbeit verzeichnete einen stärkeren Rückgang. Die beiden wichtigsten Städte, die in seine Gründung investiert haben – Chicago und Los Angeles – haben ihre personenbezogenen Daten zurückgezogen Strategien nach scharfer Community-Kritik und verheerenden internen Audits, die zeigen, dass die Taktiken nicht funktionierten arbeiten. Die Vorhersagelisten waren nicht nur fehlerhaft, sie waren auch ineffektiv.“

Die falschen Werkzeuge für den Job?

Jedoch, Rashida Richardson, Direktor für Politikforschung am A.I. Das Now Institute sagte, dass der Einsatz dieser Technologie zu undurchsichtig sei. „Wir wissen es immer noch nicht, da es an Transparenz hinsichtlich des Erwerbs von Technologie durch die Regierung und vielem mehr mangelt Schlupflöcher in bestehenden Vergabeverfahren, die bestimmte Technologiekäufe vor öffentlicher Kontrolle schützen könnten“, Sie sagte. Sie nennt als Beispiel Technologie, die einer Polizeibehörde kostenlos zur Verfügung gestellt oder von Dritten gekauft werden könnte. „Aus Untersuchungen wie meiner und Medienberichten wissen wir, dass viele der größten Polizeibehörden in den USA das genutzt haben Technologie wird irgendwann einmal eingeführt, aber es gibt auch viele kleine Polizeibehörden, die sie nutzen oder nur für begrenzte Zeiträume genutzt haben von Zeit."

Wird angesichts der aktuellen Frage nach der Rolle der Polizei die Versuchung bestehen, sich noch einmal darauf einzulassen? Predictive Policing als Instrument zur datengesteuerten Entscheidungsfindung – vielleicht im Rahmen einer weniger dystopischen Science-Fiction Branding? Es besteht die Möglichkeit, dass es zu einem solchen Wiederaufleben kommen könnte. Venkatasubramanian ist jedoch äußerst skeptisch, ob maschinelles Lernen, wie es derzeit praktiziert wird, das richtige Werkzeug für diese Aufgabe ist.

„Das gesamte maschinelle Lernen und sein Erfolg in der modernen Gesellschaft basieren auf der Prämisse, dass, egal was tatsächlich passiert Problem, es läuft letztendlich darauf hinaus, Daten zu sammeln, ein Modell zu erstellen, Ergebnisse vorherzusagen – und Sie müssen sich keine Sorgen um die Domäne machen.“ er sagte. „Man kann denselben Code schreiben und ihn an 100 verschiedenen Stellen anwenden. Das ist das Versprechen von Abstraktion und Portabilität. Das Problem besteht darin, dass dies nicht möglich ist, wenn wir sogenannte soziotechnische Systeme nutzen, bei denen Menschen und Technologie in komplizierten Wellen miteinander verzahnt sind. Sie können nicht einfach ein Teil anschließen und erwarten, dass es funktioniert. Denn es gibt Welleneffekte beim Einsetzen dieses Teils und der Tatsache, dass es Unterschiede gibt Spieler mit unterschiedlichen Absichten in einem solchen System, und sie unterwandern das System nach ihren eigenen Bedürfnissen verschiedene Wege. All diese Dinge müssen berücksichtigt werden, wenn man über Wirksamkeit spricht. Ja, man kann abstrakt sagen, dass alles gut funktionieren wird, aber so ist es Ist keine Zusammenfassung. Es gibt nur den Kontext, in dem Sie arbeiten.“