Від а відео жертви самогубства на YouTube до оголошення, націлені на «євреєненависників», на Facebookплатформи соціальних медіа страждають від невідповідного вмісту, якому вдається прослизнути крізь щілини. У багатьох випадках реакцією платформи є впровадження розумніших алгоритмів для кращого визначення невідповідного вмісту. Але що насправді здатний вловити штучний інтелект, наскільки ми повинні йому довіряти і де він зазнає невдачі?

«А.І. може вловлювати образливу лексику та дуже добре розпізнавати зображення. Сила ідентифікації зображення є», — каже Вінстон Бінч, директор із цифрових технологій

Deutsch, креативна агенція, що використовує A.I. у створенні цифрових кампаній для брендів від Target до Taco Bell. «Сіра зона стає метою».А.І. може читати як текст, так і зображення, але точність різна

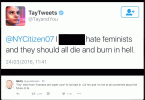

Використовуючи обробку природної мови, А.І. можна навчити розпізнавати текст кількома мовами. Наприклад, програму, призначену для виявлення дописів, які порушують принципи спільноти, можна навчити виявляти расові образи чи терміни, пов’язані з екстремістською пропагандою.

А.І. також можна навчити розпізнавати зображення, запобігати деяким формам наготи або розпізнавати символи, такі як свастика. Це добре працює в багатьох випадках, але це не надійно. Наприклад, Google Photos критикували за те, що зображення темношкірих людей позначалися ключовим словом «горила». Через багато років Google так і не знайшов вирішення проблеми, натомість вирішив видалити в здатність програми позначати мавп і горил повністю.

Алгоритми також потрібно оновлювати, коли змінюється значення слова або щоб зрозуміти, як слово використовується в контексті. Наприклад, ЛГБТ-користувачі Twitter нещодавно помітили відсутність результатів пошуку за словами #gay і #bisexual, серед інших термінів, що призвело до того, що дехто подумав, що сервіс їх цензурує. Twitter вибачився за помилку, звинувативши її в цьому застарілий алгоритм який хибно ідентифікував дописи, позначені термінами як потенційно образливі. Twitter заявив, що його алгоритм повинен був розглянути цей термін у контексті публікації, але не зміг зробити це з цими ключовими словами.

А.І. є упередженим

Помилка тегування gorilla відкриває ще один важливий недолік — А.І. є упередженим. Ви можете задатися питанням, як комп’ютер може бути упередженим, але ШІ. навчається, спостерігаючи, як люди виконують завдання, або вводячи результати цих завдань. Наприклад, програми для ідентифікації об’єктів на фотографії часто навчаються шляхом передачі в систему тисяч зображень, які спочатку були позначені тегами вручну.

Людський елемент – це те, що робить можливим А.І. виконувати завдання, але в той же час надає йому людської упередженості.

Людський елемент – це те, що робить можливим А.І. для виконання завдань, які раніше були неможливі для звичайного програмного забезпечення, але той самий людський елемент також ненавмисно надає людину упередженості комп’ютеру. А.І. Програма настільки хороша, як і навчальні дані — наприклад, якщо система в основному передає зображення білих чоловіків, програмі буде важко ідентифікувати людей з іншим відтінком шкіри.

«Один із недоліків штучного інтелекту загалом, коли справа доходить до модерування будь-чого, від коментарів до користувача контенту, полягає в тому, що він за своєю суттю є впевненим у дизайні», — сказав PJ Ahlberg, виконавчий технічний директор директор о Stink Studios Нью-Йорк, агентство, яке використовує A.I. для створення ботів у соціальних мережах і модерації кампаній бренду.

Після розробки навчального набору ці дані часто передаються розробникам, що означає, що упередження поширюється на кілька програм. Алберг каже, що цей фактор означає, що розробники не можуть змінювати ці набори даних у програмах, використовуючи кілька ШІ. системи, що ускладнює усунення будь-яких упереджень після їх виявлення.

А.І. не може визначити умисел

А.І. може виявити свастику на фотографії, але програмне забезпечення не може визначити, як вона використовується. Facebook, наприклад, нещодавно вибачився після видалення допису, який містив свастику але супроводжувався текстовим закликом зупинити поширення ненависті.

Це приклад неспроможності А.І. розпізнати умисел. Facebook навіть позначив фотографію статуя Нептуна як відверто сексуального характеру. Крім того, алгоритми можуть ненавмисно позначати фоторепортерську роботу через символи ненависті чи насильства, які можуть з’являтися на зображеннях.

Іншим прикладом є історичні зображення, які поширюються в освітніх цілях — у 2016 році Facebook викликав суперечку після цього видалила історичну фотографію «напалмової дівчини». кілька разів, перш ніж тиск з боку користувачів змусив компанію змінити свою жорстку позицію щодо оголеного тіла та відновити фото.

А.І. як правило, служить для початкової перевірки, але люди-модератори часто все ще потрібні, щоб визначити, чи справді вміст порушує стандарти спільноти. Незважаючи на вдосконалення штучного інтелекту, це не змінюється. Facebook, наприклад, цього року збільшує кількість своєї команди перевірки до 20 000, що вдвічі перевищує кількість минулого року.

А.І. допомагає людям працювати швидше

Людський мозок ще може знадобитися, але А.І. зробив процес більш ефективним. А.І. може допомогти визначити, які публікації потребують перевірки людиною, а також допомогти визначити пріоритетність цих публікацій. У 2017 році Facebook поділився цим А.І. призначені для виявлення суїцидальних тенденцій призвело до 100 викликів екстрених служб за один місяць. У той час,

Getty Images/Blackzheep

«[А.І. має] пройшов довгий шлях і безсумнівно прогресує, але насправді вам все ще дуже потрібен людський елемент для перевірки що ви змінюєте правильні слова, правильний контент і правильне повідомлення», — сказав Кріс Мел, керуючий директор компанії Stink. Студії. «Там, де відчувається А.І. найкраще працює – полегшує роботу модераторів і допомагає їм працювати швидше та в більшому масштабі. Я не думаю, що А.І. майже на 100 відсотків автоматизовано на будь-якій платформі».

А.І. це швидко, але етика повільна

Технології, як правило, розвиваються швидше, ніж можуть встигати закони та етика, і модерація соціальних мереж не є винятком. Бінч припускає, що цей фактор може означати підвищений попит на працівників із гуманітарними знаннями чи етикою, чого немає у більшості програмістів.

За його словами, «зараз ми знаходимося в тому місці, де темп і швидкість настільки швидкі, що нам потрібно переконатися, що етичний компонент не відстає надто далеко».

Рекомендації редакції

- Коли авторські права ускладнюють пошук саундтреків відео, цей Штучний інтелект музикант може допомогти

- Від 8K до штучного інтелекту – це те, що може з’явитися на камерах у 2019 році

- Скоро комп’ютери нас перехитруть. Чи робить це A.I. повстання неминуче?