Under GTC 2022 konferens, Nvidia pratade om att använda artificiell intelligens och maskininlärning för att göra framtida grafikkort bättre än någonsin.

Eftersom företaget väljer att prioritera AI och maskininlärning (ML), kommer några av dessa framsteg redan att hitta vägen till nästa generations Ada Lovelace GPU: er.

Nvidias stora planer för AI och ML i nästa generations grafikkort delades av Bill Dally, företagets chefsforskare och senior vice vd för forskning. Han pratade om Nvidias forsknings- och utvecklingsteam, hur de använder AI och maskininlärning (ML) och vad detta betyder för nästa generations GPU: er.

Rekommenderade videor

Kort sagt, att använda dessa tekniker kan bara betyda bra saker för Nvidia-grafikkort. Dally diskuterade fyra stora delar av GPU-designen, såväl som sätten på vilka användning av AI och ML drastiskt kan påskynda GPU-prestandan.

Målet är en ökning av både hastighet och effektivitet, och Dallys exempel talar om hur användning av AI och ML kan sänka en standard GPU-designuppgift från tre timmar till bara tre sekunder.

Att använda artificiell intelligens och maskininlärning kan hjälpa till att optimera alla dessa processer.

Detta påstås vara möjligt genom att optimera upp till fyra processer som normalt tar mycket tid och är mycket detaljerade.

Detta syftar på att övervaka och kartlägga effektspänningsfall, förutse fel genom parasitisk förutsägelse, standardiserad cellmigreringsautomation och ta itu med olika routingutmaningar. Att använda artificiell intelligens och maskininlärning kan hjälpa till att optimera alla dessa processer, vilket resulterar i stora vinster i slutprodukten.

Kartläggning av potentiella spänningsfall hjälper Nvidia att spåra strömflödet för nästa generations grafikkort. Enligt Dally kan byte från att använda standardverktyg till specialiserade AI-verktyg påskynda denna uppgift drastiskt, eftersom den nya tekniken kan utföra sådana uppgifter på bara några sekunder.

Dally sa att användning av AI och ML för att kartlägga spänningsfall kan öka noggrannheten med så mycket som 94% samtidigt som den ökar enormt hastigheten med vilken dessa uppgifter utförs.

Dataflödet i nya chips är en viktig faktor för hur väl ett nytt grafikkort utför. Därför använder Nvidia grafiska neurala nätverk (GNN) för att identifiera möjliga problem i dataflödet och åtgärda dem snabbt.

Parasitisk förutsägelse genom användning av AI är ett annat område där Nvidia ser förbättringar, och noterar ökad noggrannhet, med simuleringsfelfrekvenser som sjunker under 10 procent.

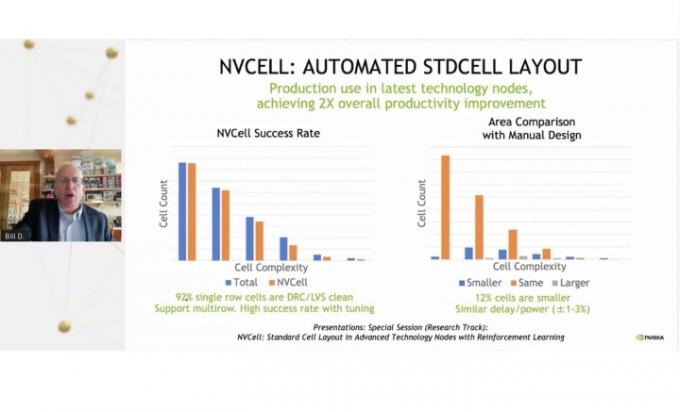

Nvidia har också lyckats automatisera processen att migrera chipets standardceller, minska på mycket driftstopp och påskynda hela uppgiften. Med det migrerades 92 % av cellbiblioteket med hjälp av ett verktyg utan fel.

Företaget planerar att fokusera på AI och maskininlärning framöver, och dedikerar fem av sina laboratorier till att forska och designa nya lösningar inom dessa segment. Dally antydde att vi kan se de första resultaten av dessa nya utvecklingar i Nvidias nya 7nm och 5nm design, som inkluderar de kommande Ada Lovelace GPU: erna. Detta rapporterades först av Wccftech.

Det är ingen hemlighet att nästa generations grafikkort, ofta kallade RTX 4000, kommer att vara intensivt kraftfull (med effektkrav som matchar). Att använda AI och maskininlärning för att främja utvecklingen av dessa GPU: er innebär att vi snart kan ha ett riktigt kraftpaket i våra händer.

Redaktörens rekommendationer

- Nvidias fredserbjudande fungerar inte

- Denna mystiska Nvidia GPU är en absolut monstrositet - och vi har precis fått en ny look

- Varför Nvidias helt nya GPU presterar sämre än integrerad grafik

- Nvidias RTX 4060 kan komma tidigare än väntat

- AMD kan krossa Nvidia med sina bärbara GPU: er - men det är tyst på skrivbordet

Uppgradera din livsstilDigitala trender hjälper läsare att hålla koll på den snabba teknikvärlden med alla de senaste nyheterna, roliga produktrecensioner, insiktsfulla redaktioner och unika smygtittar.