Från Journeys "Sluta inte tro"till Queen's"Bohemian Rhapsody" till Kylie Minogues "Kan inte få dig ur mitt huvud”, det finns några låtar som framgångsrikt lyckas maska sig ner i våra hörselgångar och ta plats i våra hjärnor. Tänk om det var möjligt att läsa hjärnans signaler och att använda dessa för att exakt gissa vilken låt en person lyssnar på vid ett givet ögonblick?

Innehåll

- Läsa tankar, träningsmaskiner

- Vägen till hjärn-dator-gränssnitt

Det är vad forskare från Human-Centered Design-avdelningen vid Delft University of Technology i Nederländerna och avdelningen för kognitiv vetenskap vid Indian Institute of Technology Gandhinagar har varit jobbar på. I ett nyligen genomfört experiment visade de att det är utomordentligt möjligt - och konsekvenserna kan vara mer betydande än du kanske tror.

Rekommenderade videor

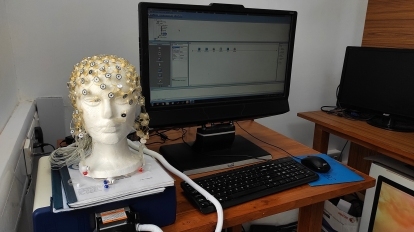

För studien rekryterade forskarna en grupp på 20 personer. och bad dem lyssna på 12 låtar med hjälp av hörlurar. För att underlätta deras fokus mörklades rummet och volontärerna fick ögonbindel. Var och en var försedd med en elektroencefalografi (EEG) keps som noninvasivt kan fånga upp den elektriska aktiviteten i hårbotten när de lyssnar på låtarna.

Dessa hjärndata, tillsammans med motsvarande musik, användes sedan för att träna en artificiellt neuralt nätverk för att kunna identifiera kopplingar mellan de två. När den resulterande algoritmen testades på data som den inte hade sett tidigare, kunde den korrekt identifiera låten med 85 % noggrannhet – helt baserat på hjärnvågorna.

"Sångerna var en blandning av västerländska och indiska låtar och inkluderade ett antal genrer," Krishna Miyapuram, biträdande professor i kognitiv vetenskap och datavetenskap vid Indian Institute of Technology Gandhinagar, berättade för Digital Trends. ”På detta sätt konstruerade vi ett större representativt urval för utbildning och testning. Tillvägagångssättet bekräftades när vi fick imponerande klassificeringsnoggrannhet, även när vi begränsade träningsdatan till en mindre andel av datamängden."

Läsa tankar, träningsmaskiner

Det här är inte första gången som forskare har visat att det är möjligt att genomföra "mind-reading" demonstrationer som skulle göra David Blaine avundsjuk, alla med hjälp av EEG-data. Till exempel har neuroforskare vid Kanadas University of Toronto Scarborough tidigare rekonstruerat bilder baserade på EEG-data för att återskapa ansiktsbilder digitalt lagras i en persons sinne. Miyapurams egen tidigare forskning inkluderar ett projekt där EEG-data användes för att identifiera filmklipp som deltagare tittade på, med var och en avsedd att framkalla olika känslomässiga reaktioner.

Intressant nog visade detta senaste arbete att algoritmer som visade sig vara mycket effektiva för att gissa låtarna som lyssnades att av en deltagare, efter att ha tränats på sin specifika hjärna, inte skulle fungera så bra när den applicerades på en annan person. Faktum är att "inte så bra" är en grov underdrift: noggrannheten i dessa tester rasade från 85 % till mindre än 10 %.

"Vår forskning visar att individer har personliga erfarenheter av musik," sa Miyapuram. "Man kan förvänta sig att hjärnan svarar på ett liknande sätt och bearbetar information från olika stimuli. Detta är sant för vad vi förstår som funktioner på låg nivå eller funktioner på stimulusnivå. [Men] när det kommer till musik är det kanske funktionerna på högre nivå, som njutning, som skiljer mellan individuella upplevelser.”

Derek Lomas, biträdande professor i positiv A.I. vid Delft University of Technology, sa att ett framtida mål med projektet är att kartlägga sambandet mellan EEG-frekvenser och musikaliska frekvenser. Detta kan hjälpa till att svara på frågor som om större estetisk resonans åtföljs av större neural resonans.

För att uttrycka det på ett annat sätt, kommer en person som "rörs" av ett musikstycke att visa större korrelationer mellan själva musiken och hjärnans respons, vilket gör det möjligt att exakt förutsäga hur mycket en person tycker om ett musikstycke bara genom att titta på deras hjärnvågor? Även om allas svar på musik kan vara subtilt olika, kan detta bidra till att belysa varför människor söker efter musik till att börja med.

Vägen till hjärn-dator-gränssnitt

"För kortsiktiga tillämpningar [under de kommande två åren] föreställer vi oss en motor för musikrekommendationer som kan baseras på en persons hjärnans reaktion," sa Lomas till Digital Trends. "Jag har för närvarande en student som arbetar med algoritmiskt genererad musik som maximerar neural resonans. Det är ganska kusligt: Den maximala neurala resonansen är inte detsamma som maximal estetisk resonans."

På medellång sikt föreslog Lomas att det skulle kunna leda till kraftfulla applikationer för att få information om "djupet av erfarenhet" som en person som engagerar sig i media åtnjuter. Med hjälp av verktyg för hjärnanalys kan det (och borde faktiskt) vara möjligt att exakt förutsäga hur djupt engagerad en person är när man till exempel tittar på en film eller lyssnar på ett album. Ett hjärnbaserat mått på engagemang kan sedan användas för att finslipa specifika upplevelser. Vill du göra din film mer engagerande för 90 % av tittarna? Modifiera detta scen, ändra den där ett.

"På lång sikt - 20 år - kan detta arbetsfält möjliggöra metoder för att transkribera innehållet i fantasin", fortsatte Lomas. ”Till exempel transkribera tankar till text. Det är den stora framtiden för [hjärn-dator-gränssnitt.]”

Som Lomas noterade är vi fortfarande en bit bort från det slutliga målet med ett hjärn-dator-gränssnitt. Ändå tyder arbete som detta på att det finns gott om välsmakande lägre hängande frukt på det trädet innan vi slutligen fällde det.

A uppsats som beskriver denna forskning, med titeln GuessTheMusic: Song Identification from Electroencephalography, presenterades nyligen på CODS-COMAD 2021.

Redaktörens rekommendationer

- Deep learning A.I. kan imitera distorsionseffekterna av ikoniska gitarrgudar

Uppgradera din livsstilDigitala trender hjälper läsare att hålla koll på den snabba teknikvärlden med alla de senaste nyheterna, roliga produktrecensioner, insiktsfulla redaktioner och unika smygtittar.