Om du funderar på att köpa eller bygga en ny speldator, då är valet av grafikkort viktigt. Det kan också vara svårt att göra, med inte bara olika tillverkare att välja på utan också olika versioner av varje enskilt grafikkort. Hur uppgraderar du ditt grafikkort om du inte ens är säker på vilket du ska köpa?

Innehåll

- AMD mot Nvidia mot Intel

- CUDA-kärnor och streamingprocessorer

- VRAM

- GPU och minnes klockhastighet

- Kylning och kraft

Rekommenderade videor

Att välja en grafikkort handlar om att lära sig läsa siffrorna och avgöra vad som är viktigt. Behöver du mer VRAM eller fler grafikprocessorkärnor (GPU)? Hur viktigt är kylning? Vad sägs om power draw? Det här är alla frågor vi kommer att besvara (och fler) när vi bryter ner hur man hittar en GPU som är rätt för dig.

AMD mot Nvidia mot Intel

När det kommer till att köpa ett nytt grafikkort är de två huvudvalen AMD och Nvidia. Dessa två branschjättar har de mest kraftfulla korten, och även deras budgeterbjudanden är designade med spel i HD-upplösningar i åtanke. Intel är mest känt för sina integrerade eller inbyggda GPU: er. Tillsammans med dess processorer är de inte riktigt designade för spel på riktigt samma sätt. De kan göra det, men det är de

bäst lämpad för oberoende spel och äldre titlar.Detta kan dock snart ändras, eftersom Intel är inställd på att lansera sin diskreta Intel Arc grafikkort senare i år. Med början med bärbara lösningar kommer Intel så småningom att gå in på gör-det-själv-datormarknaden och erbjuda stationära datorer

Det finns fler val att göra än branding när det kommer till att välja ett grafikkort, men AMD och Nvidia har några utmärkande funktioner som är unika för deras hårdvara. Nvidia-kort har exklusivt stöd för G-Sync-teknik och hänger väl med GeForce nu, men övervakar som bara stöder AMD FreeSync kommer fortfarande att fungera med Nvidia. Det finns också deep learning super sampling (DLSS), som har visat sig kunna leverera imponerande prestandaförbättringar till en växande lista med stödjande spel. Nvidia var först med att stödja strålspårning, men nu erbjuder AMD också tillgång till den tekniken. Nvidia har dock haft ett långt försprång när det kommer till strålspårning, så din körsträcka kan variera med ett AMD Radeon-kort.

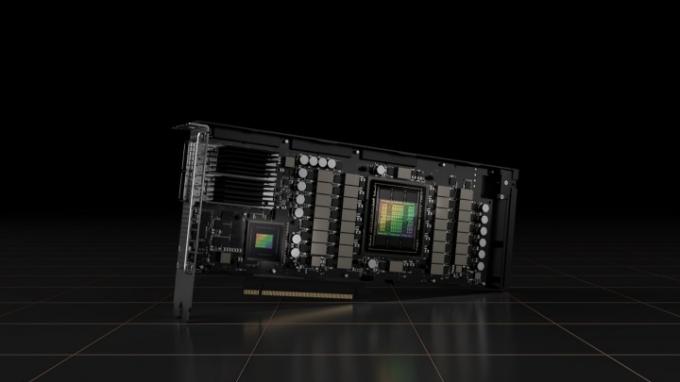

Nvidia har också de mest kraftfulla grafikkorten som finns tillgängliga med ganska stor marginal. Flaggskeppet RTX 3080 är en 4K gigant, om du kan hitta en i lager. De RTX 3090 är ännu mer imponerande, men det är mycket dyrare än vissa människor är villiga att spendera. Det finns också 3090 Ti, en komplett best för spel och alla möjliga kreativa arbetsflöden.

Det betyder dock inte att AMD är nere och ut. Faktum är att dess avancerade grafikkort är kapabla och har en viktig nisch på marknaden. Dess GPU: er tenderar att erbjuda något större värde för pengarna i de flesta sektorer av marknaden, även om dess funktionsuppsättning utan tvekan är svagare. Den erbjuder stöd för Freesync ramsynkronisering (en teknologi jämförbar med G-Sync), samt bildskärpa och andra visuella förbättringar, vilket kan få spel att se bättre ut för nästan ingen extra kostnad i resurser. AMD använder också FidelityFX Super Resolution 2.0 och Radeon Super Resolution för bilduppskalning.

I slutändan, när det gäller att välja en GPU, är det användbart att överväga om din bildskärm stöder Freesync eller G-Sync och om någon av de kompletterande funktionerna på dessa företags grafikkort kan hjälpa dig. För de flesta kommer pris och prestanda att vara viktigare överväganden.

CUDA-kärnor och streamingprocessorer

Även om processorer och grafikkort har processorkärnor i sitt hjärta, är deras uppgifter olika, så antalet av dem är också olika. CPU: er måste vara kraftfulla maskiner för allmänna ändamål, medan GPU: er är designade med massor av parallella – men enkla – beräkningar vid varje tidpunkt. Det är därför CPU: er har en handfull kärnor och GPU: er har hundratals eller tusentals.

Mer är vanligtvis bättre, även om det finns andra faktorer som kan mildra det. Ett kort med lite färre kärnor kan ha en högre klockhastighet (mer om det senare), vilket kan öka dess prestanda till och med över den för kort med högre antal kärnor – men inte normalt. Det är därför individuella recensioner av grafikkort och direkta jämförelser är så viktiga.

I vårt test av RTX 3080 Ti och den RTX 3080, kunde det avancerade kortet mata ut över 100 bilder per sekund (fps) in Battlefield V, men i rättvisans namn var RTX 3080 inte långt efter med ett genomsnitt på 100 fps. Vi jämförde också GPU: erna med AMD: s avancerade erbjudande Radeon RX 6900 XT, och fann att den presterade bäst av alla tre vid 106 fps.

Kallas CUDA-kärnor i fallet med Nvidias GPU: er och strömprocessorer på AMD: s kort, GPU-kärnor är designade lite annorlunda beroende på GPU-arkitekturen. Det gör att AMD och Nvidias kärnvärden inte är särskilt jämförbara, åtminstone inte rent siffermässigt.

Inom varje produktlinje kan du dock göra jämförelser. RTX 3080 kommer till exempel med 8 704 CUDA-kärnor, medan RTX 3090 har 10 496. Som jämförelse har 2080 Ti runt 4 300 CUDA-kärnor, hälften av vad 3080 har. Detta är dock två olika generationer av GPU, och bara för att 3080 har dubbla CUDA-kärnorna, betyder det inte att den har dubbla prestanda.

Turing CUDA-kärnor - de på 20-seriens GPU: er - kan hantera ett heltal och flyttalsberäkning samtidigt per klockcykel (FP32 + INT), medan Ampere CUDA-kärnor - de på 30-seriens GPU: er - också kan hantera dubbla flyttalsberäkningar (FP32 + FP32). Så även om det finns en enorm teoretisk prestandaökning, gör skillnaden i kärnarbetsbelastning inte de två generationerna av GPU: er direkt jämförbara.

Nvidia-kort har nu också RT- och Tensor-kärnor. RT-kärnorna är enkla nog och hanterar ray-tracing av hårdvara med Nvidias RTX-märkta GPU: er. Tensorkärnor är lite mer involverade. Nvidia introducerade sina Tensor-kärnor med Volta, men det var inte förrän Turing - generationen GPU: er inklusive RTX 2080 - som konsumenterna kunde köpa in sig i den nya tekniken. Nvidia har fortsatt att expandera på Tensor-kärnor med sin Ampere-arkitektur, med i RTX 3090 och 3080.

Tensorkärnor påskyndar beräkningar av flyttal och heltal, men de är inte byggda lika. Första generationens kärnor på Volta hanterar helt enkelt djupinlärning med FP16, medan andra generationens kärnor stöder FP32 till FP 16, såväl som INT8 och INT4. Med de senaste tredje generationens kärnor, med på RTX 30-seriens GPU: er, introducerade Nvidia Tensor Float 32, som fungerar identiskt med FP32 samtidigt som den snabbar upp A.I. arbetsbelastning med upp till 20 gånger.

För dessa kärnor handlar det inte om antalet, utan snarare vilken generation de kommer från. Mellan RTX 20-serien och 30-seriens GPU: er är 30-seriens kort bättre utrustade här. Vi föreställer oss att det kommer att bli mer komplicerat med tiden - Tensor-kärnor kommer inte någonstans - så om du har råd med en nyare Nvidia GPU är det vanligtvis bäst att hålla fast vid en.

VRAM

Precis som varje dator behöver systemminne behöver varje grafikkort sitt eget dedikerade minne, vanligtvis kallat video Bagge (VRAM) – även om det är en något föråldrad term som har återställts för sin moderna, vardagliga användning. Vanligtvis ser du minne listat i gigabyte GDDR följt av ett nummer som anger dess generation. De senaste grafikkorten sträcker sig från 4 GB GDDR4 till 24 GB GDDR6X, även om det även finns befintliga grafikkort med GDRR5. En annan minnestyp, kallad minne med hög bandbredd (HBM, HBM2 eller 2e), erbjuder högre prestanda till en högre kostnad och värmeeffekt.

VRAM är ett viktigt mått på ett grafikkorts prestanda, men i mindre utsträckning än kärnantalet. Det påverkar mängden information som kortet kan cache redo för bearbetning, vilket gör det avgörande för högupplösta texturer och andra detaljer i spelet. Om du planerar att spela medelstora inställningar i 1080p så räcker det med 4 GB VRAM för de flesta spel, men om du vill sparka upp saker och ting kommer det att bli kort.

Om du vill spela med texturer med högre upplösning och högre upplösningar ger 12 GB VRAM dig mycket mer takutrymme, och det är mycket mer framtidssäkert – perfekt när nästa generations konsolspel börjar ta steget till PC. Allt utöver 12 GB är reserverat för de mest avancerade korten och är egentligen bara nödvändigt om du vill spela eller videoredigera på 4K eller högre upplösningar.

GPU och minnes klockhastighet

Den andra biten i GPU-prestandapusslet är klockhastigheten för både kärnorna och minnet. Det här är hur många kompletta beräkningscykler kortet kan göra varje sekund, och det är där varje lucka i kärnan eller minnesantalet kan stängas, i vissa fall betydligt. Det är också där de som vill överklocka sitt grafikkort har störst inverkan.

Klockhastigheten anges vanligtvis i två mått: basklocka och boostklocka. Den förra är den lägsta klockhastighet kortet ska köras med, medan boostklockan är vad det kommer att försöka köra med när det är hårt beskattat. Det kan dock hända att värme- och effektkraven inte tillåter den att nå den klockan ofta eller under längre perioder. Av denna anledning specificerar AMD-kort också en spelklocka, som är mer representativ för den typiska klockhastigheten du kan förvänta dig att nå när du spelar.

Ett bra exempel på hur klockhastighet kan göra skillnad är med RTX 2080 Super och 2080 Ti. Där den 2080 Ti har nästan 50 % fler kärnor än 2080 Super, den är bara 10 % till 30 % långsammare, beroende på spelet. Det beror mest på den 300MHz+ högre klockhastighet som de flesta 2080 Supers har över 2080 Ti.

Snabbare minne hjälper det också. Minnesprestanda handlar om bandbredd, som beräknas genom att kombinera minnets hastighet med dess totala mängd. Den snabbare GDDR6X i RTX 3080 hjälper till att förbättra dess totala bandbredd bortom RTX 2080 och RTX 2080 Ti med cirka 20 %. Det finns dock ett tak av användbarhet med kort som AMD Radeon VII erbjuder enorm bandbredd men lägre spelprestanda än ett kort som 3080.

När det kommer till att köpa ett grafikkort, bör klockhastigheter mestadels övervägas efter att du har valt en modell. Vissa GPU-modeller har fabriksöverklockningar som kan höja prestandan med några procentenheter jämfört med konkurrenterna. Om det finns bra kylning kan det vara betydande.

Kylning och kraft

Ett kort är bara så kraftfullt som dess kylning och kraftuttag tillåter. Om du inte håller ett kort inom säkra driftstemperaturer kommer det att strypa dess klockhastighet, och det kan innebära betydligt sämre prestanda. Det kan också leda till högre ljudnivåer då fläktarna snurrar snabbare för att försöka kyla den. Även om kylare varierar enormt från kort till kort och tillverkare till tillverkare, är en bra tumregel att de med större kylflänsar och fler och större fläktar tenderar att kylas bättre. Det betyder att de kör tystare och ofta snabbare.

Det kan också öppna upp utrymme för överklockning om det intresserar dig. Eftermarknadskylningslösningar, som större kylflänsar och vattenkylning i extrema fall, kan göra att korten blir ännu tystare och svalare. Observera att det är mycket mer komplicerat att byta kylare på en GPU än vad det är på en CPU.

Om du spelar in hörlurar, låg bruskylning kanske inte är lika bekymmersam, men det är ändå något som är värt att tänka på när du bygger eller köper din dator.

När det gäller ström, fokusera på om din PSU har tillräckligt med watt för att stödja ditt nya kort. RealHardTechX har ett bra diagram för att ta reda på det. Du måste också se till att din PSU har rätt kablar för kortet du planerar att köpa. Det finns adaptrar som kan göra jobbet, men de är inte lika stabila, och om du behöver använda en är det ett gott tecken på att din PSU inte klarar uppgiften.

Om du behöver en ny PSU är det här våra favoriter.

Med allt annat i beaktande kan budget vara den viktigaste faktorn. Hur mycket ska du egentligen spendera på en GPU? Detta är olika för alla, beroende på hur du planerar att använda det och vad din budget är.

Tyvärr har de senaste åren inte varit en bra tid att handla ett grafikkort. På grund av den pågående GPU-bristen är de bästa grafikkorten på marknaden enormt överprissatta. Som sådan kommer GPU sannolikt att vara den dyraste komponenten i din PC med stor marginal. Som sagt, här är några generaliseringar:

- För ingångsnivå, oberoende spel och äldre spel kan grafik ombord räcka. Annars kommer upp till 200 $ på ett dedikerat grafikkort att ge dig något bättre bildhastigheter och detaljinställningar.

- För solida 60-plus fps 1080p-spel i esports-spel och äldre AAA-spel, räkna med att spendera runt $300 till $500.

- För moderna AAA-spel på 1080p eller 1440p överallt annars behöver du troligen spendera närmare $500 till $800.

- Mer än 60 fps vid 1440p i vilket spel som helst eller raytracing på ingångsnivå i stödjande spel kostar dig $800 till $1.200.

- 4K-spel, eller det mest extrema av spelsystem, kan kosta så mycket du är villig att spendera, men någonstans mellan $1 500 och $2 500 är troligt.

Både Intel och AMD tillverkar processorer som innehåller grafikkärnor på samma chip, vanligtvis kallade integrerade grafikprocessorer (IGP) eller inbyggd grafik. De är mycket svagare än dedikerade grafikkort och ger vanligtvis bara prestanda på basnivå för lågupplösning och detaljspel. Det finns dock några som är bättre än andra.

Många nuvarande generationens Intel-processorer inkluderar UHD 700-seriens grafik, vilket gör vissa low-end-spel nästan spelbara vid låga inställningar. Tidigare generations processorer var utrustade med Intel UHD 600-serien, som vi har testat mycket. I våra tester fann vi att UHD 620 kan spela spel som World of Warcraft och Battlefield 4 vid låga inställningar vid 768p-upplösning, men den bröt inte 60 fps, och 1080p-prestandan var betydligt lägre - knappt spelbar.

11-generations grafik, som finns på Intels 10:e generationens Ice Lake-processorer, är mycket mer kapabel. CPU: er utrustade med den tekniken kan spela spel som CS: GÅ vid lägre inställningar vid 1080p. Anandtechs testning fann att en 64 exekveringsenhet GPU ombord på Core i7-1065G7 i en Dell XPS 13 klarade över 43 fps i DotA 2 vid entusiastinställningar vid 1080p upplösning. Vi fann det som ett fungerande chip för att spela Fortnite på 720p och 1080p också.

Intels 11:e generation Tiger Lake processorer är ännu mer kapabla. Även om det är långt ifrån en dedikerad GPU, kunde vår Tiger Lake testmaskin nå 51 fps i Battlefield V och 45 fps in Civilisation VI vid 1080p med medium inställningar. Det faktum att vi till och med kunde drömma om 60 fps in Battlefield V på integrerad grafik var häpnadsväckande.

De nyare Ryzen 5000G-processorerna har också inbyggd grafik, och de är imponerande. Enligt vissa riktmärken är Ryzen 7 5700G utrustad med en av de snabbaste integrerade GPU: erna någonsin och är helt tillräcklig för en mindre krävande spelare.

Hur pass tuffa som dessa spelupplevelser är, men du hittar en mycket rikare, smidigare upplevelse med högre detaljstöd och högre bildhastigheter på ett dedikerat grafikkort.

Redaktörens rekommendationer

- Jag har granskat varje GPU under de senaste 2 åren - det här är de enda du bör köpa

- Varför denna två år gamla GPU fortfarande är den du bör köpa

- Hur Intel kunde använda AI för att ta itu med ett stort problem inom PC-spel

- Ska du köpa Nvidias RTX 4060 eller RTX 4060 Ti?

- Hur vi testar PC-komponenter och hårdvara