Google Glass przeniosło inteligentne okulary ze świata naukowców z kucykami i marzycieli z Doliny Krzemowej do głównego nurtu rzeczywistości. Ma dziesiątki aplikacji. Posiada nowe wzory od Oakley i Ray-Ban. Ma fanów, którzy obejmują jedno i drugie modele pasów startowych I Koszykarze.

A jeśli jesteś w głośnym pokoju, jest to prawie tak samo bezwartościowe, jak i geekowskie. Ponieważ rozmowa z gadżetami nie jest tak płynna, jak zauważył David Hasselhoff Rycerz Jeździec.

Polecane filmy

Jasne, możesz w zaciszu swojego salonu szczeknąć „Szkło, zrób zdjęcie” i pstryknąć Panu Meowserowi, nie odstawiając herbaty. Ale wypróbowanie tego samego w tętniącym życiem barze to pewny sposób na zirytowanie ludzi wokół ciebie – i być może pobicie. Tymczasem dotykowy pad Glassa obsługuje tylko kilka podstawowych funkcji.

Szybko rozwijająca się technologia smartglass może również pomóc w ożywieniu dość letargicznego kroku ARI.

„Smartfon wkracza w Twoją wizję i potrzebny jest nowy interfejs, który będzie ewoluował wraz z nowym sprzętem” – mówi współzałożyciel Ryan Fink. „W tym miejscu wkracza ARI.”

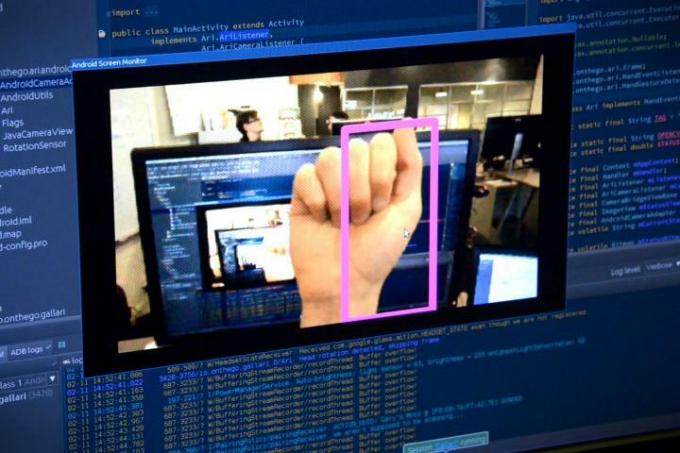

ARI, skrót od Augmented Reality Interface, nie wymaga przycisków, touchpadów ani mówienia. „ARI to Siri rozpoznawania gestów w inteligentnych okularach” – wyjaśnia Fink.

Trzymaj pięść przed twarzą (jak dawny bokser szukający walki), a w Google Glass nałoży się na nią ramka. Po rozpoznaniu tego jako polecenia ARI odlicza 3 sekundy, abyś mógł odsunąć rękę, a następnie robi zdjęcie. Po zebraniu kilku możesz machnięciem ręki przeglądać bibliotekę zdjęć Glassa, tak jakbyś przewracał niewidoczne strony w albumie fotograficznym.

To tylko jedno zastosowanie. Zespół ma nadzieję, że ostatecznie ARI będzie w stanie rozpoznać całą bibliotekę gestów, które zewnętrzni programiści będą mogli wbudować w swoje aplikacje jako elementy sterujące. Na przykład aplikacja Pandora może pewnego dnia zinterpretować dosłowne kciuki w górę jako zgodę na jam Whitesnake, który właśnie odtwarzano na Twojej stacji z lat 80.

Nowy sposób kontrolowania Google Glass

Fink i współzałożyciel Gary Peck widzą to poza tym, że są mniej irytujące niż mówienie do okularów jako niezbędny sposób kontrolowania szkła w scenariuszach, w których w przeciwnym razie nigdy by nie zadziałał, np. w fabryce podłoga.

„Jest naprawdę głośno, czasami mają coś w rękach i chcą mieć możliwość łatwej interakcji z treścią lub sprawdzania rzeczy w trakcie wykonywania” – wyjaśnia Fink. Dzięki ARI pracownik może po prostu machnąć ręką, aby przesunąć wyświetlacz w okularach na następną instrukcję na liście lub podnieść pięść, aby oznaczyć, że zostało to wykonane.

To samo tyczy się sportowców. Snowboardzista w grubych rękawiczkach może mieć trudności z przesuwaniem palca po touchpadzie, a rowerzysta może nie chcieć odrywać rąk od kierownicy, aby uruchomić stoper.

„Myślę, że na początku będzie to trochę dziwne, szczególnie dla osób, które nie są zaznajomione z tą technologią”.

Teoretycznie ARI rozwiązuje wszystkie te problemy. W wykonaniu jest jeszcze mnóstwo niedociągnięć do naprawienia. Testowana przez nas wczesna wersja alfa potrzebowała trochę czasu, aby rozpoznać gesty, a wykonanie machnięcia lub pięści w sposób, w jaki ARI chce to zobaczyć, wymaga celowego wykonania.

Jednak szybko rozwijająca się technologia smartglass może również pomóc w ożywieniu dość letargicznego kroku ARI. Ponieważ stale analizuje obrazy z wbudowanej kamery Glass, ARI nie może działać na Twoim telefonie; musi działać na anemicznym procesorze wbudowanym w Glass. W miarę jak te procesory stają się szybsze, zwiększa się także szybkość ARI.

Aparat Glassa również pozostaje wyzwaniem – ponieważ jest tylko jeden. Specjalnie zaprojektowane systemy kontroli gestów, takie jak Kinect firmy Microsoft, wykorzystują parę kamer do generowania obrazów stereo, co pozwala komputerowi odczytującemu Twoje maniakalne ruchy określić głębię. „Dzięki dwóm kamerom naprawdę masz przed sobą trójwymiarowy model świata. W przypadku pojedynczego aparatu jest to po prostu zwykły obraz” – wyjaśnia Peck. „Nie masz pojęcia, że ta dłoń to inny przedmiot niż stół, to tylko różne piksele.” Peck musiał obejść te prymitywne dane wejściowe, aby wykryć obiekty na podstawie samego ich wyglądu.

Wyzwanie jest jeszcze trudniejsze ze względu na potrzebę zachowania ograniczonej żywotności baterii Google Glass: im dokładniejsze wykrywanie gestów, tym bardziej wyczerpuje baterię. „To jest kompromis” – powiedział Peck. „Jak uzyskać dokładność wystarczającą dla gestów, które próbujesz wykonać?” Na przykład jego kod wykorzystuje niską rozdzielczość wideo z wbudowanej kamery, chociaż technicznie rzecz biorąc, może ona przechwytywać wideo w rozdzielczości 1080p — ponieważ nie próbuje on śledzić każdego palec.

Nie można tu również zignorować czynnika maniaka: jak nakłonić ludzi do korzystania z technologii, która sprawia, że wyglądasz jak najgorszy mim na świecie? „Myślę, że na początku będzie to trochę dziwne, szczególnie dla osób niezaznajomionych z tą technologią” – przyznaje Fink, ale upiera się, że postrzeganie będzie się zmieniać wraz z ulepszaniem technologii. „Będzie znacznie bardziej podobnie Człowiek z żelaza Lub Raport mniejszości, gdzie jest to wciągające doświadczenie. Myślę więc, że piętno związane z tym, że jest to dziwne i niezręczne, zniknie wraz z tym”.

Przyszłość inteligentnych okularów i rzeczywistości rozszerzonej pozostaje niejasna.

Jednym z największych kroków naprzód będą „soczewki falowodowe”. Podczas gdy Glass jedynie wyświetla mały strumień wideo w rogu pola widzenia, soczewki falowodowe mogą dosłownie nakładać informacje na całe pole widzenia, niczym prawdziwy Terminator okulary. Vuzix wyprodukował wczesne prototypy tej technologii i kilka drogich modeli przeznaczonych dla środowisk przemysłowych, ale nie zmniejszyły się one jeszcze do rozmiaru i ceny Google Glass. Peck uważa, że minie co najmniej kolejny rok, zanim wyświetlacze na takim poziomie dotrą do głównego nurtu.

Przyszłość inteligentnych okularów i rzeczywistości rozszerzonej pozostaje niejasna, ale nieznane kolejne kroki pozostają częścią atrakcyjności Pecka i Finka.

„To nowy paradygmat interakcji. Trzeba wiele przemyśleć – jak przedstawić informacje w najbardziej intuicyjny sposób? Jak z nim współdziałasz? Peck wyjaśnia. „Ale dla twórcy aplikacji nie ma żadnych konwencji. Nie ma wiedzy na temat najlepszego sposobu prezentowania informacji wyświetlanych na ekranie. To dość ciekawe wyzwania.”

Zalecenia redaktorów

- Trendy cyfrowe na żywo: nowe szkło Google, Impossible Sausage i nie tylko

Ulepsz swój styl życiaDigital Trends pomaga czytelnikom śledzić szybko rozwijający się świat technologii dzięki najnowszym wiadomościom, zabawnym recenzjom produktów, wnikliwym artykułom redakcyjnym i jedynym w swoim rodzaju zajawkom.