Policja predykcyjna miał zmienić sposób prowadzenia działań policyjnych, wprowadzając nas do świata inteligentnego prawa egzekwowanie prawa, w ramach którego usunięto stronniczość, a policja byłaby w stanie reagować na dane, a nie na nie przeczucia. Jednak dziesięć lat po tym, jak większość z nas po raz pierwszy usłyszała termin „policja predykcyjna”, wydaje się jasne, że to nie zadziałało. Pod wpływem reakcji opinii publicznej technologia ta odnotowuje znaczny spadek wykorzystania tej technologii w porównaniu z zaledwie kilka lat temu.

Zawartość

- Obietnica predykcyjnej policji

- Algorytmy dyskryminacyjne

- Niebezpieczeństwa związane z brudnymi danymi

- Niepewna przyszłość predykcyjnej policji

- Nieodpowiednie narzędzia do pracy?

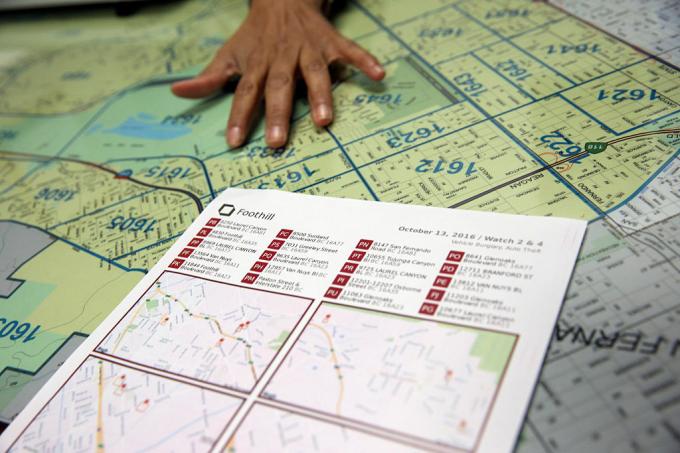

W kwietniu tego roku Los Angeles – które według LA Times „pionierem przewidywania przestępczości na podstawie danych” – obcięło fundusze na swój program predykcyjnej policji, zrzucając winę na koszty. „To trudna decyzja” – powiedział szef policji Michel Moore

powiedział „Los Angeles Times”.. „To strategia, którą zastosowaliśmy, ale szacunkowy koszt to setki tysięcy dolarów, które można na nią wydać teraz muszę zrobić więcej niż znalezienie tych pieniędzy i skierowanie ich na inne, bardziej centralne działania”.Polecane filmy

Co poszło nie tak? W jaki sposób coś reklamowanego jako „inteligentna” technologia może jeszcze bardziej utrwalić uprzedzenia i dyskryminację? Czy marzenie o predykcyjnej policji, którą można ulepszyć za pomocą odpowiedniego algorytmu, czy też jest ślepą uliczką w bardziej sprawiedliwym społeczeństwie, które obecnie zmaga się z tym, jak powinna działać policja?

Obietnica predykcyjnej policji

Początki policji predykcyjnej w jej obecnej formie sięgają około dekady wstecz, od opublikowanego w 2009 roku artykułu psychologa Colleen McCue i szefa policji Los Angeles Charliego Becka, zatytułowanego „Predykcyjne działania policji: czego możemy się nauczyć od Walmartu i Amazona na temat walki z przestępczością w czasie recesji?W artykule omówiono sposób, w jaki główni sprzedawcy detaliczni wykorzystują duże zbiory danych do odkrywania wzorców w przeszłych zachowaniach klientów, które można wykorzystać do przewidywania przyszłych zachowań. Dzięki postępowi w informatyce i gromadzeniu danych McCue i Beck zasugerowali, że możliwe jest gromadzenie i analizowanie danych dotyczących przestępstw w czasie rzeczywistym. Dane te można następnie wykorzystać do przewidywania przestępstw, które jeszcze nie miały miejsca, zapobiegania im i skuteczniejszego reagowania na nie.

Od tego czasu policja predykcyjna przestała być jednorazowym pomysłem i stała się rzeczywistością w wielu częściach Stanów Zjednoczonych, a także w pozostałej części świata. W ramach tego procesu Komisja postanowiła zmienić siły policyjne z sił reaktywnych w siły proaktywne; w oparciu o niektóre przełomowe technologie oparte na danych, które umożliwiają wykrywanie wzorców w czasie rzeczywistym i reagowanie na nie.

„Istnieją dwie główne formy predykcyjnej policji” Andrzeja Fergusona, profesor prawa na Uniwersytecie Dystryktu Kolumbii David A. Clarke School of Law i autorka Powstanie policji zajmującej się dużymi zbiorami danych: nadzór, rasa i przyszłość egzekwowania prawa, powiedział Digital Trends. „[Są to] policja predykcyjna oparta na miejscu i policja predykcyjna oparta na osobach”.

W obu przypadkach predykcyjne systemy policyjne przypisują danej osobie lub miejscu ocenę ryzyka, co zachęca policję do podejmowania działań następczych w określonych odstępach czasu. Pierwsze z tych podejść, predykcyjne działania policji oparte na miejscu, koncentruje się głównie na patrolach policyjnych. Polega na wykorzystaniu mapowania przestępczości i analiz dotyczących prawdopodobnych miejsc przyszłych przestępstw, w oparciu o wcześniejsze statystyki.

Zamiast pomagać w pozbyciu się problemów, takich jak rasizm i inne uprzedzenia systemowe, policja predykcyjna może w rzeczywistości pomóc w ich utrwaleniu.

Drugie podejście skupia się na przewidywaniu prawdopodobieństwa, że dana osoba stwarza potencjalne przyszłe ryzyko. Na przykład w 2013 roku komendant policji w Chicago został wysłany do domu 22-letniego Roberta McDaniela, który został oznaczony jako potencjalne ryzyko lub sprawca przemocy z użyciem broni w centrum Chicago przez: algorytm. „Lista ciepła”, którą algorytm pomógł stworzyć, szukała wzorców, które mogłyby pomóc przewidzieć przyszłych przestępców lub ofiar, nawet jeżeli one same nie zrobiły nic, co uzasadniałoby tę kontrolę, poza przestrzeganiem art profil.

jako – zauważyła „Chicago Tribune”.: „Strategia wzywa do indywidualnego ostrzegania osób znajdujących się na liście przeterminowanych, że dalsza działalność przestępcza, nawet w przypadku najdrobniejszych wykroczeń, spowoduje obniżenie pełnej mocy prawa ich."

Marzeniem predykcyjnej policji było to, że działając na wymiernych danych, sprawi ona, że policja będzie nie tylko skuteczniejsza, ale także mniej podatna na domysły, a w rezultacie na stronniczość. Zwolennicy twierdzili, że zmieni to policję na lepsze i zapoczątkuje nową erę inteligentnej policji. Jednak niemal od samego początku zapobiegawcze działania policji spotkały się z zagorzałymi krytykami. Twierdzą, że zamiast pomagać w pozbyciu się problemów, takich jak rasizm i inne uprzedzenia systemowe, policja predykcyjna może w rzeczywistości pomóc w ich utrwaleniu. I trudno zaprzeczyć, że nie mają racji.

Algorytmy dyskryminacyjne

Pomysł, że predykcyjne systemy policyjne oparte na uczeniu maszynowym mogą nauczyć się dyskryminacji ze względu na takie czynniki jak rasa, nie jest niczym nowym. Narzędzia do uczenia maszynowego są szkolone przy użyciu ogromnych porcji danych. Dopóki dane te są gromadzone w systemie, w którym rasa nadal stanowi dominujący czynnik, może to prowadzić do dyskryminacji.

Jak Renata M. O’Donnell pisze w artykule z 2019 r. zatytułowanym „Kwestionowanie rasistowskich, predykcyjnych algorytmów policji w ramach klauzuli równej ochrony”, algorytmy uczenia maszynowego uczą się na podstawie danych pochodzących z wymiaru sprawiedliwości, w którym „czarni Amerykanie są osadzani w więzieniach stanowych w tempie czyli 5,1 razy więcej niż wynosi kara pozbawienia wolności w przypadku rasy białej, a co trzeci urodzony dzisiaj czarny mężczyzna może spodziewać się, że w ciągu swojego życia pójdzie do więzienia, jeśli panować będą tendencje Kontynuować."

„Dane nie są obiektywne” – Ferguson powiedział Digital Trends. „To po prostu my zredukowani do kodu binarnego. Systemy oparte na danych działające w świecie rzeczywistym nie są bardziej obiektywne, sprawiedliwe i bezstronne niż świat rzeczywisty. Jeśli Twój prawdziwy świat jest strukturalnie nierówny lub dyskryminujący rasowo, system oparty na danych będzie odzwierciedlał te nierówności społeczne. Dane wejściowe są skażone stronniczością. Analiza jest skażona stronniczością. A mechanizmy władzy policyjnej nie zmieniają się tylko dlatego, że systemami kieruje technologia”.

Ferguson podaje przykład aresztowań jako pozornie obiektywnego czynnika przewidywania ryzyka. Jednakże aresztowania będą zależne od przydziału zasobów policji (np. miejsca patrolowania) oraz rodzajów przestępstw, które zazwyczaj uzasadniają aresztowania. To tylko jedna ilustracja potencjalnie problematycznych danych.

Niebezpieczeństwa związane z brudnymi danymi

Brakujące i nieprawidłowe dane są czasami określane w eksploracji danych jako „brudne dane”. A Artykuł z 2019 r. autorstwa naukowców z A.I. Teraz Instytut na Uniwersytecie Nowojorskim rozszerza ten termin, aby odnosił się również do danych, na które mają wpływ korupcja, stronniczość i niezgodność z prawem praktyk — niezależnie od tego, czy wynikają one z celowej manipulacji, czy zniekształcenia przez jednostkę uprzedzenia społeczne. Mogłyby one na przykład obejmować dane uzyskane w wyniku aresztowania niewinnej osoby, której podstawiono dowody lub która została w inny sposób fałszywie oskarżona.

Pewną ironią jest fakt, że w ciągu ostatnich dziesięcioleci wymagania społeczeństwa danych, w którym wszystko kręci się wokół kwantyfikacji i konkretnych celów liczbowych, doprowadziło właśnie do wielu… cóż, naprawdę złe dane. Serial HBO Drut pokazało rzeczywiste zjawisko „oszukiwania statystyk”, a lata, które upłynęły od emisji programu, dostarczyły wielu przykłady faktycznej manipulacji danymi systemowymi, sfałszowanych raportów policyjnych i niekonstytucyjnych praktyk, do których skierowano niewinne osoby więzienie.

Złe dane, które umożliwiają osobom sprawującym władzę sztuczne uderzanie w cele, to jedno. Ale połącz to z algorytmami i modelami predykcyjnymi, które wykorzystują to jako podstawę do modelowania świata, a potencjalnie otrzymasz coś znacznie gorszego.

Badacze wykazali, jak wątpliwe dane dotyczące przestępczości podłączone do predykcyjnych algorytmów policyjnych mogą stworzyć coś, co nazywa się „niekontrolowane pętle sprzężenia zwrotnego”, w którym policja jest wielokrotnie wysyłana do tych samych dzielnic, niezależnie od rzeczywistego wskaźnika przestępczości. Jeden ze współautorów tej pracy, informatyk Suresh Venkatasubramanian, twierdzi, że modele uczenia maszynowego mogą opierać się na błędnych założeniach poprzez modelowanie. Podobnie jak w starym powiedzeniu o tym, że dla osoby z młotkiem każdy problem wygląda jak gwóźdź, systemy te modelują tylko pewne elementy problemu i wyobrażają sobie tylko jeden możliwy wynik.

„[Coś, czego] nie uwzględniono w tych modelach, to w jakim stopniu modelujesz fakt, że rzucanie większej liczby gliniarzy na dany obszar może w rzeczywistości obniżyć jakość życia ludzi, którzy tam mieszkają?” Venkatasubramanian, profesor w School of Computing na Uniwersytecie Utah, powiedział Digital Trendy. „Zakładamy, że więcej policjantów to lepsza rzecz. Ale jak teraz widzimy, zwiększenie liczby policji niekoniecznie jest dobrą rzeczą. To faktycznie może pogorszyć sytuację. W żadnym modelu, jaki kiedykolwiek widziałem, nikt nie zapytał, jaki jest koszt umieszczenia większej liczby policji na danym obszarze.

Niepewna przyszłość predykcyjnej policji

Osoby pracujące w policji predykcyjnej czasami bez ironii używają terminu „raport mniejszości” w odniesieniu do rodzaju przewidywań, które przeprowadzają. Termin ten jest często przywoływany w odniesieniu do tzw Film z 2002 roku pod tym samym tytułem, który z kolei był luźno oparty na opowiadaniu Philipa K. Kutas. W Raport mniejszości, specjalny wydział policji PreCrime zatrzymuje przestępców na podstawie wcześniejszej wiedzy o przestępstwach, które zostaną popełnione w przyszłości. Prognozy te są dostarczane przez trzech jasnowidzów zwanych „prekogami”.

Ale zwrot akcji Raport mniejszości jest to, że przewidywania nie zawsze są dokładne. Odmienne wizje jednego z jasnowidzów zapewniają alternatywny pogląd na przyszłość, który jest ukrywany w obawie, że system będzie wyglądał na niegodny zaufania.

Audyty wewnętrzne, które pokazują, że taktyka nie zadziałała. Listy predykcyjne były nie tylko wadliwe, ale także nieskuteczne.

W tej chwili policja predykcyjna stoi przed swoją niepewną przyszłością. Oprócz nowych technologii, takich jak rozpoznawanie twarzy, technologia dostępna organom ścigania do potencjalnego wykorzystania nigdy nie była tak potężna. Jednocześnie świadomość stosowania policji predykcyjnej wywołała reakcję społeczną, która mogła w rzeczywistości pomóc ją stłumić. Ferguson powiedział Digital Trends, że w ciągu ostatnich kilku lat wykorzystanie predykcyjnych narzędzi policyjnych „spadało”.

„W szczytowym okresie [policja predykcyjna ukierunkowana na miejsce] działała w ponad 60 dużych miastach i rozwijała się, ale w wyniku skuteczne organizowanie społeczności, zostało ono w dużej mierze ograniczone i/lub zastąpione innymi formami opartymi na danych analityczne” – powiedział. „Krótko mówiąc, termin „policja predykcyjna” stał się toksyczny, a wydziały policji nauczyły się zmieniać nazwę tego, co robią z danymi. Większy spadek nastąpił w przypadku policji opartej na prognozowaniu opartym na osobach. Dwa główne miasta, które zainwestowały w jego utworzenie – Chicago i Los Angeles – wycofały się z finansowania osobistego strategii po ostrej krytyce społeczności i druzgocących audytach wewnętrznych, które wykazały, że taktyka nie sprawdziła się praca. Listy predykcyjne były nie tylko wadliwe, ale także nieskuteczne”.

Nieodpowiednie narzędzia do pracy?

Jednakże, Rashida Richardson, dyrektor ds. badań nad polityką w A.I. Instytut stwierdził, że istnieje zbyt wiele niejasności w kwestii wykorzystania tej technologii. „Nadal nie wiemy, ze względu na brak przejrzystości w zakresie przejmowania technologii przez rząd i wielu innych luki w istniejących procedurach udzielania zamówień, które mogą chronić niektóre zakupy technologii przed kontrolą publiczną”, powiedziała. Podaje przykład technologii, którą można bezpłatnie przekazać policji lub kupić od osoby trzeciej. „Z badań takich jak moje i doniesień medialnych wiemy, że wiele największych wydziałów policji w USA korzystało z tego narzędzia technologii w pewnym momencie, ale istnieje również wiele małych wydziałów policji, które z niej korzystają lub korzystają z niej przez ograniczony okres czasu czasu."

Czy biorąc pod uwagę obecne pytania dotyczące roli policji, pojawi się pokusa, aby ponownie ją przyjąć? Policja predykcyjna jako narzędzie do podejmowania decyzji w oparciu o dane – być może w mniej dystopijnym science fiction branding? Istnieje możliwość pojawienia się takiego odrodzenia. Jednak Venkatasubramanian jest bardzo sceptyczny, czy uczenie maszynowe w obecnej formie jest właściwym narzędziem do tego zadania.

„Całość uczenia maszynowego i jego sukces we współczesnym społeczeństwie opiera się na założeniu, że niezależnie od tego, co jest rzeczywiste problemu, ostatecznie sprowadza się to do zebrania danych, zbudowania modelu, przewidzenia wyniku – i nie musisz się martwić o domenę” powiedział. „Możesz napisać ten sam kod i zastosować go w 100 różnych miejscach. To obietnica abstrakcji i przenośności. Problem polega na tym, że kiedy używamy tego, co ludzie nazywają systemami społeczno-technicznymi, w których ludzie i technologia splatają się w skomplikowane fale, nie można tego zrobić. Nie można po prostu podłączyć jakiegoś elementu i oczekiwać, że będzie działać. Ponieważ [istnieją] skutki uboczne włożenia tego elementu i fakt, że są różne graczami o różnych celach w takim systemie i wywracają system do własnych potrzeb różne sposoby. Kiedy mówisz o skuteczności, należy wziąć pod uwagę wszystkie te rzeczy. Tak, można abstrakcyjnie powiedzieć, że wszystko będzie działać dobrze, ale tak Jest żadnego abstraktu. Istnieje tylko kontekst, w którym pracujesz.