Wyobraź sobie tacę. Na tacy znajduje się asortyment kształtów: niektóre kostki, inne kule. Kształty są wykonane z różnych materiałów i reprezentują asortyment rozmiarów. W sumie jest może osiem obiektów. Moje pytanie: „Patrząc na przedmioty, czy jest równa liczba dużych rzeczy i metalowych kul?”

Zawartość

- Powstanie i upadek symbolicznej sztucznej inteligencji

- Świat sieci neuronowych

- Płonące światła drogowe

- Uzupełniające się pomysły

- sztuczna inteligencja badania: następne pokolenie

To nie jest podchwytliwe pytanie. Fakt, że brzmi to tak, jakby tak było, jest dowodem na to, jak proste jest to w rzeczywistości. Jest to rodzaj pytania, na które przedszkolak najprawdopodobniej z łatwością mógłby odpowiedzieć. Jednak w przypadku dzisiejszych najnowocześniejszych sieci neuronowych jest to prawie niemożliwe. To musi się zmienić. Musi się to stać poprzez wynalezienie na nowo sztucznej inteligencji, jaką znamy.

Polecane filmy

To nie jest moja opinia; to opinia Davida Coxa, dyrektor MIT-IBM Watson A.I. Laboratorium w Cambridge, MA. W poprzednim życiu Cox był profesorem na Uniwersytecie Harvarda, gdzie jego zespół wykorzystał spostrzeżenia z neurologii, aby pomóc w tworzeniu lepszych systemów komputerowych uczących się maszynowo, inspirowanych mózgiem. Na swoim obecnym stanowisku w IBM nadzoruje wyjątkowe partnerstwo pomiędzy MIT i IBM, którego celem jest rozwój sztucznej inteligencji. badania, w tym IBM Watson A.I. platforma. Watson, dla tych, którzy nie wiedzą, był AI. który w słynny sposób pokonał dwóch czołowych graczy teleturniejów

historii w teleturnieju Niebezpieczeństwo. Tak się składa, że Watson to także system oparty głównie na uczeniu maszynowym, szkolony przy użyciu mas danych, a nie reguł opracowanych przez człowieka.

Kiedy więc Cox mówi, że świat musi ponownie przemyśleć kwestię sztucznej inteligencji, wkraczając w nową dekadę, brzmi to trochę dziwnie. W końcu rok 2010 był prawdopodobnie najbardziej udanym dziesięcioleciem w dziedzinie sztucznej inteligencji. Historia: Okres, w którym przełomy zdarzają się pozornie co tydzień i bez mroźnej nuty sztuczna inteligencja zima wgląd. Właśnie dlatego uważa, że A.I. musi się jednak zmienić. A jego sugestia dotycząca tej zmiany, obecnie mało znany termin zwany „neurosymboliczną sztuczną inteligencją”, może równie dobrze stać się jednym z tych wyrażeń, które będziemy dokładnie zaznajomieni do końca lat 20. XX wieku.

Powstanie i upadek symbolicznej sztucznej inteligencji

Neuro-symboliczna sztuczna inteligencja nie jest, ściśle rzecz biorąc, całkowicie nowym sposobem wykorzystania sztucznej inteligencji. Jest to połączenie dwóch istniejących podejść do budowania myślących maszyn; tych, z którymi kiedyś walczyli jako śmiertelni wrogowie.

„Symboliczna” część nazwy nawiązuje do pierwszego głównego nurtu podejścia do tworzenia sztucznej inteligencji. Od lat pięćdziesiątych do osiemdziesiątych XX wieku symboliczna A.I. rządził najwyżej. Do symbolicznej A.I. badacza inteligencja opiera się na zdolności człowieka do rozumienia otaczającego go świata poprzez tworzenie wewnętrznych reprezentacji symbolicznych. Następnie tworzą zasady postępowania z tymi pojęciami, które można sformalizować w sposób uwzględniający potoczną wiedzę.

Shakey the Robot: pierwszy robot ucieleśniający sztuczną inteligencję

Jeśli mózg można porównać do komputera, oznacza to, że każda sytuacja, z którą się spotykamy, zależy od tego, czy wykonamy jakąś pracę wewnętrzny program komputerowy, który krok po kroku wyjaśnia, jak przeprowadzić operację, w całości opartą na logika. Pod warunkiem, że tak jest, symboliczna A.I. badacze uważają, że te same zasady dotyczące organizację świata można by odkryć, a następnie skodyfikować w formie algorytmu dla komputera wynieść.

Symboliczna sztuczna inteligencja zaowocowało kilkoma imponującymi demonstracjami. Na przykład w 1964 roku informatyk Bertram Raphael opracował system o nazwie SIR, co oznacza „Semantyczne wyszukiwanie informacji.” SIR był systemem wnioskowania obliczeniowego, który najwyraźniej był w stanie uczyć się relacji między obiektami w sposób przypominający prawdziwą inteligencję. Gdybyś na przykład powiedział tak: „Jan jest chłopcem; chłopiec jest osobą; osoba ma dwie ręce; dłoń ma pięć palców”, wówczas SIR odpowiedziałby na pytanie: „Ile palców ma Jan?” z poprawną liczbą 10.

„…w ścianie zaczynają pojawiać się niepokojące pęknięcia.”

Systemy komputerowe oparte na symbolicznej sztucznej inteligencji osiągnęły szczyt swojej władzy (i upadek) w latach 80. Była to dekada tak zwanego „systemu eksperckiego”, który próbował wykorzystać systemy oparte na regułach do rozwiązywania rzeczywistych problemów, takich jak pomaganie chemikom organicznym w identyfikacji nieznanych cząsteczek organicznych lub pomaganie lekarzom w zaleceniu właściwej dawki antybiotyków infekcje.

Podstawowa koncepcja tych systemów ekspertowych była solidna. Ale mieli problemy. Systemy były drogie, wymagały ciągłej aktualizacji i, co najgorsze, w miarę włączania większej liczby reguł mogły faktycznie stać się mniej dokładne.

Świat sieci neuronowych

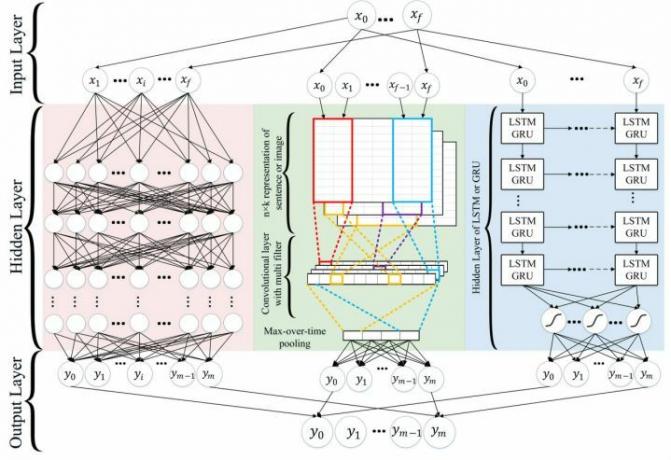

„Neuro” część neurosymbolicznej sztucznej inteligencji. odnosi się do Sieci neuronowe głębokiego uczenia się. Sieci neuronowe to rodzaj obliczeń inspirowany mózgiem, który napędza wiele rozwiązań AI. przełomowe osiągnięcia, jakie miały miejsce w ciągu ostatniej dekady. sztuczna inteligencja które potrafią jeździć samochodami? Sieci neuronowe. sztuczna inteligencja który może przetłumaczyć tekst na dziesiątki różnych języków? Sieci neuronowe. sztuczna inteligencja co pomaga inteligentnemu głośnikowi w Twoim domu rozumieć Twój głos? Sieci neuronowe to technologia, której warto podziękować.

Sieci neuronowe działają inaczej niż symboliczna sztuczna inteligencja. ponieważ opierają się na danych, a nie na regułach. Aby wyjaśnić coś symbolicznej A.I. system oznacza wyraźne dostarczenie mu wszelkich informacji niezbędnych do dokonania prawidłowej identyfikacji. Jako analogię wyobraź sobie, że wysyłasz kogoś, żeby odebrał twoją mamę z dworca autobusowego, ale musisz ją opisać, podając zestaw zasad, które pozwolą Twojemu przyjacielowi wybrać ją z tłumu. Aby wytrenować sieć neuronową, aby to robiła, wystarczy pokazać jej tysiące zdjęć danego obiektu. Gdy stanie się wystarczająco inteligentny, nie tylko będzie w stanie rozpoznać ten obiekt; może tworzyć własne podobne obiekty, które mają tak naprawdę nigdy nie istniała w prawdziwym świecie.

„Z pewnością głębokie uczenie się umożliwiło niesamowity postęp” – David Cox powiedział Digital Trends. „Jednocześnie w ścianie zaczynają być widoczne niepokojące pęknięcia”.

Jeden z tak zwanych pęknięć opiera się dokładnie na tym, co czyni dzisiejsze sieci neuronowe tak potężne: na danych. Podobnie jak człowiek, sieć neuronowa uczy się na przykładach. Ale chociaż człowiek może potrzebować tylko jednego lub dwóch przykładów szkoleniowych obiektu, aby go poprawnie zapamiętać, sztuczna inteligencja będzie wymagało o wiele, wiele więcej. Dokładność zależy od posiadania dużej ilości danych z adnotacjami, dzięki którym może uczyć się każdego nowego zadania.

Płonące światła drogowe

To sprawia, że są mniej dobrzy w statystycznie rzadkich problemach „czarnego łabędzia”. Impreza Czarnego Łabędzia, spopularyzowana przez Nassima Nicholasa Taleba, to przypadek narożny, który jest statystycznie rzadki. „Wiele naszych dzisiejszych rozwiązań do głębokiego uczenia się – choć są niesamowite – to rozwiązania typu 80–20” – kontynuował Cox. „Dobrze poradzą sobie w 80% przypadków, ale jeśli te sprawy narożne mają znaczenie, będą miały tendencję do upadku. Jeśli zobaczysz obiekt, który normalnie nie powinien znajdować się [w określonym miejscu], lub obiekt o nieco dziwnej orientacji, nawet niesamowite systemy ulegną upadkowi”.

Przedstawiamy automaty percepcyjne

Zanim dołączył do IBM, Cox był współzałożycielem firmy, Automaty percepcyjne, która opracowała oprogramowanie dla samochodów autonomicznych. Zespół miał kanał na Slacku, na którym publikował zabawne obrazy, na które natknął się podczas zbierania danych. Na jednym z nich, zrobionym na skrzyżowaniu, widać było płonącą sygnalizację świetlną. „To jeden z tych przypadków, których możesz nigdy nie zobaczyć w swoim życiu” – powiedział Cox. „Nie wiem, czy Waymo i Tesla mają w swoich zbiorach danych zdjęcia płonących sygnalizacji świetlnych trenować swoje sieci neuronowe, ale jestem skłonny się założyć… jeśli w ogóle jakieś mają, to będą mieli tylko bardzo kilka."

Jedną rzeczą jest to, że obudowa narożna jest czymś nieistotnym, ponieważ zdarza się rzadko i nie ma większego znaczenia, kiedy to się dzieje. Uzyskanie złej rekomendacji restauracji może nie być idealnym rozwiązaniem, ale prawdopodobnie nie wystarczy, aby nawet zrujnować Ci dzień. Dopóki poprzednie 99 zaleceń wydanych przez system jest dobrych, nie ma prawdziwego powodu do frustracji. Samochód autonomiczny, który nie reaguje prawidłowo na skrzyżowaniu z powodu płonącej sygnalizacji świetlnej lub powozu konnego, może zrobić o wiele więcej niż tylko zrujnować Ci dzień. Może to być mało prawdopodobne, ale jeśli tak się stanie, chcemy wiedzieć, czy system został zaprojektowany tak, aby móc sobie z tym poradzić.

„Jeśli potrafisz wyciągać wnioski i ekstrapolować wykraczające poza to, co widzieliśmy wcześniej, poradzimy sobie z takimi scenariuszami” – wyjaśnił Cox. „Wiemy, że ludzie to potrafią. Jeśli zobaczę płonące światła drogowe, będę mógł wnieść do pracy mnóstwo wiedzy. Wiem na przykład, że światło nie powie mi, czy mam się zatrzymać, czy odejść. Wiem, że muszę zachować ostrożność, ponieważ [kierowcy wokół mnie będą zdezorientowani.] Wiem, że kierowcy jadący z naprzeciwka mogą zachowywać się inaczej, ponieważ ich światła mogą działać. Potrafię ułożyć plan działania, który zabierze mnie tam, gdzie muszę. W tego rodzaju sytuacjach, w których bezpieczeństwo i misja mają kluczowe znaczenie, nie sądzę, aby głębokie uczenie służyło nam jeszcze doskonale. Dlatego potrzebujemy dodatkowych rozwiązań.”

Uzupełniające się pomysły

Idea neuro-symbolicznej sztucznej inteligencji jest połączenie tych podejść w celu połączenia zarówno uczenia się, jak i logiki. Sieci neuronowe pomogą stworzyć symboliczną sztuczną inteligencję. mądrzejsze systemy, dzieląc świat na symbole, zamiast polegać na ludzkich programistach, którzy zrobią to za nich. Tymczasem symboliczna A.I. Algorytmy pomogą włączyć zdroworozsądkowe rozumowanie i wiedzę dziedzinową do głębokiego uczenia się. Wyniki mogą doprowadzić do znacznych postępów w dziedzinie sztucznej inteligencji. systemy realizujące złożone zadania, dotyczące wszystkiego, od samochodów autonomicznych po przetwarzanie języka naturalnego. A wszystko to przy jednoczesnym wymaganiu znacznie mniejszej ilości danych do treningu.

Wyjaśnienie neurosymbolicznej sztucznej inteligencji

„Sieci neuronowe i idee symboliczne naprawdę wspaniale się uzupełniają” – powiedział Cox. „Ponieważ sieci neuronowe dają odpowiedzi na pytanie, jak przejść od bałaganu prawdziwego świata do symbolicznej reprezentacji świata, znajdując wszystkie korelacje w obrazach. Kiedy już zdobędziesz tę symboliczną reprezentację, możesz dokonać naprawdę magicznych rzeczy, jeśli chodzi o rozumowanie.

Na przykład w przykładzie kształtu, od którego zacząłem ten artykuł, system neurosymboliczny wykorzystywałby możliwości rozpoznawania wzorców sieci neuronowej do identyfikacji obiektów. Wtedy opierałoby się na symbolicznej sztucznej inteligencji. zastosować logikę i rozumowanie semantyczne w celu odkrycia nowych relacji. Takie systemy mają skuteczność została już udowodniona.

Przydałoby się to nie tylko w przypadkach narożnych. Coraz ważniejsze jest, aby A.I. systemy można wyjaśnić w razie potrzeby. Sieć neuronowa może wyjątkowo dobrze wykonywać pewne zadania, ale większość jej wewnętrznego rozumowania jest ukryta w „czarnych skrzynkach”, co sprawia, że są nie do odgadnięcia dla tych, którzy chcą wiedzieć, w jaki sposób podjęła decyzję. Powtórzę: nie ma to większego znaczenia, jeśli jest to bot, który poleca niewłaściwy utwór w Spotify. Jeśli jednak odmówiono Ci kredytu bankowego, odrzucono podanie o pracę lub ktoś doznał obrażeń w wyniku wypadku wypadku z udziałem samochodu autonomicznego, lepiej byłoby, gdybyś był w stanie wyjaśnić, dlaczego sformułowano określone zalecenia zrobiony. To tam neuro-symboliczna sztuczna inteligencja. mógł wejść.

sztuczna inteligencja badania: następne pokolenie

Kilka dekad temu światy symbolicznej sztucznej inteligencji. i sieci neuronowe były ze sobą sprzeczne. Znane postacie, które opowiadały się za tym podejściem, nie tylko wierzyły, że ich podejście jest słuszne; wierzyli, że oznacza to, że drugie podejście jest błędne. Niekoniecznie musieli to zrobić niewłaściwie. Konkurując w rozwiązywaniu tych samych problemów i przy ograniczonych funduszach, obie szkoły sztucznej inteligencji wydawały się zasadniczo sobie przeciwstawne. Dziś wydaje się, że może być odwrotnie.

„To naprawdę fascynujące widzieć młodsze pokolenie” – powiedział Cox. „[Wiele osób w moim zespole to] stosunkowo młodzi ludzie: świezi, podekscytowani, całkiem niedawno po doktoracie. Po prostu nie mają takiej historii. Po prostu nie przejmują się [to, że te dwa podejścia są sobie przeciwne] – a brak troski jest naprawdę potężny, ponieważ otwiera cię i pozbywa się tych uprzedzeń. Chętnie eksplorują skrzyżowania… Chcą po prostu zrobić coś fajnego ze sztuczną inteligencją”.

Jeśli wszystko pójdzie zgodnie z planem, wszyscy odniesiemy korzyści z wyników.

Zalecenia redaktorów

- Analogowa sztuczna inteligencja? Brzmi szalenie, ale może to być przyszłość

- Przeczytaj niesamowicie piękne „syntetyczne pismo” AI. który myśli, że jest Bogiem

- Architektura algorytmiczna: czy powinniśmy pozwolić A.I. projektować dla nas budynki?

- Supermodelka językowa: jak GPT-3 po cichu wprowadza A.I. rewolucja

- Women with Byte: plan Vivienne Ming mający na celu rozwiązanie „bajerskich problemów ludzkich” za pomocą sztucznej inteligencji