Mam wizję czasów, kiedy nie będę musiał wkładać i wyjmować telefonu z kieszeni 200 razy dziennie. Będę wydawał polecenia głosowe, włączając muzykę lub program telewizyjny i pokazując jutro pogodę, aby nakarmić kota dodatkową przekąską — i stanie się to automatycznie, gdziekolwiek się znajdę. Nie będę musiał określać urządzenia; jeśli moja prośba wymaga sprzężenia zwrotnego dźwiękowego lub reprezentacji wizualnej, najbliższy głośnik lub ekran ożyje. Jeśli chcę to przerwać, po prostu uniosę rękę w górę.

Zawartość

- Tyrania ekranu dotykowego

- Mówienie na głos

- Brakujący element układanki

Idea bezcielesnej sztucznej inteligencji, sprzedawana nam przez filmy science-fiction i seriale takie jak Star Trek, zbliża się, czy zdajesz sobie z tego sprawę, czy nie. Prawdę mówiąc, mogę już wykonywać przykładowe polecenia głosowe w moim domu i w większości działają, ale są problemy z wymaganą rzadką gamą urządzeń i często zachowują się jak wrogowie zepchnięci do niechętnej tymczasowej placówki rozejm. Zbyt często coś nie działa zgodnie z oczekiwaniami i wracasz do wydobywania tego szklanego prostokąta oraz stukania i przesuwania w celu znalezienia rozwiązania.

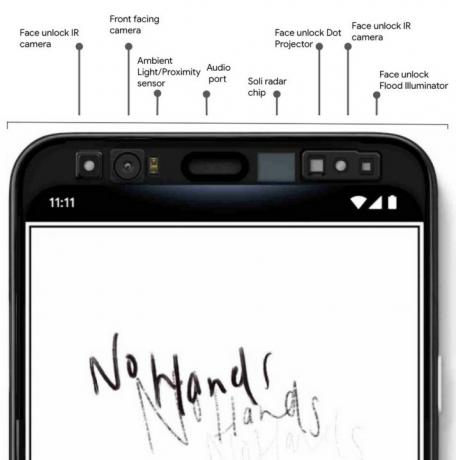

Google planuje to zmienić. Firma po prostu opublikował wideo przedstawiający kobietę wchodzącą w interakcję z nadchodzącym Pixelem 4 bez dotykania go. Najpierw telefon odblokowuje się, gdy rozpozna jej twarz – na razie Apple – ale potem ona macha ręką, aby zmienić odtwarzany utwór. Wiemy, że jest to owoc Projekt Soli, z którym zetknęliśmy się po raz pierwszy więcej niż cztery lata temu. Krótko mówiąc, jest to zminiaturyzowany radar, który zmieści się w telefonie i rozpoznaje precyzyjne gesty palców i dłoni. Może także umożliwiać wstrzymywanie, zwiększanie i zmniejszanie głośności, a nawet dokładne poruszanie się po menu.

Być może zastanawiasz się, czy Samsung nie zrobił tego z Galaxy s4 a ostatnio, czy LG nie zrobiło tego z G8ThinQ? W pewnym sensie – ale wdrożenie Samsunga było okropne, a LG używa rozwiązania czujnik czasu przelotu Zamiast. Co ważniejsze, Samsung i LG nie mają umiejętności oprogramowania Google ani jego szerszej wizji. To nie jedyny ruch, jaki podejmuje Google, aby uwolnić nas od ekranu dotykowego.

Tyrania ekranu dotykowego

Jak porty, guziki, I ramki topnieją, nasze smartfony są rozbierane do tego, co najważniejsze, ale po prostu nie możemy uciec od tego ekranu. Według jedno badaniedotykamy naszych telefonów średnio 2617 razy dziennie. Był uwarunkowani, aby dotykać naszych telefonów, priorytetowo traktować odpowiadanie na nie, a nie na faktyczną osobę przed nami; czasami nawet odczuwamy fantomowe wibracje i reagujemy na wyimaginowane powiadomienie, którego nigdy nie było.

Co ważniejsze, Samsung i LG nie mają umiejętności oprogramowania Google ani jego szerszej wizji.

Odblokowywanie telefonu twarzą nie powoduje tarcia i jest jedną z tych rzeczy, do których szybko się przyzwyczajasz i tęsknisz, jeśli ktoś Ci je zabierze. Widzieliśmy już gesty, ale zawsze były niestabilne w implementacji i miały ograniczoną użyteczność. Jestem optymistą, że Google wyniesie ten pomysł na wyższy poziom. Obydwa są ważnymi krokami, które zmniejszają potrzebę dotykania telefonów, ale tylko łącząc je z głosem, możemy naprawdę zmienić sposób, w jaki współdziałamy.

To prowadzi nas do kolejnego ważnego powodu, dla którego Google jest doskonale przygotowany do zapewnienia przyszłości bez użycia rąk: Asystent Google. Jest to zdecydowanie najbardziej wydajny i bogaty w funkcje asystent głosowy, który udoskonala się w najszybszym tempie.

Mówienie na głos

The kolejna wersja Asystenta Google, który zadebiutuje również na Pixelu 4, umożliwia zadawanie szeregu pytań bez mówienia „Hej, Google” pomiędzy nimi. Dane zostały zmniejszone, aby zmieściły się w telefonie, dzięki czemu Asystent Google może odpowiedzieć bez konieczności konsultowania się z odległym serwerem. Rozumie kontekst i, co najważniejsze, może wykonać polecenie znacznie, znacznie szybciej, niż kiedykolwiek mógłbyś je dotknąć, wpisać i przesunąć.

Niezależnie od tego, czy chcesz podyktować e-mail, znaleźć zdjęcia z wycieczki do Disneylandu, czy też połączyć zadania, które szybko się pojawią z wielu aplikacji używanie głosu i Asystenta Google stanie się najłatwiejszym i najszybszym sposobem To. Ludzie powoli przyjmowali polecenia głosowe, częściowo dlatego, że możliwości asystentów głosowych są ograniczone i nie rozumieją kontekstu, ale często po prostu dlatego, że szybciej jest to zrobić ręcznie. Kiedy to już nie jest prawdą, całość staje się znacznie atrakcyjniejszą propozycją, i to po użyciu głosu wydawania poleceń przez chwilę, przypomina to odblokowywanie za pomocą twarzy — gdzie przejście na czujnik odcisków palców wydaje się krokiem do tyłu.

Choć odblokowywanie twarzą oraz gesty i polecenia głosowe są ekscytujące, przedwczesne byłoby przewidywanie śmierci smartfona. Są chwile, kiedy w pobliżu nie ma głośnika ani ekranu, więc nasze fizyczne smartfony nadal służą ważnemu celowi. Są też chwile, gdy przesunięcie i dotknięcie ekranu będzie lepszym rozwiązaniem niż rozmowa lub gesty.

Używam teraz Asystenta Google przez cały dzień. Czyta mi wiadomości, podaje aktualne informacje o pogodzie, przypomina o spotkaniach i mówi, jak dotrzeć tam, dokąd zmierzam. Odpowiada także na mój niekończący się bufet losowych pytań. Ale chociaż używam go komfortowo i jestem podekscytowany dalszymi udoskonaleniami, nadal staram się ograniczać korzystanie z niego do chwil, gdy jestem sam lub z rodziną. Nie zamierzam tego robić w zatłoczonym pociągu ani w kolejce w kawiarni i ty też nie powinieneś.

Istnieje kolejna frustrująca przeszkoda na drodze do przyszłości bez użycia rąk, którą Google może pokonać.

Brakujący element układanki

Konkurencja między firmami i uparty opór wobec integracji lub wspólnych standardów okradają nas z przyszłości science fiction, na którą zasługujemy. Podczas gdy Samsung, LG, a także Apple skupiają się na sprzedaży nam sprzętu, ambicją Google’a numer jeden jest bycie bezcielesnym asystentem. Czasami zastanawiam się, czy przejście z referencyjnej linii Nexus na bardziej konsumenckiego Pixela było na pewno tylko zniecierpliwieniem i rosnąca frustracja, że duzi producenci, tacy jak Samsung, zamiast ich wspierać, próbują opracowywać własnych asystentów Google.

Google jest doskonale przygotowany, aby zapewnić przyszłość bez użycia rąk.

W obecnej postaci możesz zbudować zestaw głośnomówiący, ale jeśli chcesz czegoś bliskiego płynnej integracji pomiędzy nimi różnych urządzeń, musisz współpracować z konkretnym producentem i zostać uczniem Apple lub Samsunga wielbiciel. Problem w tym, że żaden pojedynczy producent nie oferuje wszystkiego tego, co najlepsze, więc trzeba gdzieś pójść na kompromis.

Amazonowi udało się wkraść backdoorem, umożliwiając każdemu i każdemu zintegrowanie Alexy, ale ryzyko było niewielkie są przeciwni temu, aby zwyciężył jako siła jednocząca w technologii, ponieważ całkowicie przegapił łódkę smartfony. Google znajduje się na czołowej pozycji, ze smartfonami zszytymi i kilkoma przeszkodami na drodze do ekspansji w kierunku technologii inteligentnego domu. Google może zadebiutować z tymi nowymi urządzeniami głośnomówiącymi funkcje na Pixelu 4, ale w przeciwieństwie do konkurencji, w ramach planu długoterminowego zostaną one wprowadzone na każdym telefonie, który będzie w stanie z nich skorzystać – najlepsze jest to, że wraz z nimi pojawi się Google.

Zalecenia redaktorów

- Galaxy Z Fold 5 potrzebuje tych 4 rzeczy, aby pokonać Pixel Fold

- Czy aparat Pixela Fold może pokonać Galaxy Z Fold 4? dowiedziałem się

- Google Pixel Watch 2: plotka o cenie, dacie premiery, nowościach i nie tylko

- Google może stworzyć idealny telefon Pixel – jeśli zmieni to jedną rzecz

- Masz stary Google Pixel? Ten test aparatu sprawi, że zapragniesz Pixela 7a