Fra Grand Theft Auto-serien til overfloden av tilgjengelige Spider-Man-titler, mange videospill lar deg utforske en tredimensjonal representasjon av en ekte (eller tynt fiksjonalisert) by. Å lage disse bybildene er imidlertid ikke lett. Oppgaven krever tusenvis av timer med datamodellering og nøye referansestudier før spillere har sjansen til å gå, kjøre eller fly gjennom den komplette virtuelle verdenen.

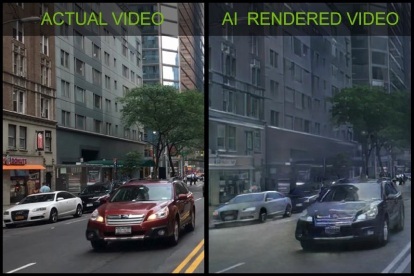

En imponerende ny teknologidemo fra Nvidia viser at det imidlertid er en annen måte. Teknologiselskapet ble vist frem på NeurIPS-konferansen om kunstig intelligens i Montreal, og viste frem hvordan maskinlæringsteknologi kan generere en overbevisende virtuell by ganske enkelt ved å vise den dash-kamera videoer. Disse videoene ble samlet fra selvkjørende biler, under en ukes prøvekjøring rundt byer. Den nevrale nettverksopplæringsprosessen tok rundt en uke ved å bruke Nvidias Tesla V100 GPUer på et DGX-1 superdatamaskinsystem. Når A.I. hadde lært hva den så på og funnet ut hvordan man segmenterer dette i fargekodede objekter, ble de virtuelle byene generert ved hjelp av Unreal Engine 4.

Anbefalte videoer

"En av de største hindringene utviklere møter er at det er dyrt å lage innhold for virtuelle verdener," Bryan Catanzaro, visepresident for anvendt dyplæringsforskning ved Nvidia, fortalte Digital Trends. «Det kan ta dusinvis av artister måneder å skape en interaktiv verden for spill eller VR-applikasjoner. Vi har laget en ny måte å gjengi innhold ved hjelp av dyp læring – ved å bruke A.I. som lærer av den virkelige verden - noe som kan hjelpe kunstnere og utviklere med å skape virtuelle miljøer til en mye lavere kostnad."

Forskning ved NVIDIA: The First Interactive AI Rendered Virtual World

Catanzaro sa at det er utallige potensielle virkelige applikasjoner for denne teknologien. For eksempel kan det tillate brukere å tilpasse avatarer i spill ved å ta en kort video med mobiltelefonen og deretter laste den opp. Dette kan også brukes til å lage morsomme videoer der brukerens funksjoner er kartlagt på en annen kropps bevegelse. (Som sett i videoen ovenfor, hadde Nvidia det gøy med å få en av utviklerne til å utføre Gangnam stil danse.)

"Arkitekter kan [i tillegg] bruke den til å gjengi virtuelle design for sine kunder," fortsatte Catanzaro. "Du kan bruke denne teknikken til å trene roboter eller selvkjørende biler i virtuelle miljøer. I alle disse tilfellene vil det redusere kostnadene og tiden det tar å skape virtuelle verdener.»

Han la til at dette fortsatt er tidlig forskning, og det vil ta «noen år» å modnes og rulles ut i kommersielle applikasjoner. "Men jeg er spent på at det fundamentalt kan endre måten datagrafikk lages på," sa Catanzaro.

Redaktørenes anbefalinger

- Nvidias superdatamaskin kan bringe en ny æra av ChatGPT

- Nvidias nye stemme A.I. høres akkurat ut som en ekte person

- IBMs A.I. Mayflower-skipet krysser Atlanterhavet, og du kan se det live

- Forskere bruker A.I. å lage kunstig menneskelig genetisk kode

- Smart ny A.I. systemet lover å trene hunden din mens du er borte fra hjemmet

Oppgrader livsstilen dinDigitale trender hjelper leserne å følge med på den fartsfylte teknologiverdenen med alle de siste nyhetene, morsomme produktanmeldelser, innsiktsfulle redaksjoner og unike sniktitter.