Prediktivt politiarbeid skulle forvandle måten politiet ble utført på, og føre oss inn i en verden av smart lov håndhevelse der skjevhet ble fjernet og politiet ville være i stand til å svare på dataene, ikke til anelser. Men et tiår etter at de fleste av oss først hørte begrepet "prediktiv politiarbeid" virker det klart at det ikke har fungert. Drevet av et offentlig tilbakeslag, opplever teknologien en betydelig nedgang i bruken, sammenlignet med for bare noen få år siden.

Innhold

- Løftet om prediktivt politiarbeid

- Diskriminerende algoritmer

- Farene med skitne data

- Den usikre fremtiden til prediktivt politiarbeid

- Feil verktøy for jobben?

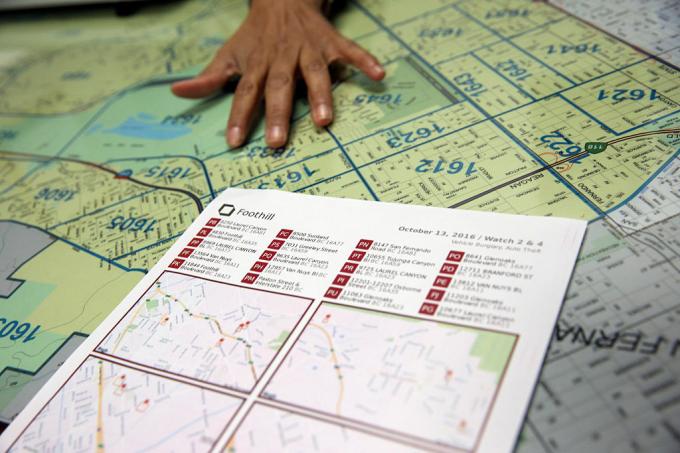

I april i år kuttet Los Angeles – som ifølge LA Times, «banebrytende for å forutsi kriminalitet med data» – finansieringen av sitt prediktive politiprogram, og skyldte på kostnadene. "Det er en vanskelig avgjørelse," politisjef Michel Moore fortalte LA Times. "Det er en strategi vi brukte, men kostnadsprognosene på hundretusenvis av dollar å bruke på det nå versus å finne de pengene og dirigere pengene til andre mer sentrale aktiviteter er det jeg må gjøre.»

Anbefalte videoer

Hva gikk galt? Hvordan kan noe annonsert som "smart" teknologi ende opp med ytterligere forankring av skjevheter og diskriminering? Og er drømmen om prediktiv politiarbeid en som kan justeres med riktig algoritme - eller en blindvei i et mer rettferdig samfunn som for tiden sliter med hvordan politiet skal operere?

Løftet om prediktivt politiarbeid

Prediktivt politiarbeid i sin nåværende form dateres tilbake rundt ett tiår til en artikkel fra 2009 av psykolog Colleen McCue og Los Angeles politisjef Charlie Beck, med tittelen "Prediktiv politiarbeid: Hva kan vi lære av Walmart og Amazon om å bekjempe kriminalitet i en lavkonjunktur?I avisen grep de måten big data ble brukt av store forhandlere for å hjelpe med å avdekke mønstre i tidligere kundeadferd som kan brukes til å forutsi fremtidig atferd. Takket være fremskritt innen både databehandling og datainnsamling, foreslo McCue og Beck at det var mulig å samle og analysere kriminalitetsdata i sanntid. Disse dataene kan deretter brukes til å forutse, forhindre og reagere mer effektivt på forbrytelser som ennå ikke hadde funnet sted.

I årene etterpå har prediktivt politiarbeid gått over fra en kastidé til en realitet i mange deler av USA, sammen med resten av verden. I prosessen har den satt seg fore å endre politiarbeid fra en reaktiv kraft til en proaktiv; å trekke på noen av gjennombruddene innen datadrevet teknologi som gjør det mulig å oppdage mønstre i sanntid – og handle ut fra dem.

"Det er to hovedformer for prediktiv politiarbeid," Andrew Ferguson, professor i jus ved University of District of Columbia David A. Clarke School of Law og forfatter av The Rise of Big Data Policing: Surveillance, Race, and the Future of Law Enforcement, fortalte Digital Trends. "[Dette er] stedsbasert prediktivt politiarbeid og personbasert prediktivt politiarbeid."

I begge tilfeller tildeler de prediktive politisystemene en risikoscore til den aktuelle personen eller stedet, som oppfordrer politiet til å følge opp med et gitt intervall. Den første av disse tilnærmingene, stedsbasert prediktivt politiarbeid, fokuserer hovedsakelig på politipatruljer. Det innebærer bruk av kriminalitetskartlegging og analyser om sannsynlige steder for fremtidige forbrytelser, basert på tidligere statistikk.

I stedet for å hjelpe til med å bli kvitt problemer som rasisme og andre systemiske skjevheter, kan prediktiv politiarbeid faktisk bidra til å forankre dem.

Den andre tilnærmingen fokuserer på å forutsi sannsynligheten for at et individ utgjør en potensiell fremtidig risiko. For eksempel, i 2013 ble en sjef for Chicago-politiet sendt til hjemmet til en 22 år gammel Robert McDaniel, som hadde blitt flagget som en potensiell risiko eller gjerningsmann for våpenvold i Chicago sentrum av en algoritme. "Heatlisten" algoritmen hjalp til med å sette sammen, lette etter mønstre som kan være i stand til å forutsi fremtidige lovbrytere eller ofre, selv om de selv ikke hadde gjort noe for å rettferdiggjøre denne granskingen utover å følge en profil.

Som Chicago Tribune bemerket: "Strategien krever å advare de på varmelisten individuelt om at ytterligere kriminell aktivitet, selv for de mest små forseelser, vil føre til at lovens fulle kraft blir revet ned dem."

Drømmen om prediktivt politiarbeid var at ved å handle på kvantifiserbare data, ville det ikke bare gjøre politiarbeid mer effektivt, men også mindre utsatt for gjetting og, som et resultat, skjevhet. Det ville, hevdet talsmenn, endre politiarbeidet til det bedre, og innlede en ny æra med smart politiarbeid. Imidlertid har prediktivt politiarbeid nesten helt fra starten hatt sterke kritikere. De argumenterer for at i stedet for å hjelpe til med å bli kvitt problemer som rasisme og andre systemiske skjevheter, kan prediktiv politiarbeid faktisk bidra til å forankre dem. Og det er vanskelig å argumentere for at de ikke har et poeng.

Diskriminerende algoritmer

Ideen om at maskinlæringsbaserte prediktive politisystemer kan lære å diskriminere basert på faktorer som rase er ikke noe nytt. Maskinlæringsverktøy trenes med enorme mengder data. Og så lenge disse dataene er samlet inn av et system der rase fortsetter å være en overveldende faktor, kan det føre til diskriminering.

Som Renata M. O'Donnell skriver i en artikkel fra 2019, med tittelen "Utfordre rasistiske prediktive politialgoritmer under likebeskyttelsesklausulen," maskinlæringsalgoritmer lærer fra data hentet fra et rettssystem der "svarte amerikanere blir fengslet i statlige fengsler med en hastighet det er 5,1 ganger fengslingen av hvite, og en av tre svarte menn som er født i dag kan forvente å gå i fengsel i løpet av livet hvis trenden er nå. Fortsette."

"Data er ikke objektiv," sa Ferguson til Digital Trends. "Det er bare oss redusert til binær kode. Datadrevne systemer som opererer i den virkelige verden er ikke mer objektive, rettferdige eller objektive enn den virkelige verden. Hvis din virkelige verden er strukturelt ulik eller rasediskriminerende, vil et datadrevet system speile disse samfunnsmessige ulikhetene. Inngangene som går inn er tilsmusset av skjevhet. Analysen er tilsmusset av skjevhet. Og mekanismene til politimyndighet endres ikke bare fordi det er teknologi som styrer systemene."

Ferguson gir eksemplet med arrestasjoner som en tilsynelatende objektiv faktor for å forutsi risiko. Imidlertid vil arrestasjoner bli skjev av tildelingen av politiressurser (for eksempel hvor de patruljerer) og kriminalitetstypene som typisk krever arrestasjoner. Dette er bare en illustrasjon av potensielt problematiske data.

Farene med skitne data

Manglende og feil data blir noen ganger referert til i datautvinning som "skitne data." EN 2019-artikkel av forskere fra A.I. Nå institutt ved New York University utvider dette begrepet til også å referere til data som er påvirket av korrupte, partiske og ulovlige praksis - enten det er fra bevisst manipulert som er forvrengt av individuelle og samfunnsmessige skjevheter. Det kan for eksempel inkludere data som er generert fra arrestasjonen av en uskyldig person som har fått plantet bevis på seg eller som på annen måte er falskt anklaget.

Det er en viss ironi i det faktum at kravene fra datasamfunnet i løpet av de siste tiårene alt handler om kvantifisering og støpejerns numeriske mål, har nettopp ført til en hel masse … vel, egentlig dårlige data. HBO-serien Ledningen viste frem fenomenet i den virkelige verden med å «juke statistikken», og årene siden programmet gikk av lufta har bydd på mange eksempler på faktisk systemisk datamanipulasjon, falske politirapporter og grunnlovsstridig praksis som har sendt uskyldige mennesker til fengsel.

Dårlige data som lar makthavere kunstig treffe mål er én ting. Men kombiner det med algoritmer og prediktive modeller som bruker dette som grunnlag for å modellere verden, og du får potensielt noe mye verre.

Forskere har vist hvordan tvilsomme kriminalitetsdata koblet til prediktive politialgoritmer kan skape det som omtales som "løpende tilbakemeldingsløkker", der politiet gjentatte ganger sendes til de samme nabolagene uavhengig av den sanne kriminalitetsraten. En av medforfatterne av avisen, dataforsker Suresh Venkatasubramanian, sier at maskinlæringsmodeller kan bygge inn feilaktige forutsetninger gjennom sin modellering. Som det gamle ordtaket om hvordan, for personen med en hammer, hvert problem ser ut som en spiker, modellerer disse systemene bare visse elementer til et problem - og forestiller seg bare ett mulig utfall.

"[Noe som] ikke blir adressert i disse modellene er i hvilken grad modellerer du det faktum at det å kaste flere politimenn inn i et område faktisk kan senke livskvaliteten for folk som bor der?» Venkatasubramanian, en professor ved School of Computing ved University of Utah, fortalte Digital Trender. «Vi antar at flere politimenn er en bedre ting. Men som vi ser akkurat nå, er det ikke nødvendigvis en god ting å ha mer politi. Det kan faktisk gjøre ting verre. I ikke én modell jeg noen gang har sett har noen spurt hva det koster å sette inn mer politi i et område.»

Den usikre fremtiden til prediktivt politiarbeid

De som jobber med prediktivt politi, bruker noen ganger uironisk uttrykket "Minoritetsrapport" for å referere til hva slags spådommer de gjør. Begrepet blir ofte påberopt som en referanse til 2002-film med samme navn, som igjen var løst basert på en novelle fra 1956 av Philip K. Dick. I Minoritetsrapport, en spesiell PreCrime politiavdeling pågriper kriminelle basert på forhåndskunnskap om forbrytelser som kommer til å bli begått i fremtiden. Disse prognosene er levert av tre synske kalt "precogs".

Men vrien inn Minoritetsrapport er at spådommene ikke alltid er nøyaktige. Avvikende visjoner fra en av precogs gir et alternativt syn på fremtiden, som undertrykkes av frykt for å få systemet til å virke upålitelig.

Interne revisjoner som viser at taktikken ikke fungerte. Ikke bare var de prediktive listene feil, men de var også ineffektive.

Akkurat nå går prediktivt politiarbeid sin egen usikre fremtid i møte. Ved siden av nye teknologier som ansiktsgjenkjenning, har teknologien som er tilgjengelig for rettshåndhevelse for mulig bruk aldri vært kraftigere. Samtidig har bevisstheten om bruken av prediktivt politi forårsaket et offentlig tilbakeslag som faktisk kan ha bidratt til å stoppe den. Ferguson fortalte Digital Trends at bruken av prediktive politiverktøy har vært på en "nedsving" de siste årene.

«På sitt høydepunkt var [stedsbasert prediktivt politiarbeid] i over 60 større byer og vokser, men som et resultat av vellykket fellesskapsorganisering, har den i stor grad blitt redusert og/eller erstattet med andre former for datadrevet analyse, sa han. "Kort sagt, begrepet prediktivt politi ble giftig, og politiavdelinger lærte å gi nytt navn til hva de gjorde med data. Personbasert prediktivt politiarbeid hadde et brattere fall. De to hovedbyene investerte i etableringen - Chicago og Los Angeles - støttet opp om deres personbaserte strategier etter skarp samfunnskritikk og ødeleggende interne revisjoner som viser at taktikken ikke gjorde det arbeid. Ikke bare var de prediktive listene feil, de var også ineffektive.»

Feil verktøy for jobben?

Derimot, Rashida Richardson, direktør for policyforskning ved A.I. Nå sa Institute at det er for mye ugjennomsiktighet rundt bruken av denne teknologien. "Vi vet fortsatt ikke på grunn av mangelen på åpenhet angående statlig anskaffelse av teknologi og mange smutthull i eksisterende anskaffelsesprosedyrer som kan beskytte visse teknologikjøp fra offentlig gransking.» hun sa. Hun gir et eksempel på teknologi som kan gis til en politiavdeling gratis eller kjøpt av en tredjepart. "Vi vet fra forskning som min og rapportering i media at mange av de største politiavdelingene i USA har brukt teknologi på et tidspunkt, men det er også mange små politiavdelinger som bruker det, eller har brukt det i begrensede perioder av tid."

Gitt dagens avhør om politiets rolle, vil det være en fristelse til å omfavne prediktiv politiarbeid som et verktøy for datadrevet beslutningstaking - kanskje under mindre dystopisk sci-fi merkevarebygging? Det er en mulighet for at en slik gjenoppblomstring kan dukke opp. Men Venkatasubramanian er svært skeptisk til at maskinlæring, slik den praktiseres i dag, er det rette verktøyet for jobben.

"Hele maskinlæring og dens suksess i det moderne samfunn er basert på premisset om at, uansett hva det faktisk er problem, det koker til slutt ned å samle inn data, bygge en modell, forutsi utfall – og du trenger ikke å bekymre deg for domenet,» han sa. "Du kan skrive den samme koden og bruke den på 100 forskjellige steder. Det er løftet om abstraksjon og portabilitet. Problemet er at når vi bruker det folk kaller sosio-tekniske systemer, hvor man har mennesker og teknologi sammen i kompliserte bølger, kan man ikke gjøre dette. Du kan ikke bare koble til et stykke og forvente at det fungerer. Fordi [det er] ringvirkninger med å sette den biten inn og det faktum at det er forskjellige spillere med ulike agendaer i et slikt system, og de undergraver systemet til sine egne behov i forskjellige måter. Alle disse tingene må tas med når du snakker om effektivitet. Ja, du kan si abstrakt at alt vil fungere bra, men der er ingen abstrakt. Det er bare konteksten du jobber i."