Nvidia GeForce RTX 4090

MSRP $1,600.00

«Sjokkerende som det høres ut, er RTX 4090 verdt hver krone. Det er bare synd at folk flest ikke vil ha råd til denne utmerkede GPUen.»

Fordeler

- Store sprang i 4K-spillytelse

- Utmerket strålesporingsytelse

- Høy effekt og termikk, men håndterlig

- DLSS 3-ytelsen er utenfor listene

Ulemper

- Veldig dyrt

- DLSS 3 bildekvalitet trenger litt arbeid

RTX 4090 er både totalt bortkastet penger og det kraftigste grafikkortet som noen gang er laget. Det gjør det riktignok et vanskelig produkt å evaluere, spesielt med tanke på hvor mye den gjennomsnittlige PC-spilleren ønsker å bruke på en oppgradering av systemet sitt.

Innhold

- Videoanmeldelse

- Nvidia RTX 4090 spesifikasjoner

- Syntetisk og gjengivelse

- 4K-spillytelse

- 1440p spillytelse

- Strålesporing

- DLSS 3 testet

- Strøm og termikk

- Bør du kjøpe Nvidia RTX 4090?

RTX 4090 debuterte med Nvidias nye Ada Lovelace-arkitektur, og har blitt innhyllet i kontroverser og sitert som plakatbarnet for å ha reist seg

GPU priser. Så mye som det koster, leverer det ytelse, spesielt med forbedringene som tilbys av DLSS 3. Bør du spare kronene dine og selge bilen din for dette beistet av GPU? Sannsynligvis ikke. Men det er definitivt et spennende utstillingsvindu for hvor langt denne teknologien virkelig kan gå.Videoanmeldelse

Nvidia RTX 4090 spesifikasjoner

Som nevnt introduserer RTX 4090 Nvidias nye Ada Lovelace-arkitektur, samt chipmaker TSMCs mer effektive N4-produksjonsprosess. Selv om det er umulig å sammenligne RTX 4090 spesifikasjoner for spesifikasjoner med forrige generasjon, kan vi få litt innsikt i hva Nvidia prioriterte ved utformingen av Ada Lovelace.

I slekt

- Bør du kjøpe Nvidias RTX 4060 eller RTX 4060 Ti?

- Nvidia RTX 4090-kabler kan smelte på en bekymringsfull ny måte

- Asus slipper en RTX 4060 like stor som RTX 4090

Hovedfokus: klokkehastigheter. De RTX 3090 Ti toppet på rundt 1,8 GHz, men RTX 4090 viser effektiviteten til den nye noden med en 2,52 GHz boost-klokke. Det er med samme korteffekt på 450 watt, men det kjører på flere kjerner. RTX 3090 Ti var bare sjenert for 11 000 CUDA-kjerner, mens RTX 4090 tilbyr 16 384 CUDA-kjerner.

| RTX 4090 | RTX 3090 | |

| Arkitektur | Ada Lovelace | Ampere |

| Prosess node | TSMC N4 | 8nm Samsung |

| CUDA kjerner | 16,384 | 10,496 |

| Strålesporingskjerner | 144 3. generasjon | 82 2. generasjon |

| Tensor kjerner | 576 4. generasjon | 328 3. generasjon |

| Base klokkehastighet | 2235MHz | 1394MHz |

| Øk klokkehastigheten | 2520MHz | 1695 MHz |

| VRAM GDDR6X | 24 GB | 24 GB |

| Minnehastighet | 21 Gbps | 19,5 Gbps |

| Buss bredde | 384-bit | 384-bit |

| TDP | 450W | 350W |

Det er vanskelig å si hvor mye de ekstra kjernene betyr noe, spesielt for spill. Nede i stabelen har 16 GB RTX 4080 litt mer enn halvparten av kjernene som RTX 4090, mens 12 GB RTX 4080 har enda mindre. Klokkehastighetene forblir høye, men spesifikasjonene til RTX 40-serien antyder akkurat nå at det økte kjerneantallet ikke vil være et stort salgsargument, i det minste for spill.

Syntetisk og gjengivelse

Før vi går inn i hele benchmark-pakken, la oss ta en titt på ytelse på høyt nivå. Port Royal og Time Spy fra 3D Mark viser hvordan Nvidias siste flaggskip skalerer seg godt, og viser en 58% gevinst over RTX 3090 Ti i Time Spy, samt en 102% økning i forhold til RTX 3090 i Port Royal.

Det er viktig å merke seg at 3DMark ikke er den beste måten å bedømme ytelsen på, da det tar hensyn til din CPU mye mer enn de fleste spill gjør (spesielt ved 4K). Når det gjelder RTX 4090, viser 3DMark imidlertid skaleringen godt. Faktisk er resultatene mine fra ekte spill faktisk litt høyere enn det denne syntetiske benchmarken antyder, i hvert fall utenfor strålesporing.

Jeg testet også Blender for å måle noen innholdsopprettingsoppgaver med RTX 4090, og forbedringene er forbløffende. Blender akselereres av Nvidias CUDA-kjerner, og RTX 4090 virker spesielt optimalisert for disse typer arbeidsbelastninger, med den opp mer enn det dobbelte av poengsummen til RTX 3090 og RTX 3090 Ti i Monster- og Junkshop-scenene, og i underkant av det dobbelte i klasserommet scene. AMDs GPUer, som ikke har CUDA, er ikke engang i nærheten.

4K-spillytelse

Over til de saftige bitene. Alle testene mine ble utført med en Ryzen 9 7950X og 32 GB DDR5-6000-minne på en friluftstestbenk. jeg beholdt Størrelsesbar BAR slått på under testingen, eller i tilfelle av AMD GPUer, Smart Access Memory.

RTX 4090 er et monster fysisk, men det er også et monster når det kommer til 4K-spillytelse. På tvers av testpakken min, unntatt Lyst minne uendelig og Horizon Zero Dawn, som jeg har ufullstendige data for, var RTX 4090 68 % raskere enn RTX 3090 Ti. Sammenlignet med RTX 3090 ser du på nesten en økning på 89 %.

Det er et stort hopp, mye større enn de 30 % økningen vi så gen-på-gen med utgivelsen av RTX 3080. Og ingen av disse tallene har betydning for oppskalering. Dette er rå ytelse, inkludert strålesporing, og RTX 4090 viser en enorm ledelse i forhold til forrige generasjon.

Den kanskje mest imponerende forestillingen var Cyberpunk 2077. RTX 4090 er litt over 50 % raskere enn RTX 3090 Ti ved 4K med maksimale innstillinger, noe som er imponerende nok. Det er imidlertid det faktum at RTX 4090 knekker 60 bilder per sekund (fps) som skiller seg ut. Tilogmed kraftigste grafikkort i forrige generasjon kunne ikke komme forbi 60 fps uten hjelp fra Deep Learning Super Sampling (DLSS). RTX 4090 kan bryte den barrieren mens den gjengir hver piksel, og gjør det med en god ledelse.

1 av 6

Gears taktikk viser også kraften til RTX 4090, og vant over RTX 3090 Ti med en ledelse på 73 %. I en Vulkan tittel som Red Dead Redemption 2, gevinstene er mindre, men RTX 4090 klarte fortsatt en 52% ledelse basert på testingen min. Dette er et stort generasjonssprang i ytelse, selv om det fortsatt er under det Nvidia opprinnelig lovet.

Nvidia har markedsført RTX 4090 som "to til fire ganger raskere" enn RTX 3090 Ti, og det er ikke sant. Det er mye raskere enn den forrige topphunden, men Nvidias påstand gir bare mening når du tar hensyn til DLSS 3. DLSS 3 er imponerende, og jeg kommer til det senere i denne anmeldelsen. Men det er ikke i alle spill, og det trenger fortsatt litt arbeid. Heldigvis, med RTX 4090s rå ytelse, er DLSS mer en "fin å ha" og mindre av et "behov å ha."

I AMD-promoterte titler som Assassin's Creed Valhalla og Forza Horizon 5, RTX 4090 viser fortsatt sin kraft, men nå mot AMDs RX 6950 XT. I Valhalla ved 4K klarte RTX 4090 en ledelse på 63 % over RX 6950 XT. Marginene var trangere inn Forza Horizon 5, som ser ut til å skalere veldig bra med AMDs nåværende tilbud. Selv med mindre forsprang, er RTX 4090 48 % foran RX 6950 XT.

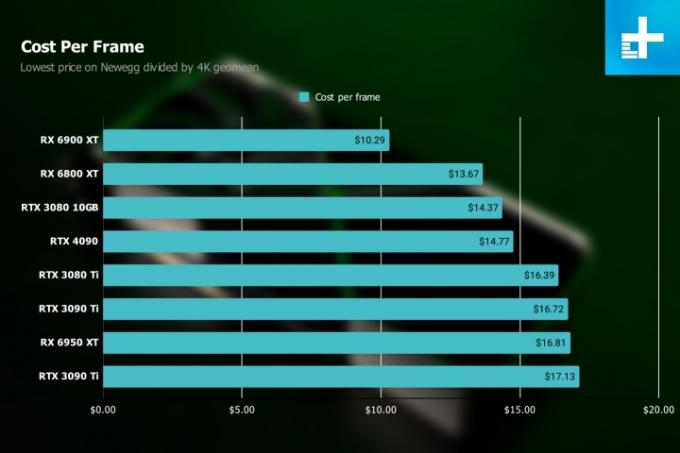

Disse sammenligningene er imponerende, men RTX 4090 er ikke på like vilkår med konkurrentene. Til $1600 er Nvidias nyeste flaggskip betydelig dyrere enn selv de dyreste GPUene som er tilgjengelige i dag. Med ytelsen RTX 4090 tilbyr, er det faktisk en bedre avtale enn en billigere RTX 3090 eller RTX 3090 Ti.

Når det gjelder pris per ramme, ser du på omtrent samme pris som en RTX 3080 10GB til $700. Dette er ikke den beste måten å bedømme verdien på – det forutsetter at du til og med har ekstra penger å bruke på RTX 4090 i utgangspunktet, og det tar ikke hensyn til funksjoner som DLSS 3 - men så gal det enn høres ut, $1600 er en ganske rimelig pris for 4K-ytelsen RTX 4090 tilbud.

Nå som lanseringsstøvet har lagt seg, sørg for å lese vår RTX 4080 anmeldelse og RX 7900 XTX anmeldelse for å se hvordan RTX 4090 klarer seg med andre avanserte GPUer.

1440p spillytelse

Hvis du kjøper RTX 4090 for 1440p, kaster du bort pengene dine (les guiden vår på beste 1440p grafikkorts i stedet). Selv om det fortsatt gir en stor forbedring i forhold til forrige generasjon, er marginene mye slankere. Du ser på en støt på 48 % i forhold til RTX 3090 Ti, og en økning på 68 % i forhold til RX 6950 XT. Det er fortsatt store generasjonshopp, men RTX 4090 skinner virkelig på 4K.

Du begynner å bli en lite CPU begrenset ved 1440p, og går du ned til 1080p, blir resultatene enda strammere. Og ærlig talt, den ekstra ytelsen ved 1440p skiller seg ikke ut som den gjør ved 4K. I Gears taktikk, for eksempel er RTX 4090 36 % raskere enn RTX 3090 Ti, ned fra 73 %-leddet Nvidias siste kort viste ved 4K. De faktiske bildefrekvensene er også mindre imponerende. Visst, RTX 4090 er langt foran RTX 3090 Ti, men det er vanskelig å forestille seg at noen trenger over 200 fps i Gears taktikk når en GPU som er $500 billigere allerede er over 160 fps.

1 av 6

Ved 4K oppnår RTX 4090 store milepæler - over 60 fps i Cyberpunk 2077 uten DLSS, nær 144Hz-merket for monitorer med høy oppdateringsfrekvens i Assassin's Creed Valhalla, etc. Ved 1440p har RTX 4090 absolutt et høyere tall, men det tallet er mye mer imponerende på papiret enn det er på en faktisk skjerm.

Strålesporing

Nvidia har vært en mester for strålesporing siden Turing-generasjonen, men Ada Lovelace er den første generasjonen der den ser en større overhaling. I hjertet av RTX 4090 er en redesignet ray tracing-kjerne som øker ytelsen og introduserer Shader Execution Reordering (SER). SER er i utgangspunktet en mer effektiv måte å behandle strålesporingsoperasjoner på, som lar dem utføre når GPU-kraft blir tilgjengelig i stedet for i en rett linje der flaskehalser må oppstå. Det krever også at du slår på maskinvareakselerert GPU-planlegging i Windows.

Og det fungerer. Marginene med ray tracing er vanligvis mye slankere, men RTX 4090 viser faktisk høyere gevinster når ray tracing er slått på. I Cyberpunk 2077, for eksempel er RTX 4090 nesten 71 % raskere enn RTX 3090 Ti med Ultra RT-forhåndsinnstillingen. Og det er før du tar med DLSS. AMDs GPU-er, som er mye lenger bak i strålesporingsytelse, viser enda større forskjeller. RTX 4090 er hele 152 % raskere enn RX 6950 XT i denne målestokken.

1 av 6

På samme måte, Metro Exodus Enhanced Edition viste en økning på 80 % for RTX 4090 over RTX 3090 Ti, og Lyst minne uendelig viste RTX 4090 93 % foran RTX 3090. Nvidias påstand om "to til fire ganger raskere" enn RTX 3090 Ti holder kanskje ikke uten DLSS 3, men ray tracing-ytelsen kommer mye nærmere det merket.

Og akkurat som 4K-ytelse, viser RTX 4090 ytelsesforbedringer som faktisk utgjør en forskjell når ray tracing er slått på. I Lyst minne uendelig, RTX 4090 er forskjellen mellom å dra nytte av en høy oppdateringsfrekvens og knapt å knekke 60 fps. Og i Cyberpunk 2077, RTX 4090 er bokstavelig talt forskjellen mellom spillbart og uspillbart.

DLSS 3 testet

DLSS har vært en superstjernefunksjon for RTX GPUer de siste generasjonene, men DLSS 3 er et stort skifte for teknologien. Det introduserer generering av optisk flyt AI-ramme, som koker ned til at AI-modellen genererer en helt unik ramme annenhver ramme. Teoretisk sett betyr det at selv et spill som er 100 % begrenset av CPU og ikke vil se noen fordel av en lavere oppløsning, vil ha dobbelt så høy ytelse.

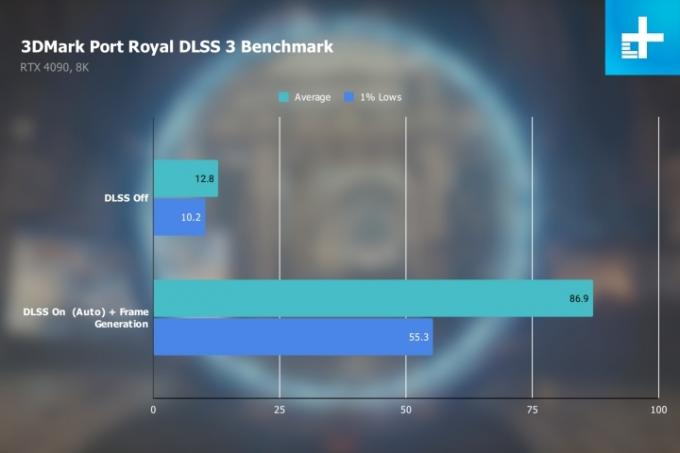

Det er ikke helt situasjonen i den virkelige verden, men DLSS 3 er fortsatt veldig imponerende. Jeg startet med 3DMarks DLSS 3-test, som bare kjører Port Royal-benchmark med DLSS av og på. Målet mitt var å presse funksjonen så langt som mulig, så jeg satte DLSS til Ultra Performance-modus og oppløsningen til 8K. Dette er det beste utstillingsvinduet for hva DLSS 3 er i stand til, med teknologien som øker bildefrekvensen med 578 %. Det er sinnsykt.

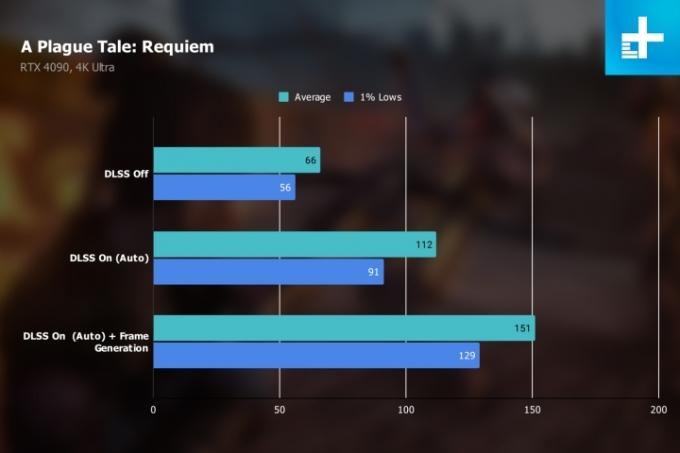

I ekte spill er ikke gevinstene like sterke, men DLSS 3 er fortsatt imponerende. Nvidia ga en tidlig oppbygging av A Plague Tale: Requiem, og DLSS klarte å øke den gjennomsnittlige bildefrekvensen med 128 % ved 4K med innstillingene maksimalt. Og dette var med Auto-modus for DLSS. Med mer aggressive forhåndsinnstillinger for bildekvalitet er gevinstene enda høyere.

A Plague Tale: Requiem avslører imidlertid et viktig aspekt ved DLSS 3: Det pådrar seg en anstendig mengde overhead. DLSS 3 er to deler. Den første delen er DLSS Super Resolution, som er den samme DLSS du har sett på tidligere RTX-generasjoner. Den vil fortsette å fungere med RTX 20-serien og 30-serien GPUer, slik at du fortsatt kan bruke DLSS 3 Super Resolution i spill med tidligere generasjons kort.

DLSS Frame Generation er den andre delen, og den er eksklusiv for RTX 40-seriens GPUer. AI genererer en ny ramme annenhver ramme, men det er beregningsmessig dyrt. På grunn av det, Nvidia refleks tvinges på hver gang du slår på Frame Generation, og du kan ikke slå den av.

Hvis du resonnerer gjennom hvordan Frame Generation fungerer, er det bør gi dobbel bildefrekvens av hva du får med bare Super Resolution, men det er ikke tilfelle. Som du kan se i Cyberpunk 2077 nedenfor betyr Frame Generation-resultatet at GPU-en bare gjengir omtrent 65 bilder - resten kommer fra AI. Med superoppløsning alene, hopper resultatet opp med nesten 30 fps. Det er DLSS Frame Generation overhead som spiller.

Selvfølgelig gir Frame Generation den beste ytelsen, men ikke tell ut Super Resolution som foreldet. Selv om det ser ut til at Frame Generation dobler DLSS-bildehastighetene, er det faktisk mye nærmere Super Resolution alene i praksis.

Du kan ikke snakke om DLSS bortsett fra bildekvalitet, og selv om DLSS 3 er imponerende, trenger den fortsatt litt arbeid i bildekvalitetsavdelingen. Fordi annenhver ramme genereres på GPUen og sendes rett ut til skjermen din, kan den ikke omgå elementer som din HUD. De er en del av den genererte rammen, og de er modne for gjenstander, som du kan se i Cyberpunk 2077 under. Den bevegelige søkemarkøren sputter ut mens den beveger seg over skjermen, med AI-modellen som ikke er helt sikker på hvor den skal plassere piksler når elementet beveger seg. Normalt er ikke HUD-elementer en del av DLSS, men Frame Generation betyr at du må ta dem med.

Den samme oppførselen dukker opp i den faktiske scenen også. I A Plague Tale: Requiem, for eksempel kan du se hvordan å løpe gjennom gresset produserer et tynt lag med piksel-skjærsilden når AI sliter med å finne ut hvor gresset skal plasseres og hvor bena skal plasseres. Tilsvarende viste Port Royal myke kanter og mye pikselustabilitet.

Disse artefaktene er best sett i bevegelse, så jeg tok en haug med 4K-opptak med 120 fps, som du kan se nedenfor. Jeg senket DLSS-sammenligningene med 50 % slik at du kan se så mange bilder som mulig, men husk YouTubes komprimering og det faktum at det er vanskelig å få en ekte eple-til-epler-kvalitetssammenligning når du fanger spilling. Det er best å se i kjødet.

RTX 4090 Gameplay og DLSS 3 utstillingsvindu

Mens du spiller, blir bildekvalitetsstraffene DLSS 3 pådrar seg lett oppveid av ytelsesgevinstene den gir. Men Frame Generation er ikke en innstilling du alltid bør slå på. Det er på sitt beste når du trykker på ray tracing og alle de visuelle klokkene og plystrene. Forhåpentligvis vil det også forbedre seg. Jeg er sikker på at Nvidia vil fortsette å avgrense Frame Generation-aspektet, men for øyeblikket viser det fortsatt noen frynsete kanter.

Strøm og termikk

Før RTX 4090-kunngjøringen, den ryktefabrikken løp løpsk med spekulasjoner om obskøne maktkrav. RTX 4090 trekker mye strøm - 450W for Founder's Edition og enda mer for bordpartnerkort som Asus ROG Strix RTX 4090 - men det er ikke mer enn RTX 3090 Ti trakk. Og basert på min testing trekker RTX 4090 faktisk litt mindre.

Tabellen nedenfor viser det maksimale strømforbruket jeg målte under testing. Dette er ikke maksimal kraft - en dedikert stresstest ville presse RTX 4090 videre - men spill er ikke stresstester, og du vil ikke alltid nå maksimal kraft (eller til og med komme i nærheten). Sammenlignet med andre Founder's Edition-modeller, forbrukte RTX 4090 faktisk omtrent 25W mindre enn RTX 3090 Ti. Overklokkede brettpartnerkort vil imidlertid klatre høyere, så husk det.

1 av 2

For termikk nådde RTX 4090 en topp på 64 grader Celsius i testpakken min, som er rett rundt der den skal sitte. Jo mindre RTX 3080 Ti med sine pressede klokkehastigheter og kjerneteller viste de høyeste termiske resultatene, med en topp på 78 grader. Alle disse tallene ble imidlertid samlet på en friluftstestbenk, så temperaturene vil være høyere når RTX 4090 er i et etui.

Bør du kjøpe Nvidia RTX 4090?

Hvis du har $1600 å bruke på en GPU, ja, du bør kjøpe RTX 4090. De fleste har imidlertid ikke 1600 dollar å bruke på et grafikkort, og det er der RTX 4090 blir vanskelig.

Jeg kan vise diagram etter diagram som viser hvor kraftig RTX 4090 er, hvor $1600 er en relativt rimelig pris å spørre om, og hvordan DLSS 3 forbedrer spillytelsen enormt. Men faktum gjenstår at RTX 4090 koster mer enn mange fulle spill-PCer gjør. Dette er langt fra grafikkortet for de fleste. Det er ikke engang grafikkortet for de fleste entusiaster.

RTX 4090 er verdt det, men det betyr ikke at du bør kjøpe den. Vi har fortsatt et veldig ufullstendig bilde av neste generasjon — RTX 4080-modellene kommer i november, og AMD skal lansere sine RX 7000 GPUer den 3. november. For de fleste er det beste alternativet å vente. Vi er ikke på vei mot en annen GPU mangel, så det er ingen grunn til å tro at RTX 4090 vil bli det mer dyrt når disse kortene er ute.

Hvis du er i den slanke prosentandelen av mennesker som vil ha det beste rett og slett fordi det er det beste, har RTX 4090 den tittelen. RTX 4090 er mye dyrere enn den gjennomsnittlige PC-spilleren ønsker å bruke, men igjen, det er mye mer enn et gjennomsnittlig grafikkort.

Redaktørenes anbefalinger

- Har Nvidia nettopp fikset RTX 4090s smeltende strømkontakter?

- Jeg testet Nvidias nye RTX 4060 mot RX 7600 - og den er ikke pen

- Nvidia trosser pushback, forsvarer 8 GB VRAM i de siste GPUene

- Med RTX 4060 til $299, snur Nvidia kursen på priser

- Ikke engang Nvidias RTX 4090 kan håndtere Star Wars Jedi: Survivor