Voorspellend politiewerk Het was de bedoeling dat het de manier zou veranderen waarop de politie werd uitgevoerd, en ons een wereld van slimme wetten zou binnenleiden handhaving waarbij vooringenomenheid werd weggenomen en de politie op de gegevens zou kunnen reageren, en niet op de gegevens ingevingen. Maar tien jaar nadat de meesten van ons voor het eerst de term ‘predictive policing’ hoorden, lijkt het duidelijk dat het niet heeft gewerkt. Gedreven door publieke reacties ervaart de technologie een aanzienlijke afname in het gebruik ervan, vergeleken met slechts een paar jaar geleden.

Inhoud

- De belofte van voorspellend politiewerk

- Discriminerende algoritmen

- De gevaren van vervuilde data

- De onzekere toekomst van voorspellend politiewerk

- Het verkeerde gereedschap voor de klus?

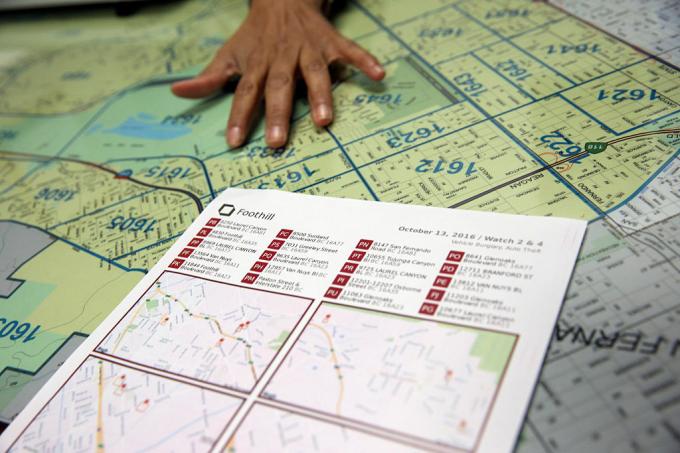

In april van dit jaar heeft Los Angeles – dat volgens de LA Times “een pionier was in het voorspellen van misdaad met data” – de financiering voor zijn voorspellende politieprogramma verlaagd, waarbij de kosten de schuld waren. “Dat is een moeilijke beslissing”, zegt politiechef Michel Moore

vertelde de LA Times. “Het is een strategie die we hebben gebruikt, maar de kostenprojecties van honderdduizenden dollars om daaraan te besteden Nu moet ik dat geld vinden en dat geld besteden aan andere, meer centrale activiteiten.”Aanbevolen video's

Wat ging er mis? Hoe kan iets dat wordt geadverteerd als ‘slimme’ technologie leiden tot nog meer diepgewortelde vooroordelen en discriminatie? En is de droom van voorspellend politiewerk een droom die kan worden aangepast met het juiste algoritme – of is dit een doodlopende weg in een eerlijkere samenleving die momenteel worstelt met de manier waarop de politie zou moeten opereren?

De belofte van voorspellend politiewerk

Predictive policing in zijn huidige vorm dateert van ongeveer tien jaar geleden, naar een artikel uit 2009 van psycholoog Colleen McCue en politiechef Charlie Beck uit Los Angeles, getiteld “Predictive Policing: wat kunnen we leren van Walmart en Amazon over het bestrijden van misdaad in een recessie?In de krant grepen ze de manier aan waarop big data door grote retailers worden gebruikt om patronen in het klantgedrag uit het verleden te helpen ontdekken die kunnen worden gebruikt om toekomstig gedrag te voorspellen. Dankzij de vooruitgang op het gebied van computergebruik en gegevensverzameling suggereerden McCue en Beck dat het mogelijk was misdaadgegevens in realtime te verzamelen en te analyseren. Deze gegevens kunnen vervolgens worden gebruikt om misdaden die nog niet hebben plaatsgevonden te anticiperen, te voorkomen en effectiever te reageren.

In de jaren daarna is voorspellend politiewerk in veel delen van de Verenigde Staten, samen met de rest van de wereld, van een wegwerpidee uitgegroeid tot een realiteit. Daarbij heeft zij zich ten doel gesteld het politiewerk te veranderen van een reactieve macht in een proactieve macht; voortbouwend op enkele van de doorbraken in datagestuurde technologie die het mogelijk maken om patronen in realtime te ontdekken – en ernaar te handelen.

‘Er zijn twee belangrijke vormen van voorspellend politiewerk’ Andreas Ferguson, hoogleraar rechten aan de Universiteit van het District of Columbia David A. Clarke School of Law en auteur van De opkomst van big data-politie: surveillance, ras en de toekomst van wetshandhaving, vertelde Digitale Trends. “[Dit zijn] plaatsgebaseerd voorspellend politiewerk en persoonsgebaseerd voorspellend politiewerk.”

In beide gevallen kennen de voorspellende politiesystemen een risicoscore toe aan de persoon of plaats in kwestie, wat de politie aanmoedigt om met een bepaald interval op te treden. De eerste van deze benaderingen, plaatsgebaseerd voorspellend politiewerk, richt zich voornamelijk op politiepatrouilles. Het omvat het gebruik van misdaadkartering en analyses over de waarschijnlijke plaatsen van toekomstige misdaden, gebaseerd op eerdere statistieken.

In plaats van te helpen problemen als racisme en andere systemische vooroordelen weg te nemen, kan voorspellend politiewerk juist helpen deze te verankeren.

De tweede benadering richt zich op het voorspellen van de waarschijnlijkheid dat een individu een potentieel toekomstig risico vormt. In 2013 werd bijvoorbeeld een politiecommandant van Chicago naar het huis van de 22-jarige Robert McDaniel gestuurd. die door een agent was gemarkeerd als een potentieel risico of dader van wapengeweld in de binnenstad van Chicago algoritme. De ‘heat list’ die het algoritme hielp samenstellen, zocht naar patronen die toekomstige overtreders zouden kunnen voorspellen of slachtoffers, zelfs als ze zelf niets hadden gedaan om dit onderzoek te rechtvaardigen, behalve het voldoen aan a profiel.

Zoals de merkte de Chicago Tribune op: “De strategie roept op tot het individueel waarschuwen van degenen op de hittelijst dat verdere criminele activiteiten, zelfs bij de kleinste overtredingen zal dit tot gevolg hebben dat de volledige kracht van de wet wordt toegepast hen."

De droom van voorspellend politiewerk was dat het, door op kwantificeerbare gegevens te reageren, het politiewerk niet alleen efficiënter zou maken, maar ook minder vatbaar voor giswerk en, als gevolg daarvan, vooroordelen. Het zou, zo beweerden de voorstanders, het politiewerk ten goede veranderen en een nieuw tijdperk van slim politiewerk inluiden. Vanaf vrijwel het allereerste begin heeft voorspellend politiewerk echter fervente critici gehad. Ze beweren dat voorspellend politiewerk problemen als racisme en andere systemische vooroordelen niet helpt wegnemen, maar juist kan helpen deze te verankeren. En het is moeilijk te beweren dat ze geen punt hebben.

Discriminerende algoritmen

Het idee dat op machine learning gebaseerde voorspellende politiesystemen kunnen leren discrimineren op basis van factoren zoals ras is niets nieuws. Machine learning-tools worden getraind met enorme hoeveelheden data. En zolang die gegevens worden verzameld door een systeem waarin ras een overweldigende factor blijft, kan dat tot discriminatie leiden.

Zoals Renata M. O’Donnell schrijft in een artikel uit 2019, getiteld “Racistische voorspellende politie-algoritmen uitdagen onder de clausule inzake gelijke bescherming”, leren machine learning-algoritmen van gegevens die zijn afgeleid van een rechtssysteem waarin “zwarte Amerikanen in een tempo worden opgesloten in staatsgevangenissen dat is 5,1 keer zoveel als de gevangenschap van blanken, en één op de drie zwarte mannen die vandaag de dag geboren worden, kan verwachten tijdens zijn leven de gevangenis in te gaan als de huidige trends doorgaan."

“Gegevens zijn niet objectief”, vertelde Ferguson aan Digital Trends. “Wij zijn gewoon gereduceerd tot binaire code. Datagestuurde systemen die in de echte wereld opereren, zijn niet objectiever, eerlijker of onbevooroordeelder dan de echte wereld. Als uw echte wereld structureel ongelijk of racistisch discriminerend is, zal een datagestuurd systeem deze maatschappelijke ongelijkheden weerspiegelen. De input die binnenkomt, is besmet met vooringenomenheid. De analyse is besmet met vooringenomenheid. En de mechanismen van het politiegezag veranderen niet alleen omdat er technologie is die de systemen stuurt.”

Ferguson geeft het voorbeeld van arrestaties als een schijnbaar objectieve factor bij het voorspellen van risico's. Arrestaties zullen echter vertekend zijn door de toewijzing van politiemiddelen (zoals waar ze patrouilleren) en de soorten misdaden die doorgaans arrestaties rechtvaardigen. Dit is slechts één voorbeeld van potentieel problematische gegevens.

De gevaren van vervuilde data

Ontbrekende en onjuiste gegevens worden in de datamining soms ‘vuile gegevens’ genoemd. A Paper uit 2019 van onderzoekers van de A.I. Nu Instituut aan de Universiteit van New York breidt deze term uit om ook te verwijzen naar gegevens die zijn beïnvloed door corrupt, bevooroordeeld en onwettig praktijken – of die nu opzettelijk zijn gemanipuleerd of vervormd door individuele personen maatschappelijke vooroordelen. Het kan bijvoorbeeld gaan om gegevens die zijn gegenereerd bij de arrestatie van een onschuldige persoon op wie bewijsmateriaal is geplaatst of die op een andere manier valselijk wordt beschuldigd.

Er schuilt een zekere ironie in het feit dat de afgelopen decennia de eisen van de datamaatschappij zijn toegenomen alles draait om kwantificering en ijzersterke numerieke doelstellingen, heeft zojuist geleid tot een heleboel... nou ja, echt waar slechte gegevens. De HBO-serie De draad toonde het echte fenomeen van ‘het voor de gek houden van de statistieken’, en de jaren sinds de show uit de lucht ging, hebben veel opgeleverd voorbeelden van daadwerkelijke systemische gegevensmanipulatie, vervalste politierapporten en ongrondwettelijke praktijken waar onschuldige mensen naartoe zijn gestuurd gevangenis.

Slechte gegevens waarmee machthebbers kunstmatig doelwitten kunnen raken, is één ding. Maar combineer dat met algoritmen en voorspellende modellen die dit gebruiken als basis voor het modelleren van de wereld en je krijgt mogelijk iets veel ergers.

Onderzoekers hebben aangetoond hoe twijfelachtige misdaadgegevens, ingeplugd in voorspellende politie-algoritmen, kunnen leiden tot wat wordt aangeduid als “op hol geslagen feedbackloops”, waarbij de politie herhaaldelijk naar dezelfde buurten wordt gestuurd, ongeacht het werkelijke misdaadcijfer. Een van de co-auteurs van dat artikel, computerwetenschapper Suresh Venkatasubramanian, zegt dat machine learning-modellen via hun modellering foutieve aannames kunnen inbouwen. Net als het oude gezegde over hoe voor de persoon met een hamer elk probleem op een spijker lijkt, modelleren deze systemen slechts bepaalde elementen van een probleem – en stellen zich slechts één mogelijke uitkomst voor.

“[Iets dat] in deze modellen niet aan de orde komt, is in hoeverre je het feit modelleert dat het gooien van meer agenten in een gebied feitelijk kan leiden de levenskwaliteit van de mensen die daar wonen verminderen?” Venkatasubramanian, een professor aan de School of Computing aan de Universiteit van Utah, vertelde Digital Trends. “Wij gaan ervan uit dat meer politie een betere zaak is. Maar zoals we nu zien, is het hebben van meer politie niet noodzakelijk een goede zaak. Het kan de zaken zelfs erger maken. In geen enkel model dat ik ooit heb gezien, heeft iemand zich ooit afgevraagd wat de kosten zijn van het inzetten van meer politie in een gebied.”

De onzekere toekomst van voorspellend politiewerk

Degenen die werkzaam zijn op het gebied van voorspellend politiewerk gebruiken soms op onironische wijze de term ‘Minority Report’ om te verwijzen naar het soort voorspellingen dat ze doen. De term wordt vaak gebruikt als verwijzing naar de Gelijknamige film uit 2002, dat op zijn beurt losjes gebaseerd was op een kort verhaal uit 1956 van Philip K. Dick. In Minderheidsverslag, arresteert een speciale PreCrime-politieafdeling criminelen op basis van voorkennis van misdaden die in de toekomst zullen worden gepleegd. Deze voorspellingen worden gedaan door drie helderzienden die ‘precogs’ worden genoemd.

Maar de twist erin Minderheidsverslag is dat de voorspellingen niet altijd accuraat zijn. Afwijkende visies van een van de precogs bieden een alternatieve kijk op de toekomst, die wordt onderdrukt uit angst het systeem onbetrouwbaar te laten lijken.

Interne audits die aantonen dat de tactiek niet werkte. Niet alleen waren de voorspellende lijsten gebrekkig, maar ze waren ook ineffectief.

Op dit moment wordt voorspellend politiewerk geconfronteerd met zijn eigen onzekere toekomst. Naast nieuwe technologieën zoals gezichtsherkenning is de technologie die wetshandhavers beschikbaar hebben voor mogelijk gebruik nog nooit zo krachtig geweest. Tegelijkertijd heeft het bewustzijn van het gebruik van voorspellend politiewerk een publieke reactie veroorzaakt die er mogelijk zelfs toe heeft bijgedragen deze te vernietigen. Ferguson vertelde Digital Trends dat het gebruik van voorspellende politie-instrumenten de afgelopen jaren een “teruggang” heeft gekend.

“Op zijn hoogtepunt was [plaatsgebaseerd voorspellend politiewerk] aanwezig in meer dan zestig grote steden en groeide het, maar als gevolg van succesvolle gemeenschapsorganisatie is het grotendeels verminderd en/of vervangen door andere vormen van datagedrevenheid analyses”, zei hij. “Kortom: de term voorspellend politiewerk werd giftig, en politiekorpsen leerden een andere naam te geven aan wat ze met data deden. Persoonsgericht voorspellend politiewerk kende een sterkere daling. De twee belangrijkste steden die in de oprichting ervan hebben geïnvesteerd – Chicago en Los Angeles – hebben zich teruggetrokken uit hun persoonlijke aanpak strategieën na scherpe kritiek uit de gemeenschap en verwoestende interne audits die aantonen dat de tactieken dat niet deden werk. Niet alleen waren de voorspellende lijsten gebrekkig, ze waren ook ineffectief.”

Het verkeerde gereedschap voor de klus?

Echter, Rashida Richardson, directeur beleidsonderzoek bij de A.I. Nu zei het Instituut dat er te veel onduidelijkheid bestaat over het gebruik van deze technologie. “We weten het nog steeds niet vanwege het gebrek aan transparantie met betrekking tot de verwerving van technologie door de overheid mazen in de bestaande aanbestedingsprocedures die bepaalde technologie-aankopen kunnen beschermen tegen publieke controle.” ze zei. Ze geeft het voorbeeld van technologie die gratis aan een politiebureau kan worden gegeven of door een derde partij kan worden gekocht. “We weten uit onderzoek zoals het mijne en uit berichtgeving in de media dat veel van de grootste politiediensten in de VS de technologie op een gegeven moment, maar er zijn ook veel kleine politie-afdelingen die er gebruik van maken, of deze gedurende een beperkte periode hebben gebruikt van tijd."

Zal er, gegeven de huidige vragen over de rol van de politie, een verleiding zijn om deze opnieuw te omarmen? voorspellend politiewerk als instrument voor datagestuurde besluitvorming – misschien onder minder dystopische sciencefiction branding? De mogelijkheid bestaat dat zo’n heropleving zich voordoet. Maar Venkatasubramanian is zeer sceptisch over het feit dat machinaal leren, zoals het momenteel wordt toegepast, het juiste hulpmiddel is voor deze taak.

“Het geheel van machinaal leren en het succes ervan in de moderne samenleving is gebaseerd op het uitgangspunt dat, ongeacht de feitelijke situatie probleem komt het uiteindelijk neer op het verzamelen van data, het bouwen van een model, het voorspellen van de uitkomst – en je hoeft je geen zorgen te maken over het domein,” hij zei. “Je kunt dezelfde code schrijven en op 100 verschillende plaatsen toepassen. Dat is de belofte van abstractie en draagbaarheid. Het probleem is dat wanneer we gebruik maken van wat mensen socio-technische systemen noemen, waarbij mensen en technologie verweven zijn in ingewikkelde golven, je dit niet kunt doen. Je kunt niet zomaar een onderdeel aansluiten en verwachten dat het werkt. Omdat er rimpeleffecten zijn bij het plaatsen van dat stuk en het feit dat er verschillende zijn spelers met verschillende agenda’s in een dergelijk systeem, en zij ondermijnen het systeem naar hun eigen behoeften verschillende manieren. Met al deze dingen moet rekening worden gehouden als je het over effectiviteit hebt. Ja, je kunt in abstracte zin zeggen dat alles goed zal werken, maar daar is geen samenvatting. Er is alleen de context waarin je werkt.”