Het constante geroezemoes in de buurt ChatGPT van OpenAI weigert af te nemen. Nu Microsoft dezelfde technologie gebruikt om zijn gloednieuwe Bing Chat, is het veilig om te zeggen dat ChatGPT deze opwaartse trend nog geruime tijd kan voortzetten. Dat is goed nieuws voor OpenAI en Microsoft, maar zij zijn niet de enige twee bedrijven die hiervan profiteren.

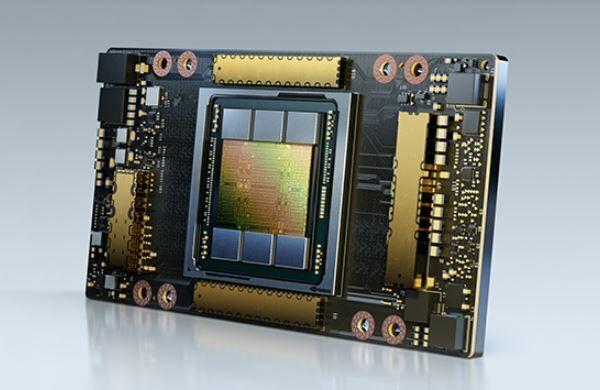

Volgens een nieuw rapport zijn de verkopen van het datacenter van Nvidia grafische kaarten kan op het punt staan omhoog te schieten. Met de commercialisering van ChatGPT heeft OpenAI misschien wel 10.000 nieuwe GPU's nodig om het groeiende model te ondersteunen - en Nvidia lijkt de meest waarschijnlijke leverancier.

Onderzoeksbureau TrendForce heeft vandaag enkele interessante schattingen gedeeld, en het meest interessante deel heeft betrekking op de toekomst van ChatGPT. Volgens TrendForce heeft het GPT-model dat ChatGPT aandrijft binnenkort een aanzienlijke toename van hardware nodig om de ontwikkeling op te schalen.

Aanbevolen video's

"Het aantal trainingsparameters dat werd gebruikt bij de ontwikkeling van dit autoregressieve taalmodel steeg van ongeveer 120 miljoen in 2018 tot bijna 180 miljard in 2020", aldus TrendForce in zijn rapport. Hoewel het geen schattingen voor 2023 deelde, is het veilig om aan te nemen dat deze cijfers alleen zullen blijven stijgen voor zover de technologie en het budget dit toelaten.

Het bedrijf beweert dat het GPT-model in 2020 maar liefst 20.000 grafische kaarten nodig had om trainingsgegevens te verwerken. Naarmate het bedrijf blijft groeien, zal dat aantal naar verwachting stijgen tot boven de 30.000. Dit zou geweldig nieuws kunnen zijn voor Nvidia.

Deze berekeningen zijn gebaseerd op de aanname dat OpenAI de A100 GPU's van Nvidia zou gebruiken om het taalmodel aan te drijven. Deze ultrakrachtige grafische kaarten zijn erg prijzig - in de marge van $ 10.000 tot $ 15.000 per stuk. Het zijn op dit moment ook niet de beste datacenterkaarten van Nvidia, dus het is mogelijk dat OpenAI voor de nieuwere H100-kaarten in plaats daarvan, die tot drie keer de prestaties zouden moeten leveren van A100. Deze GPU's hebben een sterke prijsstijging, waarbij één kaart ongeveer $ 30.000 of meer kost.

De GPU-markt voor datacenters bestaat niet alleen uit Nvidia - Intel en AMD verkopen ook AI-versnellers. Echter, Nvidia wordt vaak gezien als dé oplossing voor AI-gerelateerde taken, dus het is mogelijk dat het een lucratieve deal kan scoren als en wanneer OpenAI besluit om op te schalen.

Moeten gamers zich zorgen maken als Nvidia uiteindelijk maar liefst 10.000 GPU's levert om ChatGPT van stroom te voorzien? Het hangt er van af. De door OpenAI vereiste grafische kaarten hebben niets te maken met die van Nvidia beste GPU's voor gamers, dus daar zijn we veilig. Als Nvidia echter een deel van de productie verschuift naar datacenter-GPU's, kunnen we een beperkt aanbod van consumenten zien

Aanbevelingen van de redactie

- Topauteurs eisen betaling van AI-bedrijven voor het gebruik van hun werk

- GPT-4: hoe de AI-chatbot te gebruiken die ChatGPT te schande maakt

- Wix gebruikt ChatGPT om u te helpen snel een volledige website te bouwen

- ChatGPT-maker OpenAI wordt geconfronteerd met FTC-onderzoek over wetten voor consumentenbescherming

- Het verkeer op de ChatGPT-website is voor het eerst gedaald

Upgrade je levensstijlDigital Trends helpt lezers de snelle wereld van technologie in de gaten te houden met het laatste nieuws, leuke productrecensies, verhelderende hoofdartikelen en unieke sneak peeks.