במהלך GTC 2022 בכנס, Nvidia דיברה על שימוש בבינה מלאכותית ולמידת מכונה כדי ליצור כרטיסי מסך עתידיים יותר טוב מתמיד.

מכיוון שהחברה בוחרת לתת עדיפות לבינה מלאכותית ולמידת מכונה (ML), חלק מההתקדמות הללו כבר ימצאו את דרכן למעבדי ה-GPU של Ada Lovelace מהדור הבא.

התוכניות הגדולות של Nvidia עבור AI ו-ML בכרטיסי מסך מהדור הבא היו משותפות על ידי ביל דאלי, המדען הראשי של החברה וסגן נשיא בכיר למחקר. הוא דיבר על צוותי המחקר והפיתוח של Nvidia, כיצד הם משתמשים בבינה מלאכותית ולמידת מכונה (ML), ומה זה אומר עבור GPUs מהדור הבא.

סרטונים מומלצים

בקיצור, שימוש בטכנולוגיות אלו יכול להיות רק דברים טובים עבור כרטיסי מסך של Nvidia. דאלי דן בארבעה חלקים עיקריים של עיצוב GPU, כמו גם בדרכים שבהן שימוש ב-AI ו-ML יכול להאיץ באופן דרסטי את ביצועי ה-GPU.

המטרה היא עלייה במהירות וביעילות כאחד, והדוגמה של דאלי מדברת על איך שימוש ב-AI ו-ML יכול להוריד משימת עיצוב GPU סטנדרטית משלוש שעות לשלוש שניות בלבד.

שימוש בבינה מלאכותית ולמידת מכונה יכול לעזור לייעל את כל התהליכים הללו.

זה אפשרי לכאורה על ידי אופטימיזציה של עד ארבעה תהליכים שבדרך כלל לוקחים הרבה זמן והם מפורטים מאוד.

הכוונה היא לניטור ומיפוי של נפילות מתח, ציפייה לשגיאות באמצעות חיזוי טפילי, אוטומציה סטנדרטית של נדידת תאים וטיפול באתגרי ניתוב שונים. שימוש בבינה מלאכותית ולמידת מכונה יכול לעזור לייעל את כל התהליכים הללו, וכתוצאה מכך לרווחים גדולים במוצר הסופי.

מיפוי ירידות פוטנציאליות במתח עוזר ל-Nvidia לעקוב אחר זרימת הכוח של כרטיסים גרפיים מהדור הבא. לדברי דאלי, מעבר משימוש בכלים סטנדרטיים לכלי AI מיוחדים יכול להאיץ את המשימה הזו בצורה דרסטית, מכיוון שהטכנאי החדש יכול לבצע משימות כאלה בשניות בלבד.

דאלי אמר ששימוש ב-AI ו-ML למיפוי נפילות מתח יכול להגביר את הדיוק ב-94% ובמקביל גם להגדיל בצורה אדירה את המהירות שבה משימות אלו מבוצעות.

זרימת נתונים בשבבים חדשים היא גורם חשוב במידת היעילות של חדש כרטיס מסך מבצע. לכן, Nvidia משתמשת ברשתות עצביות גרפיות (GNN) כדי לזהות בעיות אפשריות בזרימת הנתונים ולטפל בהן במהירות.

חיזוי טפילי באמצעות שימוש ב-AI הוא תחום נוסף בו Nvidia רואה שיפורים, מציינת דיוק מוגבר, עם שיעורי שגיאות סימולציה יורדים מתחת ל-10 אחוזים.

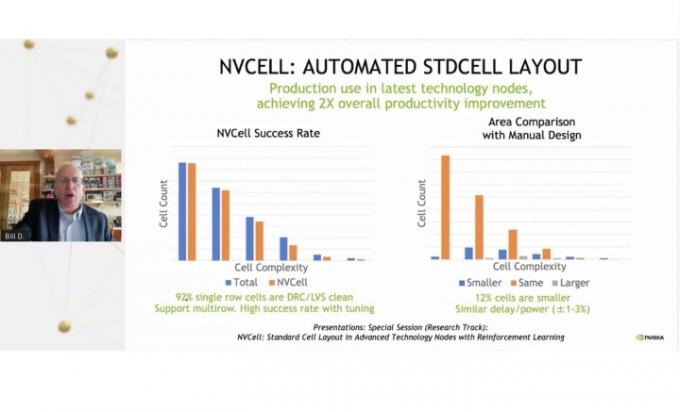

Nvidia גם הצליחה להפוך את תהליך העברת התאים הסטנדרטיים של השבב לאוטומטי, לקצץ בזמן ההשבתה הרבה ולהאיץ את כל המשימה. עם זאת, 92% מספריית התאים הועברו באמצעות שימוש בכלי ללא שגיאות.

החברה מתכננת להתמקד בבינה מלאכותית ולמידת מכונה בעתיד, ולהקדיש חמש מהמעבדות שלה למחקר ותכנון פתרונות חדשים בקטעים אלה. דאלי רמז שאולי נראה את התוצאות הראשונות של ההתפתחויות החדשות הללו בעיצובים החדשים של 7nm ו-5nm של Nvidia, הכוללים את ה-Ada Lovelace GPUs הקרובים. זה דווח לראשונה על ידי Wccftech.

זה לא סוד שהדור הבא של כרטיסים גרפיים, המכונה לעתים קרובות RTX 4000, יהיה חזק מאוד (עם דרישות הספק כדי להתאים). שימוש בבינה מלאכותית ולמידת מכונה כדי לקדם את הפיתוח של ה-GPUs הללו מרמז שייתכן שבקרוב תהיה לנו תחנת כוח אמיתית בידנו.

המלצות עורכים

- הצעת השלום של Nvidia לא עובדת

- ה-Nvidia GPU המסתורי הזה הוא מפלצתיות מוחלטת - והרגע קיבלנו מבט נוסף

- מדוע ה-GPU החדש של Nvidia מתפקד גרוע יותר מאשר גרפיקה משולבת

- RTX 4060 של Nvidia עשוי להגיע מוקדם מהצפוי

- AMD עשויה לרסק את Nvidia עם ה-GPUs של המחשב הנייד שלה - אבל היא שקטה בחזית שולחן העבודה

שדרג את אורח החיים שלךמגמות דיגיטליות עוזרות לקוראים לעקוב אחר עולם הטכנולוגיה המהיר עם כל החדשות האחרונות, ביקורות מהנות על מוצרים, מאמרי מערכת מעוררי תובנות והצצות מיוחדות במינן.