Polizia predittiva avrebbe dovuto trasformare il modo in cui veniva svolta l’attività di polizia, introducendoci in un mondo di leggi intelligenti applicazione in cui i pregiudizi venissero rimossi e la polizia sarebbe stata in grado di rispondere ai dati, non di farlo intuizioni. Ma un decennio dopo che la maggior parte di noi ha sentito per la prima volta il termine “polizia predittiva”, sembra chiaro che non ha funzionato. Spinta dalla reazione pubblica, la tecnologia sta registrando un calo significativo nel suo utilizzo, rispetto a pochi anni fa.

Contenuti

- La promessa della polizia predittiva

- Algoritmi discriminatori

- I pericoli dei dati sporchi

- Il futuro incerto della polizia predittiva

- Gli strumenti sbagliati per il lavoro?

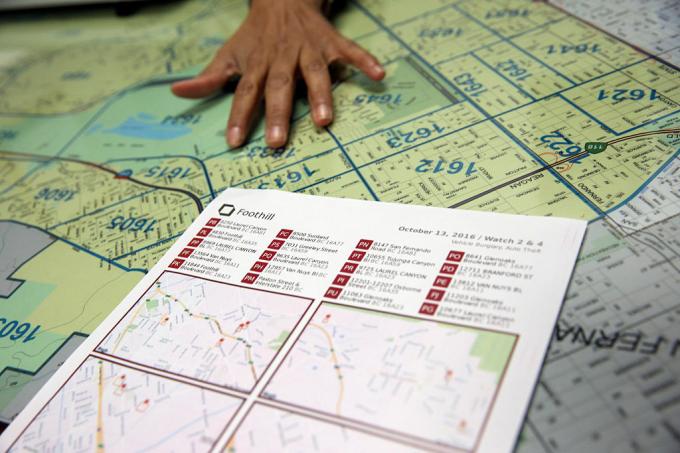

Nell’aprile di quest’anno, Los Angeles – che, secondo il LA Times, “ha aperto la strada alla previsione del crimine con i dati” – ha tagliato i finanziamenti per il suo programma di polizia predittiva, accusandone i costi. "È una decisione difficile", ha affermato il capo della polizia Michel Moore

ha detto al LA Times. “È una strategia che abbiamo utilizzato, ma le proiezioni dei costi ammontano a centinaia di migliaia di dollari da spendere per questo diritto ora invece di trovare quei soldi e indirizzarli verso altre attività più centrali è ciò che devo fare.Video consigliati

Che cosa è andato storto? Come potrebbe qualcosa pubblicizzato come tecnologia “intelligente” finire per radicare ulteriormente pregiudizi e discriminazioni? E il sogno della polizia predittiva è qualcosa che potrebbe essere modificato con il giusto algoritmo – o un vicolo cieco in una società più giusta che è attualmente alle prese con il modo in cui la polizia dovrebbe operare?

La promessa della polizia predittiva

La polizia predittiva nella sua forma attuale risale a circa un decennio fa, a un articolo del 2009 della psicologa Colleen McCue e del capo della polizia di Los Angeles Charlie Beck, intitolato “Polizia predittiva: cosa possiamo imparare da Walmart e Amazon sulla lotta alla criminalità in una fase di recessione?Nel documento, hanno sfruttato il modo in cui i big data venivano utilizzati dai principali rivenditori per aiutare a scoprire modelli nel comportamento passato dei clienti che potrebbero essere utilizzati per prevedere il comportamento futuro. Grazie ai progressi sia nell’informatica che nella raccolta dei dati, McCue e Beck suggerirono che fosse possibile raccogliere e analizzare i dati sulla criminalità in tempo reale. Questi dati potrebbero quindi essere utilizzati per anticipare, prevenire e rispondere in modo più efficace ai crimini che non si sono ancora verificati.

Negli anni successivi, la polizia predittiva è passata da un’idea usa e getta a una realtà in molte parti degli Stati Uniti, insieme al resto del mondo. Nel processo, si è proposto di trasformare la polizia da una forza reattiva a una forza proattiva; attingendo ad alcune delle scoperte della tecnologia basata sui dati che consentono di individuare modelli in tempo reale e agire di conseguenza.

“Esistono due forme principali di polizia predittiva”, Andrea Ferguson, professore di diritto presso l'Università del Distretto di Columbia David A. Clarke School of Law e autore di L'ascesa della polizia dei Big Data: sorveglianza, razza e il futuro delle forze dell'ordine, ha detto a Digital Trends. “[Si tratta] di polizia predittiva basata sul luogo e di polizia predittiva basata sulla persona”.

In entrambi i casi, i sistemi di polizia predittiva assegnano un punteggio di rischio alla persona o al luogo in questione, incoraggiando la polizia a intervenire a un dato intervallo. Il primo di questi approcci, la polizia predittiva basata sul luogo, si concentra prevalentemente sulle pattuglie di polizia. Implica l’uso della mappatura del crimine e dell’analisi dei probabili luoghi di crimini futuri, sulla base di statistiche precedenti.

Invece di contribuire a eliminare problemi come il razzismo e altri pregiudizi sistemici, la polizia predittiva può effettivamente contribuire a radicarli.

Il secondo approccio si concentra sulla previsione della probabilità che un individuo rappresenti un potenziale rischio futuro. Ad esempio, nel 2013, un comandante della polizia di Chicago è stato inviato a casa del 22enne Robert McDaniel, che era stato segnalato come potenziale rischio o autore di violenza armata nel centro di Chicago da un algoritmo. La “lista termica” che l’algoritmo ha aiutato a mettere insieme ha cercato modelli che potessero essere in grado di prevedere futuri delinquenti o vittime, anche se loro stesse non avevano fatto nulla per giustificare questo esame oltre a conformarsi ad a profilo.

Come il Lo ha notato il Chicago Tribune: “La strategia prevede di avvertire individualmente quelli sulla lista nera che ulteriori attività criminali, anche per i reati più insignificanti, ciò comporterà l’abbattimento di tutta la forza della legge loro."

Il sogno della polizia predittiva era che, agendo sulla base di dati quantificabili, avrebbe reso la polizia non solo più efficiente, ma anche meno incline a congetture e, di conseguenza, a pregiudizi. Secondo i sostenitori, ciò cambierebbe in meglio la polizia e inaugurerebbe una nuova era di polizia intelligente. Tuttavia, fin quasi dall’inizio, la polizia predittiva ha avuto critici accaniti. Sostengono che, invece di contribuire a eliminare problemi come il razzismo e altri pregiudizi sistemici, la polizia predittiva potrebbe effettivamente contribuire a radicarli. Ed è difficile sostenere che non abbiano ragione.

Algoritmi discriminatori

L’idea che i sistemi di polizia predittiva basati sull’apprendimento automatico possano imparare a discriminare in base a fattori come la razza non è una novità. Gli strumenti di apprendimento automatico vengono addestrati con enormi quantità di dati. E, finché tali dati vengono raccolti da un sistema in cui la razza continua a essere un fattore preponderante, ciò può portare alla discriminazione.

Come Renata M. O'Donnell scrive in un articolo del 2019, intitolato "Sfidare gli algoritmi di polizia predittiva razzista ai sensi della clausola di pari protezione", gli algoritmi di apprendimento automatico stanno imparando dai dati derivati da un sistema giudiziario in cui "i neri americani sono incarcerati nelle carceri statali a un ritmo cioè 5,1 volte la reclusione dei bianchi, e un uomo nero su tre nato oggi può aspettarsi di andare in prigione nel corso della sua vita se le tendenze attuali Continua."

“I dati non sono oggettivi”, ha detto Ferguson a Digital Trends. “Siamo solo noi ridotti a codice binario. I sistemi basati sui dati che operano nel mondo reale non sono più obiettivi, equi o imparziali del mondo reale. Se il tuo mondo reale è strutturalmente disuguale o razzialmente discriminatorio, un sistema basato sui dati rispecchierà quelle disuguaglianze sociali. Gli input in entrata sono contaminati da pregiudizi. L’analisi è viziata da pregiudizi. E i meccanismi dell’autorità di polizia non cambiano solo perché c’è la tecnologia che guida i sistemi”.

Ferguson cita l’esempio degli arresti come un fattore apparentemente oggettivo nella previsione del rischio. Tuttavia, gli arresti saranno influenzati dall’allocazione delle risorse della polizia (come ad esempio il luogo in cui pattuglia) e dai tipi di crimine che tipicamente giustificano gli arresti. Questo è solo un esempio di dati potenzialmente problematici.

I pericoli dei dati sporchi

Nel data mining i dati mancanti e errati vengono talvolta definiti “dati sporchi”. UN Articolo del 2019 dei ricercatori dell'A.I. Ora Istituto presso la New York University espande questo termine per riferirsi anche a dati influenzati da corruzione, parzialità e illegalità pratiche - sia che provengano da manipolazioni intenzionali che siano distorte dall'individuo e pregiudizi sociali. Potrebbero, ad esempio, includere dati generati dall’arresto di una persona innocente sulla quale sono state depositate prove o che è altrimenti accusata ingiustamente.

C'è una certa ironia nel fatto che, negli ultimi decenni, le richieste della società dei dati, in cui tutto riguarda la quantificazione e obiettivi numerici ferrei, ha appena portato a un sacco di... beh, davvero dati errati. La serie HBO Il cavo ha messo in mostra il fenomeno reale del “truccare le statistiche” e gli anni trascorsi da quando lo show è andato in onda hanno offerto un sacco di esempi di effettiva manipolazione sistemica dei dati, rapporti di polizia falsi e pratiche incostituzionali che hanno mandato persone innocenti prigione.

Una cosa sono i dati errati che consentono a chi detiene il potere di colpire artificialmente obiettivi. Ma combinandolo con algoritmi e modelli predittivi che lo utilizzano come base per modellare il mondo, si ottiene potenzialmente qualcosa di molto peggio.

I ricercatori hanno dimostrato come dati discutibili sulla criminalità inseriti negli algoritmi di polizia predittiva possano creare ciò che viene definito “cicli di feedback fuori controllo”, in cui la polizia viene ripetutamente inviata negli stessi quartieri indipendentemente dal reale tasso di criminalità. Uno dei coautori di quell'articolo, l'informatico Suresh Venkatasubramanian, afferma che i modelli di apprendimento automatico possono basarsi su presupposti errati attraverso la loro modellazione. Come il vecchio detto secondo cui, per la persona con un martello, ogni problema assomiglia a un chiodo, questi sistemi modellano solo alcuni elementi di un problema e immaginano solo un possibile risultato.

"[Qualcosa che] non viene affrontato in questi modelli è fino a che punto stai modellando il fatto che lanciare più poliziotti in un'area può effettivamente abbassare la qualità della vita delle persone che vivono lì?” Venkatasubramanian, professore alla School of Computing dell'Università dello Utah, ha detto a Digital Tendenze. “Diamo per scontato che più poliziotti siano una cosa migliore. Ma come stiamo vedendo in questo momento, avere più polizia non è necessariamente una buona cosa. Può effettivamente peggiorare le cose. In nessun modello che abbia mai visto qualcuno si è mai chiesto quale sia il costo di mettere più polizia in un’area”.

Il futuro incerto della polizia predittiva

Coloro che lavorano nella polizia predittiva a volte usano senza ironia il termine “Minority Report” per riferirsi al tipo di previsione che stanno facendo. Il termine è spesso invocato come riferimento al Film del 2002 con lo stesso nome, che a sua volta era vagamente basato su un racconto del 1956 di Philip K. Cazzo. In Rapporto di minoranza, uno speciale dipartimento di polizia PreCrime cattura i criminali basandosi sulla conoscenza anticipata dei crimini che verranno commessi in futuro. Queste previsioni sono fornite da tre sensitivi chiamati “precog”.

Ma la svolta Rapporto di minoranza è che le previsioni non sono sempre accurate. Le visioni dissenzienti di uno dei precog forniscono una visione alternativa del futuro, che viene soppressa per paura di far sembrare il sistema inaffidabile.

Audit interni che mostrano che le tattiche non hanno funzionato. Non solo gli elenchi predittivi erano viziati, ma erano anche inefficaci.

In questo momento, la polizia predittiva si trova ad affrontare il proprio futuro incerto. Oltre alle nuove tecnologie come il riconoscimento facciale, la tecnologia a disposizione delle forze dell’ordine per un possibile utilizzo non è mai stata così potente. Allo stesso tempo, la consapevolezza dell’uso della polizia predittiva ha causato una reazione pubblica che potrebbe effettivamente aver contribuito a reprimerla. Ferguson ha dichiarato a Digital Trends che l’uso di strumenti di polizia predittiva è in “flessione” negli ultimi anni.

“Al suo apice, [la polizia predittiva basata sul luogo] era presente in oltre 60 grandi città ed era in crescita, ma come risultato organizzazione di comunità di successo, è stata in gran parte ridotta e/o sostituita con altre forme basate sui dati analisi", ha detto. “In breve, il termine polizia predittiva è diventato tossico e i dipartimenti di polizia hanno imparato a rinominare ciò che facevano con i dati. La polizia predittiva basata sulla persona ha avuto un calo più marcato. Le due principali città che hanno investito nella sua creazione – Chicago e Los Angeles – hanno rinunciato al loro approccio basato sulla persona strategie dopo aspre critiche da parte della comunità e devastanti audit interni che dimostrano che le tattiche non hanno funzionato lavoro. Non solo gli elenchi predittivi erano viziati, ma erano anche inefficaci”.

Gli strumenti sbagliati per il lavoro?

Tuttavia, Rashida Richardson, Direttore della ricerca politica presso l'A.I. Ora l'Istituto ha affermato che c'è troppa opacità sull'uso di questa tecnologia. “Ancora non lo sappiamo a causa della mancanza di trasparenza riguardo all’acquisizione di tecnologia da parte del governo e molte altre lacune nelle procedure di appalto esistenti che potrebbero proteggere alcuni acquisti tecnologici dal controllo pubblico," lei disse. Fa l'esempio della tecnologia che potrebbe essere fornita gratuitamente a un dipartimento di polizia o acquistata da terzi. “Sappiamo da ricerche come la mia e dai resoconti dei media che molti dei più grandi dipartimenti di polizia degli Stati Uniti hanno utilizzato il tecnologia ad un certo punto, ma ci sono anche molti piccoli dipartimenti di polizia che la stanno usando, o l’hanno usata per periodi limitati di tempo."

Date le attuali domande sul ruolo della polizia, ci sarà la tentazione di riabbracciarlo la polizia predittiva come strumento per il processo decisionale basato sui dati, forse in un contesto di fantascienza meno distopica marchio? C’è la possibilità che una tale rinascita possa emergere. Ma Venkatasubramanian è molto scettico sul fatto che l’apprendimento automatico, come attualmente praticato, sia lo strumento giusto per questo lavoro.

“L’intero machine learning e il suo successo nella società moderna si basano sulla premessa che, qualunque sia la realtà problema, alla fine si riduce a raccogliere dati, costruire un modello, prevedere i risultati – e non devi preoccuparti del dominio," Egli ha detto. “Puoi scrivere lo stesso codice e applicarlo in 100 posti diversi. Questa è la promessa di astrazione e portabilità. Il problema è che quando usiamo quelli che la gente chiama sistemi socio-tecnici, dove gli esseri umani e la tecnologia sono intrecciati in onde complicate, non è possibile farlo. Non puoi semplicemente collegare un pezzo e aspettarti che funzioni. Perché [ci sono] effetti a catena con l'inserimento di quel pezzo e il fatto che ce ne siano diversi giocatori con obiettivi diversi in un tale sistema, e sovvertono il sistema secondo i propri bisogni diversi modi. Tutte queste cose devono essere prese in considerazione quando si parla di efficacia. Sì, puoi dire in astratto che tutto funzionerà bene, ma lì È nessun astratto. Esiste solo il contesto in cui lavori”.