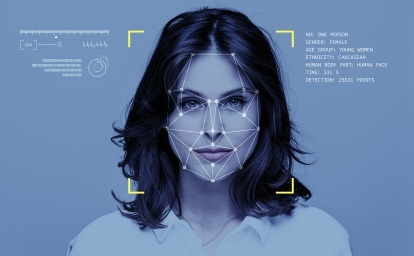

L’ultimo esempio dell’arroganza della Silicon Valley è l’app di riconoscimento facciale Visualizzazione chiara dell'intelligenza artificiale. L'app della piccola startup è così potente che qualcuno potrebbe avvicinarsi a te per strada, scattare una foto e scoprire rapidamente il tuo nome, indirizzo e numero di telefono, secondo un rapporto del New York Times.

Contenuti

- Un nuovo strumento per gli autori di abusi

- Un problema continuo

Questa tecnologia probabilmente sembra un’ottima idea per due tipi di persone: Applicazione della legge e fa venire i brividi. I sostenitori temono che questo tipo di tecnologia di riconoscimento facciale possa essere un vantaggio per gli stalker, le persone con a precedenti di abusi domestici, e chiunque altro voglia scoprire tutto su di te per un atto nefasto scopo.

Video consigliati

"Quando la notizia di questa app si è diffusa, le donne di tutto il mondo hanno sospirato", ha affermato Jo O'Reilly, sostenitrice della privacy presso ProPrivacy con sede nel Regno Unito, in una dichiarazione a Digital Trends. “Ancora una volta, la sicurezza delle donne sia online che nella vita reale è passata in secondo piano rispetto al desiderio delle startup tecnologiche di creare – e monetizzare – una tecnologia sempre più invasiva”.

Imparentato

- Amazon utilizza l'intelligenza artificiale per riassumere le recensioni dei prodotti

- L’intelligenza artificiale ha trasformato Breaking Bad in un anime – ed è terrificante

- La tecnologia di riconoscimento facciale per gli orsi mira a mantenere gli esseri umani al sicuro

Clearview funziona, in parte, estraendo dati disponibili al pubblico da popolari siti di social media come Facebook, Twitter, YouTube e Venmo, tra gli altri. Un portavoce dell’azienda Facebook ha detto a Digital Trends che “il raschiamento

Un nuovo strumento per gli autori di abusi

Lo stalking è da tempo un problema per le donne online, e questo senza uno strumento in grado di rintracciare qualcuno basandosi solo sul suo volto. Per ora, Clearview afferma di vendere i suoi servizi solo alle forze dell'ordine, che hanno fornito recensioni davvero entusiastiche della tecnologia. "Tuttavia, sono stranamente silenziosi sul fatto che, nelle mani sbagliate, questo software potrebbe essere utilizzato per molestare e perseguitare quasi chiunque", ha detto O'Reilly. “Ciò sarebbe impossibile da prevenire se il software fosse reso disponibile al pubblico – uno scenario che gli investitori di Clearview hanno riconosciuto essere possibile”.

"Qualsiasi tecnologia che sviluppi sarà utilizzata dagli esseri umani, devi pensare ai difetti", ha affermato Crystal Justice, responsabile marketing e sviluppo di la hotline nazionale per la violenza domestica . "Gli autori di abusi sono sempre alla ricerca dello strumento successivo nella loro cassetta degli attrezzi."

La hotline ha iniziato a segnalare gli abusi digitali come categoria specifica nel 2015 e da allora ha registrato un forte aumento dei numeri, soprattutto tra i giovani. La giustizia ha dichiarato a Digital Trends che la hotline ha ricevuto 371.000 contatti nel 2018 e il 15% di questi erano denunce di abusi digitali. In media a livello nazionale, secondo i numeri della hotline, una donna su quattro e un uomo su sette sono sopravvissuti alla violenza domestica.

“I sopravvissuti costituiscono una parte così importante della nostra popolazione”, ha detto Justice. "Le aziende tecnologiche devono considerare l'esperienza dei sopravvissuti quando progettano le loro app."

Un problema continuo

Questo è un modello persistente con una tecnologia molto dirompente al giorno d’oggi. Quando Uber è stata lanciata nel 2009, la tecnologia sembrava troppo interessante per essere vera. Non eravamo più schiavi dell’industria dei taxi o del trasporto pubblico incompetente nelle nostre rispettive città.

Naturalmente, il modello di Uber è anche andato contro la saggezza convenzionale che ci è stata insegnata da bambini: non salire in macchina con estranei. Dieci anni e diverse migliaia di cause legaliper violenza sessuale in seguito, sembrerebbe che ci fosse una ragione che era la saggezza convenzionale. Per molte persone, salire sull’auto di uno sconosciuto non è sicuro, anche quando si paga per essere lì.

Ma questo elemento di pensare alla sicurezza, o di dover spostarsi per il mondo costantemente preoccupato per la propria incolumità fisica, è come molti le donne e le persone appartenenti a minoranze sessuali non devono, sembra, essere state nella mente degli uomini (per lo più bianchi) che hanno fondato aziende tecnologiche come Uber, Piace Twitter, come tanti altri. Volevano solo creare qualcosa di interessante che avrebbe cambiato il mondo. L’idea che sarebbe stata utilizzata per scopi nefasti non venne loro in mente finché non fu troppo tardi.

“Produrre queste cose per il consumo pubblico mette a rischio i sopravvissuti e dobbiamo pensare alle conseguenze indesiderate”.

La privacy e la sicurezza devono essere integrate in un’app fin dall’inizio, ha affermato Rachel Gibson, specialista senior in sicurezza tecnologica per la National Network to End Domestic Violence. “Una cosa è che qualcosa sia costruito con buone intenzioni, ma sappiamo che la tecnologia può essere utilizzata in modo improprio”, ha detto Gibson a Digital Trends. “Lo consideriamo come una nuova tecnologia, un vecchio comportamento. Le persone venivano ancora violentate nei taxi [prima di Uber], ma dobbiamo pensare a come la tecnologia di questi tempi possa facilitare vecchi comportamenti come lo stalking e l’aggressione”.

Qualcosa come Clearview, ha detto Gibson, sebbene abbia i suoi usi per le forze dell'ordine, certamente solleva dubbi su come o perché potrebbe essere utile al grande pubblico. “Produrre queste cose per il consumo pubblico mette a rischio i sopravvissuti e dobbiamo pensare alle conseguenze indesiderate”, ha affermato.

La Giustizia ha detto che vede cambiare la conversazione sul ruolo della tecnologia nella sicurezza pubblica. "Il discorso è cambiato da MeToo", ha detto. “Ed era anche ora. Questo non è un nuovo problema. Non stiamo necessariamente assistendo a un aumento della violenza domestica, stiamo vedendo che finalmente se ne discute. E ora possiamo includere gli elementi complessi su come la tecnologia ne fa parte”.

Gibson ha anche detto di aver avuto conversazioni con diverse “importanti aziende tecnologiche” (anche se non l’ha fatto specificare quale), e hanno detto che ora stanno "cercando di essere consapevoli" di costruire per la privacy e sicurezza.

Clearview ha rilasciato una breve dichiarazione a Digital Trends, affermando che "prendono sul serio queste preoccupazioni e non hanno piani per un rilascio commerciale". In un post sul blog, la società ha sottolineato che il loro prodotto non era disponibile al pubblico e che sarebbe stato reso disponibile "solo alle forze dell'ordine e a professionisti della sicurezza selezionati".

Se ritieni che tu o qualcuno che conosci sia vittima di abusi da parte del partner, contatta la hotline nazionale per la violenza domestica 24 ore su 24, 7 giorni su 7 al numero 1-800-799-7233.

Raccomandazioni degli editori

- La telecronaca basata sull'intelligenza artificiale arriverà a Wimbledon il mese prossimo

- Elon Musk sta avviando un progetto di intelligenza artificiale generativa su Twitter, riporta le affermazioni

- Google Smart Canvas ottiene un'integrazione più profonda tra le app

- Nvidia affitta la sua piattaforma AI Superpod per $ 90.000 al mese

- Portland vieta l’uso privato e pubblico della tecnologia di riconoscimento facciale