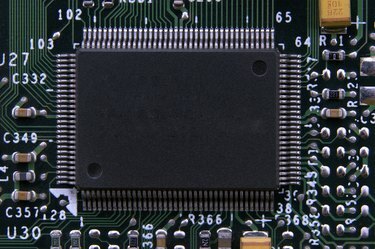

Immagine di un chip di computer.

Credito immagine: MauMyHaT/iStock/Getty Images

Mentre i primi computer sono nati prima della sua invenzione, il microchip di silicio è il progresso che ha reso possibile l'era dei computer moderni. La capacità di creare un circuito stampato miniaturizzato da questo semiconduttore è stato ciò che ha dato ai computer vasti progressi in termini di velocità e precisione, trasformandoli da dispositivi delle dimensioni di una stanza a macchine che potrebbero stare su una scrivania o il tuo grembo.

Progettazione del circuito iniziale

I primi computer utilizzavano dispositivi chiamati tubi a vuoto nei loro progetti di circuiti, che fungevano da porte per accendere e spegnere le correnti per dirigere la funzione del computer e memorizzare le informazioni. Questi erano componenti fragili, tuttavia, e spesso si guastavano durante il normale funzionamento. Nel 1947, l'invenzione del transistor sostituì il tubo a vuoto nella progettazione dei computer e questi piccoli componenti richiedevano un materiale semiconduttivo per funzionare. I primi transistor contenevano germanio, ma alla fine il silicio divenne il semiconduttore preferito dagli architetti di computer.

Video del giorno

Vantaggi del silicio

Come semiconduttore, il silicio ha proprietà elettriche che si trovano tra conduttori e resistori. I produttori possono alterare chimicamente il silicio di base per modificarne le proprietà elettriche, facendolo condurre elettricità a seconda delle esigenze specifiche dell'unità. Ciò ha consentito ai progettisti di computer di creare molti dei loro componenti con lo stesso materiale, invece di richiedere fili e altri materiali separati per ottenere gli stessi risultati.

Il Microchip

Sfortunatamente, i complessi circuiti richiesti per computer potenti significavano ancora che i dispositivi dovevano essere estremamente grandi. Nel 1958, tuttavia, Jack Kilby ebbe l'idea di creare il circuito che componeva un computer in miniatura, utilizzando un singolo blocco di semiconduttore e stampando il circuito sulla parte superiore in metallo invece di creare il circuito con fili separati e componenti. Sei mesi dopo, Robert Noyce ebbe l'idea di posare il metallo sul semiconduttore e poi incidere le parti non necessarie per creare il circuito integrato. Questi progressi hanno notevolmente ridotto le dimensioni dei circuiti dei computer e hanno reso possibile la loro produzione in serie per la prima volta.

Fabbricazione di chip di silicio

Oggi, i produttori di chip di silicio utilizzano la luce ultravioletta ad alta potenza per incidere i loro chip. Dopo aver posizionato una pellicola fotosensibile su un wafer di silicio, la luce risplende attraverso una maschera del circuito e marchia la pellicola nell'immagine del progetto del circuito. Il produttore taglia via le aree non protette, quindi stende un altro strato di silicio e ripete il processo. Infine, un ultimo strato di pellicola identifica il circuito metallico che chiude il chip, completando il circuito elettrico. I moderni chip di silicio possono contenere molti strati diversi con proprietà elettriche diverse, al fine di soddisfare le esigenze elettriche della progettazione del computer.