La force de Google dans les appareils photo pour smartphones a toujours été son IA. et les systèmes de photographie informatique. La photo que votre téléphone vous donne après avoir appuyé sur le déclencheur n’est pas une copie exacte de ce que vous voyez: c’est une combinaison de dizaines d’images fusionnées, traitées par des algorithmes avancés. Cela crée un problème: Google a constaté que ses algorithmes photo ne parviennent pas à représenter correctement toutes les carnations et caractéristiques physiques.

Vidéos recommandées

Dans une annonce à Google E/S En 2021, l’entreprise a déclaré qu’elle travaillait pour changer cela. Son objectif est de « faire téléphone intelligent la photographie vraiment accessible à tous […] pour construire un appareil photo plus précis et plus inclusif.

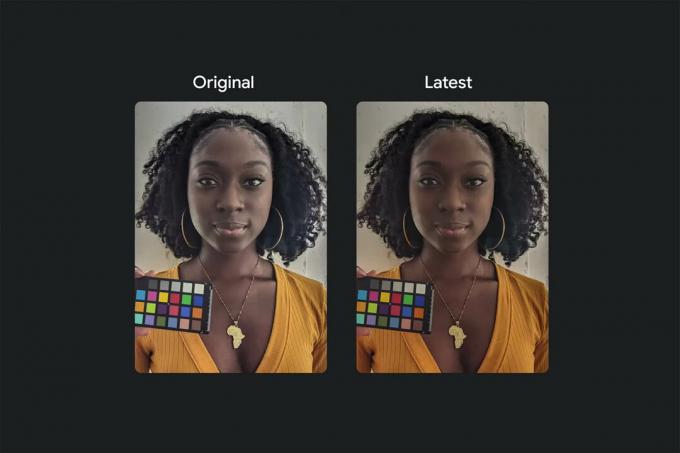

Google a lancé une nouvelle initiative dans sa division photographie pour garantir que ses algorithmes de traitement photo représenter de manière précise et appropriée les personnes de couleur – des tons de peau aux traits du corps et du visage, en passant par les types de cheveux, et au-delà. Tout a commencé par la constitution d'un groupe d'experts en photographie pour recueillir des informations sur la façon dont la photographie informatique a conduit à des lacunes dans la représentation correcte de certains groupes et a commencé à travailler pour garantir que les logiciels de ses caméras puissent contrecarrer que.

En rapport

- Vous avez un vieux Google Pixel? Ce test d'appareil photo va vous donner envie d'un Pixel 7a

- Couleurs du Google Pixel 7a: voici toutes les options disponibles

- Le Google Pixel 7a est-il doté d'une recharge sans fil?

« Le travail, c’est à nous de le faire. Il n’appartient pas aux gens de changer leur apparence; c’est à nous de changer la façon dont fonctionnent les outils », a déclaré Google.

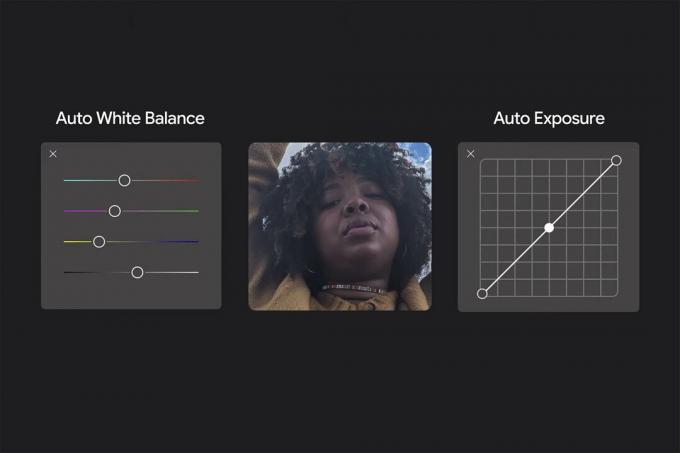

Certains changements sont un peu plus simples que d’autres. En modifiant la façon dont les algorithmes de balance des blancs automatique et d'exposition automatique traitent les images, le Google L’application appareil photo peut représenter plus précisément le ton de la peau d’une personne, quelle que soit la scène environnante.

Et au lieu de simplement supposer qu’« une image plus lumineuse est meilleure », comme c’est si souvent le cas, elle peut prendre en compte le fait qu’il existe un raison pourquoi certaines parties d'une scène ont cette couleur ou ce ton. Google a été à l'avant-garde de la combinaison de plusieurs cadres en photos composites, et c'est un autre domaine dans lequel ce type d'expertise peut être appliqué à une nouvelle philosophie.

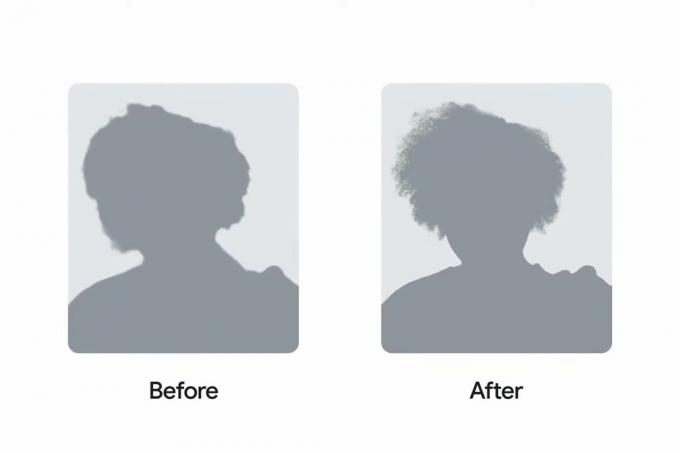

Cela va bien sûr au-delà de la couleur et de la luminosité. Google se concentre également sur ses algorithmes de traitement de différents types de cheveux – pour les photos, les selfies et les prises de vue en mode portrait. Nous avons tous déjà eu affaire à des faux portraits qui coupaient des lunettes, des oreilles ou des mèches de cheveux, mais Google a constaté que cela affectait de manière disproportionnée les types de cheveux plus bouclés. Les nouveaux changements d'algorithme aident à représenter correctement les cheveux de manière naturelle, plutôt que de les lisser artificiellement et de supprimer la définition des boucles, par exemple.

En fin de compte, tout dépend de la précision. Où divers téléphones atterrissent sur le spectre de la prise précis des photos ou plaisant la photo est une source constante de débat; mais malheureusement, on n’a pas suffisamment mis l’accent sur la représentation des sujets, quels que soient leur teint ou leurs caractéristiques physiques. Bien que nous puissions et devrions discuter de la nature subjective de la question de savoir si la photo d'un parc ou d'une scène nocturne a un blanc approprié. équilibre ou un grain non naturel dans les basses lumières, il ne devrait y avoir aucun débat sur le fait que les algorithmes de la caméra devraient représenter personnes le plus précisément possible, sans préjudice.

Google affirme que tous ces changements, et bien d'autres encore, arriveront sur les téléphones Pixel à l'automne – coïncidant probablement avec le lancement du Pixel 6. Mais cela ne s’arrête pas là; Google partagera « tout » ce qu’il apprend avec l’ensemble de Android écosystème de partenaires, dans l’espoir que d’autres entreprises rejoignent cette initiative.

Recommandations des rédacteurs

- Google Pixel 8: toutes les dernières rumeurs et ce que l'on veut voir

- Je suis enthousiasmé par le Google Pixel Fold, et vous devriez l'être aussi

- Le Google Pixel 7a a-t-il une prise casque?

- La Google Pixel Tablet est là, et c'est une énorme déception

- N’achetez pas (encore) le Google Pixel Fold

Améliorez votre style de vieDigital Trends aide les lecteurs à garder un œil sur le monde en évolution rapide de la technologie avec toutes les dernières nouvelles, des critiques de produits amusantes, des éditoriaux perspicaces et des aperçus uniques.