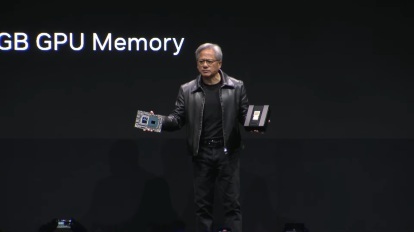

Nvidia vient d'annoncer un nouveau supercalculateur qui pourrait changer l'avenir de l'IA. Le DGX GH200, équipé de près de 500 fois plus de mémoire que les systèmes que nous connaissons actuellement, tombera bientôt entre les mains de Google, Meta et Microsoft.

Le but? Révolutionner IA générative, des systèmes de recommandation et un traitement des données à une échelle jamais vue auparavant. Les modèles de langage sont-ils comme Google Tag va en bénéficier, et qu'est-ce que cela signifiera pour les utilisateurs réguliers ?

Vidéos recommandées

Décrire le DGX GH200 de Nvidia nécessite l'utilisation de termes que la plupart des utilisateurs n'ont jamais à traiter. « Exaflop », par exemple, car le supercalculateur fournit 1 exaflop de performances et 144 téraoctets de mémoire partagée. Nvidia note que cela signifie près de 500 fois plus de mémoire que dans un seul système Nvidia DGX A100.

En rapport

- Le fabricant de ChatGPT OpenAI fait face à une enquête de la FTC sur les lois de protection des consommateurs

- Le trafic du site ChatGPT a chuté pour la première fois

- Le rival ChatGPT d'Apple peut automatiquement écrire du code pour vous

Revenons au chiffre 1 exaflop et décomposons-le un peu. Un exaflop équivaut à un quintillion d'opérations en virgule flottante par seconde (FLOP). A titre de comparaison, Nvidia RTX 4090 peut atteindre environ 100 téraflops (TFLOP) lorsqu'il est overclocké. Un TFLOP équivaut à mille milliards d'opérations en virgule flottante par seconde. La différence est stupéfiante, mais bien sûr, le RTX 4090 n'est pas un GPU de centre de données. Le DGX GH200, d'autre part, intègre un nombre important de ces GPU hautes performances qui n'appartiennent nulle part à un PC grand public.

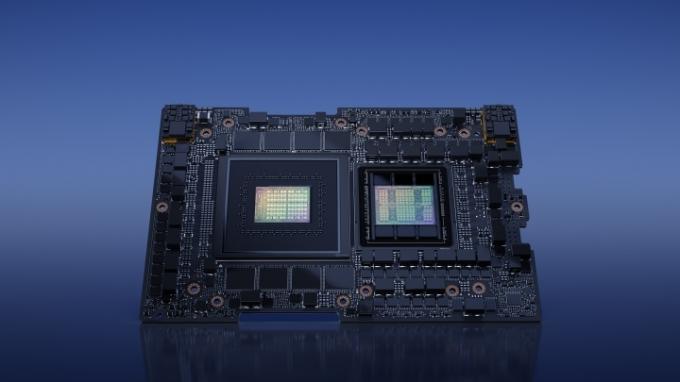

L'ordinateur est alimenté par les superpuces GH200 Grace Hopper de Nvidia. Il y en a 256 au total, qui, grâce à la technologie d'interconnexion NVLink de Nvidia, sont tous capables de fonctionner ensemble comme un système unifié, créant essentiellement un GPU massif.

Les superpuces GH200 utilisées ici n'ont pas non plus besoin d'une connexion PCIe traditionnelle entre le CPU et le GPU. Nvidia dit qu'ils sont déjà équipés d'un Nvidia Grace CP, U basé sur ARM ainsi que d'un GPU H100 Tensor Core. Nvidia a également des interconnexions de puces sophistiquées, cette fois en utilisant le NVLink-C2C. Par conséquent, la bande passante entre le processeur et le carte graphique est censé être considérablement amélioré (jusqu'à 7 fois) et plus économe en énergie (jusqu'à 5 fois).

Emballer plus de 200 de ces puces dans une seule centrale électrique d'un superordinateur est assez impressionnant, mais il devient encore meilleur si l'on considère qu'auparavant, seuls huit GPU pouvaient être associés à NVLink à la fois. temps. Un saut de huit à 256 puces donne certainement à Nvidia le droit de se vanter.

Il est difficile de ne pas imaginer que le DGX GH200 pourrait apporter des améliorations à Bard, ChatGPT et Bing Chat.

Maintenant, où finira le DGX GH200 et que peut-il offrir au monde? Nvidia construit son propre supercalculateur Helios afin de faire progresser sa recherche et son développement en IA. Il comprendra quatre systèmes DGX GH200, tous interconnectés avec le Quantum-2 InfiniBand de Nvidia. Il s'attend à ce qu'il soit mis en ligne d'ici la fin de l'année.

Nvidia partage également son nouveau développement avec le monde, à commencer par Google Cloud, Meta et Microsoft. L'objectif est sensiblement le même: explorer les charges de travail génératives de l'IA.

En ce qui concerne Google et Microsoft, il est difficile de ne pas imaginer que le DGX GH200 pourrait apporter des améliorations dans Barde, ChatGPT, et Chat Bing.

La puissance de calcul importante fournie par un seul système DGX GH200 le rend bien adapté pour faire progresser la formation de modèles de langage sophistiqués. Il est difficile de dire ce que cela pourrait signifier exactement sans commentaire de l'une des parties intéressées, mais nous pouvons spéculer un peu.

Plus de puissance signifie des modèles plus grands, ce qui signifie un texte plus nuancé et précis et un plus large éventail de données sur lesquelles ils peuvent s'entraîner. Nous pourrions voir une meilleure compréhension culturelle, une meilleure connaissance du contexte et une plus grande cohérence. Des chatbots spécialisés en IA pourraient également commencer à apparaître, remplaçant davantage les humains dans des domaines tels que la technologie.

Devrions-nous nous inquiéter d'un éventuel déplacement d'emplois ou devrions-nous être enthousiasmés par les progrès que ces superordinateurs pourraient apporter? La réponse n'est pas simple. Une chose est sûre - le DGX GH200 de Nvidia pourrait faire bouger les choses dans le monde de l'IA, et Nvidia vient de a encore renforcé son avance en matière d'IA sur AMD.

Recommandations des éditeurs

- Google Bard peut désormais parler, mais peut-il noyer ChatGPT?

- La croissance record de ChatGPT vient d'être détrônée par une nouvelle application virale

- 81 % pensent que ChatGPT est un risque pour la sécurité, selon une enquête

- Ce navigateur Web intègre ChatGPT d'une nouvelle manière fascinante

- GPT-4: comment utiliser le chatbot IA qui fait honte à ChatGPT

Améliorez votre style de vieDigital Trends aide les lecteurs à garder un œil sur le monde trépidant de la technologie avec toutes les dernières nouvelles, des critiques de produits amusantes, des éditoriaux perspicaces et des aperçus uniques.