La fuerza de Google en las cámaras de los teléfonos inteligentes siempre ha sido su A.I. y sistemas de fotografía computacional. La foto que te muestra tu teléfono después de presionar el botón del obturador no es una copia exacta de lo que ves: es una combinación de docenas de fotogramas fusionados, procesados por algoritmos avanzados. Eso crea un problema: Google descubrió que sus algoritmos fotográficos no hacen un gran trabajo al representar adecuadamente todos los tonos de piel y rasgos físicos.

Vídeos recomendados

En un anuncio en E/S de Google En 2021, la compañía dijo que está trabajando para cambiar eso. Su objetivo es “hacer teléfono inteligente fotografía verdaderamente para todos […] para construir una cámara más precisa e inclusiva”.

Google ha puesto en marcha una nueva iniciativa en su división de fotografía para garantizar que sus algoritmos de procesamiento de fotografías representar de manera precisa y apropiada a personas de color, desde tonos de piel hasta rasgos corporales y faciales, tipos de cabello, y más allá. Comenzó reuniendo a un grupo de expertos en fotografía para recopilar información sobre cómo la fotografía computacional ha llevado a lagunas en la representación adecuada de algunos grupos y comenzó a trabajar para garantizar que el software de sus cámaras pueda contrarrestar eso.

Relacionado

- ¿Tienes un Google Pixel antiguo? Esta prueba de cámara te hará querer un Pixel 7a

- Colores de Google Pixel 7a: aquí tienes todas las opciones que puedes obtener

- ¿El Google Pixel 7a tiene carga inalámbrica?

“El trabajo es para que lo hagamos nosotros. No corresponde a las personas cambiar su apariencia; Nos corresponde a nosotros cambiar la forma en que funcionan las herramientas”, dijo Google.

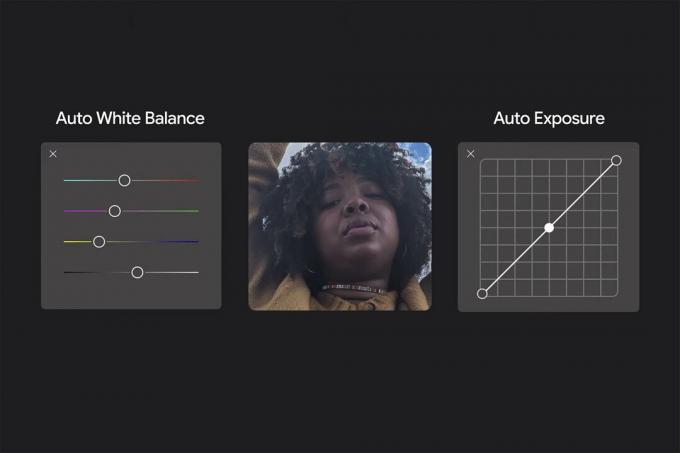

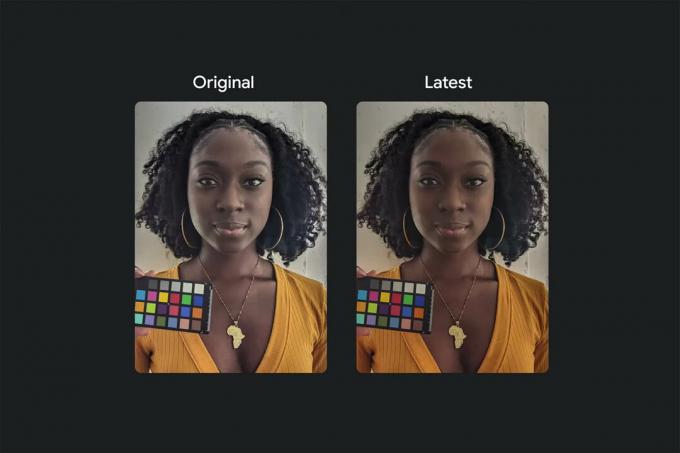

Algunos de los cambios son un poco más simples que otros. Al modificar la forma en que los algoritmos de balance de blancos y exposición automática procesan las imágenes, Google La aplicación de cámara puede representar con mayor precisión el tono de piel de una persona independientemente de la escena circundante.

Y en lugar de simplemente asumir que "una imagen más brillante es mejor", como suele ser el caso, puede tener en cuenta el hecho de que existe una razón por qué ciertas partes de una escena son de ese color o tono. Google ha estado a la vanguardia en la combinación de múltiples fotogramas en fotografías compuestas, y ésta es otra área donde ese tipo de experiencia se puede aplicar a una nueva filosofía.

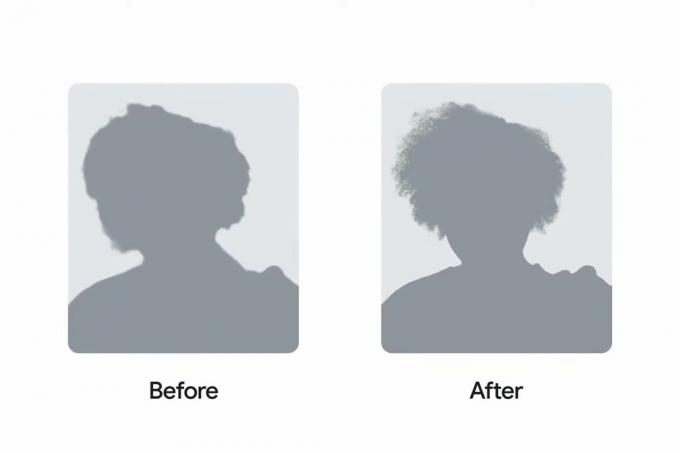

Esto va más allá del color y el brillo, por supuesto. Google también se está centrando en sus algoritmos para procesar diferentes tipos de cabello: para fotografías, selfies y tomas en modo retrato. Todos hemos lidiado con retratos falsos que cortan anteojos, orejas o mechones de cabello, pero Google descubrió que esto afectaba desproporcionadamente a los tipos de cabello más rizado. Los nuevos cambios en el algoritmo ayudan a representar adecuadamente el cabello de forma natural, en lugar de alisarlo artificialmente y quitarle definición a los rizos, por ejemplo.

En última instancia, todo esto se reduce a la precisión. Dónde se encuentran varios teléfonos en el espectro de toma preciso fotos o agradable las fotos son una fuente constante de debate; pero desafortunadamente, no se ha prestado suficiente atención a la representación de los sujetos sin importar su tono de piel o rasgos físicos. Si bien podemos y debemos discutir la naturaleza subjetiva de si la foto de un parque o de una escena nocturna tiene el blanco adecuado equilibrio o grano poco natural en las luces bajas, no debería haber ningún debate sobre el hecho de que los algoritmos de la cámara deberían representar gente con la mayor precisión posible y sin prejuicios.

Google dice que todos estos cambios, y más, llegarán a los teléfonos Pixel en el otoño, presumiblemente coincidiendo con el lanzamiento del Pixel 6. Pero la cosa no termina ahí; Google compartirá "todo" lo que aprenda con todo el mundo. Androide ecosistema de socios, con la esperanza de que otras empresas se unan a esta iniciativa.

Recomendaciones de los editores

- Google Pixel 8: todos los últimos rumores y lo que queremos ver

- Estoy entusiasmado con Google Pixel Fold y tú también deberías estarlo

- ¿El Google Pixel 7a tiene conector para auriculares?

- La tableta Google Pixel ya está aquí y es una gran decepción

- No compre Google Pixel Fold (todavía)

Mejora tu estilo de vidaDigital Trends ayuda a los lectores a mantenerse al tanto del vertiginoso mundo de la tecnología con las últimas noticias, reseñas divertidas de productos, editoriales interesantes y adelantos únicos.