Um den Titel einer bekannten Fernsehsendung leicht abzuwandeln: Kinder machen die verrücktesten Dinge. Kürzlich führten Forscher aus Deutschland und Großbritannien eine Studie durch, in der Zeitschrift veröffentlicht Wissenschaftsrobotik, das zeigte, wie sehr Kinder dem Gruppenzwang von Robotern ausgesetzt sind. TLDR-Version: Die Antwort auf die alte Elternfrage: „Wenn alle deine Freunde dir sagen würden, du sollst von einer Klippe springen, würdest du das tun?“ könnte durchaus lauten: „Sicher. Wenn alle meine Freunde Roboter wären.“

Inhalt

- Sind Erwachsene wirklich so viel schlauer?

- Für jedes Schiff gibt es einen Schiffbruch

Der Test stellte ein berühmtes Experiment aus dem Jahr 1951 nach, das der polnische Psychologe Solomon Asch entwickelt hatte. Das Experiment zeigte, wie Menschen vom Druck des Gruppendenkens beeinflusst werden können, selbst wenn dies im Widerspruch zu Informationen steht, von denen sie wissen, dass sie richtig sind. Bei Aschs Experimenten versammelte sich eine Gruppe von Studenten und zeigte ihnen zwei Karten. Die Karte links zeigte das Bild einer einzelnen vertikalen Linie. Die Karte rechts zeigte drei Linien unterschiedlicher Länge. Anschließend fragte der Experimentator die Teilnehmer, welche Linie auf der rechten Karte mit der Länge der Linie auf der linken Karte übereinstimmte.

Empfohlene Videos

„Das Besondere an Kindern dieser Altersgruppe ist, dass sie sich noch in einem Alter befinden, in dem sie ihren Unglauben aufgeben.“

So weit, so einfach. Was jedoch noch abwegiger wurde, lag in der Zusammensetzung der Gruppe. Nur eine Person aus der Gruppe war ein echter Teilnehmer, während die anderen allesamt Schauspieler waren, denen vorher gesagt wurde, was sie sagen sollten. Das Experiment bestand darin, zu testen, ob der echte Teilnehmer dem Rest der Gruppe zustimmen würde, wenn sie einstimmig die falsche Antwort gaben. Wie sich herausstellte, würden es die meisten tun. Gruppenzwang bedeutet, dass die Mehrheit der Menschen Informationen ablehnt, die eindeutig korrekt sind, wenn sie damit der Mehrheitsmeinung entsprechen.

Verwandt

- Es gibt sich weiterentwickelnde, sich selbst reproduzierende Roboter – aber machen Sie sich keine Sorgen über einen Aufstand

- Roboter kommen nicht, um Ihnen den Job zu stehlen. Sie kommen, um es zu verbessern

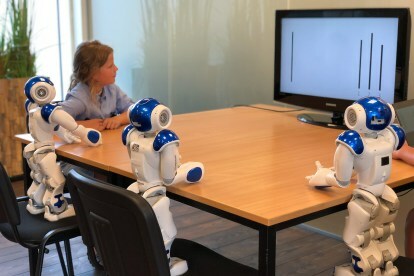

Im Remix des Experiments von 2018 wurde das gleiche Prinzip verwendet – nur dass der „echte Teilnehmer“ anstelle einer Gruppe von Gleichaltrigen im College-Alter ein Kind im Alter von sieben bis neun Jahren war. Die „Schauspieler“ wurden von drei Robotern gespielt, die darauf programmiert waren, die falsche Antwort zu geben. In einer Stichprobe von 43 Freiwilligen gaben 74 Prozent der Kinder die gleiche falsche Antwort wie die Roboter. Die Ergebnisse deuten darauf hin, dass die meisten Kinder in diesem Alter den Druck durch Roboter genauso behandeln wie den Gruppenzwang durch Gleichaltrige aus Fleisch und Blut.

„Das Besondere an Kindern dieser Altersgruppe ist, dass sie sich noch in einem Alter befinden, in dem sie ihren Unglauben aufgeben.“ Tony Belpaeme, Professor für Intelligente und autonome Steuerungssysteme, der bei der Durchführung der Studie mitgewirkt hat, sagte gegenüber Digital Trends. „Sie spielen mit Spielzeug und glauben trotzdem, dass ihre Actionfiguren oder Puppen echt sind; Sie schauen sich immer noch ein Puppentheater an und glauben wirklich, was passiert. Sie glauben vielleicht immer noch an [den Weihnachtsmann]. Wenn sie einen Roboter betrachten, ist es dasselbe: Sie sehen keine Elektronik und kein Plastik, sondern einen sozialen Charakter.“

Interessanterweise kontrastierte das Experiment dies mit der Reaktion von Erwachsenen. Im Gegensatz zu den Kindern ließen sich Erwachsene von den Fehlern der Roboter nicht beeinflussen. „Als ein Erwachsener sah, dass der Roboter die falsche Antwort gab, warf er ihm einen verwirrten Blick zu und gab dann die richtige Antwort“, fuhr Belpaeme fort.

Also kein Grund zur Sorge? Solange wir verhindern, dass Kinder Roboter in die Hände bekommen, die darauf programmiert sind, schlechte Reaktionen zu geben, sollte alles in Ordnung sein, oder? Sei nicht so schnell.

Sind Erwachsene wirklich so viel schlauer?

Wie Belpaeme einräumte, war diese Aufgabe so einfach konzipiert, dass keine Unsicherheit darüber bestand, wie die Antwort aussehen könnte. Die reale Welt ist anders. Wenn wir über die Arten von Aufgaben nachdenken, die Maschinen gerne überlassen werden, handelt es sich häufig um Aufgaben, die wir als Menschen nicht immer perfekt ausführen können.

Diese Aufgabe sollte so einfach sein, dass keine Unsicherheit darüber bestand, wie die Antwort aussehen könnte.

Es könnte sein, dass die Aufgabe unglaublich einfach ist, die Maschine sie aber deutlich schneller erledigen kann als wir. Oder es könnte sich um eine komplexere Aufgabe handeln, bei der der Computer Zugriff auf weitaus größere Datenmengen hat als wir. Abhängig von den potenziellen Auswirkungen der jeweiligen Aufgabe ist es keine Überraschung, dass viele von uns mit der Reparatur einer Maschine unzufrieden wären.

Würde sich eine Krankenschwester in einem Krankenhaus darüber freuen, das zu überstimmen? Von der FDA zugelassener Algorithmus Was kann dazu beitragen, Prioritäten für die Gesundheit des Patienten zu setzen, indem die Vitalfunktionen überwacht und dann Warnungen an das medizinische Personal gesendet werden? Oder wäre es für einen Fahrer bequemer, das Steuer eines fahrerlosen Autos zu übernehmen, wenn es um ein besonders komplexes Straßenszenario geht? Oder sogar ein Pilot, der den Autopiloten außer Kraft setzt, weil er denkt, dass die falsche Entscheidung getroffen wird? In all diesen Fällen möchten wir davon ausgehen, dass die Antwort „Ja“ lautet. Aus den unterschiedlichsten Gründen ist dies jedoch möglicherweise nicht der Fall.

Nicholas Carr schreibt darüber in seinem Buch von 2014 Der gläserne Käfig: Wohin uns die Automatisierung führt. Die Art und Weise, wie er es beschreibt, unterstreicht die Art von Unklarheit, die reale Automatisierungsfälle mit sich bringen und wo die Probleme liegen Die Maschinen sind weitaus komplexer als die Länge einer Zeile auf einer Karte, sie sind viel intelligenter und das Ergebnis ist möglicherweise höher entscheidend.

„Wie bemisst man die Kosten eines nachlassenden Einsatzes und Engagements, eines Rückgangs an Entscheidungsfreiheit und Autonomie oder einer subtilen Verschlechterung der Fähigkeiten? Das geht nicht“, schreibt er. „Das sind die Art von schattenhaften, immateriellen Dingen, die wir selten wertschätzen, bis sie verschwunden sind, und selbst dann fällt es uns möglicherweise schwer, die Verluste in konkreten Worten auszudrücken.“

„Das sind die Art von schattenhaften, immateriellen Dingen, die wir selten zu schätzen wissen, bis sie verschwunden sind.“

Soziale Roboter der Art, über die Belpaeme in der Forschungsarbeit theoretisiert, sind noch nicht im Mainstream angekommen, aber es gibt bereits Beispiele für einige dieser Rätsel in der Praxis. Carr beginnt sein Buch beispielsweise mit der Erwähnung eines Memos der Federal Aviation Administration, in dem darauf hingewiesen wird, dass Piloten aufgrund der damit verbundenen Risiken weniger Zeit mit dem Autopiloten verbringen sollten. Dies basiert auf der Analyse von Absturzdaten und zeigt, dass Piloten häufig zu stark auf computergestützte Systeme angewiesen sind.

Ein ähnlicher Fall betraf einen Rechtsstreit aus dem Jahr 2009, an dem eine Frau namens Lauren Rosenberg beteiligt war reichte Klage gegen Google ein nachdem ihm geraten wurde, auf einer Route zu gehen, die zu gefährlichem Verkehr führt. Obwohl der Fall außergerichtlich abgewiesen wurde, zeigt er, dass die Menschen ihren eigenen gesunden Menschenverstand außer Kraft setzen und glauben, dass maschinelle Intelligenz mehr Intelligenz hat als wir.

Für jedes Schiff gibt es einen Schiffbruch

Letztlich besteht das Problem, wie Belpaeme einräumt, darin, dass wir manchmal die Entscheidungsfindung Maschinen überlassen wollen. Roboter versprechen, langweilige, schmutzige und gefährliche Arbeiten zu erledigen – und wenn wir jede Entscheidung noch einmal überdenken müssen, handelt es sich nicht wirklich um die versprochenen arbeitssparenden Geräte. Wenn wir irgendwann Roboter in unser Zuhause einladen, wollen wir, dass sie autonom agieren können, und das erfordert ein gewisses Maß an Vertrauen.

„Roboter, die sozialen Druck auf einen ausüben, können eine gute Sache sein; Es muss nicht unheimlich sein“, fuhr Belpaeme fort. „Wenn Sie Roboter im Gesundheitswesen oder in der Bildung einsetzen, möchten Sie, dass diese Sie beeinflussen können. Wenn Sie beispielsweise abnehmen möchten, könnte Ihnen für zwei Monate ein Abnehmroboter zur Verfügung gestellt werden Monitore Ihre Kalorienaufnahme und regt Sie zu mehr Bewegung an. Sie möchten, dass ein solcher Roboter überzeugt und Sie beeinflusst. Aber jede Technologie, die zum Guten genutzt werden kann, kann auch zum Bösen genutzt werden.“

Wie lautet die Antwort darauf? Fragen wie diese werden im Einzelfall besprochen. Wenn das Schlechte letztendlich das Gute überwiegt, werden sich Technologien wie soziale Roboter nie durchsetzen. Aber es ist wichtig, dass wir aus Studien wie der über roboterinduzierten Gruppenzwang die richtigen Lehren ziehen. Und es ist nicht die Tatsache, dass wir so viel schlauer sind als Kinder.

Empfehlungen der Redaktion

- Die Zukunft der Automatisierung: Roboter kommen, aber sie werden Ihnen nicht den Job wegnehmen

- Diese Roboter töten Unkraut, sodass Landwirte keine chemischen Herbizide benötigen