AMD hat eine lange Geschichte und nach der kürzlichen Einführung von Ryzen 7000-Prozessoren, beschlossen wir, dass es Zeit war, zurückzublicken. Das Unternehmen blickt auf eine bewegte Geschichte mit vielen Höhen, aber ebenso vielen Tiefen zurück.

Inhalt

- Athlon

- Athlon 64

- Rotluchs und Jaguar

- Ryzen 7 1700

- Ryzen 9 3950X

- Ryzen 9 4900HS

- Nach der 4000er-Serie und darüber hinaus

Obwohl AMD für seine Grafik bekannt ist, hat es gerade erst angefangen GPUs verkaufen Ende der 2000er Jahre. Das CPU-Geschäft ist viel, viel älter und reicht bis in die 60er Jahre zurück. Und genau wie die Grafik von AMD untrennbar mit ihr verbunden ist die von Nvidia, AMDs CPUs sind schwer von denen des anderen Konkurrenten Intel zu unterscheiden.

Empfohlene Videos

AMD hat sechs CPUs entwickelt, die sich nicht nur als echte Konkurrenz zu viel größeren Unternehmen erwiesen, sondern auch die Technologie und die Welt vorangebracht haben.

Verwandt

- Der neueste V-Cache-Chip von AMD erweist sich als günstig, schnell und perfekt für Spiele

- Asus kämpft nach einer großen Kontroverse um AMD Ryzen darum, sein Gesicht zu wahren

- Einige Ryzen-CPUs brennen durch. Hier erfahren Sie, was Sie tun können, um Ihre zu retten

Athlon

AMDs erster Sieg

Der Athlon 1000 kam im Jahr 2000 auf den Markt und AMD wurde 1969 gegründet. Bevor ich also darüber spreche, wie AMD Intel im Rennen um 1 GHz besiegte, sollte ich darauf eingehen, wie AMD überhaupt hierher kam. Obwohl das Unternehmen in den 70er Jahren seine eigenen Prozessoren herstellte, übernahm AMD sehr schnell die Rolle einer sekundären Quelle für Intel-Chips, was AMD das Recht verschaffte, die x86-Architektur zu verwenden. Secondary Sourcing war damals wichtig, weil Unternehmen, die Computer herstellten (wie IBM), sicher sein wollten, dass sie über genügend Vorräte verfügten und diese umgehend geliefert würden. In den 70er- und 80er-Jahren begnügte sich AMD größtenteils mit der Herstellung von Intel-CPUs.

Schließlich wollte Intel AMD aus dem Spiel nehmen und versuchte, AMD von der Produktion des 80386 auszuschließen (den AMD schließlich klonen würde, um seinen Am386 herzustellen). Der Ausschluss von AMD durch Intel war der erste von vielen Rechtsstreitigkeiten zwischen den beiden Unternehmen, und 1995 Die beiden Unternehmen legten den Rechtsstreit schließlich bei, wodurch AMD das Recht zur Nutzung des x86 erhielt die Architektur. Bald darauf brachte AMD seine erste CPU auf den Markt, die ohne Intel-Technologie entwickelt wurde: die K5. Es konkurrierte nicht nur mit dem etablierten CPU-Geschäft von Intel, sondern auch mit Cyrix, einem anderen Unternehmen, das die x86-Architektur nutzt. Der K5 und der K6 boten 1997 eine Alternative zu Intel für Leute mit kleinem Budget, konnten aber hinsichtlich der Leistung nicht mithalten.

Das änderte sich mit dem K7, auch bekannt als Athlon, was im Altgriechischen „Wettbewerb“ oder „Arena“ bedeutet. Start in 1999 schloss die ursprüngliche Linie der Athlon-CPUs nicht nur die Lücke zur Pentium-Serie von Intel – AMD schlug Intel geradezu. Der neue K7 hatte deutlich höhere Taktraten als der alte K6 sowie deutlich mehr Cache. Anandtech spekulierte dass Intel einen 700-MHz-Pentium III benötigen würde, um AMDs 650-MHz-Athlon zu schlagen, stellte aber auch fest, dass AMDs niedrigere Preise Athlon wettbewerbsfähig halten würden, wenn auch mit hohen Kosten für AMD.

In den nächsten Monaten übertrafen AMD und Intel sich gegenseitig durch die Veröffentlichung neuer CPUs, von denen jede eine höhere Taktrate als die vorherige hatte. Beim Rennen um die höchste Taktrate ging es nicht nur um die Leistung; Eine höhere Frequenz zu haben war auch gutes Marketing. Aber obwohl Intel das weitaus größere Unternehmen war, schlug AMD Intel mit 1 GHz um Längen Einführung des Athlon 1000 im März 2000. Nur ein paar Tage später kündigte Intel seinen eigenen 1-GHz-Pentium III an es schlug den Athlon 1000, aber AMDs CPU war viel früher im Einzelhandel erhältlich.

Die gesamte Athlon-Produktreihe sorgte in der CPU-Branche für große Überraschung, und der Außenseiterstatus von AMD festigte den legendären Ruf des Athlon fast schon nach seiner Veröffentlichung. Intel hatte aufgrund seiner enormen Größe und seiner gesunden Finanzen immer noch einen Vorsprung, aber noch vor wenigen Jahren war AMD nur ein Unternehmen, das zusätzliche CPUs für Intel herstellte. Bis zum Jahr 2000 hatte AMD das Ziel, 30 % des gesamten CPU-Marktes zu erobern.

Athlon 64

AMD definiert 64-Bit-Computing

In den nächsten Jahren nach dem Wettlauf um 1 GHz gerieten sowohl AMD als auch Intel in Schwierigkeiten, als sie versuchten, ihre CPUs der nächsten Generation auf den Markt zu bringen. Intel hat seine neuen Pentium 4-CPUs auf den Markt gebracht erstmals Ende 2000, aber diese CPUs wurden durch hohe Preise, die Abhängigkeit von hochmodernem Speicher und dergleichen behindert berüchtigte NetBurst-Architektur, die auf hohe Taktraten auf Kosten der Leistung ausgelegt war Effizienz. In der Zwischenzeit verfeinerte AMD seine bereits bestehende Athlon-Reihe, die nicht die Leistung der nächsten Generation lieferte.

AMD hatte jedoch einen guten Grund zu zögern, da die nächste Generation von AMD-CPUs 64-Bit-Computing einführen sollte. Dies war vielleicht ein weitaus wichtigeres Ziel als 1 GHz, da 64-Bit-Computing für eine Vielzahl von Aufgaben eine enorme Verbesserung gegenüber 32-Bit-Computing darstellte. Intel war AMD mit seinen Itanium-Server-CPUs tatsächlich überlegen, aber Itanium war äußerst fehlerhaft, da es nicht abwärtskompatibel mit 32-Bit-Software war. Das verschaffte AMD eine große Chance, seine 64-Bit-Implementierung der x86-Architektur vorzustellen: AMD64.

AMD64 feierte schließlich 2003 sein Debüt, zunächst in der brandneuen Opteron-Serie von Server-CPUs und später in Athlon 64-Chips. Während Anandtech war nicht besonders beeindruckt Durch den Wert der neuen Desktop-CPUs von AMD (insbesondere des Flaggschiffs Athlon 64 FX) würdigte die Veröffentlichung die Leistung von AMD bei 64-Bit-Anwendungen. AMDs überlegene 64-Bit-Implementierung war einer der Hauptgründe dafür, dass sich Athlon 64 und insbesondere Opteron gut verkauften. Letztendlich lieferte AMD64 die Grundlage für x86-64, während Itanium vor seiner Einstellung im Jahr 2020 keines seiner Ziele erreichen konnte (ja, so lange hat es überlebt).

Infolgedessen hatte Intel jedoch das Gefühl, dass sein CPU-Geschäft durch AMD in tödlicher Gefahr schwebte. Um seine Geschäftsinteressen zu schützen, verließ sich Intel auf etwas, mit dem AMD nicht mithalten konnte: Geld. Intel begann, Unternehmen wie Dell und HP große Summen in Form von Rabatten und Sonderangeboten zu zahlen, damit diese keine AMD-CPUs verwenden und bei Intel bleiben. Diese Vereinbarungen waren äußerst geheim, und als die OEMs zunehmend auf den Cashflow aus Intels Rabatten angewiesen waren, wurden sie auch zögern, jemals AMD-Chips zu verwenden, denn dies würde bedeuten, auf Geld von Intel zu verzichten.

AMD reichte 2005 eine Klage ein, aber der Rechtsstreit wurde erst 2009 beigelegt, nachdem Intel von Regulierungsbehörden in mehreren Ländern und Gerichtsbarkeiten Geldstrafen verhängt worden war, einschließlich einer Geldstrafe von 1,5 Milliarden US-Dollar in der EU. Die beiden Unternehmen beschlossen, den Fall außergerichtlich beizulegen, und obwohl Intel bestritt, jemals etwas Illegales getan zu haben, versprach das Unternehmen, in Zukunft nicht gegen die wettbewerbswidrigen Gesetze zu verstoßen. Intel erklärte sich außerdem bereit, AMD 1,25 Milliarden US-Dollar als Entschädigung zu zahlen.

Das war auch nicht das Ende. Während der Rechtsstreit weiter tobte, schloss Intel weiterhin Verträge mit OEMs ab, und der Marktanteil von AMD begann schnell zu sinken, obwohl das Unternehmen gegenüber den Chips von Intel sehr konkurrenzfähig war. Besonders Opteron litt darunter und erreichte 2006 einen Marktanteil von über 25 % aber ein Jahr später sank sie auf knapp 15 %. Die Übernahme von ATI im Jahr 2006 trug ebenfalls zur Verschlechterung der Finanzlage von AMD bei, wobei wohl Intel dafür verantwortlich war größeren Schaden verursachen, indem AMD die Chance verweigert wird, nicht nur Chips zu verkaufen, sondern auch ein starkes Ökosystem innerhalb der CPU aufzubauen Markt. AMD war noch nicht aus dem Kampf ausgeschieden, aber es sah schlecht aus.

Rotluchs und Jaguar

AMDs letzte Zuflucht

Die 2000er Jahre waren die Blütezeit des Desktop-PCs mit hohem Stromverbrauch und ebenso hoher Leistung. Der nächste Schritt der Datenverarbeitung erfolgte jedoch nicht im Büro oder zu Hause, sondern unterwegs.

AMD arbeitete ebenfalls an einer ähnlichen CPU, hatte jedoch unterschiedliche Vorstellungen darüber, worauf es seine Bemühungen konzentrieren würde. Das Unternehmen wollte keinen Kampf mit ARM, das Telefone und andere Geräte im Würgegriff hatte, und beschloss daher, sich hauptsächlich auf den traditionellen x86-Markt zu konzentrieren

Obwohl es 2011 erst spät auf der Party war, etablierte sich Bobcat sofort nicht nur als Atom-Konkurrent, sondern auch als Atom-Killer. Es hatte so ziemlich alle Medienfunktionen, die sich die meisten Leute wünschen konnten, zusätzlich zu einer viel höheren CPU- und GPU-Leistung als Atom (ein Fall, in dem sich die ATI-Übernahme auszuzahlen begann). Auch der Stromverbrauch war bei Bobcat extrem gut, und Anandtech stellte fest, dass AMD „Endlich ein Mehrwertangebot, für dessen Verkauf kein großer Preisnachlass erforderlich ist.“ Bobcat war ein großer Erfolg für AMD und verkaufte bis 2013 50 Millionen Geräte.

AMD folgte mit Jaguar, was vielleicht noch wichtiger war. Dank der Verwendung des neueren 28-nm-Knotens von TSMC und mehrerer Architekturverbesserungen konnte der Stromverbrauch erheblich gesenkt und die Leistung im Vergleich zu Bobcat gesteigert werden. Im Cinebench 11.5 war der A4-5000 im Single-Thread-Test 21 % schneller als der E-350 von AMD und im Multi-Thread-Test ganze 145 % schneller. Die hohe Leistung und Energieeffizienz von Jaguar machten ihn zur offensichtlichen Wahl für Sonys und Microsofts Next-Gen-Konsolen, die PS4 und die Xbox One, verdrängen Intel und Nvidia aus der Konsole Markt.

Anandtech hat es gut zusammengefasst: „Im Kosten- und Leistungsbereich ist Jaguar derzeit konkurrenzlos. Intels aktueller 32-nm-Saltwell-Atom-Kern ist veraltet und nichts von ARM ist schnell genug. Es ist kein Wunder, dass sich sowohl Microsoft als auch Sony dafür entschieden haben, Jaguar als Basis für ihre Konsolen-SoCs der nächsten Generation zu verwenden. Es gibt heute einfach keine bessere Option … AMD wird eine Position genießen, die es seit Jahren nicht mehr hatte: eine CPU-Leistung Vorteil."

Dies sind nicht die CPUs, die Sie auf dieser Liste erwarten würden, nachdem Sie über Athlon Classic und Athlon 64 gelesen haben, die den Kampf an die Spitze geführt haben. Tatsache ist, dass diese CPUs jahrelang die Lebensader von AMD waren und das Unternehmen wahrscheinlich vor dem Bankrott bewahrt haben, was in den 2010er Jahren ein echtes Problem darstellte.

Nach Athlon 64 hatte AMD Mühe, den technologischen Vorsprung zurückzugewinnen. Im Jahr 2006 stellte Intel seine Core-Architektur vor, die deutlich besser als NetBurst war und dazu führte, dass Intel in puncto Leistung und Effizienz wieder die Nase vorn hatte. AMD konterte mit seinen Phenom-CPUs, die dank niedriger Preise preislich konkurrierten, AMD aber finanziell schadeten. AMDs GPUs aus dieser Zeit waren zu den besten, die das Unternehmen je auf den Markt gebracht hat, aber sie waren so billig, dass sie kein Geld verdienten. Deshalb wagte AMD im Jahr 2011 eine völlig neue Architektur namens Bulldozer, um sich aus dem Loch zu befreien.

Bulldozer war eine Katastrophe. Es war kaum besser als Phenom und schlechter als die konkurrierenden Sandy-Bridge-CPUs von Intel – ganz zu schweigen davon, dass es sehr heiß und energieineffizient war. Es war einfach nicht gut genug. Anandtech sah die Zeichen an der Wand: „Wir alle brauchen AMD, um erfolgreich zu sein.“ Wir haben gesehen, was ohne einen starken AMD als Konkurrenten passiert. Wir bekommen Prozessoren, die künstlich begrenzt sind und starke Einschränkungen bei der Übertaktung aufweisen, insbesondere am Preis-Ende des Segments. Uns bleibt die Wahl verwehrt, einfach weil es keine andere Alternative gibt. Es ist keine Frage mehr, ob AMD zu den Tagen des Athlon 64 zurückkehren wird, es muss einfach sein. Ansonsten kann man sich von der Wahl verabschieden.“

Bulldozer schaffte es nicht, Intel einzudämmen, und das bedeutete, dass Intel fünf lange Jahre lang die Richtung des gesamten x86-CPU-Marktes diktieren konnte.

Ryzen 7 1700

AMD ist zurück

Von 2011 bis 2017 war jede Desktop-Flaggschiff-CPU von Intel der i7, der immer mit vier Kernen und Hyperthreading ausgestattet war und immer für 330 US-Dollar auf den Markt kam. Es gab zwar CPUs mit höherer Kernzahl, die jedoch für die meisten Benutzer deutlich außerhalb des Budgets lagen. Auf der anderen Seite boten i5-CPUs der Mittelklasse und i3-CPUs der unteren Preisklasse in jeder Generation die gleichen Kernzahlen und Preise, ähnlich wie der i7. Das Tempo der Leistungs- und Wertsteigerung war ins Stocken geraten.

Im Hintergrund arbeitete AMD jedoch an einer brandneuen CPU, die alles verändern würde. Zen wurde 2015 erstmals vorgestellt und war eine neue Architektur, die nicht nur Bulldozer, sondern auch die Cat-Kerne ersetzen sollte, die AMD in den 2010er-Jahren größtenteils über Wasser gehalten hatten. Zen versprach eine enorme Verbesserung, da es 40 % mehr Anweisungen pro Takt (IPC) als Bulldozer hatte; Simultanes Multi-Threading (SMT), im Wesentlichen dasselbe wie Intels Hyperthreading; und acht Kerne.

Das Ausmaß der Fanfare für Zen war beispiellos. Die Enthüllungsveranstaltung für die ersten Zen-Desktop-CPUs trug passenderweise den Namen „New Horizon“ und im Vorprogramm trat Geoff Keighley von den The Game Awards auf. Als AMD-CEO Lisa Su endlich auf die Bühne kam und die brandneuen Ryzen-Desktop-CPUs ankündigte, erhielt sie den wohl größten Applaus und Jubel für eine CPU, den es je gegeben hatte. Die Leute hofften darauf, dass der ewige Außenseiter endlich gewinnt und die Szene wieder konkurrenzfähig macht.

Als die Rezensionen endlich veröffentlicht wurden, wurde Ryzen dem Hype gerecht. Von den drei High-End-CPUs, die AMD Anfang 2017 auf den Markt brachte, war der Ryzen 7 1700 wohl der verlockendste. Es hatte den gleichen Preis wie Intels Core i7-7700K, hatte aber acht Kerne, doppelt so viel wie Intels Flaggschiff zum gleichen Preis. In unserem Testbericht Wir haben festgestellt, dass der 1700 bei Multi-Thread-Workloads hervorragende Ergebnisse liefert und lag bei Single-Threaded-Aufgaben und -Spielen hinter dem 7700K, aber nicht so weit zurück, dass er ein weiterer Bulldozer sein könnte. Der 1700 war auch ein großartiger Übertaktungschip, wodurch die teureren 1700X und 1800X sinnlos waren.

Aber Zen bedeutete nicht nur die Rückkehr der Mainstream-AMD-CPUs. Für die gesamte CPU-Branche stellte AMD neue Zen-Prozessoren vor Low-End-APUs von Raven Ridge mit Radeon Vega-Grafik über den High-End-Desktop-Threadripper für Profis bis hin zu Epyc-Server-CPUs, den ersten wirklich wettbewerbsfähigen AMD-Server-CPUs in Jahre.

Die vielleicht größte Innovation von AMD waren Multi-Chip-Module oder MCM, bei denen AMD mehrere CPUs auf demselben Paket zusammenfasste, um eine hohe Kernzahl für HEDT und Server zu erreichen. Sein Hauptvorteil war die Kosteneffizienz, da AMD nicht mehrere Chips entwickeln musste, um das Ganze abzudecken Markt für CPUs mit mehr als vier Kernen, ganz zu schweigen von der Herstellung mehrerer kleiner Chips anstelle eines großen ZENTRALPROZESSOR.

Mit Zen war AMD zurück, und zwar im großen Stil – aber das Unternehmen gab sich nicht mehr mit dem zweiten Platz zufrieden. Es wollte die Goldmedaille.

Ryzen 9 3950X

Geht auf die Halsschlagader

Gleichzeitig stand Intel unter dem Druck von AMD, und es hätte für das blaue Team zu keinem schlechteren Zeitpunkt kommen können. Intel hatte sich mit der Festlegung extrem ehrgeiziger Ziele für seinen 10-nm-Knoten selbst ins Bein geschossen, und obwohl der Start für 2015 geplant war, war davon noch nichts in Sicht. AMD hatte für 2019 einen harten Kampf gegen 10-nm-CPUs geplant, der jedoch nie zustande kam, und Intel blieb auf absehbare Zeit bei 14-nm-CPUs hängen. Dies eröffnete die Möglichkeit, dass AMD das Undenkbare tun und sich den Prozessvorteil verschaffen könnte – etwas, das das Unternehmen noch nie zuvor hatte.

Da AMD einen harten Kampf erwartete, wollte es so schnell wie möglich auf einen neuen Knoten upgraden und entschied sich für den 7-nm-Knoten von TSMC. Die Produktion im 7-nm-Verfahren wäre normalerweise ziemlich teuer, aber AMD hatte mit MCM, der Grundlage für eine radikal neue Art der CPU-Herstellung, bereits einen Weg gefunden, dieses Problem zu umgehen: Chiplets. Die Idee bestand darin, nur die wichtigen Teile der CPU (wie die Kerne) auf einem fortschrittlichen Knoten zu produzieren und alles andere auf einem älteren, günstigeren Knoten produzieren zu lassen. Um weitere Kerne hinzuzufügen, fügen Sie einfach weitere Chiplets hinzu. Die Dinge würden verrückt werden.

Im Jahr 2019 brachte AMD die 7-nm-Zen-2-Architektur auf den Markt, wobei die brandneue Ryzen-3000-Serie die Nase vorn hatte. Während Ryzen 1000 und 2000 (eine bloße Weiterentwicklung der 1000er-Serie) Intel auf den Fersen waren, Ryzen 3000 war unbestritten die neue führende CPU in fast jeder einzelnen Metrik. Das Flaggschiff Ryzen 9 3950X hatte 16 Kerne, was zu der Zeit verrückt war, als das vorherige Flaggschiff Ryzen 7 2700X nur acht hatte. Außer bei Single-Thread-Anwendungen und Spielen hatte der Core i9-9900K keine Chance, und selbst dann kümmerte es niemanden, dass der 9900K ein paar Frames mehr schaffen konnte als der 3950X.

Diese Verdoppelung der Kernanzahl war jedoch nicht auf Desktops beschränkt. Threadripper und Epyc stiegen beide von 32 Kernen auf 64, und obwohl Intel versuchte, die Lücke mit einer 56-Kern-Xeon-CPU zu schließen, spielte das keine Rolle, da Xeon seine Führungsrolle bei der Energieeffizienz verlor. Eine bessere Energieeffizienz ist für das Rechenzentrumsgeschäft wie Goldstaub, denn eine schlechtere Energieeffizienz bedeutet, dass mehr für die Stromversorgung und Kühlung der Server gezahlt wird. Epyc hatte auf dem 7-nm-Knoten eine viel bessere Energieeffizienz.

Zum ersten Mal seit über einem Jahrzehnt hat AMD den technologischen Vorsprung zurückerobert. Das bedeutete natürlich nicht, dass Rechenzentren und PCs plötzlich auf AMD umsteigen würden. Da Intel jedoch mit seinem 10-nm-Knoten ins Stocken geriet, hatte AMD genügend Zeit, nach und nach Marktanteile zu gewinnen, sein Ökosystem weiterzuentwickeln und letztendlich Geld zu verdienen wie nie zuvor. Doch bevor AMD wirklich mit dem Aufbau seines neuen Imperiums beginnen konnte, musste es Intels letzte Bastion angreifen: den Mobilfunk.

Ryzen 9 4900HS

AMD weinte, denn es gab keine Welten mehr zu erobern

AMDs 7-nm-APUs waren für Anfang 2020 geplant, und obwohl Intel diesen Zeitpunkt gerne genutzt hätte Es war schwierig, etwas zu unternehmen, um sein lukratives Laptop-Geschäft zu schützen zusammen. 10 nm funktionierten endlich, reichten aber nur aus, um Quad-Core-CPUs zu produzieren, und diese Quad-Cores waren kaum besser als ihre 14-nm-Vorgänger. Die Frage war nicht, ob AMD Intel schlagen würde oder nicht, sondern um wie viel.

Ein wesentlicher Unterschied zu den 7-nm-APUs von AMD bestand darin, dass sie keine Chiplets wie Zen-2-Desktop- und Serverchips verwendeten und stattdessen ein traditionelles monolithisches Design hatten. Obwohl Chiplets für Hochleistungschips sehr gut geeignet waren, waren sie nicht ideal für Chips, die auf einen geringen Stromverbrauch abzielten, insbesondere im Leerlauf. Die APUs der nächsten Generation würden keine verrückten Kernzahlen haben, aber AMD brauchte diese nicht, um zu gewinnen.

Ryzen 4000 kam Anfang 2020 auf den Markt (gerade als die COVID-19-Pandemie begann), und obwohl es nicht viele Ryzen 4000 gab

Ausgestattet mit dem Achtkern-Flaggschiff Ryzen 9 4900HS war das G14 für seine Größe unglaublich schnell. In unserem Asus ROG Zephyrus G14 TestWir haben festgestellt, dass der 4900HS mit Intels Flaggschiff Core i9-9980HK mithalten kann, der in viel größeren Geräten mit robusterer Kühlung zu finden ist. Darüber hinaus war die Akkulaufzeit des G14 die beste von allen

Ryzen 4000 vollendete das Comeback von AMD und etablierte das Unternehmen als klaren Technologievorsprung gegenüber Intel. AMD musste seine Erfolge noch konsolidieren und sein Ökosystem aufbauen, aber der Sieg über Intel war der entscheidende erste Schritt, der alles andere möglich machte. Es war ein Neuanfang für AMD, den niemand hätte vorhersagen können.

Nach der 4000er-Serie und darüber hinaus

Der 4900HS war wohl die letzte großartige CPU von AMD, aber das heißt nicht, dass das Unternehmen in schwere Zeiten zurückgefallen ist. Die Ryzen 5000-Serie brachte Ende 2020 erhebliche architektonische Verbesserungen mit sich, ging aber auch mit einer Preiserhöhung einher. Außerdem hat AMD sehr lange gebraucht, um preisgünstige Ryzen 5000-Teile auf den Markt zu bringen, von denen einige erst im Jahr 2022 auf den Markt kamen. Ryzen 6000 kam ebenfalls Anfang 2022 auf den Markt, verfügte jedoch nur über mobile APUs und war selbst dann nur eine Weiterentwicklung der APUs der vorherigen Generation.

Um die Sache noch komplizierter zu machen, hat Intel mit seinen CPUs der 12. Generation wie dem auch ein eigenes Comeback hingelegt Core i9-12900K, der wohl genauso gut ist wie der Ryzen 5000, obwohl er ein Jahr zu spät zur Party kam. Aber AMD hat bei geringerer Leistung immer noch die Oberhand

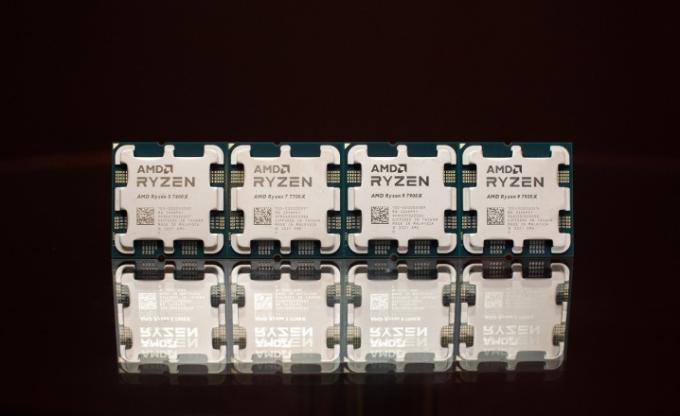

Was die Zukunft betrifft, sieht es rosig aus. AMD vor kurzem stellte seine Ryzen 7000-Serie vor, und es sieht ziemlich gut aus. Er scheint deutlich schneller zu sein als Ryzen 5000 und Alder Lake und scheint für die Bewältigung gut gerüstet zu sein Intels kommende Raptor-Lake-CPUs. Auch der Preis sieht akzeptabel aus und ist sicherlich eine Verbesserung gegenüber dem Ryzen 5000. Natürlich müssen wir die Testberichte abwarten, bevor sie als eine der besten CPUs angesehen werden kann, die AMD je hergestellt hat, aber es würde mich nicht wundern, wenn sie es auf die Liste schaffen würde.

Empfehlungen der Redaktion

- Diese beiden CPUs sind die einzigen, um die Sie sich im Jahr 2023 kümmern sollten

- AMDs kommender Ryzen 5 5600X3D könnte Intel in Budget-Builds komplett entthronen

- AMD bleibt möglicherweise bei einer umstrittenen Entscheidung beim Ryzen 8000

- AMDs Ryzen 7000-Reihe ist verwirrend, aber zumindest bekommen wir einen Aufkleber

- Von Click Wheels bis hin zu Trackpads – das sind die besten Apple-Designs aller Zeiten