Forudsigende politiarbejde skulle forvandle den måde, politiarbejde blev udført på, og føre os ind i en verden af smart lov håndhævelse, hvor bias blev fjernet, og politiet ville være i stand til at reagere på dataene, ikke til fornemmelser. Men et årti efter, at de fleste af os første gang hørte udtrykket "forudsigende politiarbejde", synes det klart, at det ikke har virket. Drevet af en offentlig tilbageslag oplever teknologien et betydeligt fald i dens brug sammenlignet med for blot et par år siden.

Indhold

- Løftet om prædiktiv politiarbejde

- Diskriminerende algoritmer

- Farerne ved beskidte data

- Den usikre fremtid for prædiktivt politiarbejde

- De forkerte værktøjer til jobbet?

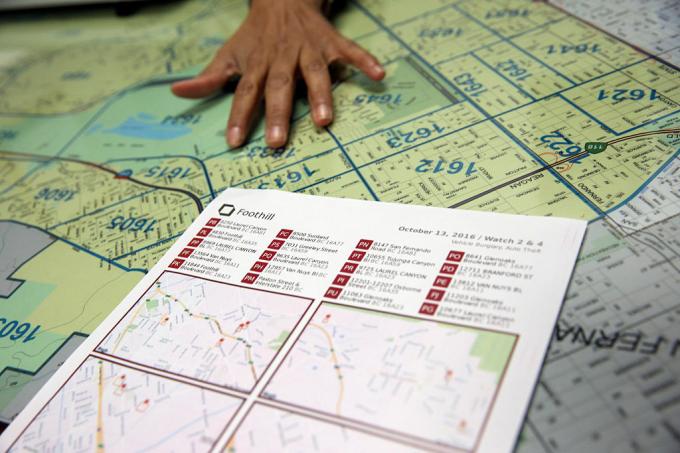

I april i år skar Los Angeles - som ifølge LA Times "banebrydende med at forudsige kriminalitet med data" - ned i midlerne til sit prædiktive politiprogram og skylder omkostningerne. "Det er en svær beslutning," politichef Michel Moore fortalte LA Times. "Det er en strategi, vi brugte, men omkostningsprognoserne på hundredtusindvis af dollars at bruge på den rigtige nu versus at finde de penge og dirigere pengene til andre mere centrale aktiviteter er, hvad jeg skal gøre.”

Anbefalede videoer

Hvad gik galt? Hvordan kunne noget, der annonceres som "smart" teknologi, ende med yderligere forankring af skævheder og diskrimination? Og er drømmen om prædiktiv politiarbejde en, der kunne justeres med den rigtige algoritme - eller en blindgyde i et mere retfærdigt samfund, der i øjeblikket kæmper med, hvordan politiet skal fungere?

Løftet om prædiktiv politiarbejde

Prædiktiv politiarbejde i sin nuværende form går tilbage omkring et årti til et papir fra 2009 af psykolog Colleen McCue og Los Angeles politichef Charlie Beck, med titlen "Prædiktiv politiarbejde: Hvad kan vi lære af Walmart og Amazon om at bekæmpe kriminalitet i en recession?” I avisen greb de den måde, big data blev brugt af store detailhandlere til at hjælpe med at afdække mønstre i tidligere kundeadfærd, som kunne bruges til at forudsige fremtidig adfærd. Takket være fremskridt inden for både databehandling og dataindsamling foreslog McCue og Beck, at det var muligt at indsamle og analysere kriminalitetsdata i realtid. Disse data kan derefter bruges til at forudse, forebygge og reagere mere effektivt på forbrydelser, der endnu ikke havde fundet sted.

I årene siden er prædiktiv politiarbejde gået fra en engangs-idé til en realitet i mange dele af USA, sammen med resten af verden. I processen har den sat sig for at ændre politiarbejdet fra en reaktiv kraft til en proaktiv; trække på nogle af gennembruddene inden for datadrevet teknologi, som gør det muligt at spotte mønstre i realtid - og handle ud fra dem.

"Der er to hovedformer for prædiktiv politiarbejde," Andrew Ferguson, professor i jura ved University of District of Columbia David A. Clarke School of Law og forfatter til The Rise of Big Data Policing: Surveillance, Race, and the Future of Law Enforcement, fortalte Digital Trends. "[Disse er] stedbaseret forudsigende politiarbejde og personbaseret forudsigende politiarbejde."

I begge tilfælde tildeler de prædiktive politisystemer en risikoscore til den pågældende person eller sted, hvilket tilskynder politiet til at følge op med et givet interval. Den første af disse tilgange, stedbaseret prædiktiv politiarbejde, fokuserer overvejende på politipatruljer. Det involverer brug af kriminalitetskortlægning og analyser om de sandsynlige steder for fremtidige forbrydelser baseret på tidligere statistikker.

I stedet for at hjælpe med at slippe af med problemer som racisme og andre systemiske skævheder, kan prædiktiv politi faktisk hjælpe med at forankre dem.

Den anden tilgang fokuserer på at forudsige sandsynligheden for, at en person udgør en potentiel fremtidig risiko. For eksempel, i 2013 blev en chef for Chicago-politiet sendt hjem til en 22-årig Robert McDaniel, der var blevet markeret som en potentiel risiko eller gerningsmand til våbenvold i Chicagos indre by af en algoritme. "Heatlisten", som algoritmen hjalp med at samle, ledte efter mønstre, der måske kunne forudsige fremtidige lovovertrædere eller ofre, selvom de ikke selv havde gjort noget for at berettige denne undersøgelse ud over at overholde en profil.

Som Chicago Tribune bemærkede: "Strategien opfordrer til at advare dem på varmelisten individuelt om, at yderligere kriminel aktivitet, selv for de mest ubetydelige forseelser, vil det resultere i, at lovens fulde kraft bliver bragt til ophør dem."

Drømmen om prædiktiv politiarbejde var, at det ved at handle på kvantificerbare data ville gøre politiarbejdet ikke kun mere effektivt, men også mindre tilbøjeligt til at gætte og som følge heraf bias. Det ville, hævdede fortalere, ændre politiarbejdet til det bedre og indlede en ny æra med smart politiarbejde. Men lige fra begyndelsen har prædiktiv politiarbejde haft stærke kritikere. De hævder, at i stedet for at hjælpe med at slippe af med problemer som racisme og andre systemiske skævheder, kan prædiktiv politi faktisk hjælpe med at forankre dem. Og det er svært at argumentere for, at de ikke har en pointe.

Diskriminerende algoritmer

Ideen om, at maskinlæringsbaserede prædiktive politisystemer kan lære at diskriminere baseret på faktorer som race, er ikke noget nyt. Maskinlæringsværktøjer trænes med enorme mængder data. Og så længe disse data er indsamlet af et system, hvor race fortsat er en overvældende faktor, kan det føre til diskrimination.

Som Renata M. O'Donnell skriver i et papir fra 2019 med titlen "Udfordring af racistiske prædiktive politialgoritmer under ligebeskyttelsesklausulen," maskinlæringsalgoritmer lærer af data, der stammer fra et retssystem, hvor "sorte amerikanere er fængslet i statsfængsler med en hastighed det er 5,1 gange hvides fængsling, og hver tredje sorte mænd, der er født i dag, kan forvente at komme i fængsel i sin levetid, hvis de nuværende tendenser Blive ved."

"Data er ikke objektiv," sagde Ferguson til Digital Trends. "Det er bare os, der er reduceret til binær kode. Datadrevne systemer, der fungerer i den virkelige verden, er ikke mere objektive, retfærdige eller upartiske end den virkelige verden. Hvis din virkelige verden er strukturelt ulige eller racediskriminerende, vil et datadrevet system afspejle disse samfundsmæssige uligheder. De input, der går ind, er plettet af bias. Analysen er plettet af bias. Og politimyndighedernes mekanismer ændrer sig ikke, bare fordi der er teknologi, der styrer systemerne."

Ferguson giver eksemplet med arrestationer som en tilsyneladende objektiv faktor til at forudsige risiko. Anholdelser vil dog blive skæv af tildelingen af politiets ressourcer (såsom hvor de patruljerer) og de typer kriminalitet, der typisk berettiger anholdelser. Dette er blot en illustration af potentielt problematiske data.

Farerne ved beskidte data

Manglende og forkerte data omtales nogle gange i datamining som "beskidte data". EN 2019 papir af forskere fra A.I. Nu Institut ved New York University udvider dette udtryk til også at henvise til data, der er påvirket af korrupte, partiske og ulovlige praksis - uanset om det er fra bevidst manipuleret, der er forvrænget af individuelle og samfundsmæssige skævheder. Det kan for eksempel omfatte data, der er genereret fra anholdelsen af en uskyldig person, som har fået plantet beviser på sig, eller som på anden måde er falsk anklaget.

Der er en vis ironi i, at de seneste årtiers krav fra datasamfundet, hvor alt handler om kvantificering og støbejerns numeriske mål, har netop ført til en hel masse … ja, virkelig dårlige data. HBO-serien Tråden fremviste fænomenet i den virkelige verden med "juking the stats", og årene siden showet gik ud af luften har budt på masser af eksempler på faktisk systemisk datamanipulation, falske politirapporter og forfatningsstridig praksis, der har sendt uskyldige mennesker til fængsel.

Dårlige data, der giver magthavere mulighed for kunstigt at ramme mål, er én ting. Men kombiner det med algoritmer og prædiktive modeller, der bruger dette som deres grundlag for at modellere verden, og du får potentielt noget meget værre.

Forskere har demonstreret, hvordan tvivlsomme kriminalitetsdata sat ind i prædiktive politialgoritmer kan skabe det, der omtales som "runaway feedback loops, hvor politiet gentagne gange sendes til de samme kvarterer uanset den sande kriminalitetsrate. En af medforfatterne til det papir, datalog Suresh Venkatasubramanian, siger, at maskinlæringsmodeller kan indbygge fejlagtige antagelser gennem deres modellering. Ligesom det gamle ordsprog om, hvordan ethvert problem for personen med en hammer ligner et søm, modellerer disse systemer kun visse elementer til et problem - og forestiller sig kun ét muligt udfald.

"[Noget, der] ikke bliver behandlet i disse modeller er, i hvor høj grad modellerer du det faktum, at det faktisk kan sænke livskvaliteten for folk, der bor der?” Venkatasubramanian, en professor ved School of Computing ved University of Utah, fortalte Digital Trends. "Vi går ud fra, at flere betjente er en bedre ting. Men som vi ser lige nu, er det ikke nødvendigvis en god ting at have mere politi. Det kan faktisk gøre tingene værre. I ikke én model, jeg nogensinde har set, har nogen nogensinde spurgt, hvad det koster at sætte mere politi ind i et område."

Den usikre fremtid for prædiktivt politiarbejde

De, der arbejder med prædiktiv politi, bruger nogle gange uironisk udtrykket "Minoritetsrapport" for at henvise til den slags forudsigelse, de laver. Udtrykket påberåbes ofte som en henvisning til 2002 film af samme navn, som igen var løst baseret på en novelle fra 1956 af Philip K. Pik. I Mindretalsrapport, en særlig PreCrime politiafdeling pågriber kriminelle baseret på forudviden om forbrydelser, der vil blive begået i fremtiden. Disse prognoser leveres af tre synske kaldet "precogs".

Men twisten ind Mindretalsrapport er, at forudsigelserne ikke altid er nøjagtige. Afvigende visioner fra en af precogs giver et alternativt syn på fremtiden, som undertrykkes af frygt for at få systemet til at virke utroværdigt.

Interne revisioner, der viser, at taktikken ikke virkede. Ikke alene var de prædiktive lister fejlbehæftede, men de var også ineffektive.

Lige nu går prædiktiv politiarbejde sin egen usikre fremtid i møde. Ved siden af nye teknologier såsom ansigtsgenkendelse har den teknologi, der er tilgængelig for retshåndhævelse til mulig brug, aldrig været mere effektiv. Samtidig har bevidstheden om brugen af prædiktiv politiarbejde forårsaget et offentligt modreaktion, der faktisk kan have været med til at ophæve det. Ferguson fortalte Digital Trends, at brugen af prædiktive politiværktøjer har været på et "nedsving" i de sidste par år.

"På sit højdepunkt var [stedbaseret prædiktiv politiarbejde] i over 60 større byer og voksede, men som et resultat af vellykket samfundsorganisering, er det stort set blevet reduceret og/eller erstattet med andre former for datadrevet analytics," sagde han. "Kort sagt blev udtrykket prædiktiv politiarbejde giftigt, og politiafdelinger lærte at omdøbe, hvad de lavede med data. Personbaseret prædiktivt politi havde et stejlere fald. De to hovedbyer, der investerede i dens oprettelse - Chicago og Los Angeles - støttede deres personbaserede strategier efter skarp samfundskritik og ødelæggende interne revisioner, der viser, at taktikken ikke gjorde det arbejde. Ikke alene var de forudsigelige lister fejlbehæftede, de var også ineffektive."

De forkerte værktøjer til jobbet?

Imidlertid, Rashida Richardson, direktør for politikforskning ved A.I. Nu sagde Instituttet, at der er for meget uigennemsigtighed omkring brugen af denne teknologi. "Vi ved det stadig ikke på grund af manglen på gennemsigtighed med hensyn til offentlige indkøb af teknologi og mange smuthuller i eksisterende indkøbsprocedurer, der kan beskytte visse teknologikøb fra offentlig kontrol." hun sagde. Hun giver et eksempel på teknologi, der kan gives til en politiafdeling gratis eller købes af en tredjepart. "Vi ved fra forskning som min og mediernes rapportering, at mange af de største politiafdelinger i USA har brugt teknologi på et tidspunkt, men der er også mange små politiafdelinger, der bruger det, eller har brugt det i begrænsede perioder af tid."

I betragtning af den aktuelle afhøring om politiets rolle, vil der være en fristelse til at omfavne prædiktiv politiarbejde som et værktøj til datadrevet beslutningstagning - måske under mindre dystopisk sci-fi branding? Der er mulighed for, at en sådan genopblussen kan dukke op. Men Venkatasubramanian er meget skeptisk over, at maskinlæring, som den praktiseres i øjeblikket, er det rigtige værktøj til jobbet.

"Hele maskinlæring og dens succes i det moderne samfund er baseret på den forudsætning, at uanset hvad den faktiske problem, det handler i sidste ende om at indsamle data, bygge en model, forudsige resultatet - og du behøver ikke bekymre dig om domænet." han sagde. “Du kan skrive den samme kode og anvende den 100 forskellige steder. Det er løftet om abstraktion og bærbarhed. Problemet er, at når vi bruger det, folk kalder socio-tekniske systemer, hvor man har mennesker og teknologi blandet ind i komplicerede bølger, kan man ikke gøre dette. Du kan ikke bare tilslutte et stykke og forvente, at det virker. Fordi [der er] ringvirkninger ved at sætte den brik i og det faktum, at der er forskellige spillere med forskellige dagsordener i et sådant system, og de undergraver systemet til deres egne behov i forskellige veje. Alle disse ting skal medregnes, når du taler om effektivitet. Ja, du kan sige abstrakt, at alt vil fungere fint, men der er intet abstrakt. Der er kun den kontekst, du arbejder i."