От видео на жертва на самоубийство в YouTube към реклами, насочени към „мразещи евреите“, На Facebook, социалните медийни платформи са засегнати от неподходящо съдържание, което успява да се промъкне през пукнатините. В много случаи отговорът на платформата е да внедри по-интелигентни алгоритми за по-добро идентифициране на неподходящо съдържание. Но какво наистина може да улови изкуственият интелект, доколко трябва да му се доверим и къде се проваля?

„A.I. може да улавя обиден език и може да разпознава изображения много добре. Силата за идентифициране на изображението е налице“, казва Уинстън Бинч, главен дигитален директор на

Deutsch, творческа агенция, която използва A.I. в създаването на дигитални кампании за марки от Target до Taco Bell. „Сивата зона се превръща в намерение.“ИИ може да чете както текст, така и изображения, но точността варира

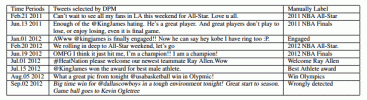

Използвайки обработка на естествен език, A.I. може да бъде обучен да разпознава текст на множество езици. Програма, предназначена да открива публикации, които нарушават насоките на общността, например, може да бъде научена да открива расови обиди или термини, свързани с екстремистка пропаганда.

ИИ може също да бъде обучен да разпознава изображения, да предотвратява някои форми на голота или да разпознава символи като свастиката. Работи добре в много случаи, но не е безпогрешно. Например Google Photos беше критикуван за тагването на изображения на тъмнокожи хора с ключовата дума "горила". Години по-късно Google все още не е намерил решение на проблема, вместо това е избрал да го премахне на способността на програмата да маркира маймуни и горили изцяло.

Алгоритмите също трябва да се актуализират с развитието на значението на думата или за да се разбере как се използва думата в контекста. Например, LGBT потребители на Twitter наскоро забелязаха липса на резултати от търсене за #gay и #bisexual, наред с други термини, което накара някои да почувстват, че услугата ги цензурира. Twitter се извини за грешката, като я обвини остарял алгоритъм който фалшиво идентифицира публикации, маркирани с термините като потенциално обидни. Twitter каза, че неговият алгоритъм е трябвало да вземе предвид термина в контекста на публикацията, но не е успял да го направи с тези ключови думи.

ИИ е пристрастен

Неуспешното маркиране на горила води до друг важен недостатък - ИИ е пристрастен. Може би се чудите как един компютър може да бъде предубеден, но A.I. се обучава, като наблюдава как хората изпълняват задачи или като въвежда резултатите от тези задачи. Например, програмите за идентифициране на обекти в снимка често се обучават чрез захранване на системата с хиляди изображения, които първоначално са били маркирани на ръка.

Човешкият елемент е това, което прави възможно A.I. да изпълнява задачи, но в същото време го придава човешко пристрастие.

Човешкият елемент е това, което прави възможно A.I. за изпълнение на задачи, които преди това бяха невъзможни за типичния софтуер, но същият този човешки елемент също неволно придава човешка пристрастност на компютъра. ИИ Програмата е толкова добра, колкото и данните за обучението - ако системата е захранвала предимно изображения на бели мъже, например, програмата ще има затруднения при идентифицирането на хора с други тонове на кожата.

„Един недостатък на ИИ като цяло, когато става дума за модериране на каквото и да било от коментари до потребител съдържание, е, че по своята същност е самоуверен от дизайна“, каза PJ Ahlberg, изпълнителен технически директор Директор на Stink Studios Ню Йорк, агенция, която използва A.I. за създаване на ботове за социални медии и модериране на кампании на марката.

След като бъде разработен набор за обучение, тези данни често се споделят между разработчиците, което означава, че отклонението се разпространява към множество програми. Алберг казва, че този фактор означава, че разработчиците не могат да променят тези набори от данни в програми, използващи множество AI. системи, което затруднява премахването на всякакви пристрастия след откриването им.

ИИ не може да определи намерението

ИИ може да открие свастика в снимка, но софтуерът не може да определи как се използва. Facebook, например, наскоро се извини, след като премахване на публикация, която съдържаше свастика но беше придружено от текстова молба за спиране на разпространението на омраза.

Това е пример за провала на A.I. за разпознаване на умисъла. Facebook дори тагна снимка на статуята на Нептун като сексуално явен. Освен това алгоритмите могат неволно да маркират фотожурналистическа работа поради символи на омраза или насилие, които могат да се появят в изображенията.

Исторически изображения, споделени с образователна цел, са друг пример - през 2016 г. Facebook предизвика полемика след това премахна историческата снимка на „напалмово момиче“. няколко пъти, преди натискът от страна на потребителите да принуди компанията да промени твърдата си позиция относно голотата и да възстанови снимката.

ИИ има тенденция да служи като първоначална проверка, но често все още са необходими човешки модератори, за да се определи дали съдържанието действително нарушава стандартите на общността. Въпреки подобренията в AI, това не е факт, който се променя. Facebook, например, увеличава размера на своя екип за преглед до 20 000 тази година, двойно повече от миналата година.

ИИ помага на хората да работят по-бързо

Все още може да е необходим човешки мозък, но A.I. направи процеса по-ефективен. ИИ може да помогне да се определи кои публикации изискват преглед от човек, както и да помогне за приоритизирането на тези публикации. През 2017 г. Facebook сподели това ИИ предназначени да откриват суицидни тенденции е довело до 100 обаждания на спешни служби за един месец. по това време,

Getty Images/Blackzheep

„[A.I. е] изминал дълъг път и определено напредва, но реалността е, че все още много се нуждаете от човешки елемент, който да потвърди че променяте правилните думи, правилното съдържание и правилното послание“, каза Крис Меле, управляващ директор на Stink Студия. „Където се усеща A.I. работи най-добре, като улеснява човешките модератори и им помага да работят по-бързо и в по-голям мащаб. Не мисля, че ИИ е почти 100 процента автоматизиран на всяка платформа.“

ИИ е бързо, но етиката е бавна

Технологиите като цяло имат тенденция да се развиват по-бързо, отколкото законите и етиката могат да поддържат - и модерирането на социалните медии не е изключение. Бинч предполага, че този фактор може да означава повишено търсене на служители с опит в хуманитарните науки или етиката, нещо, което повечето програмисти нямат.

Както той каза: „Сега сме на място, където темпото, скоростта е толкова бързо, че трябва да сме сигурни, че етичният компонент няма да изостане твърде много.“

Препоръки на редакторите

- Когато авторските права затрудняват намирането на видео саундтраци, този ИИ. музикант може да помогне

- От 8K до AI, това може да се появи при камерите през 2019 г

- Компютрите скоро ще ни надхитрит. Това прави ли A.I. бунтът неизбежен?